在近期舉行的第 43 屆國際信息檢索年會 (ACM SIGIR2020) 上,Geoffrey Hinton 做了主題為《The Next Generation of Neural Networks》的報告。

Geoffrey Hinton 是谷歌副總裁、工程研究員,也是 Vector Institute 的首席科學顧問、多倫多大學 Emeritus 榮譽教授。2018 年,他與 Yoshua Bengio、Yann LeCun 因對深度學習領域做出的巨大貢獻而共同獲得圖靈獎。

自 20 世紀 80 年代開始,Geoffrey Hinton 就開始提倡使用機器學習方法進行人工智能研究,他希望通過人腦運作方式探索機器學習系統。受人腦的啟發(fā),他和其他研究者提出了「人工神經網絡」(artificial neural network),為機器學習研究奠定了基石。

那么,30 多年過去,神經網絡神經網絡的未來發(fā)展方向在哪里呢?

Hinton 在此次報告中回顧了神經網絡的發(fā)展歷程,并表示下一代神經網絡將屬于無監(jiān)督對比學習。

Hinton 的報告主要內容如下:

人工神經網絡最重要的待解難題是:如何像大腦一樣高效執(zhí)行無監(jiān)督學習。

目前,無監(jiān)督學習主要有兩類方法。

第一類的典型代表是 BERT 和變分自編碼器(VAE),它們使用深度神經網絡重建輸入。但這類方法無法很好地處理圖像問題,因為網絡最深層需要編碼圖像的細節(jié)。

另一類方法由 Becker 和 Hinton 于 1992 年提出,即對一個深度神經網絡訓練兩個副本,這樣在二者的輸入是同一圖像的兩個不同剪裁版本時,它們可以生成具備高度互信息的輸出向量。這類方法的設計初衷是,使表征脫離輸入的不相關細節(jié)。

Becker 和 Hinton 使用的優(yōu)化互信息方法存在一定缺陷,因此后來 Pacannaro 和 Hinton 用一個判別式目標替換了它,在該目標中一個向量表征必須在多個向量表征中選擇對應的一個。

隨著硬件的加速,近期表征對比學習變得流行,并被證明非常高效,但它仍然存在一個主要缺陷:要想學習具備 N bits 互信息的表征向量對,我們需要對比正確的對應向量和 2 N 個不正確的向量。

在演講中,Hinton 介紹了一種處理該問題的新型高效方式。此外,他還介紹了實現大腦皮層感知學習的簡單途徑。

接下來,我們來看 Hinton 演講的具體內容。

為什么我們需要無監(jiān)督學習?

在預測神經網絡的未來發(fā)展之前,Hinton 首先回顧了神經網絡的發(fā)展進程。

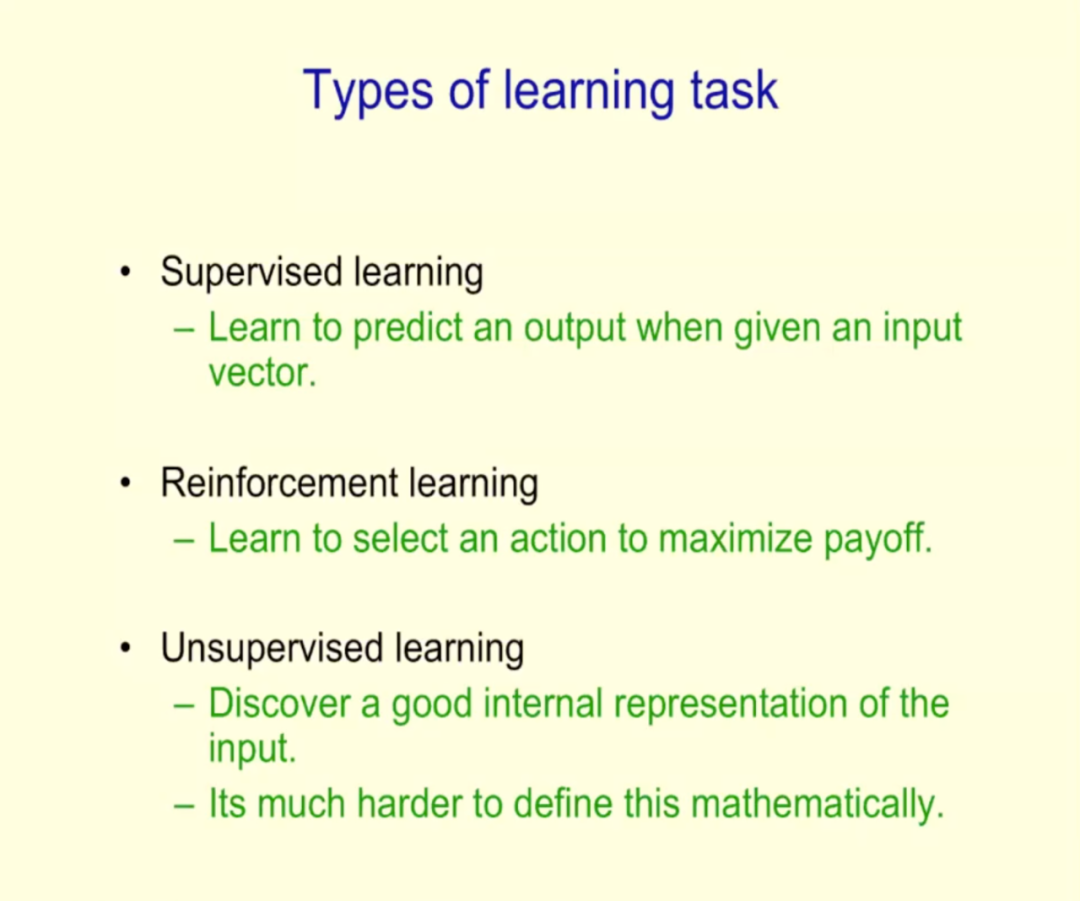

演講一開始,Hinton 先介紹了三種學習任務:監(jiān)督學習、強化學習和無監(jiān)督學習,并重點介紹了無監(jiān)督學習的必要性。

為什么我們需要無監(jiān)督學習呢?

Hinton 從生物學的角度做出了詮釋。他指出,人類大腦有 10^14 個神經元突觸,而生命的長度僅有 10^9 秒,因此人類無法完全依賴監(jiān)督學習方式完成所有神經元訓練,因而需要無監(jiān)督學習的輔助。

受此啟發(fā),構建智能模型也需要無監(jiān)督學習。

無監(jiān)督學習的發(fā)展歷程

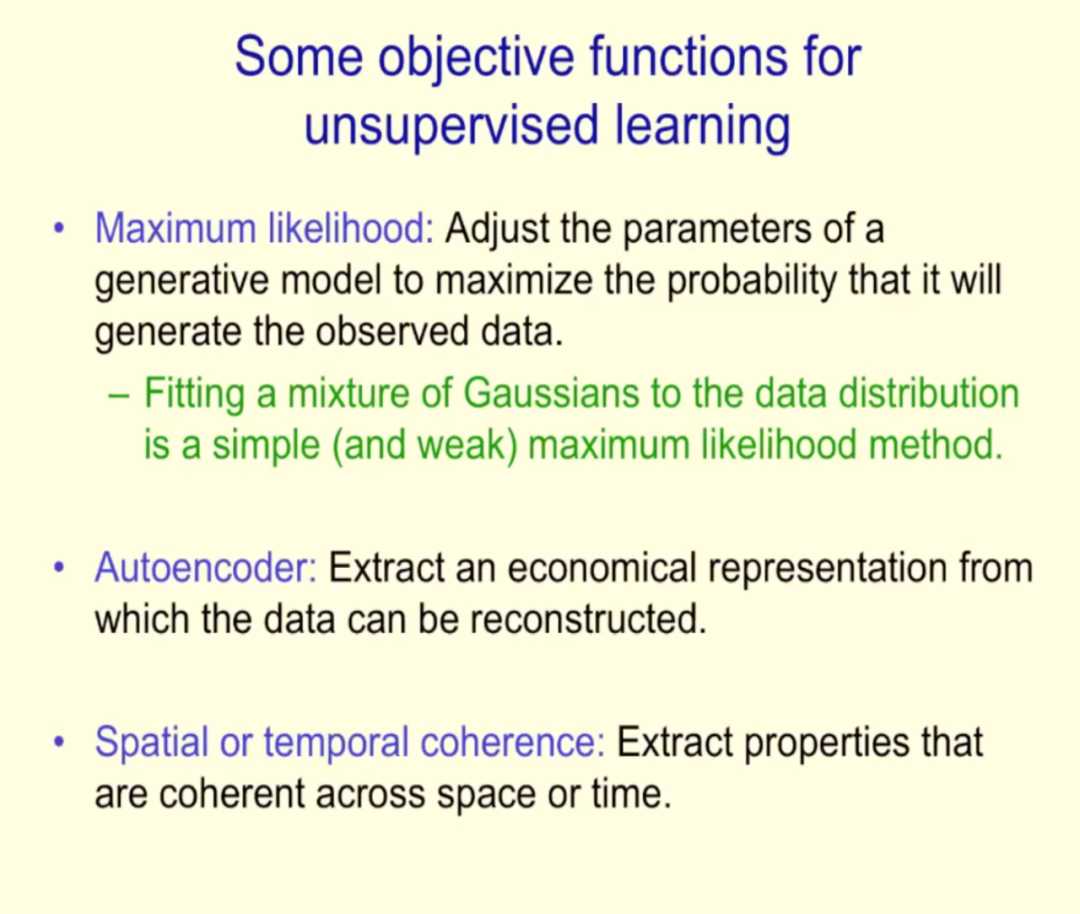

無監(jiān)督學習經過怎樣的發(fā)展呢?Hinton 為我們介紹了無監(jiān)督學習中的常見目標函數。

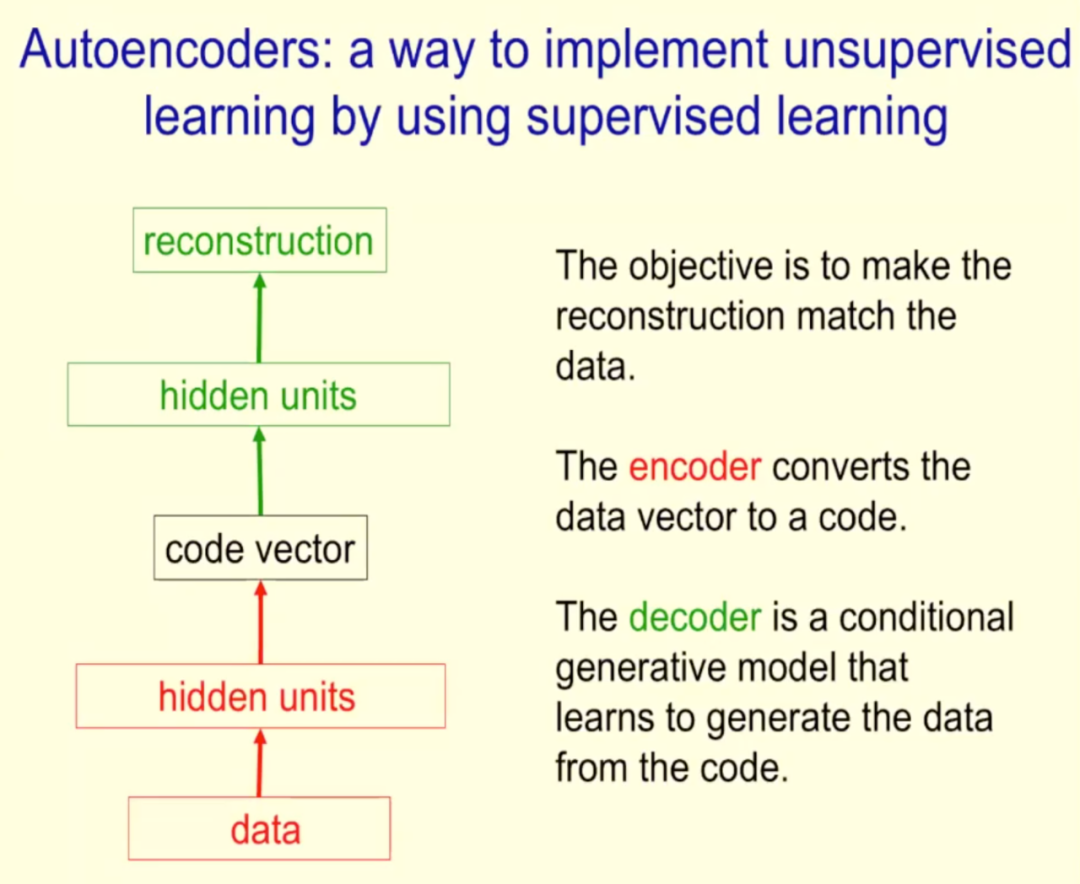

緊接著,Hinton 詳細介紹了自編碼器。

Hinton 表示,自編碼器是一種利用監(jiān)督學習實現無監(jiān)督學習的方式,其目標是使最后的重建結果與數據相匹配。編碼器將數據向量轉換為代碼,解碼器基于代碼生成數據。

在高屋建瓴地介紹了自編碼器的定義、訓練深度自編碼器之前的難點和現狀之后,Hinton 著重介紹了兩種自編碼器類型:變分自編碼器和 BERT 自編碼器。

使用深度神經網絡重建輸入:VAE 和 BERT

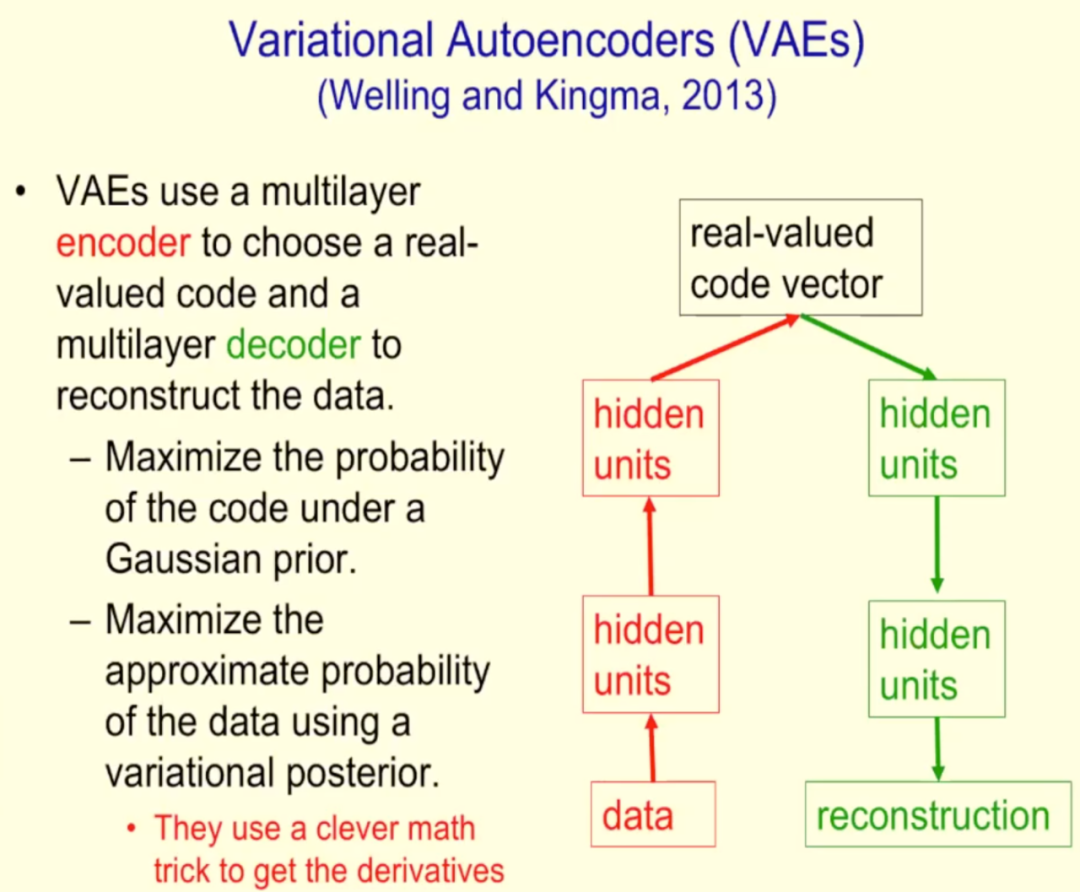

BERT 和變分自編碼器(VAE)是無監(jiān)督學習的一類典型代表,它們使用深度神經網絡重建輸入。

變分自編碼器由韋靈思和 Kingma 于 2013 年提出,它使用多層編碼器選擇實數代碼,然后用多層解碼器重建數據。VAE 的基本構造如下圖所示:

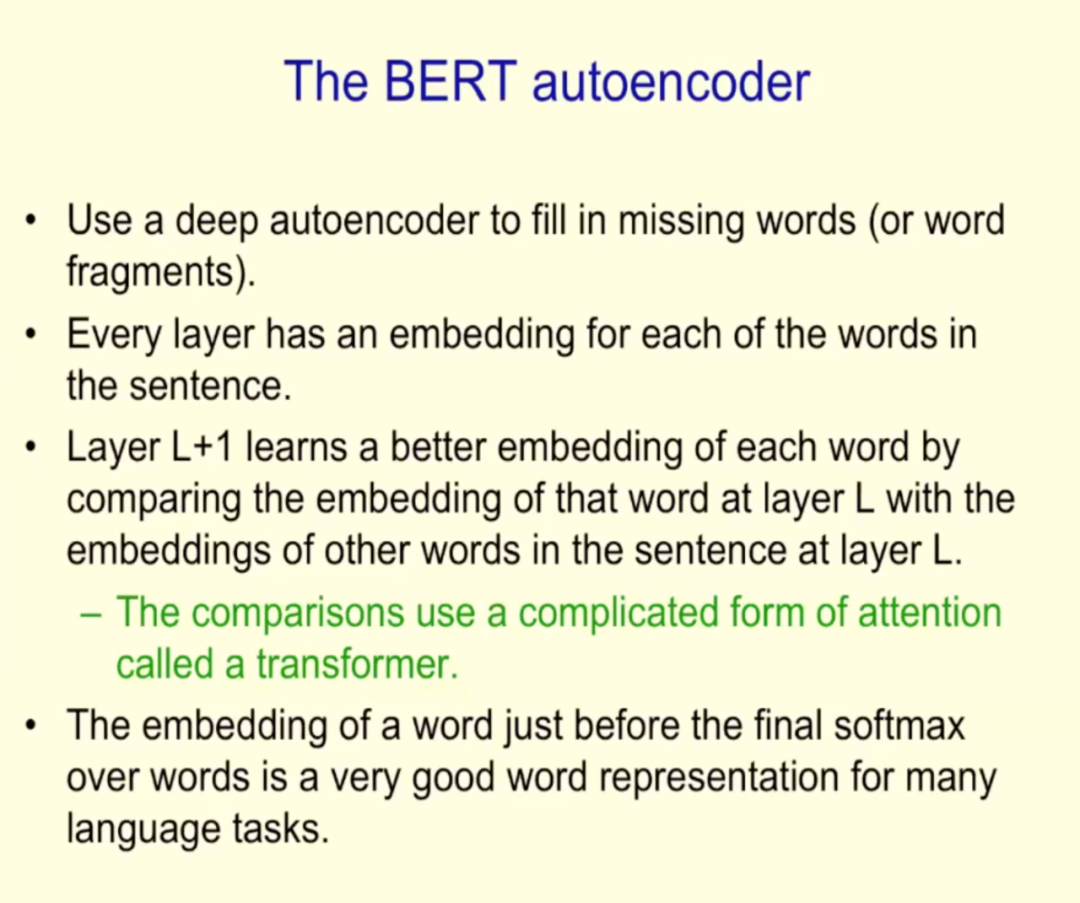

BERT 是 2018 年谷歌提出的語言表征模型,基于所有層的左、右語境來預訓練深度雙向表征。

語境信息對 BERT 非常重要,它利用遮蔽語言模型(masked language model,MLM)允許表征融合左右兩側的語境,從而預訓練深度雙向 Transformer。

Hinton 舉了一個例子:「She scromed him with the frying pan」。在這個句子中,即使你不知道 scromed 的意思,也可以根據上下文語境進行推斷。

視覺領域也是如此。然而,BERT 這類方法無法很好地應用到視覺領域,因為網絡最深層需要編碼圖像的細節(jié)。

在探討了以 VAE 和 BERT 為代表的一類無監(jiān)督學習方法后,Hinton 為我們介紹了另一類無監(jiān)督學習方法。

Becker 和 Hinton 提出最大化互信息方法

那么自編碼器和生成模型有沒有什么替代方案呢?Hinton 表示,我們可以嘗試不再解釋感官輸入(sensory input)的每個細節(jié),而專注于提取空間或時序一致性的特征。與自編碼器不同,這種方法的好處在于可以忽略噪聲。

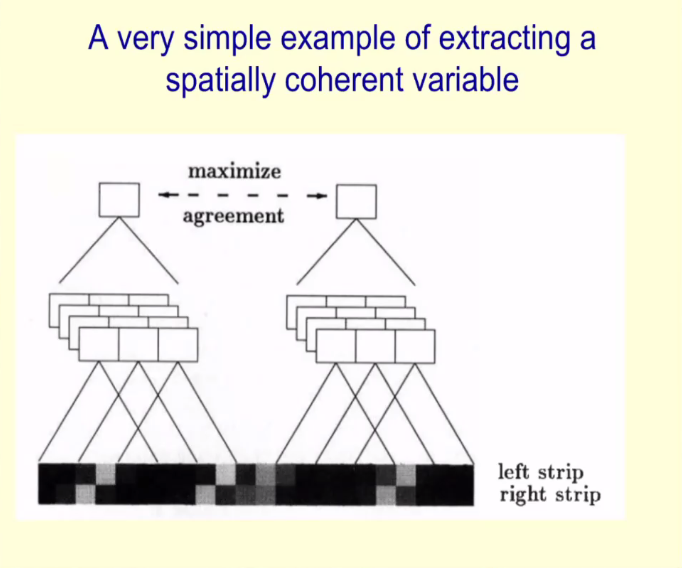

然后,Hinton 詳細介紹了他與 Suzanna Becker 在 1992 年提出的一種提取空間一致性特征的方法。該方法的核心理念是對輸入的兩個非重疊塊(non-overlapping patch)表示之間的顯式互信息進行最大化處理。Hinton 給出了提取空間一致性變量的簡單示例,如下圖所示:

經過訓練,Hinton 指出唯一的空間一致性特征是「不一致性」(The Only Spatially Coherent Property is Disparity),所以這也是必須要提取出來的。

他表示這種最大化互信息的方法存在一個棘手的問題,并做出以下假設,即如果只學習線性映射,并且對線性函數進行優(yōu)化,則變量將成為分布式的。不過,這種假設并不會導致太多問題。

以往研究方法回顧

在這部分中,Hinton 先后介紹了 LLE、LRE、SNE、t-SNE 等方法。

局部線性嵌入方法(Locally Linear Embedding, LLE)

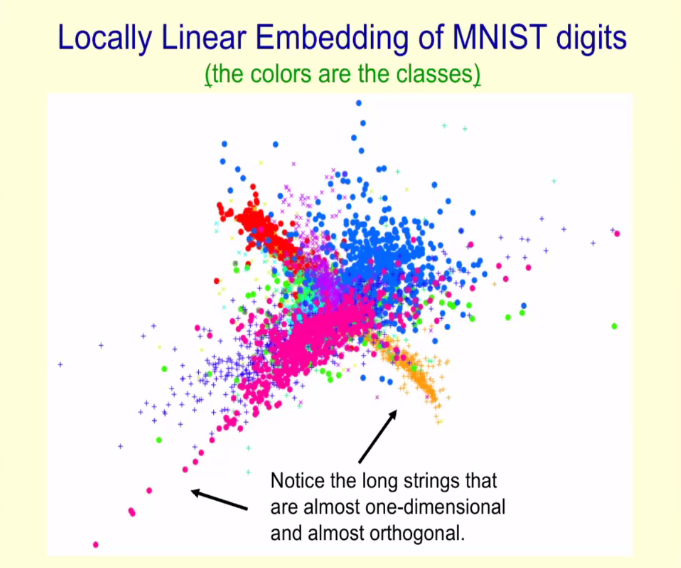

Hinton 介紹了 Sam T. Roweis 和 Lawrence K. Saul 在 2000 年 Science 論文《Nonlinear Dimensionality Reduction by Locally Linear Embedding》中提到的局部線性嵌入方法,該方法可以在二維圖中顯示高維數據點,并且使得非常相似的數據點彼此挨得很近。

但需要注意的是,LLE 方法會導致數據點重疊交融(curdling)和維度崩潰(dimension collapse)問題。

下圖為 MNIST 數據集中數字的局部線性嵌入圖,其中每種顏色代表不同的數字:

此外,這種長字符串大多是一維的,并且彼此之間呈現正交。

從線性關系嵌入(LRE)到隨機鄰域嵌入(SNE)

在這部分中,Hinton 介紹了從線性關系嵌入(Linear Relational Embedding, LRE)到隨機鄰域嵌入(Stochastic Neighbor Embedding, SNE)方法的轉變。他表示,只有「similar-to」關系存在時,LRE 才轉變成 SNE。

同時,Hinton 指出,可以將 LRE 目標函數用于降維(dimensionality reduction)。

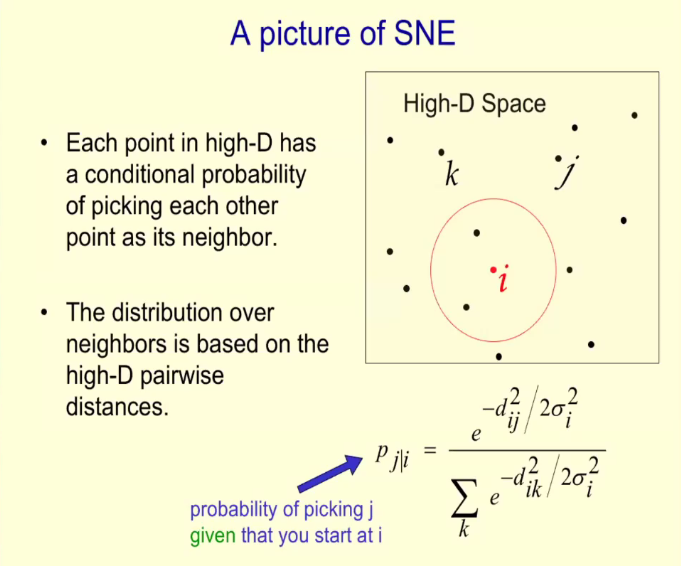

下圖為 SNE 的示意圖,其中高維空間的每個點都有選擇其他點作為其鄰域的條件概率,并且鄰域分布基于高維成對距離(pairwise distance)。

從隨機鄰域嵌入(SNE)到 t 分布隨機鄰域嵌入(t-SNE)

t 分布隨機鄰域嵌入(t-distributed stochastic neighbor embedding, t-SNE)是 SNE 的一種變體,原理是利用一個 student-distribution 來表示低維空間的概率分布。

Hinton 在下圖中展示了 MNIST 數據集中數字的 t-SNE 嵌入圖,每種顏色代表不同的數字:

在介紹完這些方法之后,Hinton 提出了兩個問題:1)方差約束在優(yōu)化非線性或非參數映射時為何表現糟糕?2)典型相關分析或線性判別分析的非線性版本為何不奏效?并做出了解答。

最后,Hinton 提出使用對比損失(contrastive loss)來提取空間或時間一致性的向量表示,并介紹了他與 Ruslan Salakhutdinov 在 2004 年嘗試使用對比損失的探索,以及 Oord、Li 和 Vinyals 在 2018 年使用對比損失復現這種想法,并用它發(fā)現時間一致性的表示。

Hinton 表示,當前無監(jiān)督學習中使用對比損失一種非常流行的方法。

無監(jiān)督對比學習的最新實現 SimCLR

在演講最后,Hinton 重點介紹了其團隊使用對比損失提取一致性表示的最新實現 SimCLR,這是一種用于視覺表示的對比學習簡單框架,它不僅優(yōu)于此前的所有工作,也優(yōu)于最新的對比自監(jiān)督學習算法。

下圖為 SimCLR 的工作原理圖:

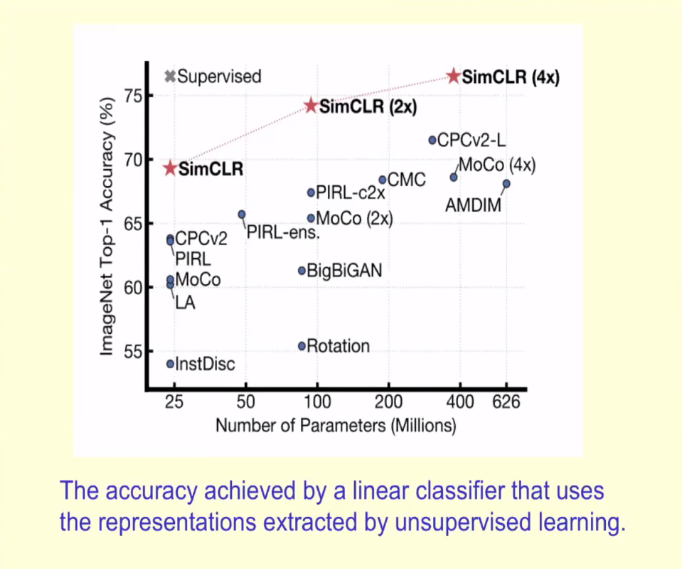

那么 SimCLR 在 ImageNet 上的 Top-1 準確率表現如何呢?下圖展示了 SimCLR 與此前各類自監(jiān)督方法在 ImageNet 上的 Top-1 準確率對比(以 ImageNet 進行預訓練),以及 ResNet-50 的有監(jiān)督學習效果。

Hinton 表示,經過 ImageNet 上 1% 圖片標簽的微調,SimCLR 可以達到 85.8%的 Top-5 準確率——在只用 AlexNet 1% 標簽的情況下性能超越后者。

Hinton 認為,以 SimCLR 為代表的無監(jiān)督對比學習將引領下一代神經網絡的發(fā)展。