今年的夏天,對賽靈思中國 AI產(chǎn)品團(tuán)隊來說是一個不平凡的夏季: 在相繼舉行的一年一度2021 CVPR (IEEE Computer Vision and Pattern Recognition conference,即IEEE國際計算機(jī)視覺與模式識別會議),以及2021 ICCV ( IEEE International Conference on Computer Vision,即國際計算機(jī)視覺大會)上,我們的團(tuán)隊每個大會各斬獲兩份榮譽,“雙獎”連連,激動人心。

CVPR 和ICCV 是全球排名前三的計算機(jī)視覺學(xué)術(shù)頂級會議中的兩個(第三個是ECCV, 即歐洲計算機(jī)視覺會議 ),兩大頂會相繼授予的雙重榮譽,無疑是對賽靈思 AI 產(chǎn)品團(tuán)隊在全球競爭領(lǐng)域技術(shù)實力和創(chuàng)新能力的高度認(rèn)可和有力證明。

在人工智能領(lǐng)域, CVPR 位列谷歌 ( Google) 學(xué)術(shù)總榜第一名。2021 CVPR接受了賽靈思 AI 研發(fā)團(tuán)隊題目為《RankDetNet:探索目標(biāo)檢測中的排序約束(RankDetNet: Delving into Ranking Constraints for Object Detection )》的論文。與此同時,該團(tuán)隊也在CVPR 自動駕駛研討會組織的 2021 Waymo 開放式數(shù)據(jù)集挑戰(zhàn)賽中榮獲三等獎。論文連續(xù)兩年入選 CVPR和挑戰(zhàn)賽全球季軍的成績,展示了賽靈思 AI 研發(fā)團(tuán)隊在理論與實踐“雙引擎”發(fā)展的道路上,正闊步前進(jìn)。

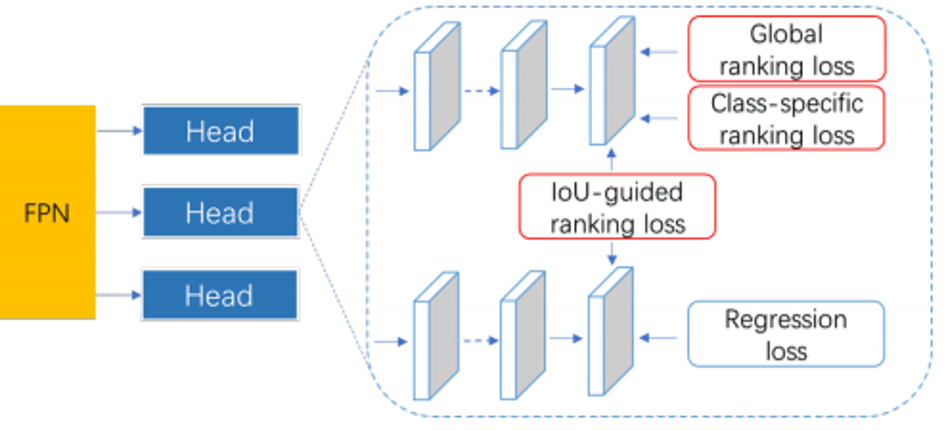

我們的論文采用一種新穎的方法 — 一種用于替代分類來學(xué)習(xí)候選框的排序和定位的排序優(yōu)化方法。我們的工程師探索了各種排序約束條件,如全局排序、特定類別排序以及 IoU-guided 排序的損失等。傳統(tǒng)的分類損失會忽略候選框之間的聯(lián)系,通過配對排序優(yōu)化的方法可以對候選框之間施加約束,這些約束有利于保留高質(zhì)量的檢測結(jié)果。該方法很容易實現(xiàn),能夠與主流檢測框架兼容,而且不會增加推斷計算。

我們的算法是用三種配對的排序損失替換常規(guī)的分類損失。最重要的是,RankDetNet 在 2D 及 3D 目標(biāo)檢測基線方法上實現(xiàn)了性能的一致提高。

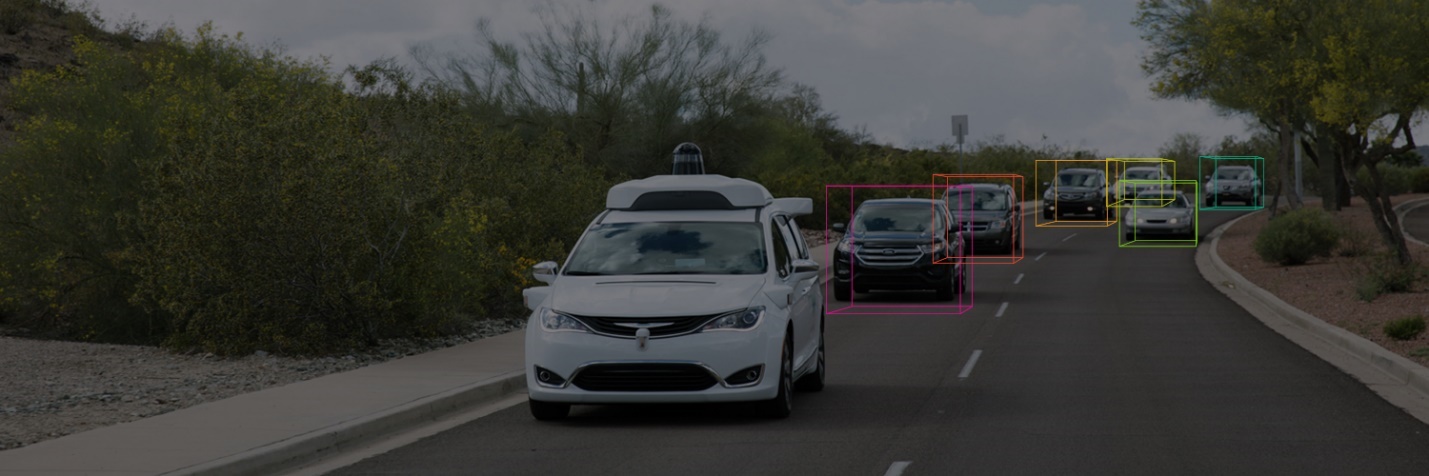

至于“Waymo 開放式數(shù)據(jù)集實時3D檢測挑戰(zhàn)賽”,參賽者的任務(wù)是通過一幅由3D LIDAR掃描生成的深度圖,來為場景中的目標(biāo)生成3D檢測結(jié)果框。與此同時需要保證檢測模型在英偉達(dá)Tesla V100 GPU上能達(dá)到每幀70毫秒的推理速度。

在此次挑戰(zhàn)賽項目上,我們的團(tuán)隊展示了賽靈思在高級駕駛輔助系統(tǒng) (ADAS) 應(yīng)用上的算法開發(fā)實力。依靠多年來端側(cè)部署的經(jīng)驗,我們使用PointPillars做為主干網(wǎng)絡(luò)加快提取點云特征,同時采用Centerpoint的無錨框檢測頭提升精度。為了保證算法的實時性,引入了結(jié)構(gòu)重新參數(shù)化技術(shù)、Quality Focal Loss等無推斷時成本的方法來優(yōu)化檢測性能;同時還在基于網(wǎng)格特征的基礎(chǔ)上引入了基于原始點云的特征,以改進(jìn)檢測目標(biāo)的特征表達(dá)。使用這些方法,該團(tuán)隊最終在68.4毫秒每幀的檢測速度下達(dá)到了70.46 mAPH/L2的準(zhǔn)確度。這個成績讓該團(tuán)隊在3D點云檢測挑戰(zhàn)賽中榮獲了第三名的成績。

而在今年隨后舉行的ICCV 上,賽靈思 AI 研發(fā)團(tuán)隊又有兩篇論文成功入選,再次獲得“雙贏”榮譽。

第一篇論文《通過Bin正則化改進(jìn)低精度網(wǎng)絡(luò)量化,(Improving Low-Precision Network Quantization via Bin Regularization)》,提出了一種新的權(quán)值正則化算法,旨在改進(jìn)低比特網(wǎng)絡(luò)的量化精度。該算法并沒有優(yōu)化weights的整體分布,而是分別優(yōu)化每個量化Bin中的數(shù)據(jù),使其盡可能接近目標(biāo)量化值。這種Bin正則化 方法可以讓weights的每個量化Bin的分布盡可能尖銳,理想情況下接近于Dirac delta分布。主流圖像分類數(shù)據(jù)集 ImageNet上的實驗表明,我們的方法對于不同網(wǎng)絡(luò)結(jié)構(gòu)(ResNet, MobileNetV2, MobileNetV3)、不同bit widths(4/3/2 bits)都獲得了一致的量化精度提升。特別地,我們提出的Bin正則化方法使得 2 bits 的 MobileNetV2 和MobileNetV3-Small 在 ImageNet 上的top-1分別提高了 3.9% 和 4.9%。此外,該方法易于實現(xiàn),而且很容易集成到現(xiàn)有的低比特優(yōu)化算法上,從而進(jìn)一步提高模型量化準(zhǔn)確率。

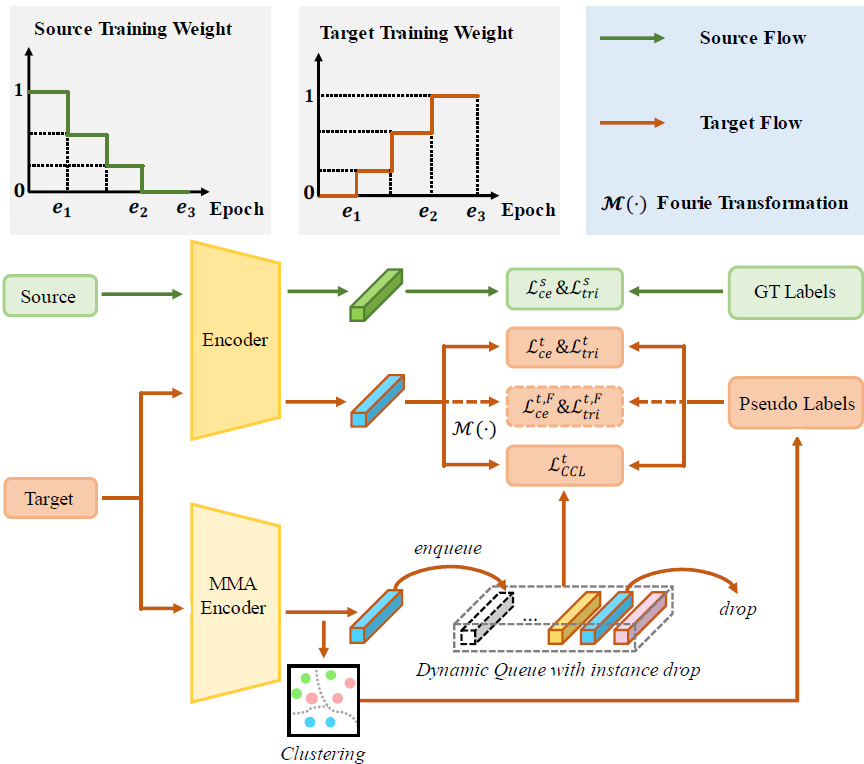

第二篇論文《無監(jiān)督行人再識別的判別表示學(xué)習(xí)(Discriminant representation learning for unsupervised pedestrian re-identification)》,重點解決行人識別模型中典型的“兩階段”訓(xùn)練方法問題。行人再識別是智能監(jiān)控和智慧城市中的重要任務(wù),主要目的是在跨攝像頭中識別同一個行人身份。有監(jiān)督行人再識別通常需要耗時耗力的數(shù)據(jù)標(biāo)注,很大程度上限制了模型的可擴(kuò)展性。例如,當(dāng)把一個在某個場景有監(jiān)督預(yù)訓(xùn)練的模型直接應(yīng)用在一個新場景時,識別效果往往大打折扣。因此,無監(jiān)督域適應(yīng)下的行人再識別應(yīng)運而生,可以應(yīng)對新場景沒有數(shù)據(jù)標(biāo)簽的問題。

為此,我們提出了三種技術(shù)手段來解決這些問題。首先,我們通過特征學(xué)習(xí)和聚類精化的迭代優(yōu)化提出了一種聚類對比學(xué)習(xí)算法(CCL,cluster-wise contrastive learning),以無監(jiān)督的方式學(xué)習(xí)抗噪表示。其次,我們采用漸進(jìn)式域適應(yīng)(PDA,progressive domain adaptation) 算法來逐步縮小源數(shù)據(jù)和目標(biāo)數(shù)據(jù)之間的域差距。第三,我們提出了傅里葉增強(qiáng)(FA,F(xiàn)ourier augmentation),通過在傅里葉空間中施加額外的約束來進(jìn)一步最大化 re-ID 模型的類可分離性。實驗證明,這種方法在多個主流 benchmark 上刷新無監(jiān)督行人再識別的最好性能。例如,在 Market-to-Duke、Duke-to-Market、Market-to-MSMT和Duke-to-MSMT 四個 benchmark 上分別超越 MMT 方法 8.1%、 9.9%、11.4%和11.1% mAP。