概述

云計(jì)算和基于容器的應(yīng)用是推動(dòng)當(dāng)今IT領(lǐng)域產(chǎn)生重大變革的兩大趨勢(shì)。與其他技術(shù)和方法相比,二者都能夠以更高的靈活性和更低的成本去運(yùn)行和操作應(yīng)用,因此日益受到歡迎。然而,在所有新的機(jī)遇面前,要實(shí)現(xiàn)潛在優(yōu)勢(shì)也都會(huì)有巨大的挑戰(zhàn)。

層出不窮的新技術(shù)通常會(huì)對(duì)業(yè)務(wù)運(yùn)營(yíng)產(chǎn)生漸進(jìn)式的影響。但是,以云計(jì)算作為運(yùn)行模式,結(jié)合管理云原生應(yīng)用的Kubernetes——這一做法已經(jīng)改變了信息技術(shù)的交付、管理和使用方式。

此外,為支持這些環(huán)境而設(shè)計(jì)的系統(tǒng)需要選擇計(jì)算、網(wǎng)絡(luò),尤其是存儲(chǔ)系統(tǒng),這些系統(tǒng)具備高度可擴(kuò)展的容量和性能,而無(wú)需采用傳統(tǒng)管理方式。Kubernetes提供機(jī)制,幫助應(yīng)用以透明的方式利用多種計(jì)算和存儲(chǔ)資源。但是,要確保應(yīng)用對(duì)持久數(shù)據(jù)的訪問(wèn),需要底層存儲(chǔ)基礎(chǔ)架構(gòu)具有彈性,同時(shí)還能滿足成千上萬(wàn)個(gè)應(yīng)用的容量和性能需求。

在此背景下,Evaluator Group獲邀對(duì)適合云原生應(yīng)用環(huán)境的兩種存儲(chǔ)系統(tǒng)展開對(duì)比。

● Ceph:云原生環(huán)境中常用的開源軟件定義存儲(chǔ)

● Lightbits云數(shù)據(jù)平臺(tái):專為云環(huán)境設(shè)計(jì)的軟件定義存儲(chǔ)

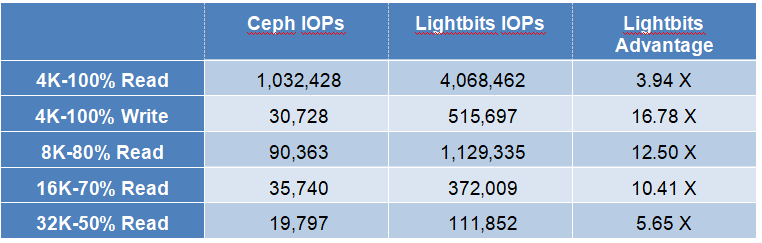

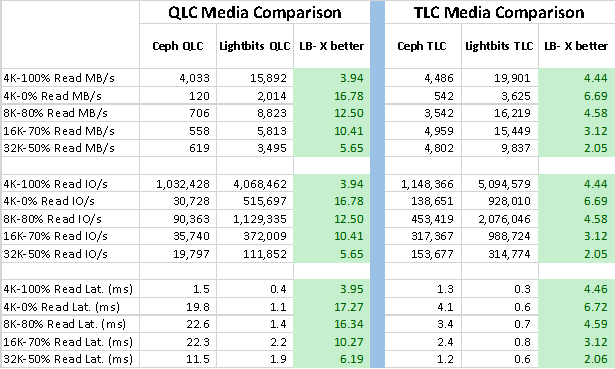

如下所示,在使用相同硬件和存儲(chǔ)介質(zhì)的情況下,Lightbits在所有工作負(fù)載測(cè)試中,實(shí)現(xiàn)的性能均遠(yuǎn)遠(yuǎn)優(yōu)于Ceph。表1匯總顯示了使用QLC介質(zhì)的NVMe固態(tài)硬盤(SSD)的測(cè)試結(jié)果。該測(cè)試使用在OpenShift Kubernetes環(huán)境中作為容器運(yùn)行的工作負(fù)載來(lái)進(jìn)行。

表1:在容器環(huán)境中使用QLC介質(zhì)時(shí)的Lightbits與Ceph I/O速率比較。(來(lái)源:Evaluator Group)

本文的其余部分將更深入地探討二者的技術(shù)和性能差異,以及使用NVMe SSD與TLC介質(zhì)時(shí)的性能數(shù)據(jù)。

新興技術(shù)

如前所述,多個(gè)趨勢(shì)正在推動(dòng)IT領(lǐng)域發(fā)生重大變化;其中,利用公共云等服務(wù)的趨勢(shì)正在改變IT運(yùn)行的地點(diǎn)和付費(fèi)方式,影響了應(yīng)用程序的運(yùn)行方式。云原生應(yīng)用程序(CNA)的推行正在改變應(yīng)用程序的開發(fā)和管理方式,這在一定程度上得益于企業(yè)向服務(wù)和云端遷移的趨勢(shì)。此外,可通過(guò)Fabric去訪問(wèn)NVMe存儲(chǔ)的新技術(shù),以及新的非易失性存儲(chǔ)技術(shù)的出現(xiàn),使得那些能夠利用這些功能的系統(tǒng)擁有顯著的性能優(yōu)勢(shì)。

云原生應(yīng)用程序

基于容器的應(yīng)用程序設(shè)計(jì)旨在運(yùn)行于云環(huán)境,包括本地云和公共云。云原生應(yīng)用程序被設(shè)計(jì)為可獨(dú)立擴(kuò)展的服務(wù),又稱為微服務(wù)。借助微服務(wù)架構(gòu),CNA能夠在少量或甚至無(wú)需管理介入的情況下,按需擴(kuò)展應(yīng)用程序的各個(gè)部分。

此外,CNA部署在一個(gè)位置后,可以根據(jù)可用資源甚至根據(jù)資源的價(jià)格而移動(dòng)到其他位置。另外,許多此類應(yīng)用程序所需的持久性存儲(chǔ)也必須動(dòng)態(tài)響應(yīng)不斷變化的容量和性能需求。

NVMe over Fabrics協(xié)議

非易失性存儲(chǔ)主機(jī)控制器接口規(guī)范(NVMe)是一個(gè)支持固態(tài)硬盤(SSD)去使用高速PCIe總線進(jìn)行通信的接口,以實(shí)現(xiàn)對(duì)固態(tài)設(shè)備的低時(shí)延訪問(wèn)。與SCSI或SATA設(shè)備相比,NVMe支持?jǐn)?shù)十億條命令,顯著減少了延遲或時(shí)延。為了兼容與外部設(shè)備的通信,NVMe over Fabrics擴(kuò)展了NVMe協(xié)議,支持通過(guò)Fabric去訪問(wèn)NVMe。

NVMe over Fabric訪問(wèn)的最新選擇之一是使用TCP傳輸協(xié)議,即NVMe/TCP。實(shí)施這項(xiàng)協(xié)議的技術(shù)負(fù)擔(dān)可顯著減少,無(wú)需任何特定的硬件或交換機(jī)設(shè)置即可支持商用以太網(wǎng)。總體而言,與TCP上的其他存儲(chǔ)協(xié)議相比,在仍然使用現(xiàn)有網(wǎng)絡(luò)基礎(chǔ)設(shè)施的情況下,NVMe over TCP具有更低的時(shí)延和更高的吞吐量。

持久性存儲(chǔ)

持久性存儲(chǔ)(PMem)兼具存儲(chǔ)特性(特別是無(wú)需能耗即可保留或“持久保存”數(shù)據(jù)的能力),以及內(nèi)存總線訪問(wèn)特性(例如極低的時(shí)延和字節(jié)尋址能力)。持久性存儲(chǔ)有兩種主要類型,分別是NVDIMM和英特爾傲騰持久性存儲(chǔ)(Optane Persistent Memory)。NVDIMM和傲騰PMem之間的主要區(qū)別在于存儲(chǔ)密度和成本,其中,與NVDIMM設(shè)備相比,英特爾傲騰PMem持久性存儲(chǔ)在這兩個(gè)方面都具有顯著優(yōu)勢(shì)。

英特爾PMem既可用于“應(yīng)用程序直接訪問(wèn)模式”,也可用于“內(nèi)存模式”。前者需要修改應(yīng)用程序,后者以低于DRAM的成本、透明地?cái)U(kuò)展系統(tǒng)內(nèi)存容量。Lightbits在App Direct模式下使用PMem作為非易失性寫入緩沖區(qū),將寫入和元數(shù)據(jù)訪問(wèn)直接定向至PMem,減少了備份介質(zhì)的磨損,改善了系統(tǒng)寫入性能。

解決方案概述

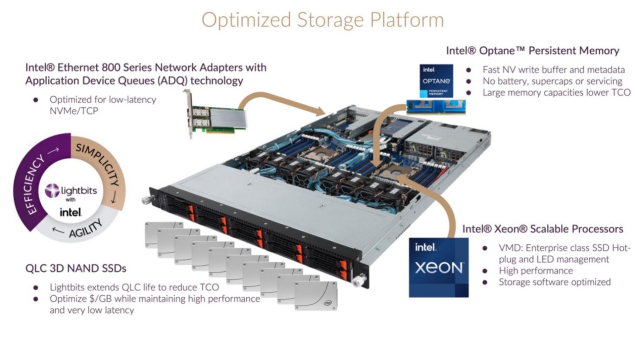

過(guò)去幾十年里,使用商用硬件、以“軟件或軟件定義存儲(chǔ)(SDS)”的形式運(yùn)行的存儲(chǔ)系統(tǒng)日益受到追捧。這種方法之所以引人入勝,是因?yàn)樗軌蛟诓豢墒褂脤S没驅(qū)S杏布沫h(huán)境中運(yùn)行彈性的數(shù)據(jù)中心級(jí)存儲(chǔ)。此外,其靈活性有利于在不同的環(huán)境和部署規(guī)模中使用相同的SDS堆棧。如前所述,我們的評(píng)估中就使用兩種不同的SDS選項(xiàng),為容器應(yīng)用提供持久存儲(chǔ)。隨后將概述它們的功能。采用英特爾技術(shù)的Lightbits解決方案如圖1所示。

圖1:用于Lightbits軟件定義存儲(chǔ)的英特爾平臺(tái)(來(lái)源:英特爾)

英特爾

英特爾為當(dāng)今許多領(lǐng)先的服務(wù)器和存儲(chǔ)解決方案提供基礎(chǔ)平臺(tái)組件。這些組件包括英特爾至強(qiáng)處理器、英特爾網(wǎng)絡(luò)適配器和英特爾傲騰?技術(shù)等,其中,英特爾傲騰?可作為NVMe固態(tài)硬盤,或內(nèi)存形式的傲騰持久性存儲(chǔ)(PMem)設(shè)備提供。此外,具有應(yīng)用設(shè)備隊(duì)列(ADQ)的英特爾Ethernet 800系列提供了高性能、低時(shí)延的NVMe/TCP網(wǎng)絡(luò)接口卡。

Lightbits云數(shù)據(jù)平臺(tái)

Lightbits云數(shù)據(jù)平臺(tái)是一種軟件定義存儲(chǔ),旨在運(yùn)用最新的技術(shù),包括NAND閃存和英特爾傲騰持久性存儲(chǔ)(PMem);它使用高速100GbE網(wǎng)絡(luò)接口卡,支持NVMe over TCP。Lightbits使用分布式架構(gòu),能夠按需獨(dú)立擴(kuò)展CPU、內(nèi)存、PMem或NVMe設(shè)備。因此,Lightbits能夠提供可擴(kuò)展的企業(yè)級(jí)存儲(chǔ),性能優(yōu)于本地NVMe設(shè)備。

Lightbits智能閃存管理解決方案Intelligent Flash Management ?(IFM)支持最大限度地提高SSD性能和延長(zhǎng)其耐用性。其主要特性包括寫條帶化、無(wú)IOP元數(shù)據(jù)訪問(wèn)、智能垃圾收集、追加寫策略和并行讀/寫通道。

通過(guò)將英特爾的高性能硬件平臺(tái)與Lightbits方案進(jìn)行耦合,可提供可擴(kuò)展的解決方案,降低總體擁有成本(TCO)。Lightbits解決方案特別采用了以下技術(shù):

● 英特爾?至強(qiáng)?理器系統(tǒng)

o 高性能CPU、內(nèi)存、I/O和PCIe Gen4

o 使用高性能CPU架構(gòu)的高效存儲(chǔ)軟件

o 企業(yè)級(jí)SSD熱插拔和LED支持NVMe介質(zhì)

● 英特爾傲騰持久性存儲(chǔ)(PMem)

o 低時(shí)延、非易失性寫緩沖區(qū)和元數(shù)據(jù)存儲(chǔ)

o 無(wú)需電池或電容器即可維持持久性

o 大容量持久性存儲(chǔ), 總擁有成本低于其他替代方案

● 英特爾 Ethernet 800系列網(wǎng)絡(luò)適配器

o 提供應(yīng)用設(shè)備隊(duì)列(ADQ)

o 高性能應(yīng)用設(shè)備隊(duì)列

o 低時(shí)延NVMe/TCP,無(wú)需使用定制的驅(qū)動(dòng)程序

通過(guò)Kubernetes容器存儲(chǔ)接口(CSI),Kubernetes管理的容器可以作為持久卷(PV)訪問(wèn)Lightbits存儲(chǔ)。Lightbits CSI插件使Kubernetes能夠使用其“Elastic RAID”在Lightbits集群中存儲(chǔ)持久卷(PV),該“Elastic RAID”提供糾刪碼保護(hù),防止每個(gè)節(jié)點(diǎn)的數(shù)據(jù)丟失。其他Lightbits服務(wù)包括壓縮、復(fù)制、卷快照、克隆和用于多租戶環(huán)境中的基于角色的訪問(wèn)控制(RBAC)。

Ceph

Ceph是一款開源的軟件定義存儲(chǔ)產(chǎn)品,帶有多個(gè)不同的接口,可作為塊設(shè)備、文件系統(tǒng)和目標(biāo)存儲(chǔ)進(jìn)行訪問(wèn)。設(shè)計(jì)Ceph時(shí),采用旋轉(zhuǎn)硬盤驅(qū)動(dòng)器作為主要的存儲(chǔ)介質(zhì),基于NAND的SSD在大多數(shù)主流存儲(chǔ)系統(tǒng)中不發(fā)揮作用。

自Ceph設(shè)計(jì)以來(lái)的15年間,各種外形規(guī)格的固態(tài)閃存已成為高性能存儲(chǔ)系統(tǒng)的主要介質(zhì)。但Ceph初始設(shè)計(jì)中旨在提高旋轉(zhuǎn)物理介質(zhì)性能的許多元素仍得以保留。最近,更新后的Ceph已經(jīng)可以使用固態(tài)的“BlueStore”和“RocksDB”進(jìn)行元數(shù)據(jù)操作。迄今為止,Ceph還沒(méi)有針對(duì)持久性存儲(chǔ)進(jìn)行優(yōu)化,也不支持NVMe over fabrics或NVMe over TCP。

我們?cè)跍y(cè)試中使用Ceph的開源版本,詳見附錄。

存儲(chǔ)效率

與一些軟件定義存儲(chǔ)系統(tǒng)相比,Lightbits的彈性設(shè)計(jì)擁有更多優(yōu)勢(shì)。Lightbits針對(duì)每個(gè)節(jié)點(diǎn)使用糾刪碼保護(hù),確保在丟失存儲(chǔ)設(shè)備時(shí)的數(shù)據(jù)可用性;此外,節(jié)點(diǎn)之間可進(jìn)行復(fù)制,因此,Lightbits能夠在減少開銷和存儲(chǔ)容量浪費(fèi)的同時(shí),提供 更大的彈性。在測(cè)試期間,Lightbits的配置是:在每個(gè)節(jié)點(diǎn)上使用糾刪碼來(lái)保護(hù)數(shù)據(jù),同時(shí)在Lightbits集群中的另一個(gè)節(jié)點(diǎn)上額外制作一份數(shù)據(jù)拷貝。

與此相反,Ceph的配置是:創(chuàng)建三個(gè)數(shù)據(jù)副本來(lái)進(jìn)行數(shù)據(jù)保護(hù),此時(shí),如果一個(gè)節(jié)點(diǎn)的驅(qū)動(dòng)器和另一個(gè)節(jié)點(diǎn)出現(xiàn)故障斷電,則無(wú)法確保數(shù)據(jù)可用性。盡管這兩種保護(hù)方法的存儲(chǔ)效率相似,但Lightbits方法的可用性更高。

不同容器工作負(fù)載下的性能

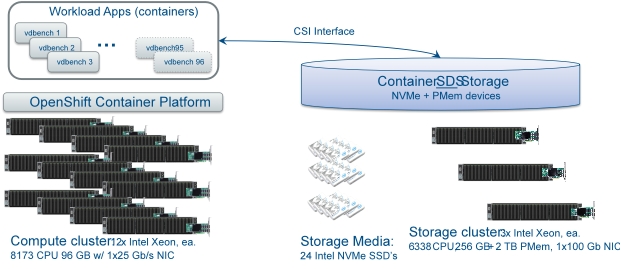

Evaluator Group需對(duì)Kubernetes應(yīng)用環(huán)境中作為容器運(yùn)行的兩種不同的存儲(chǔ)產(chǎn)品進(jìn)行分析。我們對(duì)Lightbits軟件定義存儲(chǔ)與面向容器的開源軟件定義存儲(chǔ)產(chǎn)品Ceph進(jìn)行了比較。測(cè)試環(huán)境由12個(gè)Kubernetes節(jié)點(diǎn)組成,在專用的3節(jié)點(diǎn)Lightbits集群或3節(jié)點(diǎn)Ceph集群中運(yùn)行容器工作負(fù)載。容器應(yīng)用測(cè)試圖表和其他細(xì)節(jié)、硬件、軟件和其他方面的詳細(xì)信息,請(qǐng)參見附錄描述。

測(cè)量存儲(chǔ)性能時(shí),使用眾所周知的“vdbench”工具創(chuàng)建工作負(fù)載,每個(gè)節(jié)點(diǎn)使用8個(gè)運(yùn)行vdbench的容器實(shí)例,總共96個(gè)vdbench實(shí)例。

測(cè)試包括性能敏感型應(yīng)用中常見的5種不同的訪問(wèn)模式和塊大小:

● 4KB,100%讀取,100%隨機(jī)訪問(wèn)

● 4KB,100%寫入,100%隨機(jī)訪問(wèn)

● 8KB,80%讀取/20%寫入,80%隨機(jī)訪問(wèn)

● 16KB,70%讀取/30%寫入,80%隨機(jī)訪問(wèn)

● 32KB,50%讀取/50%寫入,80%隨機(jī)訪問(wèn)

這些工作負(fù)載用于比較Lightbits與Ceph的性能,使用QLC固態(tài)介質(zhì)作為主要存儲(chǔ)介質(zhì),并根據(jù)每個(gè)存儲(chǔ)系統(tǒng)使用適當(dāng)?shù)母咚俪志媒橘|(zhì)。在所有情況下,分別多次運(yùn)行5個(gè)工作負(fù)載,獲得可用于比較的平均結(jié)果。有關(guān)Lightbits和Ceph配置的具體細(xì)節(jié),請(qǐng)參見附錄。

Evaluator Group評(píng)論:測(cè)試結(jié)果顯示,使用Lightbits具有巨大的性能優(yōu)勢(shì),其中,4KB寫入工作負(fù)載的性能是Ceph的16倍。考慮到在所有比較中,底層介質(zhì)的數(shù)量和類型是相同的,這種優(yōu)勢(shì)尤為明顯。

圖2:Ceph與Lightbits吞吐量比較(來(lái)源:Evaluator Group)

圖2顯示了使用QLC介質(zhì)時(shí),Lightbits和Ceph在5種不同訪問(wèn)模式下的吞吐量結(jié)果。吞吐量結(jié)果是直接可比較的,因?yàn)樗鼈兛紤]了數(shù)據(jù)塊大小的差異,因此將其全部顯示在一起。

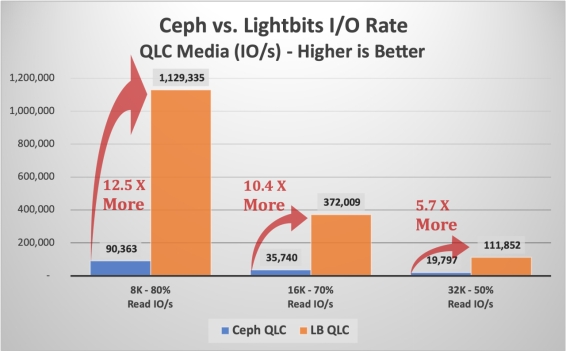

性能詳情

I/O速率(以每秒I/O傳輸次數(shù)或IOPs衡量)是小數(shù)據(jù)塊工作負(fù)載的常用指標(biāo),但不利于對(duì)比不同的數(shù)據(jù)塊大小。如下方圖3所示,對(duì)典型應(yīng)用大小——8KB、16KB和32 KB進(jìn)行比較,繪制I/O速率,以每秒I/O傳輸次數(shù)衡量。在32KB時(shí),Lightbits的優(yōu)勢(shì)是5.7倍,在16KB時(shí),優(yōu)勢(shì)是10.4倍,在8K工作負(fù)載時(shí),Lightbits的性能超過(guò)Ceph 12倍。

圖3:使用QLC介質(zhì)時(shí)Lightbits與Ceph的性能對(duì)比–不同數(shù)據(jù)塊大小的吞吐量(來(lái)源:Evaluator Group)

上文顯示的三種工作負(fù)載是數(shù)據(jù)庫(kù)或其他事務(wù)應(yīng)用程序中的常見負(fù)載。盡管許多數(shù)據(jù)庫(kù)嘗試執(zhí)行16K或32K大小的I/O,但在許多情況下,如果更改較小或事務(wù)率較高,它們傾向于使用較小數(shù)據(jù)塊。數(shù)據(jù)庫(kù)將執(zhí)行8K甚至4K事務(wù),而非等待合并幾個(gè)較小的I/O。

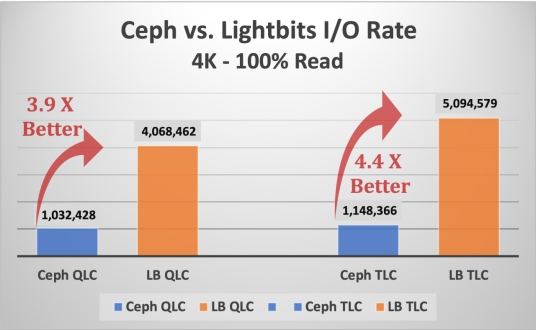

以下顯示Ceph和Lightbits使用兩種不同類型的存儲(chǔ)介質(zhì),即QLC和TLC介質(zhì)時(shí),4KB讀取操作的I/O速率比較。

圖4:使用QLC和TLC介質(zhì)時(shí),Ceph與Lightbits的4KB讀取I/O速率比較(來(lái)源:Evaluator Group)

雖然會(huì)發(fā)生4KB讀取操作,但4KB寫入操作更經(jīng)常用于數(shù)據(jù)庫(kù)日志記錄操作。使用QLC介質(zhì)時(shí),Lightbits的性能比Ceph高出近17倍,使用TLC介質(zhì)時(shí),性能比Ceph高出近7倍,如下圖5所示。

圖5:使用QLC和TLC介質(zhì)時(shí),Ceph與Lightbits的4KB寫入I/O速率比較(來(lái)源:Evaluator Group)

Evaluator Group評(píng)論: 數(shù)據(jù)庫(kù)和其他事務(wù)應(yīng)用程序依賴于低時(shí)延存儲(chǔ),尤其是事務(wù)日志,后者必須在事務(wù)完成前寫入持久介質(zhì)。日志大多通過(guò)4K I/O操作寫入,在此工作負(fù)載下,Lightbits顯示出比Ceph更大的優(yōu)勢(shì):使用TLC介質(zhì)時(shí),優(yōu)勢(shì)高出近7倍,使用QLC時(shí),優(yōu)勢(shì)高出近17倍。

其他性能數(shù)據(jù)

下文為性能結(jié)果概述,其中指出三個(gè)主要指標(biāo),包括吞吐量、I/O速率以及時(shí)延。Lightbits相對(duì)于Ceph的性能優(yōu)勢(shì)極其顯著,因此用“x”倍數(shù)來(lái)體現(xiàn)這種優(yōu)勢(shì)。使用簡(jiǎn)單的除法(即515,697 / 30,728 = 16.78 x)來(lái)顯示Lightbits性能優(yōu)勢(shì)倍數(shù)。要點(diǎn)如下:

● 在所有五個(gè)工作負(fù)載下的測(cè)試結(jié)果表明,Lightbits具有4到16倍的優(yōu)勢(shì)

● 數(shù)據(jù)庫(kù)經(jīng)常使用對(duì)時(shí)延高度敏感的小塊寫入日志或日記

● 在4KB寫入下,Lightbits的性能優(yōu)勢(shì)為16.78倍,優(yōu)勢(shì)顯著

表3:Lightbits與Ceph性能比較(來(lái)源:Evaluator Group)

關(guān)于測(cè)試,還有一點(diǎn)值得留意,即在使用QLC介質(zhì)時(shí),Ceph的時(shí)延高于大多數(shù)工作負(fù)載可接受的水平。這是因?yàn)椋覀冊(cè)谒袦y(cè)試中使用相同的隊(duì)列深度設(shè)置,確保比較結(jié)果的公平公正。如果工作負(fù)載針對(duì)Ceph QLC進(jìn)行了優(yōu)化,將使用較低的隊(duì)列深度設(shè)置,從而降低I/O速率,同時(shí)減小時(shí)延。如果以這種方式進(jìn)行測(cè)試,Ceph的時(shí)延水平更易于接受,但性能會(huì)顯著降低,從而放大Lightbits的優(yōu)勢(shì)。

最終結(jié)論

性能始終是IT基礎(chǔ)設(shè)施的重要考慮因素,尤其是在運(yùn)行云環(huán)境或托管云原生應(yīng)用程序時(shí)。盡管并非每個(gè)應(yīng)用或微服務(wù)都需要高I/O速率,但如要運(yùn)行現(xiàn)代云基礎(chǔ)設(shè)施,提供具有高I/O速率和低時(shí)延的彈性、可擴(kuò)展存儲(chǔ)至關(guān)重要。

Evaluator Group評(píng)論:在使用相同硬件配置的情況下,Lightbits的性能顯著優(yōu)于Ceph,彈性也更高。Lightbits針對(duì)英特爾的高性能技術(shù)進(jìn)行優(yōu)化,為支持云的Kubernetes環(huán)境提供了強(qiáng)大的存儲(chǔ)平臺(tái)。

近期技術(shù)進(jìn)展層出不窮,助力IT用戶去大規(guī)模、經(jīng)濟(jì)高效地運(yùn)營(yíng)基礎(chǔ)設(shè)施。當(dāng)與英特爾傲騰持久性存儲(chǔ)結(jié)合使用時(shí),QLC等新型存儲(chǔ)介質(zhì)可以為要求不高的工作負(fù)載支持海量存儲(chǔ)容量,并提供良好的性能。包括新處理器和端到端NVMe在內(nèi)的其他技術(shù)也可以提供性能和成本優(yōu)勢(shì)。

英特爾的專有技術(shù),如Xeon CPU、支持NVMe over TCP的英特爾網(wǎng)卡,以及傲騰持久性存儲(chǔ)和高密度NVMe SSD,為軟件定義產(chǎn)品提供了強(qiáng)大的硬件基礎(chǔ)。由于高效利用了英特爾CPU、網(wǎng)絡(luò)接口和持久存儲(chǔ)介質(zhì),Lightbits存儲(chǔ)可提供本地NVMe級(jí)別的性能,從而持續(xù)確保低時(shí)延和數(shù)據(jù)服務(wù)。

本文中所示的性能測(cè)試使用了IT環(huán)境和應(yīng)用中常見的工具和工作負(fù)載。附錄提供了進(jìn)一步的詳細(xì)信息,如希望進(jìn)一步了解測(cè)試,或希望使用自己的硬件配置重復(fù)這些測(cè)試,可參考附錄。

Evaluator Group評(píng)論:借助存儲(chǔ)專業(yè)人員熟知的測(cè)試工具和工作負(fù)載,我們認(rèn)為,Lightbits可以提升現(xiàn)代應(yīng)用程序的性能。Lightbits可以通過(guò)QLC介質(zhì)和傲騰PMem,支持時(shí)延敏感型應(yīng)用,而Ceph在明顯具有更高延遲的情況下只能提供很低的I/O速率。

利用持久性存儲(chǔ)和端到端NVMe等新技術(shù),Lightbits即可提供比Ceph更優(yōu)異的性能,且彈性更高。顯而易見,Lightbits的性能是Ceph的16倍,時(shí)延更低,是適合現(xiàn)代應(yīng)用和云環(huán)境的更佳選擇。

附錄

測(cè)試環(huán)境詳情

測(cè)試環(huán)境利用以下硬件、軟件和應(yīng)用工作負(fù)載項(xiàng)目。

測(cè)試持續(xù)4個(gè)月,從2021年9月起至12月止。

硬件和基礎(chǔ)設(shè)施

● 關(guān)于測(cè)試配置的概述,請(qǐng)參見下方圖6

o 在裸機(jī)上運(yùn)行的應(yīng)用集群,由12個(gè)Kubernetes“worker”節(jié)點(diǎn)組成

o 3節(jié)點(diǎn)管理集群/作為虛擬機(jī)運(yùn)行的Kubernetes“master”節(jié)點(diǎn)

o 運(yùn)行軟件定義存儲(chǔ)堆棧的3節(jié)點(diǎn)存儲(chǔ)集群

● 應(yīng)用環(huán)境和編排使用OpenShift 4.6版

圖6:OpenShift訪問(wèn)存儲(chǔ)節(jié)點(diǎn)的工作負(fù)載測(cè)試設(shè)置(來(lái)源:Evaluator Group)

軟件環(huán)境

● 使用Red Hat OpenShift 4.6版作為3個(gè)管理節(jié)點(diǎn)和12個(gè)應(yīng)用節(jié)點(diǎn)

o 12個(gè)應(yīng)用(OpenShift“worker”)節(jié)點(diǎn)直接運(yùn)行于硬件上,因此稱為“裸機(jī)”

o 3個(gè)管理(OpenShift“master”)節(jié)點(diǎn)作為虛擬機(jī)運(yùn)行,但作為“裸機(jī)”安裝

● CentOS 8.4版是3個(gè)Ceph節(jié)點(diǎn)使用的基礎(chǔ)操作系統(tǒng)

● Ceph SDS堆棧使用開源Ceph 16.2.6版(又名“Pacific”)

● VMware 7.0;3臺(tái)虛擬機(jī)使用ESXi及vCenter

SUT配置

● 一個(gè)12節(jié)點(diǎn)應(yīng)用集群,運(yùn)行Red Hat OpenShift

o 應(yīng)用/工作節(jié)點(diǎn)配置:

雙插槽第一代英特爾至強(qiáng)可擴(kuò)展系統(tǒng)(Intel Xeon Platinum 8173M)

96 GB內(nèi)存(12個(gè)8 GB DIMM)

英特爾XXV710-DA2網(wǎng)卡,每臺(tái)主機(jī)帶2個(gè)25 Gb/s連接

● 兩個(gè)存儲(chǔ)系統(tǒng)連接到OpenShift應(yīng)用集群

o SDS #1,Ceph配置:

雙插槽第三代英特爾至強(qiáng)可擴(kuò)展系統(tǒng)(Intel Xeon Gold 6338)

256 GB內(nèi)存(16個(gè)16 GB DIMM)

2 TB的英特爾傲騰PMem(配置為WAL和Cache設(shè)備)

英特爾E810-CQDA2網(wǎng)卡,每臺(tái)主機(jī)帶1個(gè)100 Gb/s連接

8個(gè)英特爾NVMe存儲(chǔ)介質(zhì),可選擇

● QLC SSD介質(zhì):英特爾SSD D5-P5316 @ 15.36 TB

● TLC SSD介質(zhì):英特爾SSD D7-P5510 @ 3.84 TB

o SDS #2,Lightbits配置:

雙插槽第三代英特爾至強(qiáng)可擴(kuò)展系統(tǒng)(Intel Xeon Gold 6338)

256b GB內(nèi)存(16個(gè)16 GB DIMM)

2 TB英特爾傲騰持久性存儲(chǔ)Persistent Memory 200(配置為L(zhǎng)ightbits寫入緩沖區(qū))

英特爾E810-CQDA2網(wǎng)卡,每臺(tái)主機(jī)帶1個(gè)100 Gb/s連接

8臺(tái)英特爾NVMe存儲(chǔ)設(shè)備,可選擇:

● QLC SSD介質(zhì):英特爾SSD D5-P5316 @ 15.36 TB

● TLC SSD介質(zhì):英特爾SSD D7-P5510 @ 3.84 TB

客戶端配置–基礎(chǔ)設(shè)施

● 使用運(yùn)行VMware ESXi的單一英特爾系統(tǒng)來(lái)支持基礎(chǔ)設(shè)施

o 3臺(tái)虛擬機(jī)用作OpenShift“master”節(jié)點(diǎn)

o 運(yùn)行Microsoft Server 2019的“jump”主機(jī),用于遠(yuǎn)程訪問(wèn)基礎(chǔ)設(shè)施

SDS存儲(chǔ)配置

Ceph配置

備注:Ceph沒(méi)有“默認(rèn)”配置,由于硬件的可用性和其他配置參數(shù),每次安裝都可能不同。有關(guān)配置,請(qǐng)參見下文:

● 使用“CentOS 8.4版”作為所有三個(gè)節(jié)點(diǎn)的主機(jī)操作系統(tǒng)

● 按照上述定義配置硬件,每個(gè)節(jié)點(diǎn)配置8個(gè)NVMe設(shè)備

● 下載后,在全部3個(gè)節(jié)點(diǎn)上配置Ceph“Pacific”

o 將2 TB的PMem分成兩個(gè)分區(qū),一個(gè)用于WAL,另一個(gè)用于RocksDB

o 每個(gè)NVMe SSD配置為6個(gè)邏輯OSD(每臺(tái)設(shè)備設(shè)置6個(gè)OSD)

● Ceph設(shè)備配置

o 每臺(tái)主機(jī)有8個(gè)SSD,分別被劃分為6個(gè)區(qū)域

o 在8個(gè)物理SSD上使用6個(gè)分區(qū),每個(gè)系統(tǒng)總共有6 * 8 = 48個(gè)OSD

o Ceph配置了駐留在Optane PMem上的WAL

● 默認(rèn)資源設(shè)置:

o CPU設(shè)置為每個(gè)OSD 1個(gè)CPU,內(nèi)存設(shè)置為每個(gè)設(shè)備4 GB

Lightbits配置

備注:Lightbits沒(méi)有“默認(rèn)”配置。Lightbits和英特爾工程部門為L(zhǎng)ightbits執(zhí)行了所有的設(shè)置操作。有關(guān)配置,請(qǐng)參見下文:

● 使用“Lightbits”作為全部三個(gè)節(jié)點(diǎn)的主機(jī)操作系統(tǒng)

● 按照上述定義配置硬件,每個(gè)節(jié)點(diǎn)配置8個(gè)NVMe設(shè)備

● 在全部3個(gè)節(jié)點(diǎn)上配置Lightbits

o 指定2 TB的PMem作為緩存設(shè)備

o 將每個(gè)NVMe SSD用作邏輯設(shè)備

應(yīng)用工作負(fù)載

● 使用“vdbench”工具,生成具有不同數(shù)據(jù)塊大小和讀寫比率的合成工作負(fù)載

o 在開始其他測(cè)試之前,運(yùn)行“寫入-填充”工作負(fù)載,完全寫入被測(cè)的整個(gè)存儲(chǔ)容量

o 每個(gè)測(cè)試運(yùn)行15分鐘進(jìn)行“預(yù)熱”,然后運(yùn)行30分鐘進(jìn)行“測(cè)量”

o 測(cè)試按順序進(jìn)行,每完成5個(gè)測(cè)試稱為一“組”

o 每個(gè)測(cè)試組重復(fù)9次,用9輪運(yùn)行結(jié)果的平均值進(jìn)行比較

● 針對(duì)存儲(chǔ)配置測(cè)試以下5種工作負(fù)載

o 4KB,100%讀取,100%隨機(jī)訪問(wèn)

o 4KB,100%寫入,100%隨機(jī)訪問(wèn)

o 8KB,80%讀取/20%寫入,100%隨機(jī)訪問(wèn)

o 16KB,70%讀取/30%寫入,80%隨機(jī)訪問(wèn)

o 32KB,50%讀取/50%寫入,50%隨機(jī)訪問(wèn)

測(cè)試過(guò)程概述

● 設(shè)置用于應(yīng)用的服務(wù)器和網(wǎng)絡(luò)

● 設(shè)置系統(tǒng),安裝附加測(cè)試基礎(chǔ)設(shè)施使用的VMware

● 在15個(gè)系統(tǒng)上安裝OpenShift(12個(gè)“worker”裸機(jī)硬件和3個(gè)“master”虛擬機(jī)節(jié)點(diǎn))

● 安裝和配置軟件定義存儲(chǔ)目標(biāo)集群

o 將Lightbits安裝到3個(gè)節(jié)點(diǎn)上,用于Lightbits SDS存儲(chǔ)

o 安裝CentOS,并在用于Ceph SDS存儲(chǔ)的3個(gè)節(jié)點(diǎn)上安裝Ceph Pacific

● 創(chuàng)建包含96個(gè)vdbench客戶端容器實(shí)例和1個(gè)vdbench控制器實(shí)例的容器工作負(fù)載環(huán)境

● 在控制器容器上運(yùn)行vdbench工作負(fù)載,將工作負(fù)載分配給所有96個(gè)vdbench實(shí)例

● 為每個(gè)工作負(fù)載收集9組結(jié)果,得到平均I/O速率、吞吐量和時(shí)延

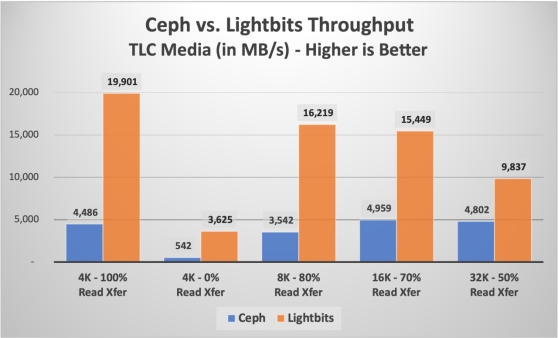

使用TLC介質(zhì)進(jìn)行比較

使用QLC介質(zhì)測(cè)試完畢后,重新將兩個(gè)存儲(chǔ)系統(tǒng)配置為使用TLC介質(zhì)設(shè)備,而非QLC設(shè)備。眾所周知,TLC介質(zhì)的寫入I/O速率更優(yōu),時(shí)延更低。同樣,測(cè)試兩個(gè)存儲(chǔ)系統(tǒng)時(shí),使用相同的工作負(fù)載,在相同的服務(wù)器硬件、網(wǎng)絡(luò)上運(yùn)行,最重要的是,使用相同數(shù)量和類型的存儲(chǔ)介質(zhì)。基于TLC的NVMe固態(tài)設(shè)備作為主要的存儲(chǔ)介質(zhì),并根據(jù)最佳實(shí)踐,為每個(gè)存儲(chǔ)堆棧使用英特爾傲騰PMem。

圖7:TLC多工作負(fù)載下的Lightbits與Ceph吞吐量比較(來(lái)源:Evaluator Group)

圖7顯示了使用TLC SSD介質(zhì)時(shí),五次相同測(cè)試的吞吐量結(jié)果。顯示吞吐量結(jié)果旨在提供可直接比較的結(jié)果,不過(guò)I/O速率是更常用于顯示單個(gè)小數(shù)據(jù)塊工作負(fù)載的指標(biāo)。