昨天壁仞科技的首顆GPU芯片發(fā)布之際,發(fā)布會上播放的宣傳片還真是能讓人聯想起英偉達“I am AI”的那則著名視頻。而壁仞科技選擇的這條賽道,和大部分做AI芯片的國內廠商都不大一樣:其GPU芯片、板卡和系統(tǒng)是要和英偉達正面硬碰硬,用于云上大規(guī)模的AI訓練與推理,以及HPC的。

壁仞科技創(chuàng)始人、董事長、CEO張文說從最初走訪20家客戶的反饋來看,大家都想要一款“國產大算力芯片”。雖說“做通用GPU芯片,99%都做不下去”,但“我思考,周期長、壁壘高、投入大,換句話說就是資本密集、人才密集和資源密集的需求。這三點恰好都是我的長項。”于是在成功說服投資人以后,壁仞就開啟了這一征程。

壁仞科技成立于2019年9月,用張文的話來說“三年時間,發(fā)展到千人團隊、芯片從PPT到量產”是個奇跡。今年3月底就有壁仞B(yǎng)R100芯片成功點亮的消息,“全球通用GPU算力記錄,第一次由中國企業(yè)創(chuàng)造。”張文說,“中國通用GPU芯片,第一次進入每秒1千萬億次的計算新時代。”

而從壁仞科技的宣傳片來看,其GPU芯片要覆蓋“從微觀細胞到浩瀚宇宙,從堅實的道路到虛擬的空間”,從生物科學、工業(yè)設計、生產制造,到農業(yè)耕作、航天航海、地質勘探與宇宙探索。大約算是與英偉達的全方位市場重合了。要做到這些可真的不容易,也絕不僅僅是算力堆砌所能輕易達成的。本文我們就詳細談談壁仞科技本次發(fā)布的1個架構、2顆芯片(及對應的OAM module與PCIe板卡)、1臺服務器,以及對應于生態(tài)建設的軟件棧。

兩顆芯片:BR100與BR104

這次壁仞科技發(fā)布了兩顆芯片:BR100和BR104。這兩者的區(qū)別主要在于BR100是兩片相同的die(或chiplet)封裝到一起;BR104則只用了1片die,所以相關算力與IO等參數大多為前者的一半,適配不同的市場需求。

所以我們將注意力主要放在BR100身上。從一些關鍵數據就可以看出本次發(fā)布的BR100 GPU是真正的“大”芯片。壁仞在宣傳中提到“創(chuàng)下全球(通用GPU芯片的)算力記錄”“單芯片算力達到PFLOPS級別”“峰值算力是國際廠商在售旗艦產品3倍以上”。

從制造和封裝技術的堆料來看,應該更能體會其規(guī)模,包括7nm工藝、“770億個晶體管”,以及張文提到的“1000mm2”左右的die size。這個die size數字當然也就突破了光刻機所能處理的reticle limit,所以是將兩片die封裝到一起。

從壁仞科技聯合創(chuàng)始人、CTO洪洲的介紹來看,BR100明確采用了臺積電的2.5D CoWoS-S封裝方案——兩片die和周邊HBM2e內存都放在一片硅中介(silicon interposer)上。我們在剛剛發(fā)布的《先進封裝的現在和將來》一文中詳細介紹過這種先進封裝技術,國內廠商在用的應當還寥寥無幾。

而且die to die互連采用超高速112G PAM4 SerDes,die間通訊帶寬達到了896GB/s——這個速度可一點也不比某“國際大廠”發(fā)布沒多久的Grace Hopper Superchip的NVLink-C2C差。

基于以上數字,推薦感興趣的同學去比一比,以及Intel Ponte Vecchio GPU,在die size、晶體管數量和先進封裝技術的應用上都有一定的可比性;也能更進一步地體會壁仞B(yǎng)R100大約是怎樣的定位。

實際上,英偉達在今年GTC上發(fā)布、尚未上市的Hopper架構的GH100 die size為814mm2,800億個晶體管。“大芯片”之間過招,在堆料上真的已經到了白熱化程度。

BR100的理論算力水平如上圖所示,不同格式與精度的算力值,對應于BR100在訓練和推理方面的適用性。壁仞提到的“全球算力記錄”和突破PFLOPS,應該就是指BF16格式(1024 TFLOPS)。

這里有個TF32+,是壁仞新推的一種數據格式,后文將會提到。在AI訓練中相對關鍵的BF16、TF32/TF32+峰值理論算力,都有著很漂亮的水平;著力推理的Int8也達到了2048 TOPS。

其他配置數據還包括2.5D封裝在一起的64GB HBM2e內存,“超300MB片上緩存”,2.3TB/s外部I/O帶寬,64路高清編碼、512路高清解碼加速。

對比“國際廠商在售旗艦”的峰值算力數據——這很顯然比的就是Ampere架構的A100;AI計算相關主要數據格式的差異還是實打實的(FP32的數據,屬于欺負A100的算力側重點了;而且A100堆的FP64算力在HPC領域也是很重要的)。

據說在“開發(fā)者云上的實測算力”,BR100的數據還更好看一些。有興趣的同學還可以拿尚未發(fā)售的英偉達Hopper新架構來比一比,雖然這種峰值算力對比的意義并不算特別大。另外要考慮對比雙方的芯片產品大規(guī)模鋪貨的時間。

到更為真實的負載中,跑主流、具代表性的網絡,包括CV、NLP,還有現在很流行的Transformer,壁仞B(yǎng)R100仍然是有不小的優(yōu)勢的,“平均加速比2.6x”。不過這種涉及到實際業(yè)務的對比,不僅是芯片本身,還要帶上系統(tǒng)、軟件的對比,應當進一步明確對比對象和內容。我們很期待未來看到壁仞B(yǎng)R100及對應系統(tǒng)參與MLPerf基準測試。

實則從這些與競品的性能對比數據,是能夠發(fā)現壁仞研發(fā)團隊的前瞻性的。這家公司2019年定義BR100芯片,到如今產品發(fā)布歷經3年時間,AI與通用計算加速市場環(huán)境變化不小。首次做芯片,就要預見未來3年的算力增長,并在對應時間節(jié)點把產品拿出來,既有風險又有難度。

另外,單die的BR104主要配置與參數如下圖所示。據說即便是單die的BR104,相比于“國際廠商在售旗艦”仍然有著1.4-1.6倍的算力優(yōu)勢,包括上述不同數據格式,與主流模型基準測試性能比較。

有關芯片架構、特性、存儲子系統(tǒng)、IO互連的部分此處還尚未提到;比如說主機接口PCIe Gen 5,也特別支持了CXL互連協議;還有壁仞自研的BLink點對點全互連技術能將8個GPU有效連接在一起等等。我們將這部分放到本文的最后。

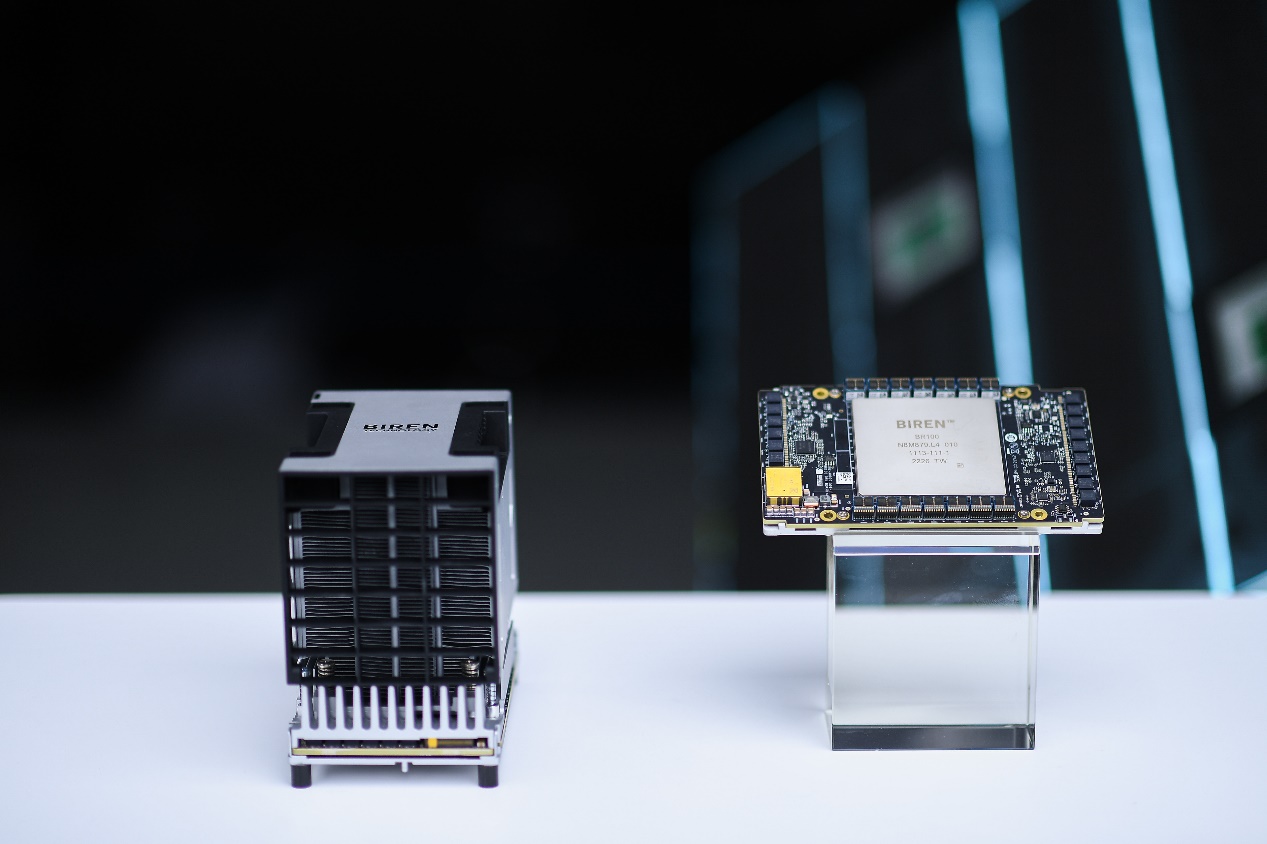

芯片構成模組、板卡和服務器以后

更往上的板級系統(tǒng)層面,BR100、BR104芯片當然是需要對應到具體的產品形態(tài)的。這次壁仞發(fā)布了兩款具體的硬件產品:壁礪100和壁礪104,分別應用了BR100和BR104芯片,這兩款產品分別以OAM(OCP Accelerator Module)模組與PCIe板卡的形態(tài)存在。算力規(guī)格之外,功耗分別對應550W和300W。

壁仞科技聯合創(chuàng)始人、總裁徐凌杰特別提到,其中壁礪100“在板級和系統(tǒng)層面做了非常多的創(chuàng)新”。供電方面,“我們專門為這套系統(tǒng)打造了48V電源,有著超高的電源密度和開關頻率,提供穩(wěn)定的供電和超高的電源效率。”

而在散熱方面,“我們在板卡上采用快速均溫技術,增加了熱腔體積和撞風面積,有效提升了散熱效率。”徐凌杰表示,“我們還優(yōu)化了散熱器的外形,能夠在不影響散熱的前提下降低5%以上的風阻。”除此之外,“考慮到系統(tǒng)的穩(wěn)定性和可靠性,我們也設計了一套專門的中斷和保護機制。”右圖的熱力圖表現的是OAM模組之上溫度的分布情況。

系統(tǒng)和性能擴展相關的部分,應該也是很多人關注的重點。“我們把8個OAM模組放在通用UBB主板上,形成8卡之間點對點的全互連拓撲。充分利用BR100上面的高速接口,和UBB的互連基礎設施,8張卡之間兩兩互連。”徐凌杰說,“節(jié)點內每張卡能夠有448GB/s的互連帶寬,節(jié)點之外還有64GB的帶寬。”8卡對分帶寬1.8TB/s。

這是“國內芯片設計廠商中,第一個實現在OAM系統(tǒng)中,單節(jié)點8卡的全互連拓撲”。全互連拓撲的價值,自然就在于專線通信,每張卡在系統(tǒng)中完全對稱,便于分布式調度和部署。

PCIe板卡形態(tài)的壁礪104則能夠部署在大部分2-4U的服務器里。徐凌杰特別提到,壁礪104也能夠實現多卡之間的高速互連。“我們?yōu)榇藢iT設計了高速的橋片,能夠在4張卡之間形成點對點的全互連拓撲,帶寬192GB/s。”

值得一提的是,本次發(fā)布會上壁仞特別宣布了與浪潮合作推出的OAM服務器:海玄。這臺服務器的理論峰值算力(BF16)達到8 PFLOPS;512GB HBM2e內存;支持PCIe 5.0和CXL;1.8TB/s對分互連帶寬;最大功耗7kW。

這個部分的最后,有必要說一說AI芯片與GPU廠商于系統(tǒng)層面的常規(guī)對比項目:少不了要和“國際廠商”對比TCO(總擁有成本)和功耗。這是真正涉及到性價比和效率的部分。

徐凌杰表示,“用國際巨頭在售的旗艦產品,6000臺服務器(DGX A100 640GB?)可以達到15 EFLOPS的浮點算力,需要3000臺機柜,占地空間1萬平方米以上,峰值功耗39兆瓦,最高需要3.4億度電每年,相當于4.2萬噸煤的發(fā)電量。”

而如果換成OAM服務器海玄,“只需要2000臺海玄服務器,達到16 EFLOPS的算力;只需要1000個機柜,占地面積不超過3500平方米,峰值功耗14兆瓦,1.2億度年用電量,相當于1.5萬噸標準煤發(fā)電量,實現了整體方案64%的成本下降。”

當然這是個理想數據,我們在不少AI芯片供應商那里都看到過類似的對比;實際情況很大程度還是受到業(yè)務類型、開發(fā)生態(tài)、軟件和系統(tǒng)效率等各方面的因素影響。目前壁礪104 PCIe板卡已經向部分用戶“開放邀測”,而海玄OAM服務器則“正在內部進行緊鑼密鼓的測試,即將在下個季度與客戶見面”。

軟件與生態(tài)建設情況

洪洲在介紹芯片架構之前就提到,壁仞科技要“占領數字經濟的制高點”。“我們計劃通過我們的芯片、計算卡,要承載我們的軟件來對接應用。剛開始兼容主流生態(tài),然后搶占整個生態(tài)的話語權”。“我們關鍵是要打造生態(tài),真正將生態(tài)打好才是立足之本。”

要在現如今的通用計算GPU市場有所發(fā)展,芯片做得再好,沒有龐大的生態(tài)都將難以生存。而且生態(tài)一直也是英偉達賴以生存與業(yè)績數年持續(xù)躥升的根源所在。英偉達當前所涉足的通用計算加速領域,每年GTC上新發(fā)布的加速庫、框架、軟件和應用,都足以讓競爭對手汗顏——甚至是一些細分、小眾的領域。

尤其是每年更新個什么庫,相同硬件的效率就提升1倍,有時都足以將DSA架構芯片的效率領先優(yōu)勢吃干抹凈。更不用談上層應用面向開發(fā)者時,易用性有時可以將競爭對手甩開幾條街。

壁仞科技作為一家剛剛發(fā)布第一顆芯片、成立才3年的新入局者,自然不大可能做到一蹴而就。我們此前采訪不少生態(tài)投入時間超過5年的AI芯片企業(yè),他們都對英偉達的生態(tài)建設水平感到無奈。這預計也將成為壁仞科技接下來很長一段時間內要投入大量人力物力的部分。

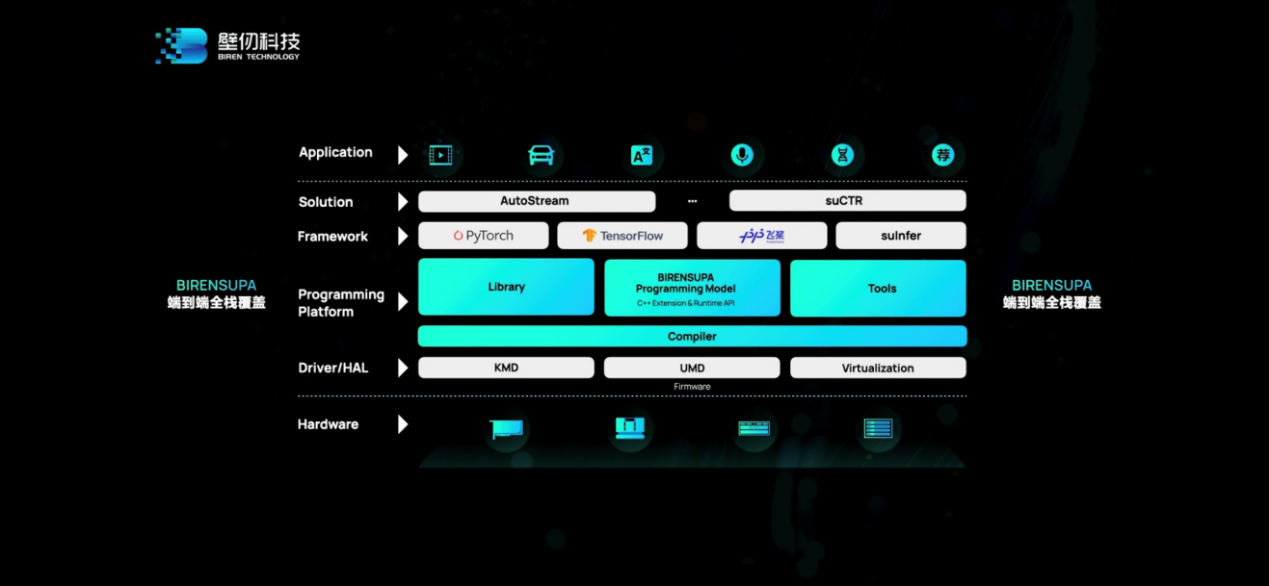

上面這張圖是壁仞的BIRENSUPA(以下簡稱SUPA)軟件全棧,從驅動、硬件抽象層、編程平臺、框架,到具體的解決方案和應用。除了相關壁仞GPU自身架構特性的一些接口(下文架構介紹中也會有涉及),這里比較值得一提的包括框架層支持PyTorch、TensorFlow,和已經在合作中的百度飛槳PaddlePaddle——百度也出現在發(fā)布會上,給出了“產品兼容性證明”;框架層有個壁仞自研的推理引擎suInfer。

上層的解決方案,現階段主要有兩個:AutoStream和suCTR。壁仞科技聯席CEO李新榮介紹說,AutoStream智能視頻分析引擎是基于GStreamer框架開發(fā)的軟件庫,用于端到端的智能分析。“它可以對圖像以及視頻的數據做前端和后端的處理,充分利用壁仞GPU的解碼能力和推理加速能力,高效地支持視頻分析應用。”未來還會有更多AutoStream的功能問世。

而suCTR是個廣告推薦訓練框架,“支持基于GPU架構的訓練框架,用在廣告推薦場景上;采用多級稀疏參數存儲架構,單機就可以支持TB級參數,并且可以通過多級擴展來支持更多的大規(guī)模參數;兼容TensorFlow,減少用戶開發(fā)的遷移成本。”

開發(fā)者比較關心的部分具體內容可見以下PPT;就一家剛剛發(fā)布芯片的企業(yè)而言,我們認為這樣的生態(tài)構建水平已經是比較優(yōu)秀的了:

另外作為生態(tài)建設的一環(huán),壁仞科技“開發(fā)者云”當前已經上線。壁仞也現場演示了開發(fā)者云的使用。“開發(fā)者云是基于壁仞suCloud機器學習平臺搭建的集成式開發(fā)環(huán)境,旨在為開發(fā)者提供可遠程訪問壁仞GPU資源的云端入口。”

生態(tài)建設前期,壁仞似乎和不少高校展開了合作,主要著力在和高校建立合作關系,從學術研究、人才培養(yǎng)和科研成果轉換上入手。從壁仞展示的視頻來看,目前涉及的合作方向包括醫(yī)療影像、分子動力學、電磁仿真等領域。雖然不清楚合作深度和成果產出如何,但這本身就是生態(tài)擴展、為未來打基礎的長遠方案。

“壁立仞”芯片架構

感覺能在發(fā)布會上從高抽象層級談技術的企業(yè),在國內還真是稀缺。壁仞在這次發(fā)布會上,花了比較多的篇幅著墨于自家GPU芯片的“壁立仞”架構。做大算力可不是堆晶體管就行的,這其中涉及到PPA權衡、內存功耗限制問題、兼容性等等。本文最后,我們就來談一談構成BR100/BR104芯片的壁立仞架構,有何獨特之處。

洪洲給出了壁立仞架構的6大特性:TF32+數據格式支持、TDA張量數據存取加速器、C-Warp協作開發(fā)模式、NME近存儲計算引擎、NUMA/UMA訪存機制、SVI安全虛擬實例。雖然聽起來其中的某些還是比較通用。

這是BR100邏輯框架圖,其上包含有計算單元、2D mesh片上網、HBM2e存儲系統(tǒng)、媒體引擎、連接主機的PCIe Gen 5接口、互連接口。

放大計算核部分,這是流處理器簇(SPC),采用標準化的模塊化設計,上面能跑4096并行線程。一個SPC內部包含有16個EU(執(zhí)行單元),每4個EU可配置成1個CU(計算單元)。一個BR100內部有32個這樣的SPC流媒體簇。

放大其中的EU。一個EU主要包含兩部分,一部分是“通用流式處理器(V-core)”。“我們采用了SIMT通用并行處理器”,BR100的“通用性主要就來自這個處理器,它支持各種各樣的指令,而且是完全并行的通用架構”。這部分應該也是能夠兼容CUDA的原因。

另一個部分就是tensor core。“我們的做法和業(yè)界不大一樣。我們的tensor核是完全集成在向量核里面的,作為向量核的加速器。”洪洲說,“其優(yōu)點在于,可以把16個tensor核連在一起,達成更大的tensor核,讓矩陣運算效率得到極大提高。我們算下來大概能提高30%。”

“矩陣運算是AI、HPC里面最重要的運算。所以這個設計至關重要。這樣的設計能提高能效比,讓數據重用性變得更好。”

“我覺得到底用通用架構還是DSA架構,這個爭論是沒有意義的。”洪洲談到,“BR100里面,這兩者都有了,既有通用性,也有很好的PPA。”

分布式共享L2 cache也是洪洲特別提到的創(chuàng)新點。“傳統(tǒng)GPU的L2 cache一般在芯片中間,或者芯片邊上,在memory controller旁邊。我們的設計是分布式緩存,和每個大的計算核在一起,也能夠共享,通過片上網將其連在一起。”“這樣的好處是,讓數據和計算單元挨得很近,與此同時又在芯片level做共享。”

基于以上信息,BR100芯片同時能跑128000個線程,總計8192個通用流式處理器、512個張量加速器,256MB分布式共享緩存。

BR100所用的片上網絡(NoC),為“網格式多播(multicast)片上互連”。“權重一般來說是可以共享多播的;當你跑模型并行,training sample也可以共享多播。這樣就能極大減少對內存的帶寬壓力,減少片上網link的帶寬壓力。”

IO方面值得一提的特性,除了PCIe Gen 5主機接口支持——128GB/s帶寬,并且支持CXL互連協議以外;BLink點對點全互連技術,在壁仞科技的版圖中應該也是很重要的——可類比于英偉達的NVLink。

“我們有8組BLink接口,其中7個接口可以連接另外7個GPU,最終將8個GPU有效連在一起。”洪洲說,“我們?yōu)槭裁匆匝羞@個接口?因為它能夠給我們更好的控制。通過這項技術,把8個GPU當成1個GPU來用,并且把數據多播、計算核之間同步都通過接口來實現。”

6大亮點中的第一個就是TF32+數據格式的支持。“兩年前,頭部廠商引入了TF32,這個格式能夠讓網絡比較容易收斂。但我們和客戶交流的時候發(fā)現,這還遠遠不夠。很多客戶在某些場景下,為了0.1%的精度提高,寧愿速度跑慢一點,或者加更多設備。”

“我們的TF32+,精度bit有15bit(E8M15),TF32就只有10bit。我們增加了5bit,相當于增加了32倍精度。”洪洲說,“即使這樣,我們的TF32+算力仍然是頭部廠家TF32的3.3倍。”所以最終達成了“更高的精度”和“更大的算力”。

架構層面的另一個亮點在于TDA(Tensor Data Accelerator)張量數據存取加速器。這個加速器用于offload計算單元(SPC)的數據存取工作。“它是個專門的加速器,像數據的加壓、解壓、地址計算、同步。它能讓計算和數據搬動做到異步。”

實際上,以下多項特性都著力于減少數據通訊產生的開銷——在AI計算時代,這個命題正被不斷放大。而“高算力”架構現在總是要花大量的精力在應對存儲墻的問題上。包括C-Warp協作并發(fā)、NME近存儲計算引擎、NUMA/UMA訪存機制:

比如C-Warp協作并發(fā)相比于傳統(tǒng)GPU的warp和warp之間不能直接通訊(需要經由cache來交換數據),“我們這種模式可以藉由一些同步方式,通過Register File來直接傳遞數據,也就減少了數據的搬移。”

而NME近存計算引擎應當和前面提到的分布式L2 cache也有關,“讓計算發(fā)生在數據呆著的地方。數據走到哪兒,計算就應該在哪兒發(fā)生。”這里的“reduction engine”大約是關竅所在。NUMA/UMA訪存機制也是考量不同數據特性,減少數據通訊的距離和次數。

洪洲說由于數據存取需要大量開銷,很多馮諾依曼體系架構的芯片,功耗真正花在“算”的部分就只有10%。“我們很驕傲地說,BR100測下來,大部分功耗都是花在了‘算‘上面。基于不同的場景,有些場景能到70%,有些60%,這已經非常好了。這是對計算模式的顛覆。”以上所有技術在此應當都是至關重要的。

虛擬化和安全相關的技術,對當代數據中心GPU而言自然也不能少。SVI安全虛擬實例特性的一個亮點,應該是支持1、2、4、8份實例的“物理切分”。“每個物理切分,memory、緩存、計算單元、片上網的link都是私有的,和旁邊在跑的東西完全隔離,相互不會有影響。”

另外還有國密1級安全標準支持等特性,以及性能方面BR100“即使切成8份,每份算力也有256TOPS(INT8),是現在主流推理卡的2倍性能”等。

這是個很好的起點

壁仞B(yǎng)R100/BR104芯片,以及軟件生態(tài)、OAM模組與PCIe板卡的發(fā)布還是相當振奮人心的。至少從這次的發(fā)布會來看,3年時間交出的答卷讓人滿意。無論是芯片算力水平、架構亮點、所用的制造和封裝技術,還是系統(tǒng)產品的能效、TCO。而且如前所述,壁礪104很快就要量產出貨了,海玄OAM服務器今年Q4也將開放邀測。

不過GPU通用計算和AI市場的競爭也實在不簡單,要在既有市場參與者占據統(tǒng)領地位的環(huán)境中占得一席之地,甚至“搶占生態(tài)話語權”都絕非短時間內可以達成。實際上,英偉達當前的優(yōu)勢,一方面來自xPU芯片和系統(tǒng)的覆蓋,不僅是GPU芯片和系統(tǒng),還體現在networking等領域的不斷開花結果。而老生常談的軟件生態(tài),更是全棧自下而上的覆蓋,以及持續(xù)不斷的行業(yè)橫向擴張。

無論如何壁仞B(yǎng)R100的發(fā)布都是個出色的開端,接下來等待壁仞科技的還會有更多的挑戰(zhàn)。產品落地和持續(xù)的生態(tài)建設會是所有人都將密切關注的。

更多信息可以來這里獲取==>>電子技術應用-AET<<