云提供商正在組建 GPU 大軍,以提供更多的 AI 火力。在今天舉行的年度 Google I/O 開發(fā)者大會(huì)上,Google 宣布了一款擁有 26,000 個(gè) GPU 的 AI 超級(jí)計(jì)算機(jī)——A3 ,這個(gè)超級(jí)計(jì)算機(jī)是谷歌與微軟爭(zhēng)奪 AI 霸權(quán)的斗爭(zhēng)中投入更多資源進(jìn)行積極反攻的又一證據(jù)。

這臺(tái)超級(jí)計(jì)算機(jī)擁有大約 26,000 個(gè) Nvidia H100 Hopper GPU。作為參考,世界上最快的公共超級(jí)計(jì)算機(jī)Frontier擁有 37,000 個(gè) AMD Instinct 250X GPU。

對(duì)于我們最大的客戶,我們可以在單個(gè)集群中構(gòu)建多達(dá) 26,000 個(gè) GPU 的 A3 超級(jí)計(jì)算機(jī),并正在努力在我們最大的地區(qū)構(gòu)建多個(gè)集群,”谷歌發(fā)言人在一封電子郵件中說,并補(bǔ)充說“并非我們所有的位置都將是縮放到這么大的尺寸。”

該系統(tǒng)是在加利福尼亞州山景城舉行的 Google I/O 大會(huì)上宣布的。開發(fā)者大會(huì)已經(jīng)成為谷歌許多人工智能軟件和硬件能力的展示。在微軟將 OpenAI 的技術(shù)應(yīng)用于 Bing 搜索和辦公生產(chǎn)力應(yīng)用程序之后,谷歌加速了其 AI 開發(fā)。

該超級(jí)計(jì)算機(jī)面向希望訓(xùn)練大型語(yǔ)言模型的客戶。谷歌為希望使用超級(jí)計(jì)算機(jī)的公司宣布了隨附的 A3 虛擬機(jī)實(shí)例。許多云提供商現(xiàn)在都在部署 H100 GPU,Nvidia 在 3 月份推出了自己的 DGX 云服務(wù),與租用上一代 A100 GPU 相比價(jià)格昂貴。

谷歌表示,A3 超級(jí)計(jì)算機(jī)是對(duì)現(xiàn)有 A2 虛擬機(jī)與 Nvidia A100 GPU 提供的計(jì)算資源的重大升級(jí)。谷歌正在將所有分布在不同地理位置的 A3 計(jì)算實(shí)例匯集到一臺(tái)超級(jí)計(jì)算機(jī)中。

“A3 超級(jí)計(jì)算機(jī)的規(guī)模可提供高達(dá) 26 exaflops 的 AI 性能,這大大減少了訓(xùn)練大型 ML 模型的時(shí)間和成本,”谷歌的董事 Roy Kim 和產(chǎn)品經(jīng)理 Chris Kleban 在一篇博客文章中說。

公司使用 exaflops 性能指標(biāo)來(lái)估計(jì) AI 計(jì)算機(jī)的原始性能,但批評(píng)者仍然對(duì)其持保留意見。在谷歌的案例中,被大家詬病的是其結(jié)果在以 ML 為目標(biāo)的 bfloat16(“brain floating point”)性能中計(jì)算出來(lái)的,這讓你達(dá)到“exaflops”的速度比大多數(shù)經(jīng)典 HPC 應(yīng)用程序仍然使用的雙精度 (FP64) 浮點(diǎn)數(shù)學(xué)要快得多要求。

GPU 的數(shù)量已經(jīng)成為云提供商推廣其 AI 計(jì)算服務(wù)的重要名片。微軟在 Azure 中的 AI 超級(jí)計(jì)算機(jī)與 OpenAI 合作構(gòu)建,擁有 285,000 個(gè) CPU 內(nèi)核和 10,000 個(gè) GPU。微軟還宣布了配備更多 GPU 的下一代 AI 超級(jí)計(jì)算機(jī)。Oracle 的云服務(wù)提供對(duì) 512 個(gè) GPU 集群的訪問,并且正在研究新技術(shù)以提高 GPU 通信的速度。

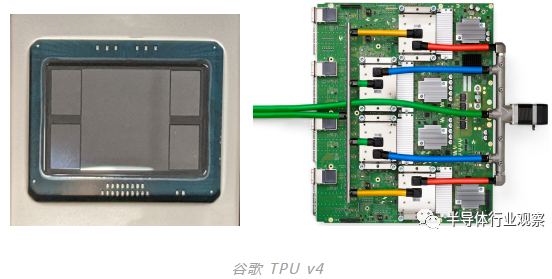

谷歌一直在大肆宣傳其TPU v4 人工智能芯片,這些芯片被用于運(yùn)行帶有 LLM 的內(nèi)部人工智能應(yīng)用程序,例如谷歌的 Bard 產(chǎn)品。谷歌的 AI 子公司 DeepMind 表示,快速 TPU 正在指導(dǎo)通用和科學(xué)應(yīng)用的 AI 開發(fā)。

相比之下,谷歌的 A3 超級(jí)計(jì)算機(jī)用途廣泛,可以針對(duì)廣泛的 AI 應(yīng)用程序和 LLM 進(jìn)行調(diào)整。Kim 和 Kleban 在博文中表示:“鑒于這些工作負(fù)載的高要求,一刀切的方法是不夠的——你需要專為 AI 構(gòu)建的基礎(chǔ)設(shè)施。”

就像谷歌喜歡它的 TPU 一樣,Nvidia 的 GPU 已經(jīng)成為云提供商的必需品,因?yàn)榭蛻粽?CUDA 中編寫 AI 應(yīng)用程序,這是 Nvidia 專有的并行編程模型。該軟件工具包基于 H100 的專用 AI 和圖形內(nèi)核提供的加速生成最快的結(jié)果。

客戶可以通過 A3 虛擬機(jī)運(yùn)行 AI 應(yīng)用程序,并通過 Vertex AI、Google Kubernetes Engine 和 Google Compute Engine 服務(wù)使用 Google 的 AI 開發(fā)和管理服務(wù)。公司可以使用 A3 超級(jí)計(jì)算機(jī)上的 GPU 作為一次性租用,結(jié)合大型語(yǔ)言模型來(lái)訓(xùn)練大型模型。然后,將新數(shù)據(jù)輸入模型,更新模型——無(wú)需從頭開始重新訓(xùn)練。

谷歌的 A3 超級(jí)計(jì)算機(jī)是各種技術(shù)的大雜燴,以提高 GPU 到 GPU 的通信和網(wǎng)絡(luò)性能。A3 虛擬機(jī)基于英特爾第四代 Xeon 芯片(代號(hào) Sapphire Rapids),與 H100 GPU 一起提供。目前尚不清楚 VM 中的虛擬 CPU 是否會(huì)支持 Sapphire Rapids 芯片中內(nèi)置的推理加速器。VM 隨附 DDR5 內(nèi)存。

Nvidia H100 上的訓(xùn)練模型比在云端廣泛使用的上一代 A100 GPU 更快、更便宜。人工智能服務(wù)公司 MosaicML 進(jìn)行的一項(xiàng)研究發(fā)現(xiàn),H100 在其 70 億參數(shù)的 MosaicGPT 大型語(yǔ)言模型上“比 NVIDIA A100 的成本效益高 30%,速度快 3 倍”。

H100 也可以進(jìn)行推理,但考慮到 H100 提供的處理能力,這可能被認(rèn)為是矯枉過正。谷歌云提供 Nvidia 的 L4 GPU 用于推理,英特爾在其 Sapphire Rapids CPU 中擁有推理加速器。

“A3 VM 也非常適合推理工作負(fù)載,與我們的 A2 VM 的 A100 GPU 相比,推理性能提升高達(dá) 30 倍,”Google 的 Kim 和 Kleban 說。

A3 虛擬機(jī)是第一個(gè)通過名為 Mount Evans 的基礎(chǔ)設(shè)施處理單元連接 GPU 實(shí)例的虛擬機(jī),該單元由谷歌和英特爾聯(lián)合開發(fā)。IPU 允許 A3 虛擬機(jī)卸載網(wǎng)絡(luò)、存儲(chǔ)管理和安全功能,這些功能傳統(tǒng)上是在虛擬 CPU 上完成的。IPU 允許以 200Gbps 的速度傳輸數(shù)據(jù)。

“A3 是第一個(gè)使用我們定制設(shè)計(jì)的 200Gbps IPU 的 GPU 實(shí)例,GPU 到 GPU 的數(shù)據(jù)傳輸繞過 CPU 主機(jī)并流經(jīng)與其他 VM 網(wǎng)絡(luò)和數(shù)據(jù)流量不同的接口。與我們的 A2 虛擬機(jī)相比,這使網(wǎng)絡(luò)帶寬增加了 10 倍,具有低尾延遲和高帶寬穩(wěn)定性,”谷歌高管在一篇博客文章中說。

IPU 的吞吐量可能很快就會(huì)受到微軟的挑戰(zhàn),微軟即將推出的配備 Nvidia H100 GPU 的 AI 超級(jí)計(jì)算機(jī)將擁有該芯片制造商的 Quantum-2 400Gbps 網(wǎng)絡(luò)功能。微軟尚未透露其下一代 AI 超級(jí)計(jì)算機(jī)中 H100 GPU 的數(shù)量。

A3 超級(jí)計(jì)算機(jī)建立在源自公司 Jupiter 數(shù)據(jù)中心網(wǎng)絡(luò)結(jié)構(gòu)的主干上,該主干通過光學(xué)鏈路連接地理上不同的 GPU 集群。

“對(duì)于幾乎每一種工作負(fù)載結(jié)構(gòu),我們都實(shí)現(xiàn)了與更昂貴的現(xiàn)成非阻塞網(wǎng)絡(luò)結(jié)構(gòu)無(wú)法區(qū)分的工作負(fù)載帶寬,”谷歌表示。

谷歌還分享說,A3 超級(jí)計(jì)算機(jī)將有八個(gè) H100 GPU,它們使用 Nvidia 專有的交換和芯片互連技術(shù)互連。GPU 將通過 NVSwitch 和 NVLink 互連連接,其通信速度約為 3.6TBps。Azure 在其 AI 超級(jí)計(jì)算機(jī)上提供了相同的速度,并且兩家公司都部署了 Nvidia 的電路板設(shè)計(jì)。

“每臺(tái)服務(wù)器都使用服務(wù)器內(nèi)部的 NVLink 和 NVSwitch 將 8 個(gè) GPU 互連在一起。為了讓 GPU 服務(wù)器相互通信,我們?cè)?Jupiter DC 網(wǎng)絡(luò)結(jié)構(gòu)上使用了多個(gè) IPU,”一位谷歌發(fā)言人說。

該設(shè)置有點(diǎn)類似于 Nvidia 的 DGX Superpod,它具有 127 個(gè)節(jié)點(diǎn)的設(shè)置,每個(gè) DGX 節(jié)點(diǎn)配備八個(gè) H100 GPU。

谷歌博客:配備 NVIDIA H100 GPU 的 A3 超級(jí)計(jì)算機(jī)

實(shí)施最先進(jìn)的人工智能 (AI) 和機(jī)器學(xué)習(xí) (ML) 模型需要大量計(jì)算,既要訓(xùn)練基礎(chǔ)模型,又要在這些模型經(jīng)過訓(xùn)練后為它們提供服務(wù)。考慮到這些工作負(fù)載的需求,一種放之四海而皆準(zhǔn)的方法是不夠的——您需要專為 AI 構(gòu)建的基礎(chǔ)設(shè)施。

我們與我們的合作伙伴一起,為 ML 用例提供廣泛的計(jì)算選項(xiàng),例如大型語(yǔ)言模型 (LLM)、生成 AI 和擴(kuò)散模型。最近,我們發(fā)布了 G2 VMs,成為第一個(gè)提供新的 NVIDIA L4 Tensor Core GPU 用于服務(wù)生成式 AI 工作負(fù)載的云。今天,我們通過推出下一代 A3 GPU 超級(jí)計(jì)算機(jī)的私人預(yù)覽版來(lái)擴(kuò)展該產(chǎn)品組合。Google Cloud 現(xiàn)在提供一整套 GPU 選項(xiàng),用于訓(xùn)練和推理 ML 模型。

Google Compute Engine A3 超級(jí)計(jì)算機(jī)專為訓(xùn)練和服務(wù)要求最嚴(yán)苛的 AI 模型而打造,這些模型為當(dāng)今的生成式 AI 和大型語(yǔ)言模型創(chuàng)新提供動(dòng)力。我們的 A3 VM 結(jié)合了 NVIDIA H100 Tensor Core GPU 和 Google 領(lǐng)先的網(wǎng)絡(luò)技術(shù),可為各種規(guī)模的客戶提供服務(wù):

1. A3 是第一個(gè)使用我們定制設(shè)計(jì)的 200 Gbps IPU的 GPU 實(shí)例,GPU 到 GPU 的數(shù)據(jù)傳輸繞過 CPU 主機(jī)并流過與其他 VM 網(wǎng)絡(luò)和數(shù)據(jù)流量不同的接口。與我們的 A2 VM 相比,這可實(shí)現(xiàn)高達(dá) 10 倍的網(wǎng)絡(luò)帶寬,同時(shí)具有低尾延遲和高帶寬穩(wěn)定性。

2. 我們行業(yè)獨(dú)一無(wú)二的智能 Jupiter 數(shù)據(jù)中心網(wǎng)絡(luò)結(jié)構(gòu)可擴(kuò)展到數(shù)萬(wàn)個(gè)高度互連的 GPU,并允許全帶寬可重新配置的光學(xué)鏈路,可以按需調(diào)整拓?fù)洹?duì)于幾乎每種工作負(fù)載結(jié)構(gòu),我們實(shí)現(xiàn)的工作負(fù)載帶寬與更昂貴的現(xiàn)成非阻塞網(wǎng)絡(luò)結(jié)構(gòu)沒有區(qū)別,從而降低了 TCO。

3. A3 超級(jí)計(jì)算機(jī)的規(guī)模提供高達(dá) 26 exaFlops 的 AI 性能,這大大減少了訓(xùn)練大型 ML 模型的時(shí)間和成本。

隨著公司從訓(xùn)練過渡到提供 ML 模型,A3 VM 也非常適合推理工作負(fù)載,與我們由 NVIDIA A100 Tensor Core GPU* 提供支持的 A2 VM 相比,推理性能提升高達(dá) 30 倍。

A3 GPU VM 專門為當(dāng)今的 ML 工作負(fù)載提供最高性能的訓(xùn)練,配備現(xiàn)代 CPU、改進(jìn)的主機(jī)內(nèi)存、下一代 NVIDIA GPU 和主要網(wǎng)絡(luò)升級(jí)。以下是 A3 的主要特點(diǎn):

1. 8 個(gè) H100 GPU,利用 NVIDIA 的 Hopper 架構(gòu),提供 3 倍的計(jì)算吞吐量

2. 通過 NVIDIA NVSwitch 和 NVLink 4.0,A3 的 8 個(gè) GPU 之間的對(duì)分帶寬為 3.6 TB/s

3. 下一代第 4 代英特爾至強(qiáng)可擴(kuò)展處理器

4. 2TB 主機(jī)內(nèi)存,通過 4800 MHz DDR5 DIMM

5. 由我們支持硬件的 IPU、專門的服務(wù)器間 GPU 通信堆棧和 NCCL 優(yōu)化提供支持的網(wǎng)絡(luò)帶寬增加 10 倍

A3 GPU VM 是客戶開發(fā)最先進(jìn)的 ML 模型的一個(gè)進(jìn)步。通過顯著加快 ML 模型的訓(xùn)練和推理,A3 VM 使企業(yè)能夠快速訓(xùn)練更復(fù)雜的 ML 模型,為我們的客戶創(chuàng)造機(jī)會(huì)來(lái)構(gòu)建大型語(yǔ)言模型 (LLM)、生成 AI 和擴(kuò)散模型,以幫助優(yōu)化運(yùn)營(yíng)并在競(jìng)爭(zhēng)中保持領(lǐng)先地位。

此次發(fā)布基于我們與 NVIDIA 的合作伙伴關(guān)系,旨在為我們的客戶提供用于訓(xùn)練和推理 ML 模型的全方位 GPU 選項(xiàng)。

NVIDIA 超大規(guī)模和高性能計(jì)算副總裁 Ian Buck 表示:“由下一代 NVIDIA H100 GPU 提供支持的 Google Cloud 的 A3 VM 將加速生成 AI 應(yīng)用程序的訓(xùn)練和服務(wù)。” “在谷歌云最近推出 G2 實(shí)例之后,我們很自豪能夠繼續(xù)與谷歌云合作,通過專門構(gòu)建的人工智能基礎(chǔ)設(shè)施幫助全球企業(yè)轉(zhuǎn)型。”

對(duì)于希望在無(wú)需維護(hù)的情況下開發(fā)復(fù)雜 ML 模型的客戶,您可以在 Vertex AI 上部署 A3 VM,Vertex AI 是一個(gè)端到端平臺(tái),用于在專為低延遲服務(wù)和高性能而構(gòu)建的完全托管基礎(chǔ)設(shè)施上構(gòu)建 ML 模型訓(xùn)練。今天,在Google I/O 2023上,我們很高興通過向更多客戶開放 Vertex AI 中的生成 AI 支持以及引入新功能和基礎(chǔ)模型來(lái)構(gòu)建這些產(chǎn)品。

對(duì)于希望構(gòu)建自己的自定義軟件堆棧的客戶,客戶還可以在 Google Kubernetes Engine (GKE) 和 Compute Engine 上部署 A3 VM,以便您可以訓(xùn)練和提供最新的基礎(chǔ)模型,同時(shí)享受自動(dòng)縮放、工作負(fù)載編排和自動(dòng)升級(jí)。

“Google Cloud 的 A3 VM 實(shí)例為我們提供了計(jì)算能力和規(guī)模,可滿足我們最苛刻的訓(xùn)練和推理工作負(fù)載。我們期待利用他們?cè)?AI 領(lǐng)域的專業(yè)知識(shí)和在大規(guī)模基礎(chǔ)設(shè)施方面的領(lǐng)導(dǎo)地位,為我們的 ML 工作負(fù)載提供強(qiáng)大的平臺(tái)。” -Noam Shazeer,Character.AI 首席執(zhí)行官

在谷歌云,人工智能是我們的 DNA。我們應(yīng)用了數(shù)十年為 AI 運(yùn)行全球規(guī)模計(jì)算的經(jīng)驗(yàn)。我們?cè)O(shè)計(jì)了該基礎(chǔ)架構(gòu)以擴(kuò)展和優(yōu)化以運(yùn)行各種 AI 工作負(fù)載——現(xiàn)在,我們將其提供給您。

更多精彩內(nèi)容歡迎點(diǎn)擊==>>電子技術(shù)應(yīng)用-AET<<