Meta 公司當(dāng)?shù)貢r(shí)間 12 日通過官方新聞稿公布了兩座新的數(shù)據(jù)中心集群,該公司正希望通過英偉達(dá)的 GPU,在以 AI 為重點(diǎn)的開發(fā)中脫穎而出。

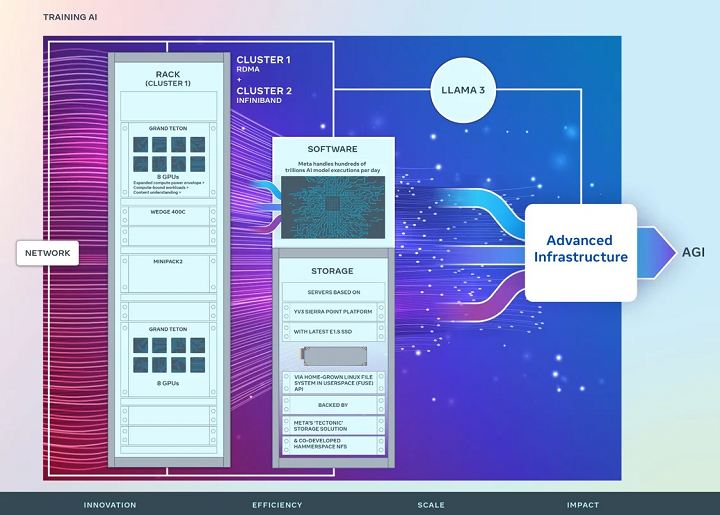

據(jù)悉,這兩座數(shù)據(jù)中心的唯一目的,是在消費(fèi)者特定應(yīng)用領(lǐng)域(注:包含聲音或圖像識(shí)別)中進(jìn)行 AI 研究和大語言模型的開發(fā),每個(gè)集群都包含了 24576 塊英偉達(dá) H100 AI GPU,將用于自家大語言模型 Llama 3 的訓(xùn)練。

兩座新建的數(shù)據(jù)中心集群都具有 400Gbps 互聯(lián)功能,其中一個(gè)集群采用了 Meta 基于 Arista 7800 自主開發(fā)的 Fabric 解決方案,而另一個(gè)集群則采用了英偉達(dá)的 Quantum2 InfiniBand Fabric,以確保無縫互連體驗(yàn)。

此外,集群基于 Meta 自家的開放式 GPU Grand Teton AI 平臺(tái),可通過提高主機(jī)到 GPU 的帶寬和計(jì)算能力,充分利用現(xiàn)代加速器的功能。

Meta 官方表示,這些集群的高性能網(wǎng)絡(luò)結(jié)構(gòu)的效率及關(guān)鍵存儲(chǔ)決策、配合每個(gè)集群中的 H100 GPU,能夠?yàn)楦蟆⒏鼜?fù)雜的模型提供支持,為通用人工智能產(chǎn)品開發(fā)、AI 研究的進(jìn)步鋪路。

據(jù)IT之家1 月報(bào)道,Meta 首席執(zhí)行官扎克伯格宣布公司正在建設(shè)龐大的基礎(chǔ)設(shè)施。“預(yù)估到今年年底,我們將擁有大約 35 萬片英偉達(dá) H100 加速卡,如果算上其它 GPU 的話,其計(jì)算能力相當(dāng)于 60 萬片 H100。”