牢牢掌握算力分配權(quán)的英偉達(dá)是人工智能領(lǐng)域當(dāng)仁不讓的“炸子雞”。

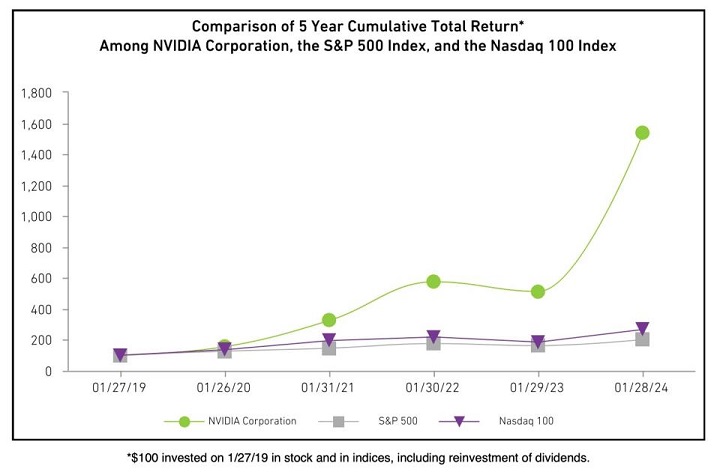

通過(guò)為包括OpenAI、Meta等人工智能企業(yè)提供包括H200、H100、A100等不同規(guī)格的GPU,英偉達(dá)一躍成為全球市值增速最快的企業(yè)之一,也因此被外界稱之為人工智能時(shí)代的”賣水人“。以至于黃仁勛和他的財(cái)務(wù)團(tuán)隊(duì),會(huì)在財(cái)報(bào)中,通過(guò)直觀的圖表來(lái)說(shuō)明英偉達(dá)對(duì)于業(yè)績(jī)的自信。

在向SEC提交的文件中,英偉達(dá)表示,2019年1月27日投資100美元(我們)的股票,2024年1月28日價(jià)值達(dá)到1536.28美元。而對(duì)應(yīng)投資100美元標(biāo)準(zhǔn)普爾500指數(shù)和納斯達(dá)克100指數(shù)基金,價(jià)值均在200美元以下。

今年的GTC2024上,黃仁勛的AI“核武庫(kù)”正式上新,B200將成為科技巨頭們追逐的“算力明星”——它不僅會(huì)成為新的AI算力底座,也將成為英偉達(dá)市值繼續(xù)攀升的業(yè)績(jī)底座。

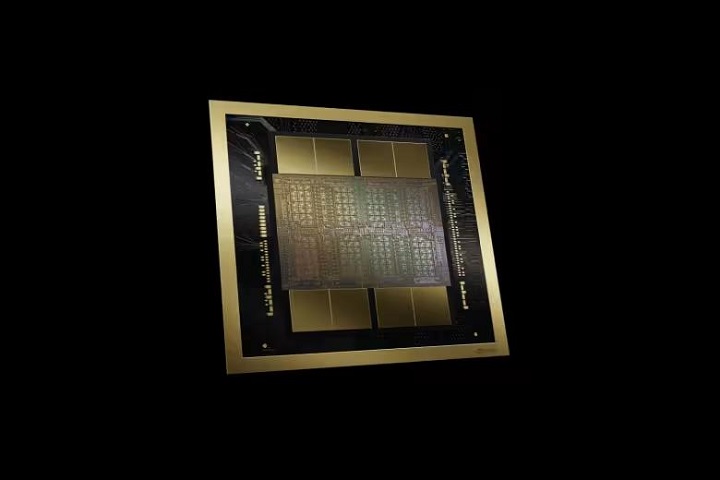

作為NVIDIA Blackwell架構(gòu)首款新產(chǎn)品,B200采用雙芯片設(shè)計(jì),晶體管數(shù)量達(dá)到2080億個(gè),基于Blackwell架構(gòu)的B100,英偉達(dá)還提供了包括GB200、DGX GB200 NVL 72,以及基于GB200和B200打造的DGX SuperPOD超算平臺(tái)。

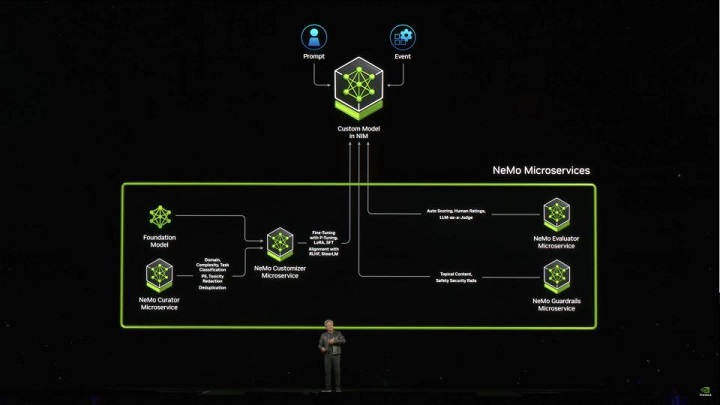

軟件服務(wù)方面,英偉達(dá)發(fā)布了集成AI開發(fā)軟件微服務(wù)系統(tǒng)NIM,通過(guò)直接提供多行業(yè)、多模態(tài)的專有模型,以及基于NeMo Retriver的專有數(shù)據(jù)注入系統(tǒng),企業(yè)可借由NIM快捷部署公司級(jí)專有模型。

除了通過(guò)軟硬件賦能AI技術(shù)之外,英偉達(dá)也推出了加速AI仿生機(jī)器人落地的解決方案——GR00T機(jī)器人項(xiàng)目——世界首款人形機(jī)器人模型,支持通過(guò)語(yǔ)言、視頻和人類演示,為機(jī)器人的生成行動(dòng)指令。

以下為核心要點(diǎn):

● B200芯片:采用雙芯片設(shè)計(jì),晶體管數(shù)量達(dá)到2080億個(gè)。單GPU AI性能達(dá)20 PFLOPS(即每秒2萬(wàn)萬(wàn)億次)。內(nèi)存192GB,基于第五代NVLink,帶寬達(dá)到8TB/s。

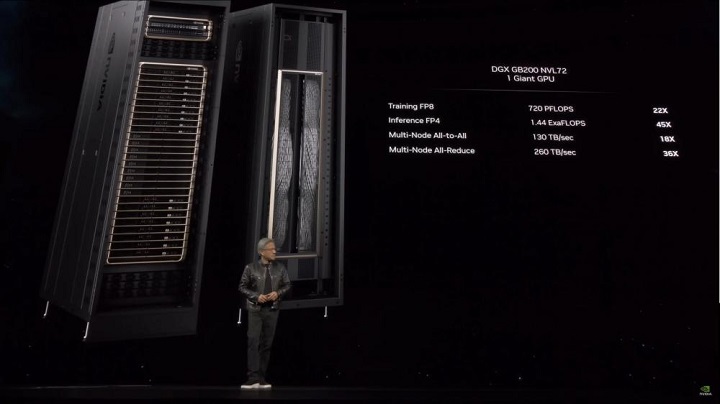

● DGX GB200 NVL 72:內(nèi)置36顆GRACE CPU和72顆Blackwell架構(gòu)GPU,AI訓(xùn)練性能可達(dá)720PFLOPs(即每秒72萬(wàn)萬(wàn)億次),推理性能為1440PFLOPs(每秒144萬(wàn)萬(wàn)億次)。

● 基于GB200的DGX SuperPOD超算:搭載8顆DGX GB200,即288顆Grace CPU和576顆B200 GPU,內(nèi)存達(dá)到240TB,F(xiàn)P4精度計(jì)算性能達(dá)到11.5EFLOPs(每秒11.5百億億次)

● Project GR00T:人型機(jī)器人項(xiàng)目——包含了人型機(jī)器人基礎(chǔ)模型,ISAAC Lab開發(fā)工具庫(kù)和Jetson Thor SoC片上系統(tǒng)開發(fā)硬件,帶寬達(dá)到100GB/s,AI計(jì)算性能達(dá)到800TFLOPs。

● NIM軟件:針對(duì)AI推理系統(tǒng)的新軟件,開發(fā)人員可以在其中直接選擇模型來(lái)構(gòu)建利用自己數(shù)據(jù)的人工智能應(yīng)用程序。

01 算力核彈B200

英偉達(dá)最近幾代架構(gòu),在名稱上都有致敬科學(xué)家的慣例。

上一代產(chǎn)品Hopper架構(gòu)則是致敬格蕾絲·霍珀,這一代架構(gòu)Blackwel則是致敬的是統(tǒng)計(jì)學(xué)家兼數(shù)學(xué)家大衛(wèi)·布萊克韋威爾。

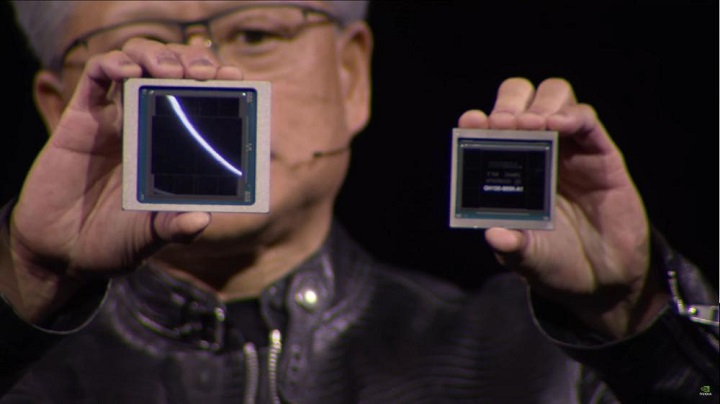

黃仁勛展示Blackwell和Hopper架構(gòu)GPU對(duì)比,左邊為Blackwell架構(gòu)的B200芯片

在新一代的GPU正式亮相之前,關(guān)于架構(gòu)、雙芯片設(shè)計(jì)等已經(jīng)有不少傳聞,關(guān)注點(diǎn)在于,黃仁勛會(huì)把手中的“AI核彈”性能提升到多少?

現(xiàn)在,官方的答案給出來(lái)了——基于Blackwell架構(gòu)的B200采用雙芯片設(shè)計(jì),基于臺(tái)積電4nm工藝,晶體管數(shù)量達(dá)到2080億個(gè),上一代Hopper架構(gòu)的H100同樣是4nm工藝,但由于沒(méi)有上雙芯片設(shè)計(jì),晶體管數(shù)量只有800億。

B200搭配8顆HBM3e內(nèi)存(比Hopper架構(gòu)的H200多了2顆),內(nèi)存達(dá)到192GB,基于第五代NVLink,帶寬達(dá)到8TB/s,相比Hopper架構(gòu)和Ampere架構(gòu),有了巨幅提升,最大可支持10萬(wàn)億參數(shù)的模型的訓(xùn)練。

作為對(duì)比,OpenAI 的 GPT-3 由 1750 億個(gè)參數(shù)組成,GPT-4參數(shù)為1.8億。

黃仁勛還介紹稱,B200平臺(tái)可以向下兼容,支持與上一代Hopper架構(gòu)的H100/H200 HGX系統(tǒng)硬件適配。

此前,被稱之為OpenAI勁敵的Inflection AI,官宣建立了一套22000顆英偉達(dá)H100 GPU的世界最大人工智能數(shù)據(jù)中心集群,接下來(lái)要看看OpenAI,能不能借助B200反超了。

這里再插一句英偉達(dá)的NVLink和NVLink Switch技術(shù)。

其中NVLink是英偉達(dá)開發(fā)的CPU和GPU之間高速互聯(lián)通道,在內(nèi)存墻無(wú)法突破的情況下,最大化提升CPU和GPU之間通信的效率,于2016年在基于Pascal架構(gòu)的GP100芯片和P100運(yùn)算卡上率先采用,當(dāng)時(shí)的帶寬為160GB/s,到H100采用的第四代NVLink,其帶寬已經(jīng)達(dá)到900GB/s,而B200采用的第五代NVLink 帶寬已經(jīng)突破1.8TB/s。

NVLink Switch支持與多個(gè)NVLink連接,實(shí)現(xiàn)NVLink在單節(jié)點(diǎn)、節(jié)點(diǎn)之間互聯(lián),進(jìn)而創(chuàng)建更高帶寬的GPU集群,基于最新的NVLink Switch芯片(臺(tái)積電4nm工藝,500億個(gè)晶體管),可實(shí)現(xiàn)576顆GPU組成計(jì)算集群,上一代產(chǎn)品僅支持到256個(gè)GPU。

根據(jù)官方公布的數(shù)據(jù),B200支持第二代Transformer引擎,Tensor核支持FP4、FP6精度計(jì)算,單顆B200 GPU的AI性能達(dá)20 PFLOPs(即每秒2億億次)。

另外,英偉達(dá)還在主題演講中展示了全新的加速計(jì)算平臺(tái)DGX GB200 NVL 72,擁有9個(gè)機(jī)架,總共搭載18個(gè)GB200加速卡,即36顆GRACE CPU和72顆Blackwell架構(gòu)GPU(英偉達(dá)也提供了DGX B200版本,簡(jiǎn)單來(lái)說(shuō)就是用Intel的Xeon CPU,替換了Grace CPU)。

黃仁勛說(shuō),一套DGX版GB200 NVL 72總共內(nèi)置了5000條NVLink銅制線纜,總長(zhǎng)度達(dá)到2公里,可以減少20kW的計(jì)算能耗。

舉個(gè)例子,8000個(gè)GPU組成的GH100系統(tǒng),90天內(nèi)可以訓(xùn)練一個(gè)1.8萬(wàn)億參數(shù)的GPT-Moe模型,功耗15兆瓦,而使用一套2000顆GPU的GB200 NVL72加速卡,只需要4兆瓦。

據(jù)介紹,DGX版GB200NVL 72加速計(jì)算平臺(tái)AI訓(xùn)練性能(FP8精度計(jì)算)可達(dá)720PFLOPs(即每秒72億億次),F(xiàn)P4精度推理性能為1440PFLOPs(每秒144億億次)。官方稱GB200的推理性能在Hopper平臺(tái)的基礎(chǔ)上提升6倍,尤其是采用相同數(shù)量的GPU,在萬(wàn)億參數(shù)Moe模型上進(jìn)行基準(zhǔn)測(cè)試,GB200的性能是Hopper平臺(tái)的30倍。

演講環(huán)節(jié),黃仁勛還公布了搭載64個(gè)800Gb/s端口、且配備RoCE自適應(yīng)路由的NVIDIA Quantum-X800 InfiniBand 交換機(jī),以及搭載144個(gè)800Gb/s端口,網(wǎng)絡(luò)內(nèi)計(jì)算性能達(dá)到14.4TFLOPs(每秒14.4萬(wàn)億次)的Spectrum-X800交換機(jī)。兩者應(yīng)對(duì)的客戶需求群體略有差異,如果追求超大規(guī)模、高性能可采用NVLink+InfiniBand網(wǎng)絡(luò);如果是多租戶、工作負(fù)載多樣性,需融入生成式AI,則用高性能Spectrum-X以太網(wǎng)架構(gòu)。

另外,英偉達(dá)還推出了基于GB200的DGX Super Pod一站式AI超算解決方案,采用高效液冷機(jī)架,搭載8套DGX GB200系統(tǒng),即288顆Grace CPU和576顆B200 GPU,內(nèi)存達(dá)到240TB,F(xiàn)P4精度計(jì)算性能達(dá)到11.5ELOPs(每秒11.5百億億次),相比上一代產(chǎn)品的推理性能提升30倍,訓(xùn)練性能提升4倍。

黃仁勛說(shuō),如果你想獲得更多的性能,也不是不可以——發(fā)揮鈔能力——在DGX Super Pod中整合更多的機(jī)架,搭載更多的DGX GB200加速卡。

02 NIM+NeMo:構(gòu)建英偉達(dá)版企業(yè)用GPTs

英偉達(dá)的另一個(gè)殺手锏就是它的軟件,它構(gòu)成了這一萬(wàn)億帝國(guó)至少半條護(hù)城河。

誕生于2006年的CUDA被認(rèn)為是英偉達(dá)在GPU上建立霸權(quán)的關(guān)鍵功臣——它使得GPU從調(diào)用 GPU計(jì)算和GPU硬件加速第一次成為可能,讓 GPU 擁有了解決復(fù)雜計(jì)算問(wèn)題的能力。在它的加持下,GPU從圖形處理器這一單一功能發(fā)展成了通用的并行算力設(shè)備,也因此AI的開發(fā)才有可能。

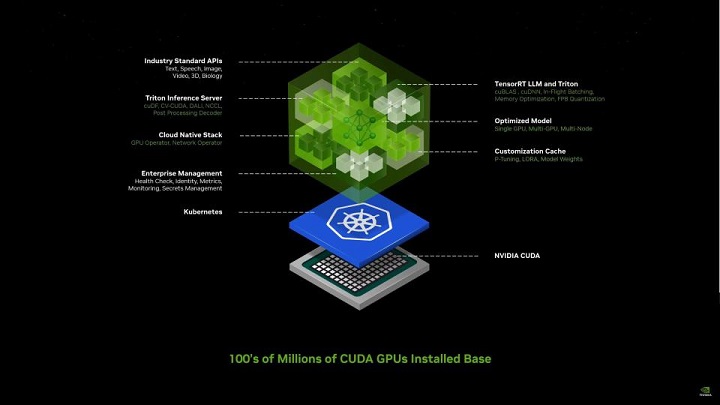

但談?wù)?nbsp;NVIDIA時(shí),許多人都傾向于使用“CUDA”作為 NVIDIA提供的所有軟件的簡(jiǎn)寫。這是一種誤導(dǎo),因?yàn)?nbsp;NVIDIA的軟件護(hù)城河不僅僅是 CUDA 開發(fā)層,還包含了其上的一系列連通軟硬件的軟件程序,比如英偉達(dá)開發(fā)的用于運(yùn)行C++推理框架,去兼容Pytorch等模型訓(xùn)練框架的TensorRT;使團(tuán)隊(duì)能夠部署來(lái)自多個(gè)深度學(xué)習(xí)和機(jī)器學(xué)習(xí)框架的任何 AI 模型的 Triton Inference Server。

雖然有如此豐富的軟件生態(tài),但對(duì)于缺乏AI基礎(chǔ)開發(fā)能力的傳統(tǒng)行業(yè)來(lái)講,這些分散的系統(tǒng)還是太難掌握。

看準(zhǔn)了這個(gè)給傳統(tǒng)企業(yè)賦能的賽道,在今天的發(fā)布會(huì)上,英偉達(dá)推出了集成過(guò)去幾年所做的所有軟件于一起的新的容器型微服務(wù):NVIDIA NIM。它集成到了不給中間商活路的地步,可以讓傳統(tǒng)企業(yè)直接簡(jiǎn)單部署完全利用自己數(shù)據(jù)的專屬行業(yè)模型。

這一軟件提供了一個(gè)從最淺層的應(yīng)用軟件到最深層的硬件編程體系CUDA的直接通路。構(gòu)成 GenAI 應(yīng)用程序的各種組件(模型、RAG、數(shù)據(jù)等)都可以完成直達(dá)NVIDIA GPU的全鏈路優(yōu)化。

它讓缺乏AI開發(fā)經(jīng)驗(yàn)的傳統(tǒng)行業(yè)可以通過(guò)在 NVIDIA 的安裝基礎(chǔ)上運(yùn)行的經(jīng)過(guò)打包和優(yōu)化的預(yù)訓(xùn)練模型,一步到位部署AI應(yīng)用,直接享受到英偉達(dá)GPU帶來(lái)的最優(yōu)部署時(shí)效,繞過(guò)AI開發(fā)公司或者模型公司部署調(diào)優(yōu)的成本。Nvidia 企業(yè)計(jì)算副總裁 Manuvir Das表示,不久前,需要數(shù)據(jù)科學(xué)家來(lái)構(gòu)建和部署這些類型的 GenAI 應(yīng)用程序。但有了 NIM,任何開發(fā)人員現(xiàn)在都可以構(gòu)建聊天機(jī)器人之類的東西并將其部署給客戶。

這一切都建立在Kubernetes這一容器化應(yīng)用程序之上。NVIDIA通過(guò)Kubernetes創(chuàng)建了一個(gè)單一的架構(gòu),可以運(yùn)行所有這些軟件。Nim作為預(yù)構(gòu)建的容器(containers),開發(fā)人員可以在其中直接選擇模型來(lái)構(gòu)建利用自己數(shù)據(jù)的人工智能應(yīng)用程序。在容器中配備了適用于語(yǔ)言和藥物發(fā)現(xiàn)等人工智能領(lǐng)域的行業(yè)標(biāo)準(zhǔn)應(yīng)用程序編程接口以適應(yīng)各類專有模型。

英偉達(dá)在博客文章中表示:“NIM 針對(duì)每個(gè)模型和硬件設(shè)置利用優(yōu)化的推理引擎,在加速基礎(chǔ)設(shè)施上提供最佳的延遲和吞吐量。” “除了支持優(yōu)化的社區(qū)模型之外,開發(fā)人員還可以通過(guò)使用永遠(yuǎn)不會(huì)離開數(shù)據(jù)中心邊界的專有數(shù)據(jù)源來(lái)調(diào)整和微調(diào)模型,從而獲得更高的準(zhǔn)確性和性能。”

在模型支持方面,NIM 微服務(wù)的可選項(xiàng)也很多。它支持 Nvidia 自己的模型合作庫(kù),來(lái)自 AI21 Labs,Cohere等合作伙伴的模型,以及來(lái)自Meta、Hugging Face、Stability AI 和Google的開源模型。同時(shí)客戶可以通過(guò) Nvidia AI Enterprise 平臺(tái)以及 Microsoft Azure AI、Google Cloud Vertex AI、Google Kubernetes Engine 和 Amazon SageMaker 訪問(wèn) NIM 微服務(wù),并與包括 LangChain、LlamaIndex 和 Deepset 在內(nèi)的 AI 框架集成。這基本上就等于對(duì)所有市面上主流模型都完成了覆蓋。

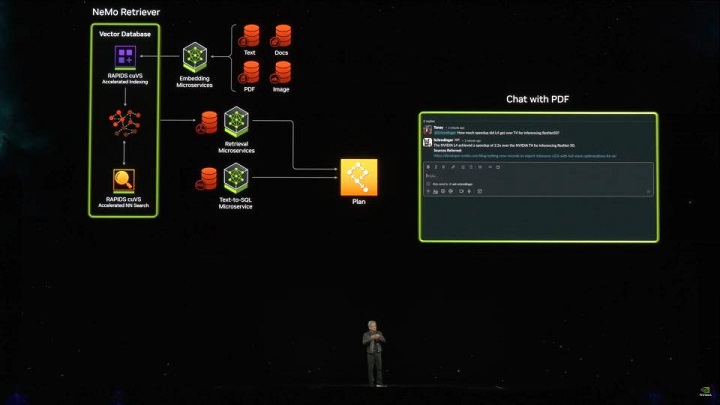

在Nim的搭建過(guò)程中,利用Nvidia NeMo Retriever技術(shù),公司的專有數(shù)據(jù)都可以被集成到這個(gè)微服務(wù)里以供使用。最終用戶會(huì)得到一個(gè)個(gè)NVIDIA NeMo,這就是針對(duì)每個(gè)公司的專有Copilit。這個(gè)專有的NeMo會(huì)用對(duì)話機(jī)器人的形式幫助你檢索公司數(shù)據(jù),如PPT,提供相關(guān)領(lǐng)域的技術(shù)支持。

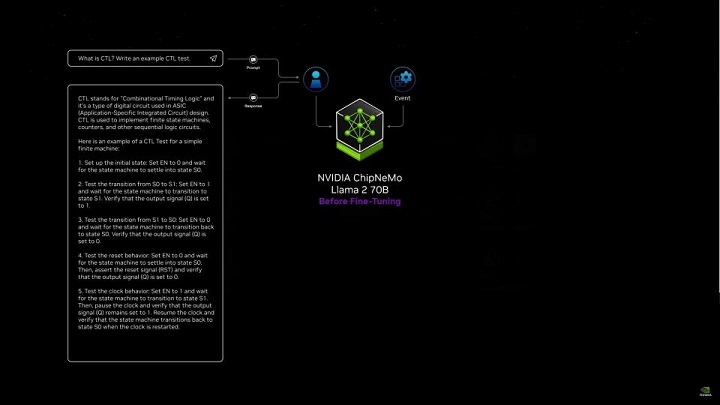

在發(fā)布會(huì)上,黃仁勛就展示了基于英偉達(dá)數(shù)據(jù)(Event)和芯片行業(yè)信息形成的Nvidia ChipNeMo,它構(gòu)建在開源的Llama2模型之上。利用英偉達(dá)的專有數(shù)據(jù),它可以回答只有英偉達(dá)公司內(nèi)部使用的CTL實(shí)驗(yàn)細(xì)節(jié)問(wèn)題。

這些NeMo還可以跨公司共用,也就是這套系統(tǒng)可以被視為工業(yè)大模型的GPT Store,行業(yè)公司可以使用其他公司或英偉達(dá)提供的行業(yè)基礎(chǔ)NeMo添加自己的數(shù)據(jù)即可獲得專有大模型。為此,英偉達(dá)還特意上線了ai.nvidia.com去承載這些NeMO。

這一微服務(wù)使得傳統(tǒng)企業(yè)AI轉(zhuǎn)型變得極為易得,不論是構(gòu)筑專有模型,還是直接通過(guò)模型連接企業(yè)私有數(shù)據(jù)都變得快速方便。黃仁勛表示 “成熟的企業(yè)平臺(tái)坐擁數(shù)據(jù)金礦, 他們掌握了大量可以轉(zhuǎn)化為副駕駛的數(shù)據(jù),當(dāng)你準(zhǔn)備好運(yùn)行這些人工智能聊天機(jī)器人時(shí),你將需要一個(gè)人工智能鑄造廠”。NIM正是這樣一個(gè)鑄造廠。它幫助構(gòu)建企業(yè)AI轉(zhuǎn)型的Copilot級(jí)產(chǎn)品,可以被視為公司AI化所需的基石。

這一產(chǎn)品將首先在即將發(fā)布的NVIDIA AI企業(yè)版第五版中搭載。對(duì)于NVIDIA AI企業(yè)版的現(xiàn)有客戶來(lái)說(shuō)這只是一個(gè)軟件升級(jí)。這項(xiàng)新功能不會(huì)額外收費(fèi)。當(dāng)然企業(yè)版價(jià)格本身并不低,單GPU的企業(yè)版使用權(quán)限包年就需要4500美金,小時(shí)租金為1美金每小時(shí)。

目前英偉達(dá)全公司已經(jīng)都用上了Nim,包括Box、Cloudera、Cohesity、Datastax、Dropbox等合作伙伴也都已經(jīng)參與Nim的使用和優(yōu)化過(guò)程。

03 Project GR00T機(jī)器人

英偉達(dá)的上一個(gè)萬(wàn)億市值來(lái)自GPU與算力,下一個(gè)萬(wàn)億市值增幅空間可能體現(xiàn)在對(duì)機(jī)器人開發(fā)的賦能上。

年初,英偉達(dá)資深科學(xué)家Jim Fan就宣布建立GEAR工作室,相關(guān)研究成果以及研究基礎(chǔ)環(huán)境成為了英偉達(dá)新機(jī)器人解決方案的基礎(chǔ)。

據(jù)了解,英偉達(dá)目前正在構(gòu)建包括NVIDIA IAI、Omniverse、ISAAC三大平臺(tái),三大平臺(tái)均與機(jī)器人產(chǎn)業(yè)高度關(guān)聯(lián)。其中NVIDIA IAI搭載DGX系列產(chǎn)品,用于模擬物理世界,Omnivese搭載RTX和OVX系列產(chǎn)品,用于驅(qū)動(dòng)數(shù)字孿生的計(jì)算系統(tǒng),ISAAC搭載AGX系列,用于驅(qū)動(dòng)人工智能機(jī)器人。

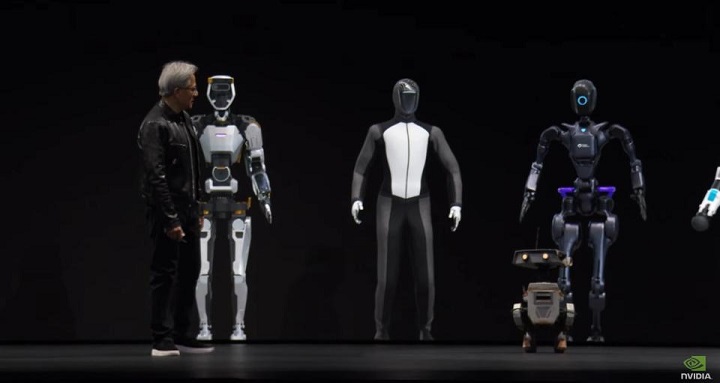

本次GTC大會(huì)上,英偉達(dá)還推出了Project GR00T人型機(jī)器人項(xiàng)目——人型機(jī)器人基礎(chǔ)模型。

英偉達(dá)表示,基于GR00T人型機(jī)器人基礎(chǔ)模型,可以實(shí)現(xiàn)通過(guò)語(yǔ)言、視頻和人類演示,來(lái)理解自然語(yǔ)言,模仿人類動(dòng)作,進(jìn)而快速學(xué)習(xí)協(xié)調(diào)性、靈活性以及其他的技能,進(jìn)而能夠融入現(xiàn)實(shí)世界并與人類進(jìn)行互動(dòng)。

除了基礎(chǔ)模型,該項(xiàng)目還包括基于NVIDIA Thor SoC系統(tǒng)的開發(fā)套件Jetson Thor,內(nèi)置了下一代Blackwell GPU(此前英偉達(dá)也推出個(gè)針對(duì)汽車的DRIVE Thor套件),帶寬達(dá)到100GB/s,AI計(jì)算性能達(dá)到800TFLOPs。

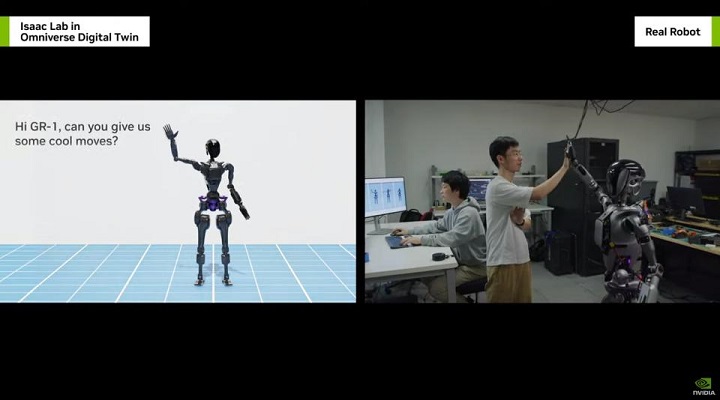

為了給Project GR00T項(xiàng)目提供軟件支持,基于英偉達(dá)Omniverse構(gòu)建的ISAAC Lab也進(jìn)行了同步更新,允許開發(fā)者利用該平臺(tái)模擬機(jī)器人學(xué)習(xí)技能、與物理世界模擬互動(dòng),支持?jǐn)?shù)千個(gè)機(jī)器人同步訓(xùn)練與模擬。

與此同時(shí),ISAAC Lab還整合了用于輔助提升機(jī)械臂的靈敏度與精確度的加速庫(kù)平臺(tái)ISAAC MANIPULATOR,以及用于提升服務(wù)機(jī)器人感知能力的ISAAC PERCEPTOR軟件庫(kù)。

按照慣例,英偉達(dá)也不免俗的用了客戶的例子為自家解決方案背書——比亞迪倉(cāng)庫(kù)機(jī)器人。

黃仁勛表示,英偉達(dá)過(guò)去和比亞迪基于Omniverse構(gòu)建汽車和工廠數(shù)字孿生上有了良好的合作,當(dāng)然也還包括汽車自動(dòng)駕駛業(yè)務(wù)方面的合作,現(xiàn)在則開始基于英偉達(dá)的ISSAC,展開倉(cāng)庫(kù)自動(dòng)機(jī)器人研發(fā)方面的合作。

在英偉達(dá)的愿景當(dāng)中,未來(lái)Omniverse將成為機(jī)器人系統(tǒng)的誕生地和AI的虛擬訓(xùn)練場(chǎng),你可以將其理解為“機(jī)器人產(chǎn)房”、“AI駕校”。

04 氣象觀測(cè)、計(jì)算光刻與6G

Omniverse的模擬不僅僅體現(xiàn)在機(jī)器人、數(shù)字孿生領(lǐng)域,在一些新技術(shù)的研發(fā)上,比如代表未來(lái)通信的6G技術(shù)研發(fā)也將派上用場(chǎng)。

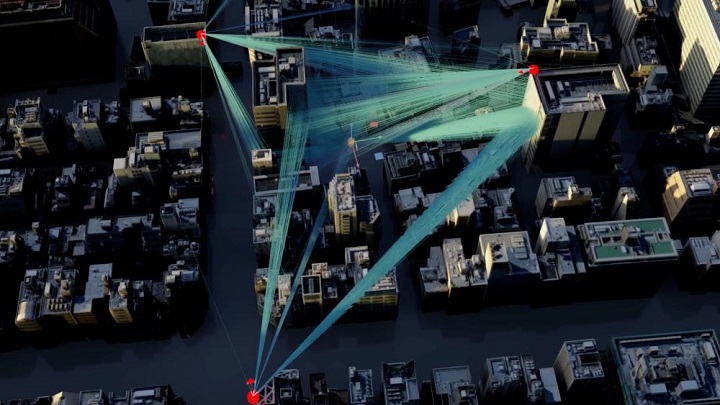

根據(jù)官方公布的信息,英偉達(dá)將推出6G研究云平臺(tái),其中包括為開發(fā)人員提供神經(jīng)無(wú)線電仿真框架能力的NVIDIA Aerial,以及提供模擬城市規(guī)模網(wǎng)絡(luò)的Omniverse數(shù)字孿生系統(tǒng),以及提供加速的無(wú)線接入網(wǎng)絡(luò)堆棧,從系統(tǒng)層面為開發(fā)者模擬一個(gè)具有城市規(guī)模的6G網(wǎng)絡(luò)系統(tǒng)。

基于英偉達(dá)6G云平臺(tái),開發(fā)者可以模擬城市大規(guī)模無(wú)線網(wǎng)絡(luò)環(huán)境

除了6G研究,英偉達(dá)希望將Omniverse帶到氣候和天氣預(yù)測(cè)方面。

官方表示,極端事件每年為全球帶來(lái)了1400億美元的經(jīng)濟(jì)損失,而目前高性價(jià)比的氣候模擬高度不能滿足需求,雖然千米級(jí)的模擬可以幫助人類模擬預(yù)測(cè)氣候和天氣,但這個(gè)計(jì)算量相比高空模擬要超出100萬(wàn)倍,進(jìn)而成本高昂。

為此,英偉達(dá)公布了地球氣候數(shù)字孿生套件NVIDIA Earth 2,它具有可交互的特點(diǎn),支持通過(guò)高分辨率模擬來(lái)加速氣候、天氣預(yù)測(cè)。作為一個(gè)支持千米級(jí)天氣預(yù)測(cè)的AI擴(kuò)散模型,Earth 2在天氣預(yù)報(bào)的計(jì)算預(yù)測(cè)上效率提升達(dá)到1000倍,而能效則提升了2000倍。

GTC2023大會(huì)上,英偉達(dá)推出計(jì)算光刻CuLitho軟件庫(kù),按照當(dāng)初的設(shè)想,單就晶圓廠部分的提效即可以實(shí)現(xiàn),每天利用1/9的電力,生產(chǎn)3-5倍的光掩膜,今年的大會(huì)上,黃仁勛也補(bǔ)充了計(jì)算光刻CuLitho的進(jìn)展。

官方表示,過(guò)去12個(gè)月內(nèi)與TSMC和Synopsys緊密合作,已經(jīng)將CuLitho集成這些客戶的工作流當(dāng)中,包括芯片的設(shè)計(jì)工具和生產(chǎn)制造。