7 月 31 日消息,蘋果公司最新發(fā)布論文 [PDF],分享了關(guān)于 Apple Intelligence 模型的相關(guān)細(xì)節(jié),部分性能已經(jīng)超過 OpenAI 的 GPT-4。

模型簡介

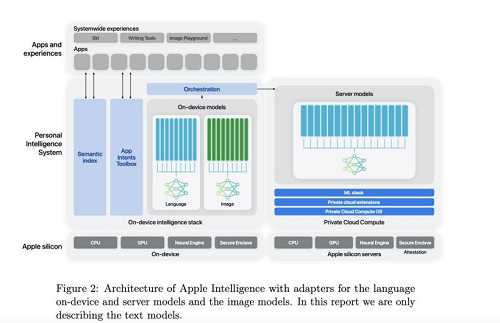

蘋果在論文中介紹了 Apple Foundation Model(下文簡稱 AFM)模型,共有以下兩款:

· AFM-on-device:本地運行,30 億參數(shù),可以在 iPhone、iPad 等設(shè)備上高效運行;

· AFM-server:蘋果尚未公布參數(shù)等細(xì)節(jié)。

訓(xùn)練數(shù)據(jù)來源

蘋果表示訓(xùn)練數(shù)據(jù)集包括從出版商處獲得授權(quán)的數(shù)據(jù)、經(jīng)過策劃的公開或開源數(shù)據(jù)集以及我們的網(wǎng)絡(luò)爬蟲 Applebot 抓取的公開信息組成。

蘋果強(qiáng)調(diào)注重保護(hù)用戶隱私,數(shù)據(jù)混合物中不包括蘋果用戶的私人數(shù)據(jù)。

據(jù)《紐約時報》報道,蘋果公司在 2023 年底與 NBC、Condé Nast 和 IAC 等多家出版商達(dá)成了價值至少 5000 萬美元的多年期協(xié)議,在出版商的新聞檔案中訓(xùn)練模型。

蘋果的 AFM 模型還在 GitHub 上托管的開源代碼上進(jìn)行了訓(xùn)練,特別是 Swift、Python、C、Objective-C、C++、JavaScript、Java 和 Go 代碼。

論文稱,為了提高 AFM 模型的數(shù)學(xué)技能,蘋果公司特別在訓(xùn)練集中加入了來自網(wǎng)頁、數(shù)學(xué)論壇、博客、教程和研討會的數(shù)學(xué)問題和答案。

蘋果利用了高質(zhì)量、可公開獲得的數(shù)據(jù)集(論文中未提及名稱),這些數(shù)據(jù)集“擁有允許用于訓(xùn)練...... 模型的許可證”,并經(jīng)過過濾以去除敏感信息。

AFM 模型的訓(xùn)練數(shù)據(jù)集約有 6.3 萬億個 token(token 是小塊數(shù)據(jù),通常更容易被生成式人工智能模型吸收)。相比之下,這還不到 Meta 用來訓(xùn)練其旗艦文本生成模型 Llama 3.1 405B 的 token 數(shù)量(15 萬億)的一半。

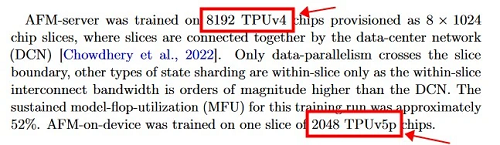

訓(xùn)練硬件

根據(jù)論文描述,蘋果公司使用 8192 片 TPUv4 芯片訓(xùn)練 AFM-server 模型;2048 片 TPUv5p 芯片訓(xùn)練 AFM-on-device 模型。

每個 v5p pod 由 8960 個芯片組成,每秒的浮點運算(FLOPS)和內(nèi)存分別是 TPU v4 的兩倍和三倍,訓(xùn)練模型的速度快了近三倍。

模型性能

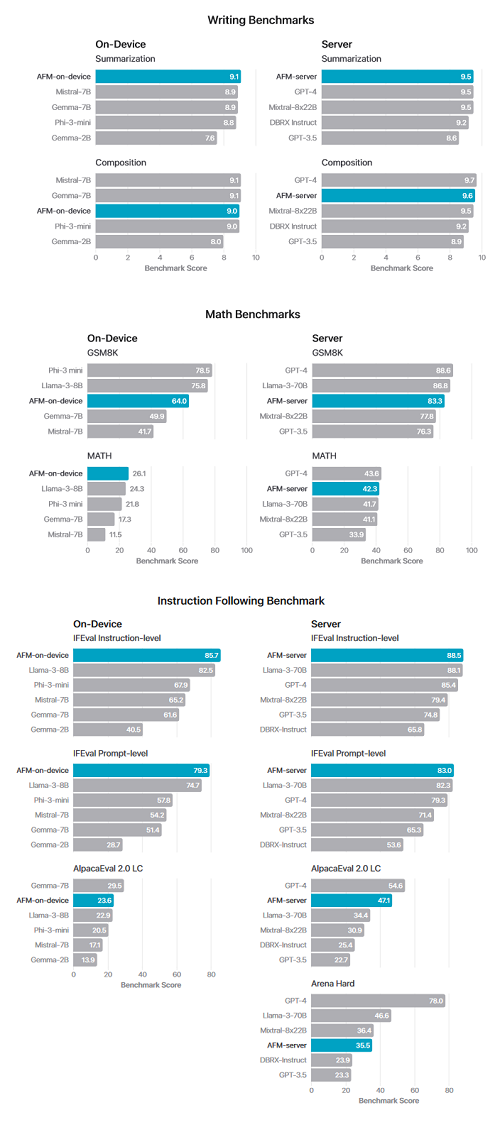

根據(jù)論文描述,蘋果自研大模型在指令遵循、文本總結(jié)方面測試超 GPT-4。

蘋果公司的數(shù)據(jù)顯示,AFM-server 有害輸出違規(guī)率為 6.3%,明顯低于 GPT-4 的 28.8%。同樣,在設(shè)備上,AFM 7.5% 的違規(guī)率低于 Llama-3-8B(由 Facebook 母公司 Meta 訓(xùn)練)21.8% 的得分。

在電子郵件、信息和通知匯總方面,設(shè)備上的 AFM 的滿意度分別為 71.3%、63% 和 74.9%。研究論文還指出,這三個模型分別領(lǐng)先于 Llama、Gemma 和 Phi-3 模型。附上相關(guān)性能結(jié)果如下: