1 月 13 日消息,據(jù)英偉達(dá)官方博客,英偉達(dá)宣布推出一款名為 Nemotron-CC 的大型英文 AI 訓(xùn)練數(shù)據(jù)庫,總計(jì)包含 6.3 萬億個(gè) Token,其中 1.9 萬億為合成數(shù)據(jù)。英偉達(dá)聲稱該訓(xùn)練數(shù)據(jù)庫可以幫助為學(xué)術(shù)界和企業(yè)界進(jìn)一步推動(dòng)大語言模型的訓(xùn)練過程。

目前,業(yè)界各類 AI 模型的具體性能主要取決于相應(yīng)模型的訓(xùn)練數(shù)據(jù)。然而現(xiàn)有公開數(shù)據(jù)庫在規(guī)模和質(zhì)量上往往存在局限性,英偉達(dá)稱 Nemotron-CC 的出現(xiàn)正是為了解決這一瓶頸,該訓(xùn)練數(shù)據(jù)庫 6.3 萬億 Token 的規(guī)模內(nèi)含大量經(jīng)過驗(yàn)證的高質(zhì)量數(shù)據(jù),號(hào)稱是 " 訓(xùn)練大型語言模型的理想素材 "。

數(shù)據(jù)來源方面,Nemotron-CC 基于 Common Crawl 網(wǎng)站數(shù)據(jù)構(gòu)建,并在經(jīng)過嚴(yán)格的數(shù)據(jù)處理流程后,提取而成高質(zhì)量子集 Nemotron-CC-HQ。

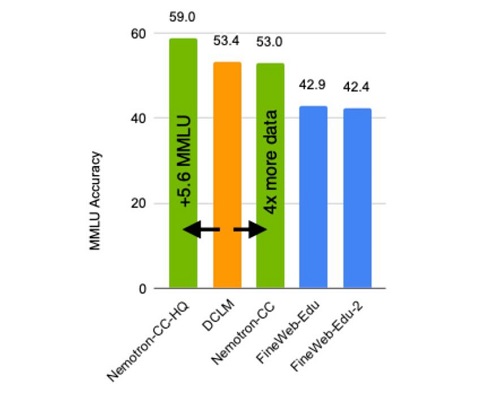

在性能方面,英偉達(dá)稱與目前業(yè)界領(lǐng)先的公開英文訓(xùn)練數(shù)據(jù)庫 DCLM(Deep Common Crawl Language Model)相比,使用 Nemotron-CC-HQ 訓(xùn)練的模型在 MMLU(Massive Multitask Language Understanding)基準(zhǔn)測試中的分?jǐn)?shù)提高了 5.6 分。

進(jìn)一步測試顯示,使用 Nemotron-CC 訓(xùn)練的 80 億參數(shù)模型在 MMLU 基準(zhǔn)測試中分?jǐn)?shù)提升 5 分,在 ARC-Challenge 基準(zhǔn)測試中提升 3.1 分,并在 10 項(xiàng)不同任務(wù)的平均表現(xiàn)中提高 0.5 分,超越了基于 Llama 3 訓(xùn)練數(shù)據(jù)集開發(fā)的 Llama 3.1 8B 模型。

英偉達(dá)官方表示,Nemotron-CC 的開發(fā)過程中使用了模型分類器、合成數(shù)據(jù)重述(Rephrasing)等技術(shù),最大限度地保證了數(shù)據(jù)的高質(zhì)量和多樣性。同時(shí)他們還針對(duì)特定高質(zhì)量數(shù)據(jù)降低了傳統(tǒng)的啟發(fā)式過濾器處理權(quán)重,從而進(jìn)一步提高了數(shù)據(jù)庫高質(zhì)量 Token 的數(shù)量,并避免對(duì)模型精確度造成損害。

英偉達(dá)已將 Nemotron-CC 訓(xùn)練數(shù)據(jù)庫已在 Common Crawl 網(wǎng)站上公開(點(diǎn)此訪問),英偉達(dá)稱相關(guān)文檔文件將在稍晚時(shí)候于該公司的 GitHub 頁中公布。