摘 要: 針對(duì)全局圖像特征不能有效刻畫彩色圖像內(nèi)容信息的問(wèn)題,提出了一種基于興趣點(diǎn)的彩色圖像特征檢索方法。首先基于仿射-尺度不變特征轉(zhuǎn)換(ASIFT)算法,利用亮度概率密度梯度進(jìn)行興趣點(diǎn)提取;然后將提取后的興趣點(diǎn)映射回原圖像,構(gòu)建顏色直方圖作為圖像的特征;最后通過(guò)計(jì)算不同圖像特征間的相似度進(jìn)行圖像檢索。仿真實(shí)驗(yàn)證明,該方法能夠充分地提取圖像中的角點(diǎn)、邊緣點(diǎn)和這些點(diǎn)的周圍點(diǎn),較好地表達(dá)圖像的內(nèi)容,最終得到比較理想的檢索結(jié)果。

關(guān)鍵詞: 圖像檢索;概率密度;仿射-尺度不變特征轉(zhuǎn)換算法

隨著多媒體技術(shù)的發(fā)展及互聯(lián)網(wǎng)的不斷普及,數(shù)字圖像作為一種內(nèi)容豐富、表現(xiàn)力強(qiáng)的信息儲(chǔ)存形式被大量應(yīng)用,而海量的數(shù)字圖像也因此產(chǎn)生。如何快速準(zhǔn)確地從數(shù)據(jù)庫(kù)中找到用戶所需要的圖像逐漸成為一個(gè)難題并被研究者重視。傳統(tǒng)的基于文本的圖像檢索技術(shù)主要依靠人工標(biāo)記,在大量消耗人力資源的同時(shí),還存在著用戶對(duì)圖像內(nèi)容的理解不同,標(biāo)記的信息不全面等問(wèn)題。因此,基于內(nèi)容的圖像檢索技術(shù)(Content-Based Image Retrieval)隨之產(chǎn)生,該方法是利用圖像的視覺(jué)特征(如顏色、形狀、紋理以及空間分布等底層特征)進(jìn)行檢索[1]。相對(duì)于人工標(biāo)記,這種方法所提取的特征更具有通用性,從而有效地解決了基于文本的圖像檢索技術(shù)的不足。

在基于內(nèi)容的圖像檢索中,傳統(tǒng)的方法一般使用全局特征進(jìn)行檢索[2],不但計(jì)算量大,而且在提取特征的過(guò)程當(dāng)中摻雜了很多并不被用戶所關(guān)注的信息。因此,基于局部特征的圖像檢索方法被學(xué)者們提出,目前常見的方法大致分為基于圖像分割的方法和基于興趣點(diǎn)的方法兩類。其中,基于圖像分割的方法由于圖像分割技術(shù)本身尚未成熟,在受到光照影響、背景相對(duì)復(fù)雜等因素的干擾下,很難找到一種相對(duì)通用的方法將目標(biāo)與背景完整地分離開。因此,更具穩(wěn)定性和通用性的基于興趣點(diǎn)的方法受到了更多的關(guān)注。WOL C等人[3]提出了一種通過(guò)提取特征點(diǎn)局部Gabor特征的方法,進(jìn)行圖像的檢索。根據(jù)不同尺度不同方向的最大幅值,構(gòu)造出不同直方圖描述圖像。Zheng Xia等人[4]首先將圖像分成不同區(qū)域,分別對(duì)每個(gè)區(qū)域檢測(cè)進(jìn)行興趣點(diǎn)的檢測(cè),然后利用興趣點(diǎn)的邊緣類型的直方圖進(jìn)行檢索。Jian Mumei等人[5]利用密度聚類的算法實(shí)現(xiàn)圖像檢索。該算法首先對(duì)興趣點(diǎn)進(jìn)行分類,然后利用顏色矩和Gabor特征對(duì)每類興趣點(diǎn)進(jìn)行處理,通過(guò)構(gòu)建出圖像的特征向量進(jìn)行檢索。符祥等人[6]基于局部興趣點(diǎn)的灰度信息,利用Zernike矩相關(guān)理論計(jì)算Zernike矩值作為圖像特征,然后通過(guò)計(jì)算歐氏距離的方法對(duì)不同特征間的距離進(jìn)行排序,從而濾除不匹配的興趣點(diǎn),最后利用興趣點(diǎn)的空間離散度作為不同圖像間的相似度來(lái)實(shí)現(xiàn)圖像的檢索操作。

以上檢索方法充分考慮到了興趣點(diǎn)的分布信息,并且不同程度地提高了檢索精度,但終究不能達(dá)到理想的效果。為了進(jìn)一步提高檢索的準(zhǔn)確性,本文提出一種新的基于興趣點(diǎn)的圖像檢索方法,該方法在仿射-尺度不變特征轉(zhuǎn)換(ASIFT)[7]算法基礎(chǔ)上,利用亮度的概率密度梯度來(lái)完成對(duì)興趣點(diǎn)的檢測(cè)。該算法不僅能有效地繼承ASIFT算法的優(yōu)點(diǎn),并且使興趣點(diǎn)更好地聚集在圖像的關(guān)鍵區(qū)域上,從而更加充分地表達(dá)出圖像的語(yǔ)義。最后通過(guò)計(jì)算興趣點(diǎn)顏色直方圖的相似度進(jìn)行圖像的檢索。

1 圖像的興趣點(diǎn)檢測(cè)

圖像中的角點(diǎn)、邊緣點(diǎn)等具有很好的穩(wěn)定性,常被研究者們作為興趣點(diǎn)來(lái)描述圖像特征。Harris[8]基于Moravec的檢測(cè)算法中,利用亮度函數(shù)的自相關(guān)矩陣檢測(cè)興趣點(diǎn),但是該算法存在對(duì)紋理很敏感,容易產(chǎn)生噪聲的不足。因此,本文用各點(diǎn)亮度的概率密度梯度代替亮度梯度,通過(guò)ASIFT算子進(jìn)行興趣點(diǎn)的提取。

1.1概率密度梯度估計(jì)

目前,主要的興趣點(diǎn)檢測(cè)算法都將研究重心集中在幾何不變性上,而對(duì)于圖像檢索技術(shù),興趣點(diǎn)的數(shù)量、分布程度同樣也很重要。只有將興趣點(diǎn)集中在圖像的關(guān)鍵區(qū)域上,才能有效地表達(dá)出圖像內(nèi)容的語(yǔ)義信息;只有在興趣點(diǎn)數(shù)量足夠多時(shí),才能保證對(duì)圖像內(nèi)容信息描述足夠詳細(xì),從而得到理想的檢索結(jié)果。參考文獻(xiàn)[9]提出了一種基于概率密度的檢測(cè)算法,該算法在Harris角點(diǎn)檢測(cè)算法的基礎(chǔ)上,將亮度梯度替換為亮度的概率密度梯度,進(jìn)而建立二階矩矩陣,最終實(shí)現(xiàn)對(duì)興趣點(diǎn)的提取。該算法可以有效地降低紋理中的“噪聲”興趣點(diǎn),并且興趣點(diǎn)的分布比基于亮度算法更加均勻。在此基礎(chǔ)上,本文使用ASIFT算子代替原文獻(xiàn)使用的Harris算子,繼承了ASIFT算子提取的興趣點(diǎn)多的優(yōu)點(diǎn),并且使興趣點(diǎn)更好地聚集在圖像邊緣等關(guān)鍵區(qū)域上,從而更加充分地表達(dá)出圖像的語(yǔ)義。

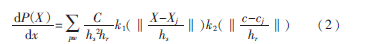

圖像中每個(gè)像素的概率密度都可以通過(guò)核函數(shù)估計(jì)得到。圖像中的任意一點(diǎn)X(x,y)處的概率密度P(X)的估計(jì)值為:

![DX9(4AM)(CY${PZ6XW]A61S.png DX9(4AM)(CY${PZ6XW]A61S.png](http://files.chinaaet.com/images/2015/05/26/6356826921163579698288841.png)

其中,pw是每一點(diǎn)概率密度的觀測(cè)窗口,Xj是以X為中心的窗口pw的一點(diǎn),cj是圖像中Xj點(diǎn)的亮度,k1、k2是高斯核函數(shù),hs是圖像空間中的帶寬,hr是亮度空間中的帶寬。通過(guò)式(1)可以推導(dǎo)出各像素概率密度梯度的估計(jì)公式為:

1.2 ASIFT算子介紹

興趣點(diǎn)的提取方法有很多,如SIFT算法、SURF算法、Harris算法等,這些方法雖然各有優(yōu)點(diǎn),但都不具備完全的仿射不變性。而ASIFT算法實(shí)現(xiàn)了真正意義上的仿射不變。

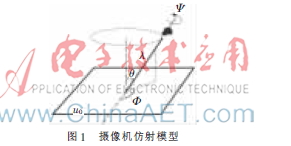

圖1闡明了仿射變換的參數(shù)[10],分別是:u0是一個(gè)平面圖像,角度θ和Φ分別表示攝像機(jī)光軸的經(jīng)度,角度Φ表示攝像機(jī)光軸的緯度,角度Ψ代表攝像機(jī)的旋轉(zhuǎn)角度,λ是縮放參數(shù)。這些參數(shù)中,SIFT算法和SURF算法對(duì)所有參數(shù)都進(jìn)行了歸一化,而ASIFT算子則歸一化了仿射變換中的平移、旋轉(zhuǎn)、傾斜3個(gè)參數(shù),模擬了經(jīng)度角、緯度角、尺度縮放3個(gè)參數(shù)。

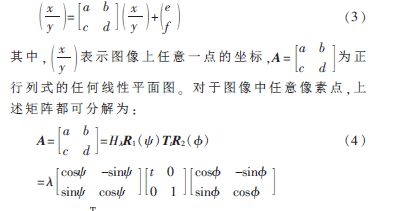

由于相機(jī)光軸的變化帶來(lái)的圖像扭曲,可以使用仿射平面的改變進(jìn)行局部的建模操作,其中,目標(biāo)邊界必須光滑或者是分段光滑的。此時(shí)攝像機(jī)運(yùn)動(dòng)由于光軸變換所帶來(lái)的圖像的扭曲模型為:

u(x,y)→u(ax+by+e,cx+dy+f),將其改寫成矩陣的形式為:

其中,T=ef是平移因子;t>1是絕對(duì)傾斜參數(shù),它是攝像機(jī)光軸與所照射物體平面垂線的夾角余弦的倒數(shù)值;λ>0是縮放參數(shù);表示平面旋轉(zhuǎn)?鬃角度。

ASIFT算法步驟如下:

(1)充分考慮所有相機(jī)可能拍攝到該圖片的角度,模擬出由相機(jī)光軸的經(jīng)度和緯度變化所帶來(lái)的所有可能的仿射變換。

(2)仿射扭曲的變換由光軸的傾斜參數(shù)和旋轉(zhuǎn)角度決定,而旋轉(zhuǎn)和傾斜由經(jīng)度角和緯度角表示,對(duì)這些參數(shù)進(jìn)行間隔采樣,采樣間隔要確保模擬出盡可能多的由于相機(jī)光軸變化所導(dǎo)致的圖像扭曲。

(3)利用SIFT算子對(duì)所有模擬出的圖像進(jìn)行處理,提取興趣點(diǎn)。

2 特征構(gòu)造和相似度計(jì)算

顏色是彩色圖像最直觀的特征。在提取圖像顏色特征的眾多方法中,顏色直方圖由于具有對(duì)旋轉(zhuǎn)、平移和尺度變化不敏感的特點(diǎn),并且計(jì)算簡(jiǎn)單,已成為圖像檢索中應(yīng)用最多的特征提取方法。

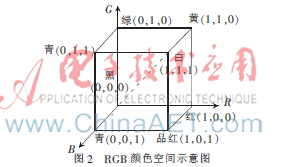

2.1 RGB顏色空間

RGB顏色空間是是最常見的顏色空間,廣泛用于手機(jī)、數(shù)碼相機(jī)和計(jì)算機(jī)等設(shè)備。它是由紅、綠、藍(lán)3種基色混合構(gòu)成的直角坐標(biāo)系中的一個(gè)單位正方體,坐標(biāo)系中的原點(diǎn)即3種顏色的亮度都等于零為黑色,當(dāng)3種顏色的亮度都達(dá)到1時(shí)表示白色,如圖2所示。

2.2 顏色直方圖

圖像的顏色直方圖采用統(tǒng)計(jì)學(xué)的方法,分別計(jì)算各個(gè)顏色通道興趣點(diǎn)的顏色值的出現(xiàn)頻數(shù)。通常情況下,其定義為:

Hx,y,z(x,y,z)=N×Prob(R=x,G=y,B=z)(5)

其中,R、G、B分別代表了紅、綠、藍(lán)3個(gè)顏色通道,N代表了圖像中像素點(diǎn)的個(gè)數(shù)。本文算法分別統(tǒng)計(jì)了紅、綠、藍(lán)3個(gè)顏色通道中興趣點(diǎn)的顏色直方圖,構(gòu)成一個(gè)三維特征向量,并將其作為圖像的特征進(jìn)像檢索。

2.3 相似度計(jì)算

相似度計(jì)算采用歐氏距離計(jì)算,目標(biāo)圖像和圖像庫(kù)中的圖像特征向量間的相似度計(jì)算公式為:

S(Q,I)=SR(Q,I)+SG(Q,I)+SB(Q,I)(6)

其中,Q和I表示目標(biāo)圖像和圖像庫(kù)中的圖像,SR、SG、SB分別表示R、G、B 3個(gè)顏色通道的歐式距離。

3 仿真實(shí)驗(yàn)結(jié)果

興趣點(diǎn)的提取方法是否能夠滿足圖像檢索的要求,主要在于兩個(gè)方面:(1)必須有足夠多的興趣點(diǎn),這樣才能盡可能充分表達(dá)出圖像的內(nèi)容信息;(2)興趣點(diǎn)必須盡可能多地聚焦在圖像的主要語(yǔ)義信息上,從而準(zhǔn)確表達(dá)圖像內(nèi)容。為了驗(yàn)證本文算法的有效性,進(jìn)行了如下仿真實(shí)驗(yàn)。實(shí)驗(yàn)中所采用的軟硬件環(huán)境為:Intel Xeon E5-1603 2.8 GHz處理器,4 GB內(nèi)存,Windows 7 64位操作系統(tǒng)和MATLAB 2011b。

圖3顯示了本文算法與全局顏色直方圖檢索算法[2]、參考文獻(xiàn)[11]算法的對(duì)比檢索結(jié)果,其中第一幅圖為待檢圖像。

為進(jìn)一步證明本文算法的有效性,將本文算法與全局顏色直方圖算法、參考文獻(xiàn)[11]算法的平均查準(zhǔn)率、平均查全率進(jìn)行對(duì)比。實(shí)驗(yàn)選用了著名的Corel圖像庫(kù),該圖像數(shù)據(jù)庫(kù)包括非洲人、馬、大象、恐龍、風(fēng)景、沙灘、公交車、夕陽(yáng)等各類圖片3 000張(包含30個(gè)種類,每個(gè)種類包含100幅相關(guān)圖片)。實(shí)驗(yàn)中從圖像庫(kù)中任意挑選了10類圖像,每類圖像隨機(jī)抽取10幅作為待檢圖像,共構(gòu)成100次查詢。每次查詢從檢索結(jié)果中截取前20幅相似程度最高的圖像作為檢索結(jié)果。對(duì)于每類圖像分別計(jì)算其查詢結(jié)果的查準(zhǔn)率平均值、查全率平均值,其中:

表1和表2分別給出了3種方法的對(duì)比實(shí)驗(yàn)結(jié)果。

基于內(nèi)容的圖像檢索是一門飛速發(fā)展中的跨學(xué)科、綜合性的高新技術(shù),該技術(shù)的研究與發(fā)展涉及多個(gè)學(xué)科和領(lǐng)域。本文以興趣點(diǎn)為基礎(chǔ),提出了一種概率密度和ASIFT的彩色圖像檢索方法。該方法能夠充分提取圖像中的興趣點(diǎn),并能有效地刻畫出圖像的特征,降低了圖像檢索的歧義性。仿真實(shí)驗(yàn)表明,該方法能夠準(zhǔn)確和高效地查找出用戶所需內(nèi)容的彩色圖像,在圖像檢索領(lǐng)域有較廣闊的應(yīng)用前景。

參考文獻(xiàn)

[1] REDDY P V N, SATYA PRASAD K. Color and texture features for content based image retrieval[J]. International Journal of Computer Technology and Applications, 2011,2(4):1016-1020.

[2] SWAIN M J, BALLARD D H. Color Indexing[J].International Journal of Computer Vision, 1991,7(1):11-32.

[3] WOL C, JOLION J, KROPATSCH W, et a.l Content based image retrieval using interest points and texture features[C]. Proceedings of 15th International Conference on Pattern Recognition, Barcelona, IAPR, 2000: 234-237.

[4] Zheng Xia, Zhou Mingquan, Wang Xingce. Interest point based medical image retrieval[C]. Lecture Notes in Computer Science, Beijing:Springer Verlag, 2008:118-124.

[5] Jian Muwei, Chen Shi. Image retrieval based on clustering of salient points[C]. Proceedings of 2008 2nd International Symposium on Intelligent Information Technology Application, Shanghai, 2008,1: 347-351.

[6] 符祥,曾接賢.基于興趣點(diǎn)匹配和空間分布的圖像檢索方法[J].中國(guó)激光,2010,37(3):774-778.

[7] MOREL J M, Yu Guoshen. A new framework for fully affine invariant image comparison[J]. SIAM Journal on Imaging Science, 2009,2(2):438-469.

[8] HARRIS C, STEPHENS M. A combined corner and edge detector[C]. proceedings of 4th Alevy Vision Conference,1988: 147-151.

[9] 孫達(dá),唐降龍,劉家鋒,等.基于概率密度的興趣點(diǎn)檢測(cè)算法[J].自動(dòng)化學(xué)報(bào),2008,34(8),854-860.

[10] Yu Guoshen, MOREL J M. A fully affine invariant image comparison method[C]. IEEE International Conference on Acoustics Speech and Signal Processing, Taipei,2009:1597-1600.

[11] YAP P T, PARAMESRAN R. Content-based image retrieval using Legendre chromaticity distribution moments[J]. IEEE Proceedings of Vision Image and Signal Processing, 2006,153(1):17-24.