摘要:針對(duì)復(fù)雜背景下的目標(biāo)識(shí)別問題,提出一種新的基于增量記憶的視覺注意模型。首先根據(jù)目標(biāo)的顏色形狀,以及自底向上的原始視覺特征顏色、強(qiáng)度、方向、對(duì)稱性對(duì)目標(biāo)進(jìn)行粗定位。在此基礎(chǔ)上,利用粗選目標(biāo)的顏色、形狀生成一組自頂向下的偏差信號(hào),對(duì)初選目標(biāo)進(jìn)行及時(shí)指導(dǎo)修正。為了提高識(shí)別的準(zhǔn)確率,算法設(shè)計(jì)了一種增量學(xué)習(xí)記憶的機(jī)制來指導(dǎo)偏差信號(hào),所提出的增量注意機(jī)制不僅可以不斷學(xué)習(xí)和記憶各類目標(biāo)的顏色和形狀特征,而且利用這種機(jī)制可生成一個(gè)自頂向下的偏差信號(hào),對(duì)關(guān)注的候選區(qū)域的目標(biāo)進(jìn)行精確定位。此外,訓(xùn)練后的增量記憶的顏色、形狀特征有助于推斷新的未知目標(biāo)。最后的仿真實(shí)驗(yàn)中,與五種典型算法對(duì)比,無論是主觀還是客觀實(shí)驗(yàn),都獲得了較優(yōu)結(jié)果。因此,所提算法是一種高效的、切實(shí)可行的算法。

關(guān)鍵詞:自底向上注意;自頂向下注意;增量記憶;視覺顯著性

0引言

人類視覺系統(tǒng)[1]具有機(jī)器無法比擬的靈活、高效的適應(yīng)能力,在自然或雜亂復(fù)雜的場(chǎng)景中,往往可以輕松地檢測(cè)到任意目標(biāo)。因此,把人類視覺系統(tǒng)的特性融入到人工視覺系統(tǒng)中一直是計(jì)算機(jī)視覺領(lǐng)域的研究重點(diǎn)。而顯著目標(biāo)檢測(cè),由于其高效的處理性能、廣闊的應(yīng)用前景,被認(rèn)為是機(jī)器視覺研究的重中之重。

本文利用增量記憶將自底向上處理過程與自頂向下處理過程結(jié)合起來,提出一種新的注意模型。基于該模型的算法強(qiáng)調(diào)自頂向下的注意感知,實(shí)際上是一個(gè)自底向上和自頂向下有機(jī)融合和相互作用的過程,將目標(biāo)對(duì)象生成的偏差信號(hào)定義為增量記憶,自頂向下模型生成的增量記憶不斷指導(dǎo)修正自底向上模型對(duì)目標(biāo)對(duì)象的識(shí)別,達(dá)到即使在復(fù)雜背景下,也可以準(zhǔn)確、高效地識(shí)別出目標(biāo)對(duì)象。最后的仿真結(jié)果中,與6種典型自底向上注意模型對(duì)比,所提算法體現(xiàn)了更好的穩(wěn)定性和有效性。

1視覺注意機(jī)制

視覺注意機(jī)制是模擬人腦來處理信息的機(jī)制[2]。通過將不同的處理優(yōu)先級(jí)賦予不同的圖像區(qū)域,可以降低處理過程的復(fù)雜度,提高處理速度和抗干擾能力,即在特征整合理論的基礎(chǔ)上,提取圖像的亮度等初級(jí)視覺特征,形成各個(gè)特征維的顯著圖;然后基于非均勻采樣的方式,采用多特征圖合并策略對(duì)這些不同特征維的顯著圖進(jìn)行融合,形成一幅最終的顯著圖。根據(jù)顯著圖可以得到一系列的待注意的目標(biāo),各目標(biāo)通過注意轉(zhuǎn)移的禁止返回(Iinhibition of retum)機(jī)制[3]和勝者為王(Winnertakeall)競(jìng)爭(zhēng)機(jī)制[4]吸引注意焦點(diǎn),并使得注意焦點(diǎn)在各個(gè)待注意的目標(biāo)之間依一定的原則轉(zhuǎn)移。注意信息是由每一個(gè)對(duì)應(yīng)于特定區(qū)域圖像特征的點(diǎn)組成的。

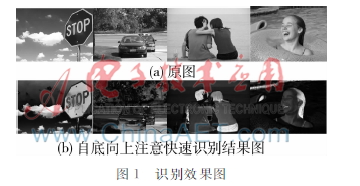

以基于視覺注意機(jī)制的注意快速識(shí)別目標(biāo)為例,其識(shí)別效果如圖1所示。

由圖可知,單純視覺注意模型檢測(cè)顯著目標(biāo)的效果并不好,在目標(biāo)對(duì)象和背景對(duì)比度不明顯的情況下識(shí)別效果很差,顯著區(qū)域的邊界不清晰,特征細(xì)節(jié)給模糊掉了,目標(biāo)對(duì)象并不突出,尤其背景比較復(fù)雜的情況下,噪聲干擾也比較大。

2基于增量記憶視覺注意模型的復(fù)雜目標(biāo)

為了模擬人類的智能視覺系統(tǒng),本文提出一種基于增量記憶的視覺注意的模型。本模型包括兩個(gè)處理過程:自底向上處理過程[5],自頂向下處理[6]過程。自頂向下處理過程生成增量記憶,指導(dǎo)修正自底向上處理過程的識(shí)別目標(biāo)對(duì)象工作,其中增量注意不僅可以不斷學(xué)習(xí)和記憶各類目標(biāo)的顏色和形狀特征,而且利用增量記憶生成自頂向下的偏差信號(hào),可以對(duì)目標(biāo)對(duì)象進(jìn)行精確定位。整體框圖如圖2所示。

首先由原始的輸入圖像可獲取到圖像的基本特征,通過高斯金字塔提取粗尺度圖像,圖像通過中央標(biāo)準(zhǔn)差(CSD)獲取到顯著信息[7];同時(shí)對(duì)圖像的基本顏色特征、形狀特征進(jìn)行加權(quán)等處理生成基于原始圖像的顏色、形狀偏差信號(hào),即增量記憶,在生成細(xì)識(shí)別目標(biāo)對(duì)象的過程中,偏差信號(hào)對(duì)識(shí)別不斷指導(dǎo)修正,以實(shí)現(xiàn)復(fù)雜背景下目標(biāo)對(duì)象的高效準(zhǔn)確識(shí)別,生成顯著圖。通過增量記憶[8]不僅可以識(shí)別顯著區(qū)域,而且可以將其存儲(chǔ)下來。

21自底向上處理

211顏色特征提取

為了提高識(shí)別精度,并且實(shí)現(xiàn)彩色圖像的識(shí)別,識(shí)別過程中各個(gè)顏色通道需保持獨(dú)立。若想獲得最佳的圖像邊緣就需要采用IUV顏色空間[9]。把對(duì)彩色圖像(R,G,B)的識(shí)別問題轉(zhuǎn)換成(I,U,V)顏色空間的問題,識(shí)別過程中各個(gè)顏色通道保持獨(dú)立,這種方法識(shí)別精度高,并且實(shí)現(xiàn)了彩色圖像的識(shí)別。通過公式(1)計(jì)算:

根據(jù)RGB顏色空間模型[10]構(gòu)建一個(gè) IUV 顏色模型,轉(zhuǎn)化方法如公式(2)所示:

強(qiáng)度特征i通過公式(3)獲得:

i=(r+g+b)/3(3)

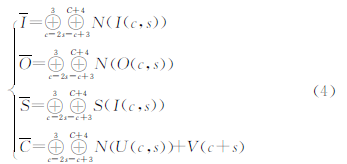

212基于中央周邊差的特征處理

在顯著圖模型中,以方向(O)和對(duì)稱性(S)特性作為高階特性,分別利用Gabor濾波器和Fukushima對(duì)稱性提取邊緣特性的方法,將I、O、S、U、V 5個(gè)特征通過高斯金字塔,生成7個(gè)不同尺寸的特征圖,可以得到35幅特征圖。然后,利用中央周邊差,將I、O、S、U、V的顯著圖組合成4個(gè)顯著圖,如式(4):

I,O,S,C分別表示強(qiáng)度、方向、對(duì)稱性和顏色對(duì)立的顯著圖。c和s分別代表規(guī)模指數(shù)小尺度(中心)和粗尺度(周圍)。N(·)是一種歸一化函數(shù),這樣每個(gè)像素值都在0~255范圍內(nèi)。

213基于顯著圖的獨(dú)立成分分析

在該模塊中,采用獨(dú)立分量分析算法[11]來減少冗余,以視覺皮層的作用作為冗余減速器。將特征圖各個(gè)特征通道與濾波器寬度作卷積計(jì)算并求和來確定局部顯著區(qū)域。最合適的規(guī)模顯著區(qū)域集中在x,如式(5)所示:

HD(l,x)和WD(l,x)分別是熵和窗大小。在自底向上顯著圖模型中獲取局部區(qū)域,定義為IOR 區(qū)域[12]。自底向上凸起的局部地區(qū)獲得的地圖模型被定義為IOR地區(qū)。那么屏蔽掉這個(gè)IOR 區(qū)域也就是排除了先前認(rèn)為的顯著對(duì)象,接著可以找到下一個(gè)顯著目標(biāo)。

214顯著圖的熵值選擇與目標(biāo)對(duì)象中央加強(qiáng)

本文通過抑制幅度譜脈沖進(jìn)行顯著目標(biāo)檢測(cè),對(duì)脈沖的抑制量不同檢測(cè)出的顯著圖結(jié)果也不同,所以建立了不同高斯函數(shù)平滑后幅度譜尺度空間[13],它是由一系列高斯函數(shù)與幅度譜卷積[14]得到的,每個(gè)高斯函數(shù)具有一個(gè)不同的尺度參數(shù),如式(6)所示:

其中k為可調(diào)節(jié)的尺度參數(shù), k=1…K,K由圖像的尺寸決定,如式(7)所示:

K=[log2min{H,W}]+1(7)

H,W為圖像的長(zhǎng)和寬,t0=05。給定圖像的幅度譜為A(u,v),則平滑幅度譜的尺度空間如式(8)所示:

Λ(u,v,k)=(g(u,k)*A(u,v))(8)

對(duì)不同尺度的顯著圖求熵值,熵值最小的顯著圖[15]認(rèn)為檢測(cè)結(jié)果是最好的,其計(jì)算公式如式(9)所示:

kp=arg min{H(Sk)}(9)

其中熵值計(jì)算為傳統(tǒng)的計(jì)算公式如式(10)所示:

H(x)=-∑ni-1Pilogpi(10)

22自頂向下處理

221提取顏色和形狀特征

由R,G,B和Y色彩成分可以獲取到RG和BY特性,而由RG和BY可以獲取物體的顏色和形狀特性,通過此過程可以有效地通過顏色特征來提取圖像的細(xì)節(jié)信息。目標(biāo)物體的RG和BY特征通過裁剪變成兩個(gè)16×16極對(duì)數(shù)特性,并且將每個(gè)極對(duì)數(shù)特性轉(zhuǎn)換為一維向量。

本文采用熵最大模型來分別模擬視覺注意機(jī)制簡(jiǎn)單特性和復(fù)雜特性,即S1和C1特性。S1特性構(gòu)造使用一個(gè)對(duì)象在一個(gè)局部區(qū)域的定位信息,并通過Gabor濾波器具有不同尺度的輸入圖像。通過濾波可以獲得2尺度和8個(gè)方向的濾波特性的S1特性。因此每個(gè)方向就有了兩個(gè)S1定位圖,通過S1定位圖對(duì)每個(gè)方向的操作取最大的操作可以得到C1特性。

222自頂向下信號(hào)生成偏差矩陣

當(dāng)成功訓(xùn)練學(xué)習(xí)目標(biāo)對(duì)象后還有一個(gè)額外的作用就是可以生成權(quán)重矩陣,矩陣可以生成自上而下的偏差信號(hào),這樣便在輸入場(chǎng)景中可以找到目標(biāo)對(duì)象區(qū)域。基于特定偏差注意的目標(biāo)對(duì)象任務(wù)來考慮尺度不變特性,基于三種不同尺度的高斯金字塔,其三種不同的尺度可以用來訓(xùn)練三種不同比例的顏色和形狀特性。所以這三種不同比例訓(xùn)練的權(quán)重矩陣可以生成三種不同尺度的特性。在中央周邊差(CSD&N)過程中,三種不同比例的權(quán)重矩陣可以用于生成不同尺度的偏差信號(hào)。

在自底向上的特征提取過程中獲取到權(quán)重矩陣從而獲得自上而下的偏差信號(hào),在生成偏差信號(hào)的過程中IBe,OBe,SBe,CBe如式(11)所示:

其中c_We和f_We分別是顏色和形狀的加權(quán)矩陣,Ie,Oe,Se,Ce分別是強(qiáng)度、方向、對(duì)稱性和顏色特征。

23增量記憶

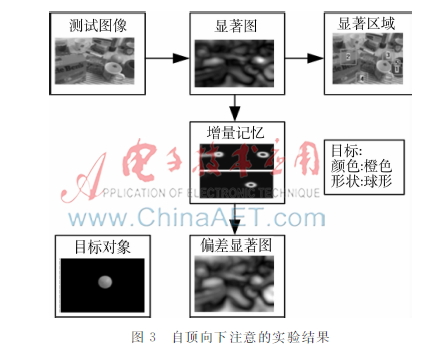

首先將自頂向下處理工程生成的顏色、形狀偏差信號(hào)定義為增量記憶,結(jié)合考慮自頂向下的目標(biāo)對(duì)象的形狀和顏色偏差信號(hào),得出顯著圖,利用提出的模型可以成功地提取出目標(biāo)物體區(qū)域,生成流程圖如圖3所示。

通過對(duì)一個(gè)特定尺度的目標(biāo)對(duì)象的感知可以獲取到每個(gè)感知對(duì)象的權(quán)重矩陣。因此,通過使用不同尺度的自底向上特征并用自上向下的加權(quán)矩陣提出的自上向下偏差模型可以檢測(cè)出尺度不變的對(duì)象定位區(qū)域。基于同一特征圖生成過程由自頂向下的偏差強(qiáng)度特征、方向特征、對(duì)稱性特征、顏色特征可以創(chuàng)建偏差強(qiáng)度特征圖、偏差方向特征圖、偏差顏色特征圖、偏差對(duì)稱性特征圖這四種不同的偏差特征圖。

3實(shí)驗(yàn)結(jié)果

將本文提出的方法與FT,SR,AIM,Gbvs,Itti算法進(jìn)行比較,實(shí)驗(yàn)結(jié)果如圖4。

(d)AIM(e)Gbvs(f)Itti(g)本文方法從上圖的對(duì)比結(jié)果可以看出,本文方法具有最好的顯著性能評(píng)估。對(duì)于測(cè)試圖像,大多數(shù)方法都能夠檢測(cè)出顯著目標(biāo),但是都各有利弊,并不完善。FT算法可以識(shí)別目標(biāo)對(duì)象但是精確度不高,沒有消除冗余信息;SR算法抗噪聲性能不好,識(shí)別效果也不是很理想;AIM算法在目標(biāo)對(duì)象和背景對(duì)比度不明顯的情況下識(shí)別效果很差,顯著區(qū)域的邊界不清晰;Gbvs算法和Itti算法可以識(shí)別出目標(biāo)對(duì)象的大體輪廓,但是對(duì)象的細(xì)節(jié)信息被復(fù)雜的背景給模糊掉了,所以最終識(shí)別效果不好。從本文算法最終識(shí)別效果可以看出,對(duì)于復(fù)雜背景下的目標(biāo)對(duì)象識(shí)別效果還是很不錯(cuò)的,冗余信息處理的也比較好,抗噪聲性能相比較也是比較強(qiáng)的,精確度、準(zhǔn)確率等各方面的表現(xiàn)都不錯(cuò)。

4結(jié)束語

在正常的人類視覺中,自底向上和自頂向下處理過程的結(jié)合將會(huì)影響注意,并將注意吸引到顯著的相關(guān)場(chǎng)景部分。所以,強(qiáng)調(diào)模擬自頂向下的注意感知實(shí)際上是一個(gè)自下而上和自上而下的有機(jī)融合和相互作用的過程,在這個(gè)過程中自動(dòng)運(yùn)用視覺認(rèn)知規(guī)律,通過一系列視知覺操作,使視覺處理過程在一定目的下,以盡可能小的代價(jià)獲得盡可能好的結(jié)果,也更加符合人類視覺感知的基本特征。

復(fù)雜背景下的目標(biāo)識(shí)別是計(jì)算機(jī)視覺的研究熱點(diǎn)和難點(diǎn)問題。本文中提出了一種基于增量記憶將自底向上和自頂向下相結(jié)合的方式來定位復(fù)雜背景下目標(biāo)對(duì)象的方法。在復(fù)雜的背景下,該模型有較強(qiáng)的噪聲抑制能力,可以把目標(biāo)準(zhǔn)確定位出來并且更好地解決目標(biāo)識(shí)別的問題。

參考文獻(xiàn)

[1] 田媚.模擬自頂向下視覺注意機(jī)制的感知模型研究[D].北京:北京交通大學(xué),2007.

[2] 暴林超.復(fù)雜目標(biāo)視覺注意模型研究[D].武漢:華中科技大學(xué),2011.

[3] 謝玉林.貝葉斯框架下圖像顯著性檢測(cè)[D]. 大連: 大連理工大學(xué), 2011.

[4] 殷德奎,張保民,柏連發(fā).一種熱圖像的多模板邊緣檢測(cè)方法[J].南京理工大學(xué)學(xué)報(bào),1999,23(1): 16-20.

[5] TREISMAN A,GELADE G. A feature integration theory of attention [J]. Cognitive Psychology, 1980, 12(1): 97-136.

[6] 王岳環(huán),張?zhí)煨?基于視覺注意機(jī)制的實(shí)時(shí)紅外小目標(biāo)預(yù)檢測(cè)[J].華中科技大學(xué)學(xué)報(bào): 自然科學(xué)版,2001,29(6):7-9.

[7] 唐奇伶.基于初級(jí)視皮層感知機(jī)制的輪廓與邊界檢測(cè)[D].武漢:華中科技大學(xué),2007.