張俊俊,何良華

(同濟(jì)大學(xué) 電子與信息工程學(xué)院,上海 201800)

摘要:深度學(xué)習(xí)是一類新興的多層神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)算法,因其緩解了傳統(tǒng)訓(xùn)練算法的局部最小性,故引起機(jī)器學(xué)習(xí)領(lǐng)域的廣泛關(guān)注。但是,如何使一個(gè)網(wǎng)絡(luò)模型在選取任意數(shù)值的隱藏層節(jié)點(diǎn)數(shù)時(shí)都能夠得到一個(gè)比較合適的網(wǎng)絡(luò)結(jié)構(gòu)是目前深度學(xué)習(xí)界普遍存在的一個(gè)開(kāi)放性問(wèn)題。文章提出了一種能夠動(dòng)態(tài)地學(xué)習(xí)模型結(jié)構(gòu)的算法——最大判別能力轉(zhuǎn)換法,根據(jù)Fisher準(zhǔn)則來(lái)評(píng)估隱藏層每一個(gè)節(jié)點(diǎn)的判別性能,然后通過(guò)動(dòng)態(tài)地選擇部分隱層節(jié)點(diǎn)來(lái)構(gòu)建最優(yōu)的模型結(jié)構(gòu)。

關(guān)鍵詞:深度學(xué)習(xí);最大判別能力轉(zhuǎn)換法;Fisher準(zhǔn)則;深度信念網(wǎng)絡(luò)

中圖分類號(hào):TP183文獻(xiàn)標(biāo)識(shí)碼:ADOI: 10.19358/j.issn.1674-7720.2017.01.018

引用格式:張俊俊,何良華. 動(dòng)態(tài)深度信念網(wǎng)絡(luò)模型構(gòu)建[J].微型機(jī)與應(yīng)用,2017,36(1):59-61,65.

0引言

深度學(xué)習(xí)可以讓那些擁有多個(gè)處理層的計(jì)算模型來(lái)學(xué)習(xí)具有多層次抽象的數(shù)據(jù)的表示。這些方法在許多方面都帶來(lái)了顯著的改善,包括最先進(jìn)的語(yǔ)音識(shí)別、視覺(jué)對(duì)象識(shí)別、對(duì)象檢測(cè)和許多其他領(lǐng)域,例如藥物發(fā)現(xiàn)和基因組學(xué)等。

然而,在很多應(yīng)用問(wèn)題中,經(jīng)常會(huì)遇到很高維度的數(shù)據(jù),高維度的數(shù)據(jù)會(huì)造成很多問(wèn)題,例如導(dǎo)致算法運(yùn)行性能以及準(zhǔn)確性的降低。特征選取(Feature Selection)技術(shù)的目標(biāo)是找到原始數(shù)據(jù)維度中的一個(gè)有用的子集,再運(yùn)用一些有效的算法,實(shí)現(xiàn)數(shù)據(jù)的聚類、分類以及檢索等任務(wù)。好的特征可以提供數(shù)據(jù)的語(yǔ)義和結(jié)構(gòu)信息,使簡(jiǎn)單的模型結(jié)構(gòu)也能取得良好的學(xué)習(xí)效果。然而,如何選取恰當(dāng)?shù)奶卣鞑@取一個(gè)準(zhǔn)確的模型結(jié)構(gòu)仍然是深度學(xué)習(xí)模型構(gòu)建的一個(gè)開(kāi)放性問(wèn)題。近年來(lái)很多相關(guān)工作[12]被提出,使得特征選取越來(lái)越多地受到關(guān)注,另外一些關(guān)于數(shù)據(jù)譜分析以及L1正則化模型的研究,也啟發(fā)了特征選取問(wèn)題一些新的工作的開(kāi)展。并且,隨著計(jì)算機(jī)與網(wǎng)絡(luò)的發(fā)展,人們?cè)絹?lái)越多地關(guān)注大規(guī)模數(shù)據(jù)的處理問(wèn)題,使得研究與應(yīng)用能夠真正銜接在一起。傳統(tǒng)的特征選取方法普遍采用依賴于經(jīng)驗(yàn)或者模型參數(shù)的調(diào)整,例如dropout[3]、dropconnect[4]等。這些方法都要求在模型使用的初始時(shí)結(jié)構(gòu)就必須確定下來(lái),并在模型的整個(gè)訓(xùn)練過(guò)程中結(jié)構(gòu)都不再發(fā)生變化。這在一定程度上限制了模型的表達(dá)能力。

基于此,本文提出一種能夠動(dòng)態(tài)地學(xué)習(xí)模型結(jié)構(gòu)的算法——最大判別能力轉(zhuǎn)換法,來(lái)根據(jù)Fisher準(zhǔn)則評(píng)估隱藏層每一個(gè)節(jié)點(diǎn)的判別性能,然后通過(guò)動(dòng)態(tài)地選擇部分隱層節(jié)點(diǎn)來(lái)構(gòu)建最優(yōu)的模型結(jié)構(gòu)。其中,對(duì)于隱藏層節(jié)點(diǎn)數(shù)目的選取是通過(guò)考慮模型計(jì)算復(fù)雜度以及信息保留程度權(quán)衡后的計(jì)算結(jié)果。

1深度信念網(wǎng)絡(luò)

深度學(xué)習(xí)是具有多層隱藏層的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),這種網(wǎng)絡(luò)具有更好的學(xué)習(xí)特征的能力,對(duì)原始特征具有更本質(zhì)的描述,從而更利于可視化或分類。其中,深度信念網(wǎng)絡(luò)[5](Deep Belief Network, DBN)是比較具有代表性的模型之一,也是最簡(jiǎn)單的深度學(xué)習(xí)模型。為了有效克服深度神經(jīng)網(wǎng)絡(luò)在訓(xùn)練上的難度,其采用了無(wú)監(jiān)督貪婪學(xué)習(xí)的逐層初始化方式(即BP算法)。

深度信念網(wǎng)絡(luò)是一種生成型概率模型,是由多個(gè)限制玻爾茲曼機(jī)(Restricted Boltzmann Machine,RBM)堆疊組成的層次結(jié)構(gòu)。

DBN是通過(guò)堆疊RBMs而成,如圖1所示,使用輸入樣本觀測(cè)值作為第一層RBM的輸入,將由輸入訓(xùn)練出的輸出作為第二層RBM的輸入,以此類推,通過(guò)疊加RBM模型完成深度模型的構(gòu)建。

RBM訓(xùn)練模式受物理學(xué)的能量模型啟發(fā),事物在能量最低時(shí)所處的狀態(tài)是最穩(wěn)定的,于是構(gòu)建RBM的穩(wěn)態(tài)就成了狀態(tài)優(yōu)化的問(wèn)題,這一問(wèn)題可以進(jìn)一步轉(zhuǎn)化為求極值與優(yōu)化的問(wèn)題。對(duì)于圖1所示的RBM模型,假設(shè)輸入層節(jié)點(diǎn)為v,隱藏層輸出節(jié)點(diǎn)為h,輸入輸出層之間的權(quán)重為w,那么輸入層向量v與輸出層向量h之間的能量函數(shù)E為:

![G]BW9Z@452B(WY`%~OZKD@6.png G]BW9Z@452B(WY`%~OZKD@6.png](http://files.chinaaet.com/images/2017/03/02/6362407579082933037586464.png)

其中,a、b分別為對(duì)應(yīng)可視層和隱藏層的偏移,V、H分別表示可視層和隱藏層的節(jié)點(diǎn)數(shù)。那么,由能量函數(shù)得到可視層v與隱藏層h之間聯(lián)合函數(shù)為:

![}QNJ}TX75V]56VT46ZO0Y9G.png }QNJ}TX75V]56VT46ZO0Y9G.png](http://files.chinaaet.com/images/2017/03/02/6362407579367328369492930.png)

其中尖括號(hào)的運(yùn)算表示相對(duì)于下標(biāo)的預(yù)期分布內(nèi)積,由此,log似然函數(shù)梯度權(quán)重的更新規(guī)則如下:

Δwij=ε(<vihj>data-<vihj>model)(8)

其中ε表示學(xué)習(xí)率。然而上式中計(jì)算后一項(xiàng)需要花費(fèi)很多額外的時(shí)間,為了減小這種額外花費(fèi),對(duì)比散度(Contrastive Divergence)方法被用來(lái)計(jì)算梯度,所以新的更新規(guī)則如下:

Δwij=ε(<vihj>data-<vihj>recon)(9)

后一項(xiàng)表明了重構(gòu)后的可視層與隱藏層的期望值,實(shí)踐證明該方法得到充分應(yīng)用后具有良好的特性。相比于傳統(tǒng)的Sigmod信度網(wǎng)絡(luò),通過(guò)以上方式學(xué)習(xí)的RBM具有權(quán)值容易學(xué)習(xí)的優(yōu)點(diǎn)。

深度學(xué)習(xí)是具有多層隱藏層的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),這種網(wǎng)絡(luò)具有更好的學(xué)習(xí)特征的能力,對(duì)原始特征具有更本質(zhì)的描述,從而更利于可視化或分類。為了有效克服深度神經(jīng)網(wǎng)絡(luò)在訓(xùn)練上的難度,采用了無(wú)監(jiān)督貪婪學(xué)習(xí)的逐層初始化方式。深度信念網(wǎng)是其中比較具有代表性的模型之一,也是最簡(jiǎn)單的深度學(xué)習(xí)模型。

2結(jié)構(gòu)計(jì)算

每一個(gè)隱藏層節(jié)點(diǎn)代表了映射空間中的一個(gè)維度,將可視層映射到隱藏層的過(guò)程就類似于一種空間變換,也就是把源數(shù)據(jù)轉(zhuǎn)換到了一個(gè)更加容易區(qū)分的新的映射空間。然而,這種空間變換的方式,例如:PCA、ICA、LDA等,所產(chǎn)生的各個(gè)維度在不同的空間中有不同的判別能力。

故本文基于Fisher準(zhǔn)則[6],評(píng)估每個(gè)節(jié)點(diǎn)的判別能力,然后根據(jù)最大判別能力轉(zhuǎn)換法選取部分隱藏層節(jié)點(diǎn)來(lái)構(gòu)成新的映射空間,剔除冗余或者對(duì)判別能力產(chǎn)生副作用的投影維度,來(lái)提高此投影空間判別性能。

2.1節(jié)點(diǎn)評(píng)估

Fisher準(zhǔn)則函數(shù)通過(guò)計(jì)算每個(gè)節(jié)點(diǎn)的類間與類內(nèi)的比值來(lái)確定其在此投影空間中每個(gè)維度的判別能力。

定義數(shù)據(jù)集中共有N個(gè)樣本屬于C類,每一類分別包含Nc個(gè)樣本,uc、u分別表示樣本Xc在第c類的均值以及所有樣本的均值。第j個(gè)特征的Fisher的值表示為:

2.2最具判別能力轉(zhuǎn)換法

Fisher準(zhǔn)則僅僅能夠判別每個(gè)特征的判別性能,卻無(wú)法計(jì)算每層隱藏層具體多少個(gè)節(jié)點(diǎn)能夠獲取最大的描述能力以及判別能力。本文基于能夠最大程度縮減原始高維輸入樣本與重構(gòu)后的輸入樣本之間的誤差來(lái)提取部分特征,以此來(lái)提高模型的整體判別性能。

誤差計(jì)算方式如下:

![23~D{551K6YZ]G`F{3`EJWE.png 23~D{551K6YZ]G`F{3`EJWE.png](http://files.chinaaet.com/images/2017/03/02/6362407583311358855718131.png)

其中,xi是原始的輸入樣本,hjWji是重構(gòu)后的輸入樣本。

W*=argminWR(14)

3實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)從兩方面來(lái)驗(yàn)證最具判別能力轉(zhuǎn)換法(MDT)的有效性以及可行性。第一個(gè)實(shí)驗(yàn)基于Iris數(shù)據(jù)庫(kù),通過(guò)對(duì)比Laplacian Score[7]方法與Data variance方法來(lái)驗(yàn)證Fisher Score方法的優(yōu)越性能;第二個(gè)實(shí)驗(yàn)是基于Mnist數(shù)據(jù)庫(kù)來(lái)評(píng)估MDT算法。

3.1Iris數(shù)據(jù)庫(kù)

Iris數(shù)據(jù)庫(kù)也稱鳶尾花卉數(shù)據(jù)集,是一類多重變量分析的數(shù)據(jù)集。數(shù)據(jù)庫(kù)包含150個(gè)數(shù)據(jù)集,分為3類,每類50個(gè)數(shù)據(jù),每個(gè)數(shù)據(jù)包含4個(gè)屬性(F1:sepal length;F2:sepal width;F3:petal length;F4:petal width)。大量研究證明對(duì)分類起顯著作用的屬性為F3與F4。

Data variance方法被認(rèn)為是最簡(jiǎn)單的無(wú)監(jiān)督分類算法,它可以作為一種對(duì)特征選擇與提取的標(biāo)準(zhǔn)之一,另一種標(biāo)準(zhǔn)是Laplacian Score,它是根據(jù)Laplacian Eigenmaps與Locality reserving Projection來(lái)評(píng)判的。實(shí)驗(yàn)結(jié)果如圖2所示。

圖2顯示,根據(jù)Data variance標(biāo)準(zhǔn),特征排序?yàn)椋篎3,F(xiàn)4,F(xiàn)1,F(xiàn)2;根據(jù)Laplacian Score排序結(jié)果為:F4,F(xiàn)3,F(xiàn)1,F(xiàn)2;而根據(jù)Fisher Score排序結(jié)果為:F3,F(xiàn)4,F(xiàn)1,F(xiàn)2。由此可知,F(xiàn)isher Score能夠?qū)崿F(xiàn)比較好的特征評(píng)估。

3.2Mnist數(shù)據(jù)庫(kù)

Mnist數(shù)據(jù)庫(kù)包含有60 000個(gè)訓(xùn)練樣本和10 000個(gè)測(cè)試樣本,每個(gè)樣本大小為28×28,共分為10類。

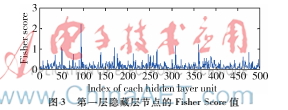

本實(shí)驗(yàn)通過(guò)對(duì)比深度信念網(wǎng)絡(luò)(DBN)不同隱層節(jié)點(diǎn)數(shù)目發(fā)現(xiàn),當(dāng)?shù)谝浑[層節(jié)點(diǎn)為500、第二隱層節(jié)點(diǎn)為2 000時(shí),模型訓(xùn)練效果最好,誤差最低,結(jié)果如表1表示。基于該最優(yōu)結(jié)構(gòu),我們希望MDT算法能夠進(jìn)一步降低模型分類誤差。首先計(jì)算出第一層隱藏層中每一個(gè)節(jié)點(diǎn)的Fisher Score值,如圖3所示。

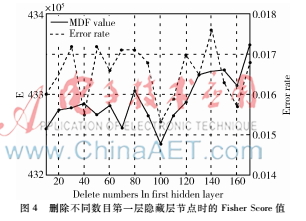

然后,圖4展示了依次刪除第一層隱藏層不同節(jié)點(diǎn)數(shù)目后模型的錯(cuò)誤率以及MDF值。最后,發(fā)現(xiàn)刪除100個(gè)節(jié)點(diǎn)時(shí),MDF值最小并且模型的錯(cuò)誤率也達(dá)到最小。

4結(jié)論

本文提出了一種新穎的構(gòu)建DBN模型結(jié)構(gòu)的算法,其基于Fisher準(zhǔn)則以及最大判別能力轉(zhuǎn)換法來(lái)動(dòng)態(tài)地刪除隱層節(jié)點(diǎn)以達(dá)到優(yōu)化結(jié)構(gòu)的目的,不同于現(xiàn)有的各種針對(duì)DBN模型所做的規(guī)則化算法。基于多個(gè)數(shù)據(jù)庫(kù)的實(shí)驗(yàn)結(jié)果也證實(shí)了本算法確定能夠獲得比較好的隱層節(jié)點(diǎn)數(shù)目。

參考文獻(xiàn)

[1] HINTON G E,SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786):504-507.

[2] SALAKHUTDINV R, HINTON G. Semantic hashing[J]. International Journal of Approximate Reasoning, 2009, 50(7):969-978.

[3] HINTON G E, SRIVASTAVA N,KRIZHEVSKY A, et al. Improving neural networks by preventing coadaptation of feature detectors[J]. Computer Science, 2012, 3(4):212-223.

[4] SRIVASTAVA N. Improving neural networks with dropout[J]. Journal of Chemical Information and Modeling, 2015, 53(9):1689-1699.

[5] HINTON G E,OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 1960, 18(7):1527-1554.