進(jìn)入到2020年,自動(dòng)駕駛技術(shù)走到了需要規(guī)模商業(yè)化證明技術(shù)價(jià)值的時(shí)候。

不管是封閉或半封閉場(chǎng)景的礦區(qū)、港口和園區(qū),還是公開(kāi)道路的RoboTaxi、RoboTruck等,技術(shù)都是自動(dòng)駕駛在不同場(chǎng)景商業(yè)化的基礎(chǔ)。

本報(bào)告覆蓋了自動(dòng)駕駛汽車所需要的感知、定圖與定位、傳感器融合、機(jī)器學(xué)習(xí)方法、數(shù)據(jù)收集與處理、路徑規(guī)劃、自動(dòng)駕駛架構(gòu)、乘客體驗(yàn)、自動(dòng)駕駛車輛與外界交互、自動(dòng)駕駛對(duì)汽車部件的挑戰(zhàn)(如功耗、尺寸、重量等)、通訊與連接(車路協(xié)同、云端管理平臺(tái))等技術(shù)領(lǐng)域的討論,并且提供相應(yīng)的各自動(dòng)駕駛公司的實(shí)施案例。

本報(bào)告是由美國(guó)、中國(guó)、以色列、加拿大、英國(guó)等全球不同國(guó)家和地區(qū)的自動(dòng)駕駛專家,針對(duì)自動(dòng)駕駛技術(shù)的硬件和軟件技術(shù),進(jìn)行的全面闡述,方便各位讀者能夠從技術(shù)角度,了解最新的技術(shù)動(dòng)態(tài),從而全面了解自動(dòng)駕駛汽車。

本報(bào)告的案例大多數(shù)來(lái)自汽車領(lǐng)域,這也是目前自動(dòng)駕駛行業(yè)最火熱的應(yīng)用場(chǎng)景,但是,服務(wù)個(gè)人出行的汽車并不是自動(dòng)駕駛技術(shù)影響深遠(yuǎn)的行業(yè),其他的行業(yè),如公共交通、貨運(yùn)、農(nóng)業(yè)、礦業(yè)等領(lǐng)域,也同樣是自動(dòng)駕駛技術(shù)應(yīng)用的廣泛天地。

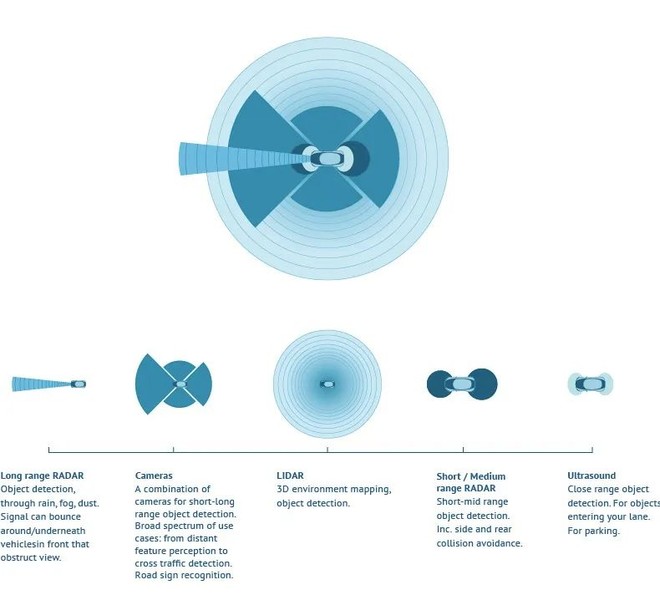

01 各類傳感器

各類傳感器,用于自動(dòng)駕駛汽車感知環(huán)境,如同人類的眼睛,自動(dòng)駕駛汽車的基礎(chǔ)部件;自動(dòng)駕駛汽車的傳感器主要有五種,包括了:1、Long range RADAR;2、Camera;3、LIDAR;4、Short/Medium range RADAR;5、Ultrasound;

這些不同的傳感器,主要用于不同距離、不同類型的物體感知,為自動(dòng)駕駛汽車判斷周邊環(huán)境,提供最重要的信息來(lái)源,另外,還有一個(gè)環(huán)境感知的信息來(lái)源是車路協(xié)同的來(lái)源,這點(diǎn)報(bào)告中也有闡述。

關(guān)于傳感器的選擇,主要是根據(jù)下面的技術(shù)因素進(jìn)行判斷:

1、掃描范圍,確定必須對(duì)被感測(cè)的對(duì)象做出反應(yīng)的時(shí)間;

2、分辨率,確定傳感器可以為自動(dòng)駕駛車輛提供的環(huán)境細(xì)節(jié);

3、視場(chǎng)或角度分辨率,確定要覆蓋、要感知的區(qū)域需要傳感器的數(shù)量;

4、刷新率,確定來(lái)自傳感器的信息更新的頻率;

5、感知對(duì)象數(shù)量,能夠區(qū)分3D中的靜態(tài)對(duì)象數(shù)量和動(dòng)態(tài)對(duì)象數(shù)量,并且確定需要跟蹤的對(duì)象數(shù)量;

6、可靠性和準(zhǔn)確性,傳感器在不同環(huán)境下的總體可靠性和準(zhǔn)確性;

7、成本、大小和軟件兼容性,這是量產(chǎn)的技術(shù)條件之一;

8、生成的數(shù)據(jù)量,這決定了車載計(jì)算單元的計(jì)算量,現(xiàn)在傳感器偏向智能傳感器,也就是,不僅僅是感知,還會(huì)分辨信息,把對(duì)車輛行駛影響最重要的數(shù)據(jù)傳輸給車載計(jì)算單元,從而減少其計(jì)算負(fù)荷;

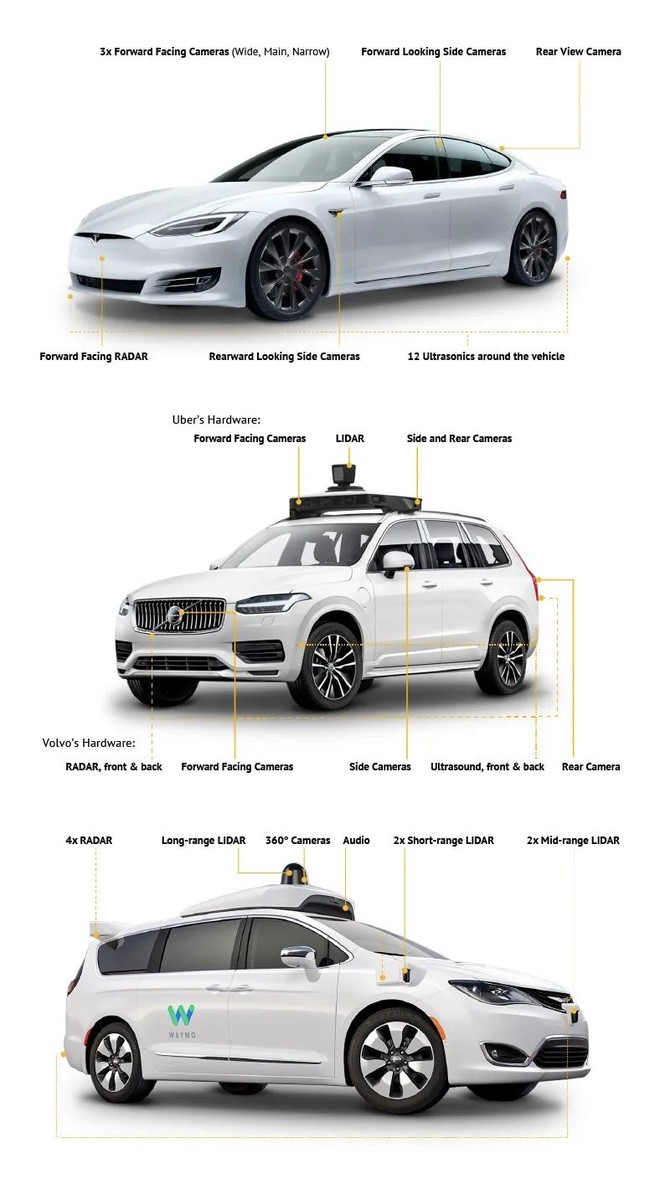

下面是Waymo、Volvo-Uber、Tesla的傳感器方案示意圖:

傳感器因?yàn)橐恢北┞对诃h(huán)境中,容易受到環(huán)境的污染,從而影響傳感器的工作效率,所以,都需要對(duì)傳感器進(jìn)行清潔。

1、Tesla的傳感器,具有加熱功能,可抵御霜凍和霧氣;

2、Volvo的傳感器配備有噴水清潔系統(tǒng),用于清潔粉塵;

3、Waymo使用的Chrysler Pacifica的傳感器有噴水系統(tǒng)和刮水器。

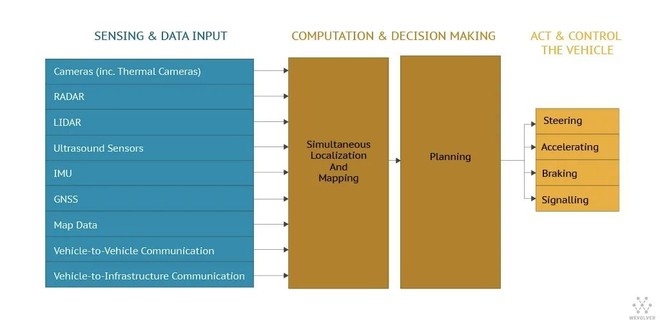

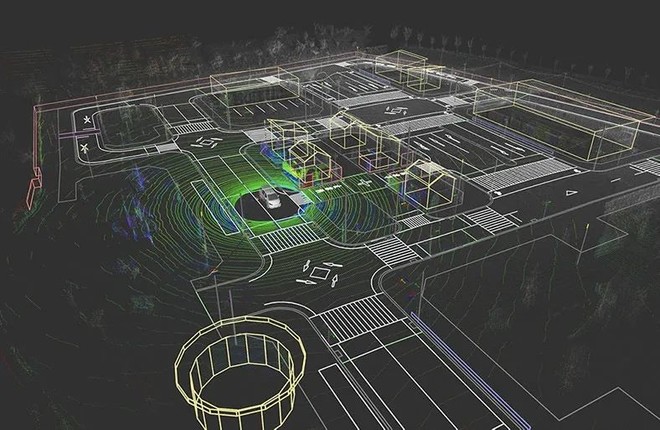

02 SLAM和傳感器融合

SLAM是一個(gè)復(fù)雜的過(guò)程,因?yàn)楸镜鼗枰貓D,并且映射需要良好的位置估計(jì)。盡管長(zhǎng)期以來(lái)人們一直認(rèn)為機(jī)器人要成為自主的基本“雞或蛋”問(wèn)題,但在1980年代和90年代中期的突破性研究從概念和理論上解決了SLAM。從那時(shí)起,已經(jīng)開(kāi)發(fā)了多種SLAM方法,其中大多數(shù)使用概率概念。

為了更準(zhǔn)確地執(zhí)行SLAM,傳感器融合開(kāi)始發(fā)揮作用。傳感器融合是組合來(lái)自多個(gè)傳感器和數(shù)據(jù)庫(kù)的數(shù)據(jù)以獲得改進(jìn)信息的過(guò)程。它是一個(gè)多級(jí)過(guò)程,處理數(shù)據(jù)的關(guān)聯(lián),相關(guān)性和組合,與僅使用單個(gè)數(shù)據(jù)源相比,可以實(shí)現(xiàn)更便宜,更高質(zhì)量或更多相關(guān)信息。

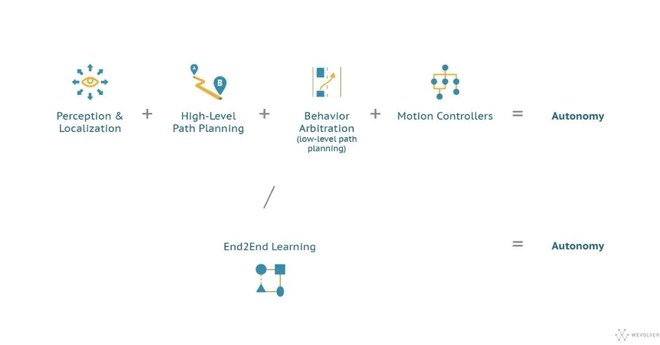

對(duì)于從傳感器數(shù)據(jù)到運(yùn)動(dòng)所需的所有處理和決策,通常使用兩種不同的AI方法:

1、順序地,將驅(qū)動(dòng)過(guò)程分解為分層管道的組件,每個(gè)步驟(傳感,定位,路徑規(guī)劃,運(yùn)動(dòng)控制)都由特定的軟件元素處理,管道的每個(gè)組件都將數(shù)據(jù)饋送到下一個(gè);

2、基于深度學(xué)習(xí)的端到端解決方案,負(fù)責(zé)所有這些功能。

哪種方法最適合AV的問(wèn)題是不斷爭(zhēng)論的領(lǐng)域。傳統(tǒng)且最常見(jiàn)的方法包括將自動(dòng)駕駛問(wèn)題分解為多個(gè)子問(wèn)題,并使用專用的機(jī)器學(xué)習(xí)算法技術(shù)依次解決每個(gè)子問(wèn)題,這些算法包括計(jì)算機(jī)視覺(jué),傳感器融合,定位,控制理論和路徑規(guī)劃。

端到端(e2e)學(xué)習(xí)作為一種解決方案,可以解決自動(dòng)駕駛汽車復(fù)雜AI系統(tǒng)所面臨的挑戰(zhàn),因此越來(lái)越受到人們的關(guān)注。端到端(e2e)學(xué)習(xí)將迭代學(xué)習(xí)應(yīng)用于整個(gè)復(fù)雜系統(tǒng),并已在深度學(xué)習(xí)的背景下得到普及。

03 三種機(jī)器深度學(xué)習(xí)方法

當(dāng)前,不同類型的機(jī)器學(xué)習(xí)算法被用于自動(dòng)駕駛汽車中的不同應(yīng)用。本質(zhì)上,機(jī)器學(xué)習(xí)根據(jù)提供的一組訓(xùn)練數(shù)據(jù)將一組輸入映射到一組輸出。1、卷積神經(jīng)網(wǎng)絡(luò)(CNN);2、遞歸神經(jīng)網(wǎng)絡(luò)(RNN);3、深度強(qiáng)化學(xué)習(xí)(DRL);是應(yīng)用于自動(dòng)駕駛的最常見(jiàn)的深度學(xué)習(xí)方法。

CNN——主要用于處理圖像和空間信息,以提取感興趣的特征并識(shí)別環(huán)境中的對(duì)象。這些神經(jīng)網(wǎng)絡(luò)由卷積層組成:卷積過(guò)濾器的集合,它們?cè)噲D區(qū)分圖像元素或輸入數(shù)據(jù)以對(duì)其進(jìn)行標(biāo)記。該卷積層的輸出被饋送到一種算法中,該算法將它們組合起來(lái)以預(yù)測(cè)圖像的最佳描述。最終的軟件組件通常稱為對(duì)象分類器,因?yàn)樗梢詫?duì)圖像中的對(duì)象進(jìn)行分類,例如路牌或其他汽車。

RNN——當(dāng)處理諸如視頻之類的時(shí)間信息時(shí),RNN是強(qiáng)大的工具。在這些網(wǎng)絡(luò)中,先前步驟的輸出作為輸入被饋送到網(wǎng)絡(luò)中,從而使信息和知識(shí)能夠持久存在于網(wǎng)絡(luò)中并被上下文化。

DRL——將深度學(xué)習(xí)(DL)和強(qiáng)化學(xué)習(xí)相結(jié)合。DRL方法使軟件定義的“代理”可以使用獎(jiǎng)勵(lì)功能,在虛擬環(huán)境中學(xué)習(xí)最佳行動(dòng),以實(shí)現(xiàn)其目標(biāo)。這些面向目標(biāo)的算法學(xué)習(xí)如何實(shí)現(xiàn)目標(biāo),或如何在多個(gè)步驟中沿特定維度最大化。盡管前景廣闊,但DRL面臨的挑戰(zhàn)是設(shè)計(jì)用于駕駛車輛的正確獎(jiǎng)勵(lì)功能。在自動(dòng)駕駛汽車中,深度強(qiáng)化學(xué)習(xí)被認(rèn)為仍處于早期階段。

這些方法不一定孤立地存在。例如,特斯拉(Tesla)等公司依靠混合形式,它們?cè)噲D一起使用多種方法來(lái)提高準(zhǔn)確性并減少計(jì)算需求。

一次在多個(gè)任務(wù)上訓(xùn)練網(wǎng)絡(luò)是深度學(xué)習(xí)中的常見(jiàn)做法,通常稱為多任務(wù)訓(xùn)練 或輔助任務(wù)訓(xùn)練。這是為了避免過(guò)度擬合,這是神經(jīng)網(wǎng)絡(luò)的常見(jiàn)問(wèn)題。當(dāng)機(jī)器學(xué)習(xí)算法針對(duì)特定任務(wù)進(jìn)行訓(xùn)練時(shí),它會(huì)變得非常專注于模仿它所訓(xùn)練的數(shù)據(jù),從而在嘗試進(jìn)行內(nèi)插或外推時(shí)其輸出變得不切實(shí)際。

通過(guò)在多個(gè)任務(wù)上訓(xùn)練機(jī)器學(xué)習(xí)算法,網(wǎng)絡(luò)的核心將專注于發(fā)現(xiàn)對(duì)所有目的都有用的常規(guī)功能,而不是僅僅專注于一項(xiàng)任務(wù)。這可以使輸出對(duì)應(yīng)用程序更加現(xiàn)實(shí)和有用。