Google 今天分享了有關(guān)其TPU芯片的新版本的早期細(xì)節(jié),據(jù)介紹,該芯片用于運(yùn)行人工智能工作負(fù)載,其性能是前一代的兩倍以上。

Google的TPU(即Tensor處理器單元)是專(zhuān)門(mén)針對(duì)AI設(shè)計(jì)的專(zhuān)用集成電路。搜索巨頭今天詳細(xì)介紹的新的TPU模型是該芯片的第四次迭代。通過(guò)Google Cloud Platform,企業(yè)可以使用第三次和第二次迭代,這兩者也展示了出色的性能。

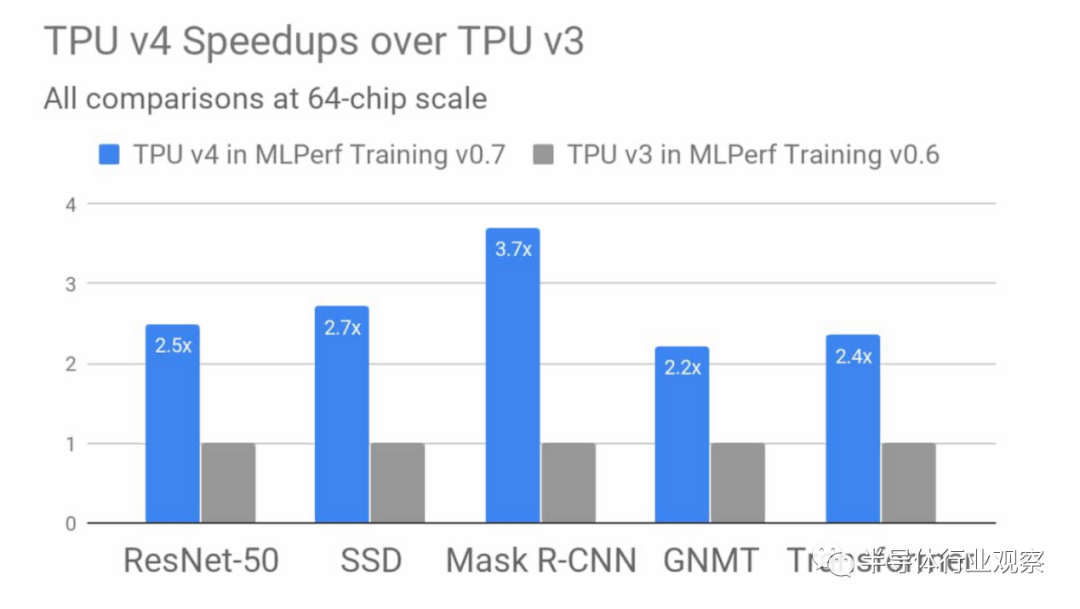

谷歌表示,其第四代TPU的平均性能比其第三代TPU高出2.7倍。這家搜索巨頭通過(guò)在最近的MLPerf行業(yè)競(jìng)賽中衡量他們訓(xùn)練五個(gè)流行的AI模型的速度來(lái)比較這些芯片。第四代TPU在運(yùn)行Mask R-CNN模型時(shí)獲得了最強(qiáng)的效果,Mask R-CNN模型是用于自動(dòng)駕駛等用例的圖像分割A(yù)I,其訓(xùn)練速度比Google的早期芯片快3.7倍。

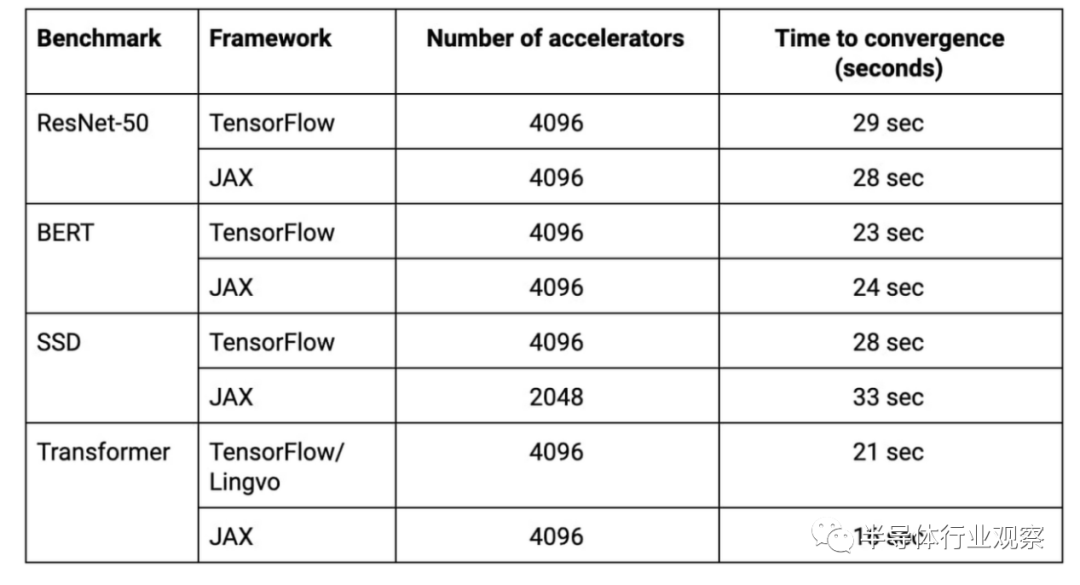

Google指出,他們?cè)诒敬蜯LPerf訓(xùn)練回合中使用的超級(jí)計(jì)算機(jī)是Cloud TPU v3 Pod的四倍,后者在之前的比賽中創(chuàng)造了三項(xiàng)記錄。該系統(tǒng)包括4096個(gè)TPU v3芯片和數(shù)百個(gè)CPU主機(jī),所有這些都通過(guò)超快速,超大規(guī)模的定制互連進(jìn)行連接。該系統(tǒng)總共可提供430多個(gè)PFLOP峰值性能。

性能的提高是設(shè)計(jì)重大變化的結(jié)果。谷歌工程師Naveen Kumar在博客中詳細(xì)介紹了該公司已大大提高了TPU的內(nèi)存帶寬,即芯片從內(nèi)存中獲取數(shù)據(jù)進(jìn)行處理的速度,并提高了其執(zhí)行專(zhuān)門(mén)計(jì)算的能力。

“Google的第四代TPU ASIC提供了TPU v3的矩陣乘法TFLOP的兩倍以上性能,” Kumar在帖子中詳細(xì)介紹。矩陣乘法是AI模型用來(lái)處理數(shù)據(jù)的一種數(shù)學(xué)運(yùn)算,而TFLOP是每秒一萬(wàn)億個(gè)浮點(diǎn)運(yùn)算。相比之下,與新芯片進(jìn)行比較的第三代TPU v3 每秒可管理420萬(wàn)億次操作。

Kumar寫(xiě)道,客戶(hù)可以很快獲得有關(guān)新TPU的更多信息。鑒于該平臺(tái)上已有兩個(gè)上一代TPU可供租用,該芯片很有可能最終登陸Google Cloud。但是,客戶(hù)可能需要等待一會(huì)兒:ExtremeTech 報(bào)告說(shuō),第四代TPU在MLPerf競(jìng)賽期間被列為研究類(lèi)別,這意味著它將在至少六個(gè)月內(nèi)無(wú)法商用。

新芯片的速度提升尤其引人注目,因?yàn)槠湫阅軆?yōu)于第三代的芯片在同一比賽中打破了多項(xiàng)記錄。谷歌使用了4,090個(gè)第三代TPU來(lái)構(gòu)建其所謂的世界上最快的AI培訓(xùn)超級(jí)計(jì)算機(jī)。該系統(tǒng)為MLPerf八個(gè)基準(zhǔn)中的六個(gè)基準(zhǔn)創(chuàng)造了新記錄,并在30秒內(nèi)訓(xùn)練了四個(gè)測(cè)試模型。