最近,人工智能領(lǐng)域權(quán)威跑分榜單MLPerf更新了1.1版,主要針對云端和邊緣端的推理性能。

MLPerf是由ML Commons推出的性能測試榜單。在人工智能技術(shù)發(fā)展迅速的今天,不同的針對人工智能加速的芯片也是層出不窮,于是如何能有一個較好的標(biāo)準(zhǔn)跑分(benchmark)平臺就很重要,有了這樣的平臺,用戶才能以較為公平和合理的方式去比較不同芯片的人工智能性能。具體來說,MLPerf對于不同的測試組別(訓(xùn)練,服務(wù)器推理,終端推理等)提供了一系列標(biāo)準(zhǔn)的測試網(wǎng)絡(luò),并且由各個硬件公司上傳可驗證的跑分結(jié)果,這些結(jié)果在經(jīng)過驗證后,就由ML Commons總結(jié)整理并上傳到MLPerf的榜單上。

這次公布的MLPerf 1.1榜單中,基本可以分為幾大勢力:首先,是以Nvidia的GPU為核心加速卡的方案,由各種不同的廠商(包括Nvidia自己,以及超微、聯(lián)想、戴爾、HP等整機廠商)實現(xiàn)的整機去跑分;其次是高通的云端加速卡方案,由高通自己提交跑分結(jié)果;第三類是Intel的CPU方案;第四類則是一些初創(chuàng)公司的方案。因此,在MLPerf 1.1的結(jié)果中,我們認(rèn)為最值得關(guān)注的,就是高通與Nvidia之間的競爭。事實上,在一些測評項目中,高通的方案已經(jīng)實現(xiàn)了比Nvidia更高的結(jié)果,這也說明在服務(wù)器推理市場,Nvidia遇到了一個強力的競爭對手,未來無法再高枕無憂。

MLPerf:高通與Nvidia的競爭

目前,Nvidia這一代的主要人工智能加速方案包括A100和A30。其中,A100是Nvidia的旗艦級GPU,同時針對推理和訓(xùn)練市場,算力高達(dá)600 TOPS (INT8精度),其功耗則根據(jù)使用內(nèi)存的區(qū)別從250W-400W不等。

另一方面,A30則是Nvidia主要針對推理市場的GPU產(chǎn)品,其INT8峰值算力可達(dá)330 TOPS,約為A100的一半,而Nvidia在其官方資料中稱A30在運行機器學(xué)習(xí)算法時的實際性能約為A100的三分之二。功耗方面,A30的最大功耗約為165W。

在高通方面,Cloud AI 100芯片于今年上半年正式發(fā)貨,其INT8最大算力可達(dá)400 TOPS,最大功耗(PCIe版本)則75W。根據(jù)高通公布的資料,其設(shè)計采用了多核架構(gòu),每個AI Core上擁有8MB的SRAM,最多在芯片上可以集成16個AI Core,并且這些AI Core會共享LPDDR4X DRAM,以及PCIe接口。值得注意的是,高通的Cloud AI 100并沒有像Nvidia一樣使用HBM2內(nèi)存接口,而是使用了功耗和帶寬都更低的LPDDR4X接口,這意味著高通需要能更好地管理內(nèi)存才能擺脫其在內(nèi)存帶寬方面的劣勢。

高通Cloud AI 100架構(gòu)

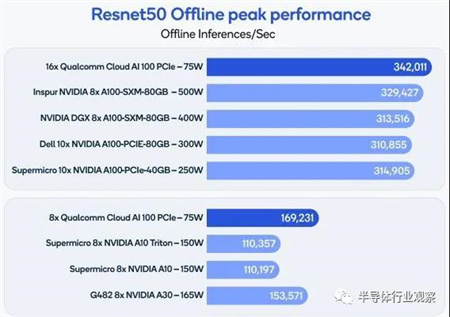

在MLPerf 1.1中,高通的表現(xiàn)可圈可點。在推理分類下的各項目中,高通提交了ResNet 50(用于圖像分類),SSD(用于物體檢測)以及BERT(用于自然語言處理任務(wù))的結(jié)果。在ResNet 50的結(jié)果中,高通裝有16塊75W Cloud AI 100 加速卡的主機可以實現(xiàn)每秒342011次推理,而Nvidia提交的DGX主機結(jié)果中(包含8塊400W的A100 GPU),ResNet 50的推理吞吐量為每秒313516次推理,因此高通不僅推理吞吐量比Nvidia的旗艦GPU A100結(jié)果高了10%,而且總功耗僅為Nvidia方案的三分之一左右。在和Nvidia A30的對比中,高通的Cloud AI 100同樣可以以A30一半左右的功耗實現(xiàn)比A30高10%左右的ResNet 50推理吞吐量。

另一方面,在目標(biāo)檢測SSD方面,高通16X Cloud AI 100的性能則比Nvidia 8X A100低了10%左右。而在自然語言BERT項目中,高通16X Cloud AI 100的性能則大約是Nvidia 8X A100的一半。這些結(jié)果表明,在主流機器視覺任務(wù)中,高通的16X Cloud AI 100已經(jīng)能實現(xiàn)和Nvidia 8X A100基本相同甚至更好的性能,而在BERT等自然語言處理任務(wù)中,Cloud AI 100則仍然距離A100有相當(dāng)?shù)牟罹唷_@其實從高通Cloud AI 100的設(shè)計中也可以看出端倪,它使用8MB每核心的片上內(nèi)存搭配LPDDR4X內(nèi)存接口,在模型較小的機器視覺任務(wù)(例如ResNet-50和SSD)中已經(jīng)夠用,內(nèi)存不會成為其瓶頸;然而對于模型較大的自然語言處理模型如BERT中,LPDDR4X接口仍然成為了高通AI Cloud 100的瓶頸,而使用HBM2系列接口的Nvidia A100則有優(yōu)勢。

推理市場中,高通對Nvidia會造成威脅嗎

如前所述,高通的Cloud AI 100在機器視覺任務(wù)中都能以更低的功耗實現(xiàn)和Nvidia A100方案接近,或比A30更高的性能。雖然Cloud AI 100在自然語言處理方面離Nvidia A100方案的性能有一些差距(能效比上仍然是Cloud AI 100更好),但是目前在推理方面,事實上機器視覺已經(jīng)是一塊巨大的市場,因此高通在這個領(lǐng)域有可能會成為強而有力的競爭者。

如果我們細(xì)數(shù)機器視覺領(lǐng)域?qū)τ谕评硇阅苡休^強需求的領(lǐng)域,首當(dāng)其沖的可能就是自動和輔助駕駛領(lǐng)域。在自動和輔助駕駛領(lǐng)域,需要大量的目標(biāo)檢測,這就需要大量的機器視覺算力支持。高通的Cloud AI 100擁有更好的能效比和相當(dāng)?shù)男阅埽由掀涑杀绢A(yù)計會遠(yuǎn)遠(yuǎn)低于基于HBM2內(nèi)存的A100 GPU,因此可能會與Nvidia在這個領(lǐng)域有激烈的競爭。自動駕駛領(lǐng)域擁有較高的質(zhì)控和渠道壁壘,而高通作為在半導(dǎo)體供應(yīng)鏈中已經(jīng)有非常深厚積累的巨頭,在這個領(lǐng)域顯然要比其他做自動駕駛芯片的初創(chuàng)公司更有競爭力,因此可能會給這個領(lǐng)域帶來新的市場格局。當(dāng)然,在自動駕駛領(lǐng)域高通即使能戰(zhàn)勝Nvidia,也不代表高通能占領(lǐng)整個自動駕駛市場:隨著目前各大智能駕駛公司都紛紛開始自研芯片,未來自動駕駛市場中究竟是第三方芯片方案還是第一方芯片方案更是主流,仍然有待觀察。

除了智能駕駛之外,另一個重要的推理市場是智能終端,例如工業(yè)機器人和智能攝像頭。這些領(lǐng)域?qū)τ诠暮湍苄П榷加休^強的需求。高通顯然在設(shè)計芯片的時候?qū)⑦@些市場納入了考慮,因此Cloud AI 100除了功耗75W,400TOPS算力的PCIe版本之外,還有功耗15W,算力70 TOPS和功耗25W,算力200 TOPS的低功耗版本,這些版本非常適合工業(yè)機器人和智能攝像頭應(yīng)用。而Nvidia同樣針對該市場的Xavier系列芯片的能效比則遠(yuǎn)遜于Cloud AI 100,因此高通在這個領(lǐng)域也有優(yōu)勢。

當(dāng)然,高通即使能在競爭中勝過Nvidia,也未必能真正主導(dǎo)這個市場。人工智能推理的一大市場,即中國市場,在國際形勢和國內(nèi)對于半導(dǎo)體產(chǎn)業(yè)大力扶持的背景下,究竟會使用外國公司的方案,還是使用國內(nèi)公司的方案,對于高通究竟能在這個市場中占有多大份額也有很大影響。

訓(xùn)練市場如何戰(zhàn)勝Nvidia

在人工智能訓(xùn)練市場,從MLPerf早些公布的訓(xùn)練跑分結(jié)果我們可以看到,Nvidia的單卡性能仍然遠(yuǎn)遠(yuǎn)領(lǐng)先Graphcore,Habana等競爭對手。另外,高通似乎目前尚沒有公布在這個領(lǐng)域的計劃。然而,在分布式訓(xùn)練結(jié)果中,我們可以看到Nvidia的訓(xùn)練跑分結(jié)果和谷歌的TPU類似。分布式訓(xùn)練結(jié)果主要考慮如何通過大規(guī)模的分布式計算來實現(xiàn)訓(xùn)練速度的提升,它一個系統(tǒng)工程,需要軟件、網(wǎng)絡(luò)通訊和加速卡芯片的協(xié)同設(shè)計才能實現(xiàn)最佳性能。雖然Nvidia的單卡性能仍然很強,但是在訓(xùn)練領(lǐng)域,分布式訓(xùn)練性能事實上甚至比單卡性能更有意義,因此需要很強的系統(tǒng)工程能力才能實現(xiàn)超越。

當(dāng)然,從另一個角度來說,由于這是一個系統(tǒng)工程,因此如果公司在系統(tǒng)中的其他組件有優(yōu)勢的話,可以彌補芯片方面的短板。例如,谷歌的芯片部門雖然成立時間遠(yuǎn)少于Nvidia,但是憑借其在系統(tǒng)工程領(lǐng)域的深厚積累,可以在分布式訓(xùn)練領(lǐng)域?qū)崿F(xiàn)和Nvidia接近的結(jié)果。此外,來自北大和鵬城實驗室基于華為Kunpeng CPU+Ascend加速卡+mindspore軟件框架的分布式訓(xùn)練結(jié)果也值得肯定,在自然語言處理領(lǐng)域,BERT訓(xùn)練結(jié)果的跑分華為Ascend 128卡的結(jié)果與介于64卡Nvidia A100和64卡TPU之間,而在機器視覺領(lǐng)域,Ascend 1024卡的結(jié)果與A100 1024卡的結(jié)果接近。因此,在可使用的芯片工藝收到限制的情況下,中國芯片公司考慮從系統(tǒng)工程的角度(例如,通過與該領(lǐng)域有深厚積累的各大IT公司合作)來實現(xiàn)對于Nvidia GPU在訓(xùn)練領(lǐng)域的趕超或許是一個可行的思路。