2022年12月份的時候,ChatGPT還只是個被人各種撩的聊天工具。但進入2023年后,已經(jīng)向著效率工具邁進了。

微軟宣布正和ChatGPT開發(fā)團隊OpenAI進行洽談,投資百億美元,并計劃把這個工具整合到云服務、搜索引擎、甚至office中。海外高校、學術(shù)機構(gòu),也興起了關(guān)于用ChatGPT寫論文是否合規(guī)的大討論;咨詢公司也開始擔憂是否會被搶飯碗。

毫無疑問,ChatGPT的應用熱情,已經(jīng)被點燃;應用場景也不斷拓展。但ChatGPT并不是一蹴而就,以更廣闊的的視野來看,這背后是AIGC“智慧涌現(xiàn)”的大浪潮。那么,AIGC的發(fā)展節(jié)點有哪些?企業(yè)競爭靠什么?

AIGC是如何一步步突破的?

AI懂創(chuàng)作、會畫畫,可以說是人工智能的一個“跨越式”提升。雖然人工智能在生活中不斷普及,比如我們習慣了機器代替人去搬運重物、制造精密的產(chǎn)品、完成復雜的計算等等。但是,如果人工智能更接近人,那就必須具備人類“創(chuàng)作”的能力。這就是AIGC的意義。

AI能力的提升,并不是一蹴而就,而大部分則經(jīng)歷了“模型突破-大幅提升-規(guī)模化生產(chǎn)-遇到障礙-再模型突破-大幅提升”的循環(huán)發(fā)展。而要實現(xiàn)落地、走進人類生活,則必須具備“規(guī)模化生產(chǎn)”的能力,在資源消耗、學習門檻等方面大幅降低到平民化。

比如以AI畫畫為例,則經(jīng)歷了三個關(guān)鍵節(jié)點:

第一個節(jié)點,早期突破:2014年,對抗生成網(wǎng)絡(luò)(GAN)誕生,真正“教會”AI自己畫畫。

GAN包含兩個模型,一個是生成網(wǎng)絡(luò)G、一個是判別網(wǎng)絡(luò)D。G負責把接收到的隨機噪聲生成圖片,D則要判斷這張圖是G畫的、還是現(xiàn)實世界就存在的。G、D互相博弈,能力也不斷提升,而當D不再能判斷出G生成的圖片時,訓練就達到了平衡。

GAN的開創(chuàng)性在于,精巧地設(shè)計了一種“自監(jiān)督學習”方式,跳出了以往監(jiān)督學習需要大量標簽數(shù)據(jù)的應用困境,可以廣泛應用于圖像生成、風格遷移、AI藝術(shù)和黑白老照片上色修復。

第二個節(jié)點,大幅提升:2020年,一篇關(guān)于擴散模型(Diffusion Model)的學術(shù)論文,大幅提升AI的畫畫水平。

擴散模型的原理是“先增噪后降噪”。首先給現(xiàn)有的圖像逐步施加高斯噪聲,直到圖像被完全破壞,然后再根據(jù)給定的高斯噪聲,逆向逐步還原出原圖。當模型訓練完成后,輸入一個隨機的高斯噪聲,便能“無中生有”出一張圖像了。

這樣的設(shè)計大大降低了模型訓練難度,突破了GAN模型的局限,在逼真的基礎(chǔ)上兼具多樣性,也就能夠更快、更穩(wěn)定的生成圖片。

第三個節(jié)點,批量生產(chǎn):2022年夏天誕生的Stable Diffusion,讓高大上的學術(shù)理論變得“接地氣”。

去年8月,Stability AI將擴散過程放到更低維度的潛空間(Latent Diffusion),從而開發(fā)出了Stable Diffusion模型。這個模型帶來的提升,在于資源消耗大幅降低,消費級顯卡就可以驅(qū)動的,可以操作也更為方便,普通人也可以體會到人工智能驚艷的創(chuàng)作能力。而且開發(fā)團隊還把所有代碼、模型和權(quán)重參數(shù)庫都進行了開源,踐行了Geek的共享精神、去中心化主義。

門檻降低、效果提升,因此,大受歡迎。發(fā)布10天后,活躍數(shù)據(jù)達到了每天1700萬張,如果都用A4紙打印出來疊一起,相當于一座52層高的大樓。

共享,也是Stability AI的另一特色。在開源社區(qū)中,除了更小的內(nèi)存和更快的速度,Stable Diffusion收獲了更完善的指南與教程、共享提示詞、新UI,也依靠集體的智慧,走進了Photoshop、Figma等經(jīng)典軟件,匯入創(chuàng)作者們的既有工作流中。可謂是,依靠群眾、回饋群眾。

從技術(shù)實現(xiàn)突破、到技術(shù)提升、再到規(guī)模化降低門檻,AI創(chuàng)作能力也不斷提升。2022年10月,美國一名男子用AI繪畫工具Midjourney,生成了一幅名為《太空歌劇院》的作品,并獲得了第一名。這引起了一波不小的爭論,也終于形成了一條新賽道。于是,2022年以AI繪畫為代表的各種生成式AI工具,如雨后春筍般瘋狂冒尖,比如盜夢師、意間AI、6pen、novelAI等等。

而在文本AI領(lǐng)域也是如此。如今大火的ChatGPT則是基于GPT3.5模型,已經(jīng)迭代了4次。而對話一次的平均成本為0.01-0.2美元,也就是六毛到一塊錢人民幣,成本依然需要不斷降低。但整體而言,無論畫畫、還是聊天,AI已經(jīng)體現(xiàn)出智慧涌現(xiàn)。

如何成為浪潮寵兒?

Stability AI的創(chuàng)始人Emad認為,圖像才是殺手級應用。

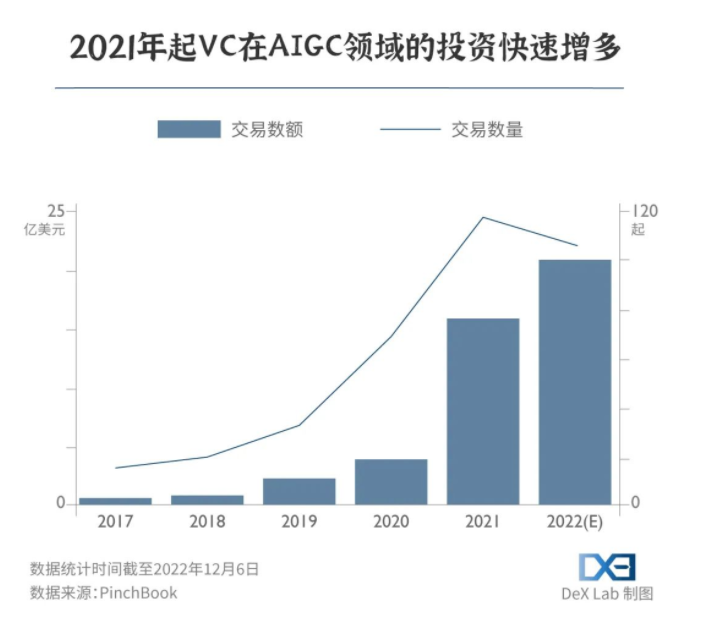

圖像模型可以迅速創(chuàng)造,并引導人們迅速消費,同時又能以較低成本快速整合到不同領(lǐng)域,從而快速普及,掀起浪潮。而事實上,確實許多創(chuàng)業(yè)者涌入了這些領(lǐng)域。AIGC成為了幣圈之后的投資新焦點。在 GPT-3 發(fā)布的兩年內(nèi),風投資本對 AIGC 的投資增長了四倍,在 2022 年更是達到了 21 億美元。

公司增多,投資增多,但并不是每家企業(yè)都能活得很好。比如2022年底,僅創(chuàng)立4個月的AI繪畫公司StockAI就停止了運營。公司CEO表示,主要是因為商業(yè)化模式不成熟,目前的付費用戶群體無法覆蓋高昂的運營成本。雖然他也表明會在今年1月份推出全新的平臺,但從透露的信息來看,新平臺已不會有需要大量算力的AI圖片生成功能了。

那么,什么樣的企業(yè),才是這波浪潮的“寵兒”?

首先,無疑是掌握核心前沿技術(shù)的行業(yè)引領(lǐng)者。全球TOP3的人工智能研究機構(gòu),都在各出奇招、爭奪AIGC主導地位。

OpenAI是文字生成領(lǐng)域的領(lǐng)航員。不光吸引了“生成對抗網(wǎng)絡(luò)之父”Ian Goodfellow加盟,還早早獲得了微軟的10億美元投資。從GPT到GPT3.5,OpenAI不斷迭代,也不斷帶給行業(yè)驚喜。這一次的ChatGPT更加獲得了微軟的認可。而通過開放GPT-3受控API的模式,OpenAI也將賦能更多公司和創(chuàng)業(yè)者。

DeepMind是通用型AI的探路人。2016年,AlphaGo擊敗人類圍棋的最高代表韓國棋手李世石,Go背后正是谷歌旗下的DeepMind。但DeepMind的目標并不是下棋,而是通用型AI,比如能預測蛋白質(zhì)結(jié)構(gòu)的AlphaFold、能解決復雜數(shù)學計算的AlphaTensor等等。但這些AI始終面臨著一個瓶頸,即無法像人類一樣進行“無中生有”的創(chuàng)作。

這兩年,DeepMind終于向通用型AI又推近了一步。在對話機器人Sparrow、劇本創(chuàng)作機器人Dramatron等背后的語言大模型中找到靈感,構(gòu)建了會聊天、會干活、會玩游戲的Gato。

Meta在加速AI的商業(yè)化落地。重組調(diào)整AI部門,將其分布式地下放到各實際業(yè)務中,而FAIR被并入元宇宙核心部門Reality Labs Research,成為新場景探索者的一員。

也許同行相輕,Meta首席人工智能科學家Yann LeCun對ChatGPT的評價并不高,他認為從底層技術(shù)上看,ChatGPT并不是什么創(chuàng)新性、革命性的發(fā)明,除了谷歌和Meta,至少有六家初創(chuàng)公司擁有類似的技術(shù)。

當被問及Meta的AI愿景時,LeCun為FAIR畫下了“生成藝術(shù)”的大餅。他提出,F(xiàn)acebook上有1200萬商鋪在投放廣告,其中多是沒有什么資源定制廣告的夫妻店,Meta將通過能夠自動生成宣傳資料的AI幫助他們做更好的推廣。

其次,另一類寵兒,則是押對應用場景的企業(yè)們,在“繪畫”之外吸納了不少資本支持與人才投入。

在所有內(nèi)容生成式AI中,輸出文字和音樂的已經(jīng)先一步找到了財富密碼。最早出現(xiàn)的AI生成文字在遍歷了寫新聞稿、寫詩、寫小劇本等頗受關(guān)注的應用方式后,終于在營銷場景找到了能夠穩(wěn)定變現(xiàn)的商業(yè)模式,成為寫作輔助的效率工具,幫助從業(yè)者寫郵件、文案、甚至策劃。專注于音樂的LifeScore,則讓人工智能學會了即時編曲,按照場景、長度的需要,組織藝術(shù)家同事人工創(chuàng)作、演奏的音樂素材,在人類的創(chuàng)作流程中找到了自己的位置。

能夠互動的聊天機器人,則在客服和游戲這兩個相去甚遠的行業(yè)分別“打工”。區(qū)別于當下只會提供預設(shè)問題解答,有時還會答非所問的“智能客服”,真正的AI需要結(jié)合用戶的行為和上下文來理解人類的真正意圖。在游戲領(lǐng)域,AI則被用來協(xié)助人類,高效地創(chuàng)造內(nèi)容豐富、體驗良好的游戲內(nèi)容,從而延長用戶的游戲時間。

顯然,寵兒是少的。而經(jīng)歷了過去一年多“科技股大回落”后,投資者們也謹慎一些了,當下的AIGC雖然很好,但等大模型出來也許更香。

大模型,也許是企業(yè)比拼的護城河

模型是人工智能的靈魂,本質(zhì)上它是一套計算公式和數(shù)學模型。“參數(shù)”可以看做是模型里的一個個公式,這意味著,參數(shù)量越大,模型越復雜,做出來的預測就越準確。

小模型就像“偏科的機器”,只學習針對特定應用場景的有限數(shù)據(jù),“舉一反三”能力不足,一些智能產(chǎn)品被用戶調(diào)侃為“人工智障”的情況時有發(fā)生。

大模型就是參數(shù)量極大的模型,目前業(yè)界主流的AIGC模型都是千億級、萬億級參數(shù)量的水平。通過學習各行各業(yè)各類數(shù)據(jù),除了能給出相較于小模型更準確的預測結(jié)果之外,它也展現(xiàn)出了驚人的泛化能力、遷移能力,產(chǎn)出內(nèi)容質(zhì)量更高、更智能,這也是當前AIGC工具讓人眼前一亮的原因。

而大模型的快速發(fā)展,對行業(yè)發(fā)展起到了明顯的推動作用。例如ChatGPT是基于GPT-3模型進行優(yōu)化所產(chǎn)生的,引領(lǐng)AI繪畫發(fā)展的DALL·E 2也離不開GPT-3的貢獻。類似的還有Deepmind的Chinchilla、百度的文心大模型等等。

大模型,很大概率是行業(yè)淘汰與否的判斷要素。

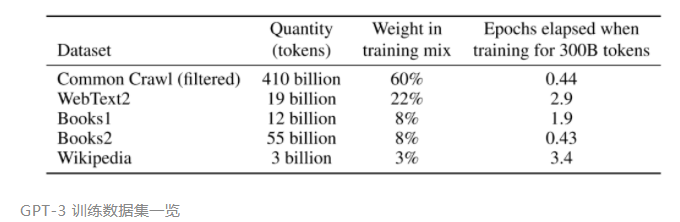

首先,訓練數(shù)據(jù)量大,OpenAI為了讓GPT-3的表現(xiàn)更接近人類,用了45TB的數(shù)據(jù)量、近 1 萬億個單詞來訓練它,大概是1351萬本牛津詞典。

這就帶來了兩個問題:巨大的算力需求與資金消耗。訓練和運行模型都需要龐大的算力,有研究估測,訓練 1750 億參數(shù)語言大模型 GPT-3,需要有上萬個 CPU/GPU 24 小時不間輸入數(shù)據(jù),所需能耗相當于開車往返地球和月球,且一次運算就要花費450萬美元。

國內(nèi)也不例外。目前國內(nèi)自研的大模型包括百度的文心大模型、阿里的M6大模型、騰訊的混元大模型,針對中文語境,國內(nèi)廠商的表現(xiàn)要比國外大廠要好得多。而且國內(nèi)的大模型發(fā)展速度也很驚人。

采用稀疏MoE結(jié)構(gòu)的M6大模型,2021年3月僅1000億參數(shù),3個月后就達到了萬億級,又過了五個月模型參數(shù)達到了十萬億級,成為全球最大的AI預訓練模型。混元模型也是萬億級別,成本大幅降低,最快用256張卡,1天內(nèi)就能訓練完成。而采用稠密結(jié)構(gòu)(可以粗糙理解是和稀疏相比,密度更大)的文心大模型,2021年,參數(shù)規(guī)模達到2600億。2022年,百度又先后發(fā)布了數(shù)十個大模型,其中有11個行業(yè)大模型。

這樣高的研發(fā)門檻,注定目前主流的大模型多由大企業(yè)、或是背靠大企業(yè)的研究機構(gòu)掌握,中小企業(yè)只能望而卻步。因此,大模型,也就成為企業(yè)的“護城河”。

但進行大模型的研發(fā)只是“成功第一步”,還有三個維度的比拼,也非常重要。

一是數(shù)據(jù)資源。有研究表明,到2026年就沒有更多高質(zhì)量的數(shù)據(jù)可以訓練AI了。此外,基于現(xiàn)實生活中已有的數(shù)據(jù)來訓練模型只能解決一些已知問題,對于一些我們還沒有發(fā)現(xiàn)的、潛在的、未知的問題,現(xiàn)在的模型未必能解決。因此有一些研究人員提出了合成數(shù)據(jù)的概念,即通過計算機程序人工合成的數(shù)據(jù),一方面補充高質(zhì)量的訓練數(shù)據(jù),另一方面填補一些極端或者邊緣的案例,增加模型的可靠性。

二是綠色發(fā)展。雖然模型越大效果越好,但無限“大”下去并不經(jīng)濟,對自然資源消耗、數(shù)據(jù)資源都帶來巨大壓力。而過高的資源消耗,也不利于平民化普及。

三是應用場景。商業(yè)和純理論研究不同,不能拿著技術(shù)的錘子,瞎找釘子,而是要結(jié)合應用來發(fā)展技術(shù)。而國內(nèi)廠商要想拿出Stable Diffusion、ChatGPT這樣的殺手級應用,還需要更多的思考和努力:

跳出“跑分”怪圈,找到應用場景,進行模型“瘦身”,甚至,將模型開源、形成生態(tài),利用群眾的智慧、為群眾服務。

尾聲

隨著微軟對ChatGPT的關(guān)注,產(chǎn)業(yè)、投資圈都熱了起來,美股BuzzFeed因為要采用ChatGPT技術(shù)就實現(xiàn)了兩天漲三倍的壯舉;H股、A股也迎風而動,不少上市公司也表態(tài)具備技術(shù)積累。

躁動當然是好事兒,科技創(chuàng)新,就是要令人心潮澎湃。我國廣闊的產(chǎn)業(yè),是應用開花的土壤。但與此同時,國內(nèi)的AIGC也存在著隱憂,比如高算力的芯片,如何造出來?

另一方面,科技創(chuàng)新,也要牢記Gartner曲線揭示的規(guī)律:萌發(fā)期→泡沫期→泡沫破裂期→穩(wěn)步發(fā)展期→穩(wěn)定產(chǎn)出期。只有躁動,沒有篤定、沒有低谷時的忍耐,也絕不可能成功的。

適度的泡沫,成為驅(qū)動力;過度的泡沫,也許會劣幣驅(qū)逐良幣。但至少目前,我們和海外相比,幾乎在同一起跑線,值得充滿熱情的期待。

敬請關(guān)注電子技術(shù)應用2023年2月22日==>>商業(yè)航天研討會<<