正如我們?cè)谝荒昵爸赋龅哪菢樱?dāng)一些關(guān)鍵的芯片專家從英特爾和 Broadcom 被聘請(qǐng)到 Meta Platforms 工作時(shí),這家前身為 Facebook 的公司一直是定制芯片最明顯的地方。在全球最大的八家互聯(lián)網(wǎng)公司(也是全球八家最大的 IT 設(shè)備買(mǎi)家)中,Meta Platforms 是唯一一家純粹的超大規(guī)模供應(yīng)商,并且不在云上銷(xiāo)售基礎(chǔ)設(shè)施容量。

因此,Meta Platforms 擁有自上而下的軟件堆棧,并且可以隨心所欲地創(chuàng)建驅(qū)動(dòng)它的硬件。而且,它有足夠的錢(qián)這樣做,并且在硅片和人員上投入了足夠的錢(qián)來(lái)為它調(diào)整軟件,毫無(wú)疑問(wèn),它可以通過(guò)控制更多的芯片來(lái)節(jié)省很多錢(qián)。

Meta Platforms 今天在其 AI Infra @ Scale 活動(dòng)中推出了自主研發(fā)的 AI 推理和視頻編碼芯片,并討論了其研究超級(jí)計(jì)算機(jī)的部署、適應(yīng)繁重 AI 工作負(fù)載的新數(shù)據(jù)中心設(shè)計(jì),以及其 AI 框架的演變。在本片文章中,我們將專注于元訓(xùn)練和推理加速器,簡(jiǎn)稱 MTIA v1。

從長(zhǎng)遠(yuǎn)來(lái)看,CPU、DPU、交換機(jī)和路由 ASIC 可能會(huì)添加到 Meta Platforms 不會(huì)購(gòu)買(mǎi)的半導(dǎo)體組件列表中。如果 Meta Platforms 真的想造成很大的破壞,它可以將自己的芯片賣(mài)給其他人。. . . 奇怪的事情發(fā)生了。就像1975 年的寵物搖滾熱潮,僅舉一個(gè)例子。

為什么要自研芯片

在今天上午的一次虛擬活動(dòng)中,Meta 揭開(kāi)了其為 AI 工作負(fù)載開(kāi)發(fā)內(nèi)部基礎(chǔ)設(shè)施的努力的帷幕,包括支持其最近推出的廣告設(shè)計(jì)和創(chuàng)作工具的生成 AI 類型。

這是對(duì) Meta 實(shí)力投射的一次嘗試,Meta 在采用 AI 友好的硬件系統(tǒng)方面歷來(lái)進(jìn)展緩慢,這阻礙了其與谷歌和微軟等競(jìng)爭(zhēng)對(duì)手保持同步的能力。

“構(gòu)建我們自己的 [硬件] 功能使我們能夠控制堆棧的每一層,從數(shù)據(jù)中心設(shè)計(jì)到訓(xùn)練框架,”Meta 基礎(chǔ)設(shè)施副總裁 Alexis Bjorlin 告訴 TechCrunch。“需要這種水平的垂直整合才能大規(guī)模突破人工智能研究的界限。”

在過(guò)去十年左右的時(shí)間里,Meta 花費(fèi)了數(shù)十億美元來(lái)招募頂級(jí)數(shù)據(jù)科學(xué)家并構(gòu)建新型人工智能,包括現(xiàn)在為發(fā)現(xiàn)引擎、審核過(guò)濾器和遍布其應(yīng)用程序和服務(wù)的廣告推薦器提供支持的人工智能。但該公司一直在努力將其許多雄心勃勃的 AI 研究創(chuàng)新轉(zhuǎn)化為產(chǎn)品,尤其是在生成 AI 方面。

直到 2022 年,Meta 主要使用 CPU 和專為加速 AI 算法而設(shè)計(jì)的定制芯片的組合來(lái)運(yùn)行其 AI 工作負(fù)載——CPU 在處理這類任務(wù)時(shí)的效率往往低于 GPU。Meta 取消了計(jì)劃于 2022 年大規(guī)模推出定制芯片的計(jì)劃,轉(zhuǎn)而訂購(gòu)了價(jià)值數(shù)十億美元的 Nvidia GPU,這需要對(duì)其多個(gè)數(shù)據(jù)中心進(jìn)行重大重新設(shè)計(jì)。

為了扭轉(zhuǎn)局面,Meta 計(jì)劃開(kāi)始開(kāi)發(fā)更具雄心的內(nèi)部芯片,該芯片將于 2025 年推出,能夠訓(xùn)練 AI 模型并運(yùn)行它們。這就是今天演講的主題。

Meta 將新芯片稱為 Meta Training and Inference Accelerator,簡(jiǎn)稱 MTIA,并將其描述為加速 AI 訓(xùn)練和推理工作負(fù)載的芯片“家族”的一部分。(“推理”是指運(yùn)行經(jīng)過(guò)訓(xùn)練的模型。)MTIA 是一種 ASIC,一種將不同電路組合在一塊板上的芯片,允許對(duì)其進(jìn)行編程以并行執(zhí)行一項(xiàng)或多項(xiàng)任務(wù)。

“為了在我們的重要工作負(fù)載中獲得更高水平的效率和性能,我們需要一個(gè)與模型、軟件堆棧和系統(tǒng)硬件共同設(shè)計(jì)的定制解決方案,”Bjorlin 繼續(xù)說(shuō)道。“這通過(guò)各種服務(wù)為我們的用戶提供了更好的體驗(yàn)。”

定制 AI 芯片越來(lái)越成為大型科技公司的游戲名稱。谷歌創(chuàng)建了一個(gè)處理器,TPU(“張量處理單元”的縮寫(xiě)),用于訓(xùn)練大型生成式人工智能系統(tǒng),如PaLM-2和Imagen。亞馬遜向 AWS 客戶提供專有芯片,用于訓(xùn)練 ( Trainium ) 和推理 ( Inferentia )。據(jù)報(bào)道,微軟正在與 AMD 合作開(kāi)發(fā)一種名為 Athena 的內(nèi)部 AI 芯片。

Meta 表示,它在 2020 年創(chuàng)建了第一代 MTIA——MTIA v1——基于 7 納米工藝。它可以從其內(nèi)部 128 MB 內(nèi)存擴(kuò)展到高達(dá) 128 GB,并且在 Meta 設(shè)計(jì)的基準(zhǔn)測(cè)試中——當(dāng)然,必須持保留態(tài)度——Meta 聲稱 MTIA 處理了“低復(fù)雜性” ”和“中等復(fù)雜度”的 AI 模型比 GPU 更高效。

Meta 表示,芯片的內(nèi)存和網(wǎng)絡(luò)領(lǐng)域仍有工作要做,隨著 AI 模型規(guī)模的增長(zhǎng),這會(huì)出現(xiàn)瓶頸,需要將工作負(fù)載分配到多個(gè)芯片上。(并非巧合,Meta 最近收購(gòu)了位于奧斯陸的英國(guó)芯片獨(dú)角獸 Graphcore 的 AI 網(wǎng)絡(luò)技術(shù)團(tuán)隊(duì)。)目前,MTIA 的重點(diǎn)完全放在 Meta 應(yīng)用程序系列“推薦工作負(fù)載”的推理上,而不是訓(xùn)練上。

但 Meta 強(qiáng)調(diào),它繼續(xù)改進(jìn)的 MTIA 在運(yùn)行推薦工作負(fù)載時(shí)“大大”提高了公司在每瓦性能方面的效率——反過(guò)來(lái)允許 Meta 運(yùn)行“更加增強(qiáng)”和“尖端”(表面上)人工智能工作負(fù)載。

NNP和GPU無(wú)法處理具有良好TCO的負(fù)載

MTIA AI 推理引擎于 2020 年啟動(dòng),當(dāng)時(shí)冠狀病毒大流行導(dǎo)致一切失控,而 AI 已經(jīng)超越圖像識(shí)別和語(yǔ)音到文本翻譯,發(fā)展到大型語(yǔ)言模型的生成能力,這些模型似乎知道如何做很多他們不打算做的事情。深度學(xué)習(xí)推薦模型或 DLRM 是一個(gè)比 LLM 更棘手的計(jì)算和內(nèi)存問(wèn)題,因?yàn)樗鼈円蕾囉谇度搿环N數(shù)據(jù)集上下文的圖形表示——必須存儲(chǔ)在運(yùn)行的計(jì)算設(shè)備的主內(nèi)存中神經(jīng)網(wǎng)絡(luò)。LLM 沒(méi)有嵌入,但 DLRM 有,內(nèi)存是主機(jī) CPU 內(nèi)存容量以及 CPU 和加速器之間快速、高帶寬連接對(duì) DLRM 比對(duì) LLM 更重要的原因。

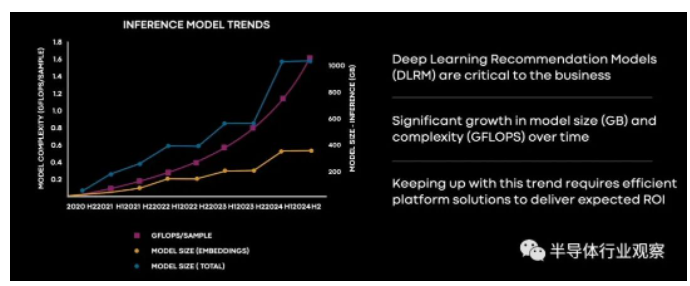

Meta Platforms 的軟件工程師 Joel Coburn 在 AI Infra @ Scale 活動(dòng)中展示了這張圖表,展示了該公司的 DLRM 推理模型在過(guò)去三年中的規(guī)模和計(jì)算需求如何增長(zhǎng),以及該公司的預(yù)期他們將在接下來(lái)的十八個(gè)月內(nèi)成長(zhǎng):

請(qǐng)記住,這是為了推理,而不是訓(xùn)練。這些模型絕對(duì)突破了大多數(shù) CPU 中的片上矢量引擎提供的相對(duì)少量的低精度計(jì)算,以及片上矩陣數(shù)學(xué)引擎,例如現(xiàn)在英特爾至強(qiáng) SP v4 和 IBM Power10 芯片上的引擎,即將在 AMD Epycs 上使用可能還不夠。

無(wú)論如何,這是我們一直看到的那種圖表,盡管我們還沒(méi)有看到它們用于 DLRM。這是一張可怕的圖表,但不像這張圖那么可怕:

在圖表的左側(cè),在我們?cè)缭?2019 年談到的“Yosemite”微服務(wù)器平臺(tái)中, Meta Platforms 正在用用于推理的神經(jīng)網(wǎng)絡(luò)處理器或 NNPI 取代基于 CPU 的推理。基于 CPU 的推理仍在繼續(xù),你看,但是隨著 DLRM 模型變得越來(lái)越胖,它們超出了 NNPI 的范圍,然后 Meta Platforms 不得不引入 GPU 來(lái)進(jìn)行推理。我們假設(shè)這些不是用于 AI 訓(xùn)練的 GPU,而是 Nvidia 的 T4 和 A40 等 PCI-Express 卡,但 Coburn 沒(méi)有具體說(shuō)明。然后隨著需要更多的推理能力,它開(kāi)始變得越來(lái)越昂貴。

“你可以看到推理需求很快超過(guò)了 NPI 功能,Meta 轉(zhuǎn)向了 GPU,因?yàn)樗鼈兲峁┝烁鼜?qiáng)大的計(jì)算能力來(lái)滿足不斷增長(zhǎng)的需求,”Coburn 在 MTIA 發(fā)布演示中解釋道。“但事實(shí)證明,雖然 GPU 提供了大量的內(nèi)存帶寬和計(jì)算吞吐量,但它們?cè)谠O(shè)計(jì)時(shí)并沒(méi)有考慮到推理,盡管軟件進(jìn)行了大量?jī)?yōu)化,但它們的效率對(duì)于真實(shí)模型來(lái)說(shuō)仍然很低。這使得它們的部署和實(shí)踐具有挑戰(zhàn)性且成本高昂。”

我們強(qiáng)烈懷疑 Nvidia 會(huì)爭(zhēng)辯說(shuō) Meta Platforms 為 DLRM 使用了錯(cuò)誤的設(shè)備,或者它可能已經(jīng)解釋了“Grace”CPU 和“Hopper”GPU 混合體將如何挽救局面。這一切似乎都不重要,因?yàn)?Meta Platforms 希望控制自己在硅片中的命運(yùn),就像它在 2011 年啟動(dòng)開(kāi)放計(jì)算項(xiàng)目以開(kāi)源服務(wù)器和數(shù)據(jù)中心設(shè)計(jì)時(shí)所做的那樣。

這就引出了一個(gè)問(wèn)題:Facebook 會(huì)開(kāi)源 MTIA 設(shè)備的 RTL 和設(shè)計(jì)規(guī)范嗎?

為 MTIA 寄希望于 RISC-V

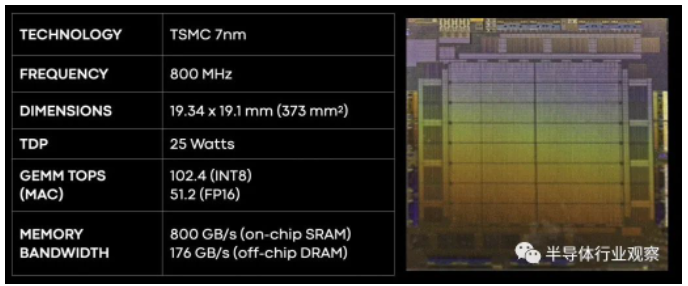

Facebook 在歷史上一直是開(kāi)源軟件和硬件的堅(jiān)定支持者,如果 Meta Platforms 沒(méi)有為 MTIA 加速器采用 RISC-V 架構(gòu),那將是一個(gè)很大的驚喜。當(dāng)然,它是基于一個(gè)雙核 RISC-V 處理元件,包裹著一大堆東西,但沒(méi)有多到無(wú)法裝入 25 瓦芯片和 35 瓦雙 M.2 外圍卡.

以下是 MTIA v1 芯片的基本規(guī)格:

因?yàn)樗堑皖l率的,MTIA v1 芯片消耗的功率也相當(dāng)?shù)停⑶也捎?7 納米工藝實(shí)現(xiàn)意味著該芯片足夠小,可以運(yùn)行得非常酷,而無(wú)需采用臺(tái)積電最先進(jìn)的工藝,(如從 5 納米到 3 納米不等,中間有 4 納米墊腳石。)這些都是更昂貴的制程,也許可以留到以后再使用——當(dāng)這些制程更成熟并因此更便宜時(shí),可以單獨(dú)或一起使用新一代設(shè)備進(jìn)行訓(xùn)練和推理,就像谷歌對(duì)其 TPU 所做的那樣。

圖片

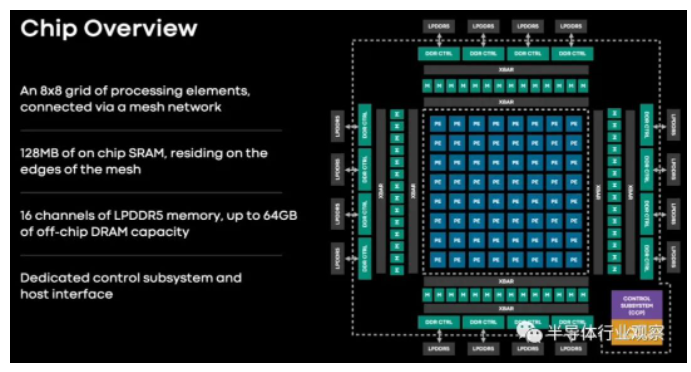

MTIA v1 推理芯片有一個(gè)由 64 個(gè)處理元件組成的網(wǎng)格,這些處理元件周?chē)h(huán)繞著 128 MB 的 SRAM 內(nèi)存,可用作主存儲(chǔ)器或前端有 16 個(gè)低功耗 DDR5 (LPDDR5) 內(nèi)存控制器的高速緩存。這種 LPDDR5 內(nèi)存用于筆記本電腦,也用于 Nvidia 即將推出的 Grace Arm 服務(wù)器 CPU。這 16 個(gè) LPDDR5 內(nèi)存通道可以提供高達(dá) 64 GB 的外部?jī)?nèi)存,適合容納 DLRM 所需的那些big fat embeddings。

這 64 個(gè)處理元素基于一對(duì) RISC-V 內(nèi)核,一個(gè)是普通的,另一個(gè)是帶有矢量數(shù)學(xué)擴(kuò)展的。每個(gè)處理元件都有 128 KB 的本地內(nèi)存和固定功能單元,用于執(zhí)行 FP16 和 INT8 數(shù)學(xué)運(yùn)算、處理非線性函數(shù)和移動(dòng)數(shù)據(jù)。

這是 MTIA v1 板的外觀:

無(wú)法將風(fēng)扇放在芯片頂部,并在 Yosemite V3 服務(wù)器中安裝一打這樣的風(fēng)扇。也許這只是為了顯示規(guī)模?

這是 MTIA 服務(wù)器設(shè)計(jì)中的巧妙之處。Yosemite 服務(wù)器中有一個(gè) PCI-Express 交換機(jī)的葉/脊( leaf/spine)網(wǎng)絡(luò),它不僅可以讓 MTIA 連接到主機(jī),還可以相互連接,并連接到 96 GB 的主機(jī) DRAM,必要時(shí)可以存儲(chǔ)更大的嵌入。(就像 Nvidia 打算對(duì) Grace-Hopper 做的那樣。)整個(gè) shebang 的重量為每個(gè)系統(tǒng) 780 瓦 - 或者比單個(gè) Hopper SXM5 GPU 在運(yùn)行full tilt boogie時(shí)的 700 瓦多一點(diǎn)。

Nvidia H100 可以在 700 瓦的設(shè)備功率下以 INT8 精度處理 2,000 teraops ,而 Meta Platforms Yosemite 推理平臺(tái)可以在 780 瓦的系統(tǒng)下處理 1,230 teraops。DGX H100 的功率為 10,200 瓦,配備八個(gè) GPU,即 16,000 兆運(yùn)算,即每瓦 1.57 兆運(yùn)算。MTIA 的功耗為每瓦 1.58 teraops,并針對(duì) Meta Platform 的 DLRM 和 PyTorch 框架進(jìn)行了調(diào)優(yōu)——并且將進(jìn)行更高程度的調(diào)優(yōu)。我們強(qiáng)烈懷疑 MTIA 機(jī)箱的單位工作成本比 DGX H100 系統(tǒng)要低得多——否則 Meta Platforms 不會(huì)提出來(lái)。

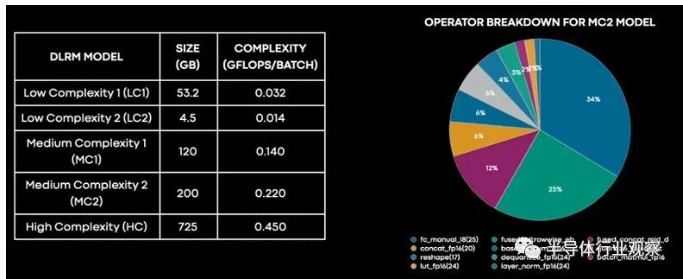

當(dāng)然,原始進(jìn)給和速度并不是比較系統(tǒng)的最佳方式。DLRM 具有不同程度的復(fù)雜性和模型大小,并不是所有的東西都擅長(zhǎng)。以下是 DLRM 在元平臺(tái)內(nèi)部的分解方式:

“我們可以看到,大部分時(shí)間實(shí)際上花在了完全連接的層上,其次是嵌入式底層,然后是連接、轉(zhuǎn)置、量化和反量化等長(zhǎng)尾操作,”Meta Platforms 工程總監(jiān)Roman Levenstein 解釋說(shuō),。“細(xì)分還讓我們深入了解 MTIA 在哪里以及如何更有效。與 GPU 相比,MTIA 在全連接層上的每瓦性能最高可達(dá)兩倍。”

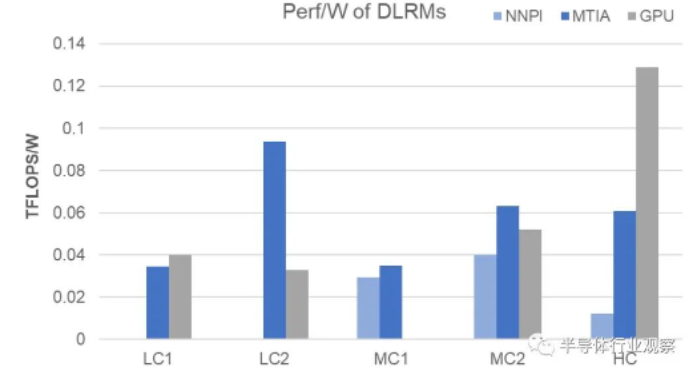

以下是低復(fù)雜度、中等復(fù)雜度和高復(fù)雜度模型的每瓦性能如何疊加:

One More Thing:視頻轉(zhuǎn)碼器

該公司在今天的活動(dòng)中透露,除了 MTIA 之外,Meta 還在開(kāi)發(fā)另一種芯片來(lái)處理特定類型的計(jì)算工作負(fù)載。Meta 稱為 Meta 可擴(kuò)展視頻處理器,或 MSVP,Meta 表示這是其第一個(gè)內(nèi)部開(kāi)發(fā)的 ASIC 解決方案,專為滿足視頻點(diǎn)播和直播流媒體的處理需求而設(shè)計(jì)。

讀者可能還記得, Meta 多年前就開(kāi)始構(gòu)思定制服務(wù)器端視頻芯片,并宣布在 2019 年推出用于視頻轉(zhuǎn)碼和推理工作的 ASIC。這是其中一些努力的成果,也是對(duì)競(jìng)爭(zhēng)優(yōu)勢(shì)的新推動(dòng)。特別是現(xiàn)場(chǎng)視頻領(lǐng)域。

“僅在 Facebook 上,人們就將 50% 的時(shí)間花在觀看視頻上,”Meta 技術(shù)主管 Harikrishna Reddy 和 Yunqing Chen 在今天上午發(fā)表的一篇合著的博客文章中寫(xiě)道。“為了服務(wù)于世界各地的各種設(shè)備(移動(dòng)設(shè)備、筆記本電腦、電視等),上傳到 Facebook 或 Instagram 的視頻被轉(zhuǎn)碼為多個(gè)比特流,具有不同的編碼格式、分辨率和質(zhì)量……MSVP是可編程和可擴(kuò)展的,并且可以配置為有效地支持 VOD 所需的高質(zhì)量轉(zhuǎn)碼以及實(shí)時(shí)流媒體所需的低延遲和更快的處理時(shí)間。”

Meta 表示,它的計(jì)劃是最終將大部分“穩(wěn)定和成熟”的視頻處理工作負(fù)載卸載到 MSVP,并僅對(duì)需要特定定制和“顯著”更高質(zhì)量的工作負(fù)載使用軟件視頻編碼。Meta 說(shuō),使用智能降噪和圖像增強(qiáng)等預(yù)處理方法以及偽影去除和超分辨率等后處理方法,我們將繼續(xù)使用 MSVP 提高視頻質(zhì)量。

“在未來(lái),MSVP 將使我們能夠支持更多 Meta 最重要的用例和需求,包括短視頻——實(shí)現(xiàn)生成 AI、AR/VR 和其他元宇宙內(nèi)容的高效交付,”Reddy 和 Chen 說(shuō)。

更多精彩內(nèi)容歡迎點(diǎn)擊==>>電子技術(shù)應(yīng)用-AET<<