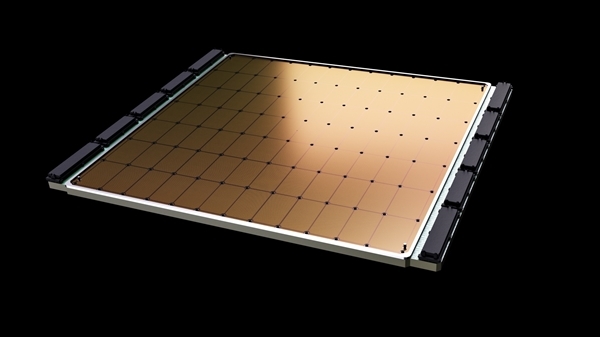

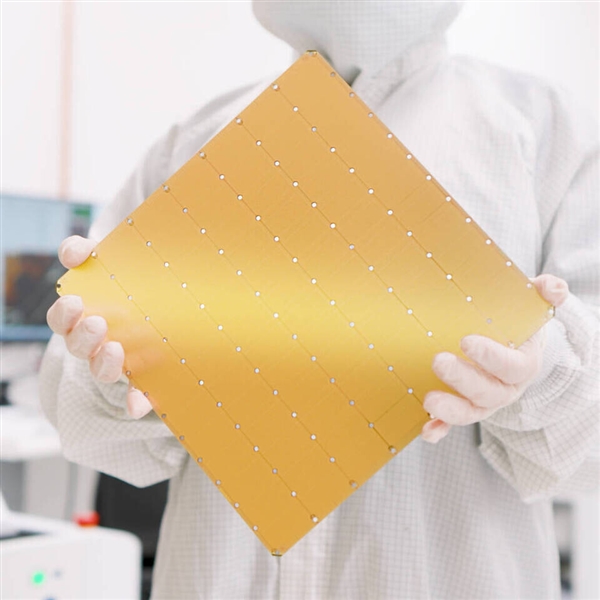

3月14日消息,Cerebras Systems發(fā)布了他們的第三代晶圓級AI加速芯片“WSE-3”(Wafer Scale Engine 3),規(guī)格參數(shù)更加瘋狂,而且在功耗、價格不變的前提下性能翻了一番。

2019年的第一代WSE-1基于臺積電16nm工藝,面積46225平方毫米,晶體管1.2萬億個,擁有40萬個AI核心、18GB SRAM緩存,支持9PB/s內(nèi)存帶寬、100Pb/s互連帶寬,功耗高達(dá)15千瓦。

2021年的第二代WSE-2升級臺積電7nm工藝,面積不變還是46225平方毫米,晶體管增至2.6萬億個,核心數(shù)增至85萬個,緩存擴至40GB,內(nèi)存帶寬20PB/s,互連帶寬220Pb/s。

如今的第三代WSE-3再次升級為臺積電5nm工藝,面積沒說但應(yīng)該差不多,畢竟需要一塊晶圓才能造出一顆芯片,不可能再大太多了。

晶體管數(shù)量繼續(xù)增加達(dá)到驚人的4萬億個,AI核心數(shù)量進(jìn)一步增加到90萬個,緩存容量達(dá)到44GB,外部搭配內(nèi)存容量可選1.5TB、12TB、1200TB。

乍一看,核心數(shù)量、緩存容量增加的不多,但性能實現(xiàn)了飛躍,峰值A(chǔ)I算力高達(dá)125PFlops,也就是每秒12.5億億次浮點計算,堪比頂級超算。

它可以訓(xùn)練相當(dāng)于GPT-4、Gemini十幾倍的下一代AI大模型,能在單一邏輯內(nèi)存空間內(nèi)存儲24萬億參數(shù),無需分區(qū)或者重構(gòu)。

用它來訓(xùn)練1萬億參數(shù)大模型的速度,相當(dāng)于用GPU訓(xùn)練10億參數(shù)。

四顆并聯(lián),它能在一天之內(nèi)完成700億參數(shù)的調(diào)教,而且支持最多2048路互連,一天就可以完成Llama 700億參數(shù)的訓(xùn)練。

WSE-3的具體功耗、價格沒公布,根據(jù)上代的情況看應(yīng)該在200多萬美元。