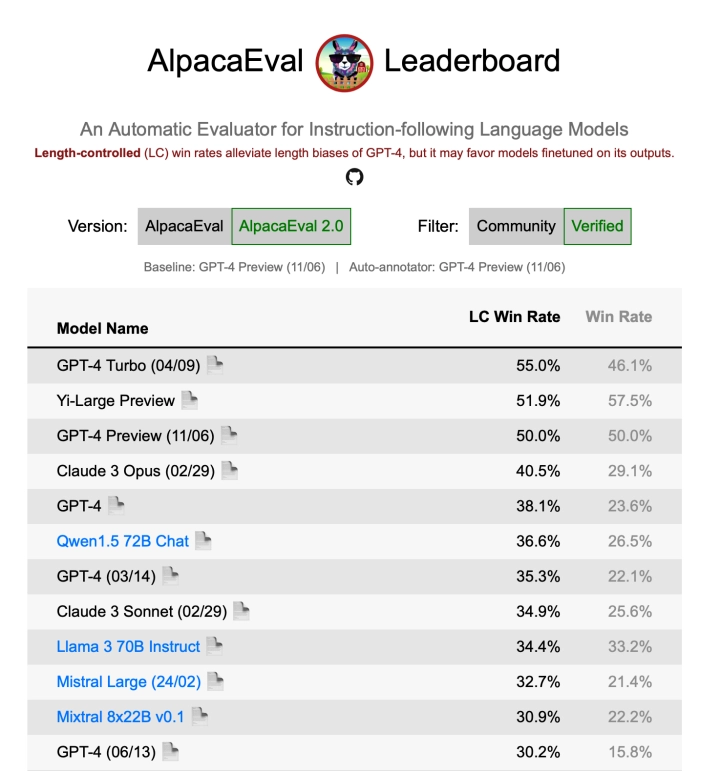

5 月 13 日消息,零一萬物創(chuàng)始人兼 CEO 李開復(fù)今日發(fā)布了千億參數(shù)閉源模型 Yi-Large,他表示 Yi-Large 的多數(shù)指標(biāo)可對(duì)標(biāo)甚至是超越 GPT 4.0。該模型在斯坦福大學(xué)最新的 AlpacaEval 2.0 評(píng)估中,全球大模型勝率(Win Rate)排第一、文本長度誤差的勝率(LC Win Rate)排第二。

同時(shí)零一萬物將早先發(fā)布的 Yi-34B、Yi-9B / 6B 中小尺寸開源模型版本升級(jí)為 Yi-1.5 系列,每個(gè)版本達(dá)到同尺寸中 SOTA (State of the art model,即在當(dāng)前研究中表現(xiàn)最好的模型)。

在不久之前,零一萬物上線一站式 AI 工作平臺(tái)“萬知”,其可用來制作會(huì)議紀(jì)要、周報(bào)、解讀財(cái)報(bào)或論文、制作 PPT 等,也可以當(dāng)作“寫作助手”來使用。

李開復(fù)還表示,大模型推理成本的下降會(huì)推動(dòng)中國 AI 大模型進(jìn)入落地為王的階段,今年會(huì)迎來“大模型應(yīng)用爆發(fā)元年”。

本站內(nèi)容除特別聲明的原創(chuàng)文章之外,轉(zhuǎn)載內(nèi)容只為傳遞更多信息,并不代表本網(wǎng)站贊同其觀點(diǎn)。轉(zhuǎn)載的所有的文章、圖片、音/視頻文件等資料的版權(quán)歸版權(quán)所有權(quán)人所有。本站采用的非本站原創(chuàng)文章及圖片等內(nèi)容無法一一聯(lián)系確認(rèn)版權(quán)者。如涉及作品內(nèi)容、版權(quán)和其它問題,請(qǐng)及時(shí)通過電子郵件或電話通知我們,以便迅速采取適當(dāng)措施,避免給雙方造成不必要的經(jīng)濟(jì)損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。