剛剛,英偉達全新發(fā)布的開源模型 Nemotron-4 340B,有可能徹底改變訓(xùn)練 LLM 的方式!從此,或許各行各業(yè)都不再需要昂貴的真實世界數(shù)據(jù)集了。而且,Nemotron-4 340B 直接超越了 Mixtral 8x22B、Claude sonnet、Llama3 70B、Qwen 2,甚至可以和 GPT-4 掰手腕!

就在剛剛,英偉達再一次證明了自己的 AI 創(chuàng)新領(lǐng)域的領(lǐng)導(dǎo)地位。

它全新發(fā)布的 Nemotron-4 340B,是一系列具有開創(chuàng)意義的開源模型,有可能徹底改變訓(xùn)練 LLM 的合成數(shù)據(jù)生成方式!

這一突破性進展,標志著 AI 行業(yè)的一個重要里程碑 ——

從此,各行各業(yè)都無需依賴大量昂貴的真實世界數(shù)據(jù)集了,用合成數(shù)據(jù),就可以創(chuàng)建性能強大的特定領(lǐng)域大語言模型!

現(xiàn)在,Nemotron-4 340B 已經(jīng)取得了輝煌戰(zhàn)績,直接超越了 Mixtral 8x22B、Claude sonnet、Llama3 70B、Qwen 2,甚至可以和 GPT-4 一較高下!

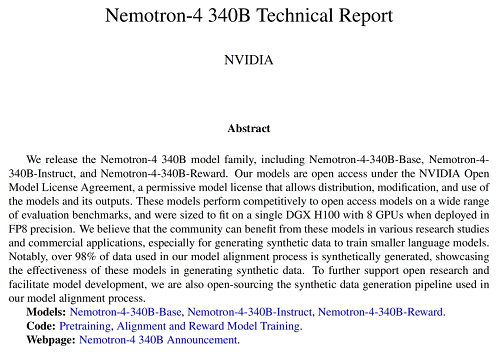

具體來說,Nemotron-4 340B 包括基礎(chǔ)模型 Base、指令模型 Instruct 和獎勵模型 Reward,并構(gòu)建了一個高質(zhì)量合成數(shù)據(jù)生成的完整流程。

模型支持 4K 上下文窗口、50 多種自然語言和 40 多種編程語言,訓(xùn)練數(shù)據(jù)截止到 2023 年 6 月。

訓(xùn)練數(shù)據(jù)方面,英偉達采用了高達 9 萬億個 token。其中,8 萬億用于預(yù)訓(xùn)練,1 萬億用于繼續(xù)訓(xùn)練以提高質(zhì)量。

值得一提的是,指令模型的訓(xùn)練是在 98% 的合成數(shù)據(jù)上完成的。

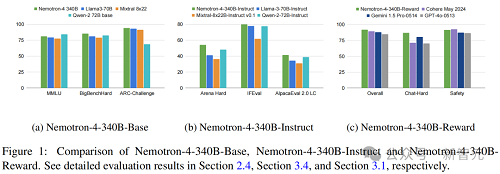

結(jié)果顯示,Nemotron-4-340B-Base 在常識推理任務(wù),如 ARC-Challenge、MMLU 和 BigBench Hard 基準測試中,可以和 Llama-3 70B、Mixtral 8x22B 和 Qwen-2 72B 模型媲美。

而 Nemotron-4-340B-Instruct,在指令跟隨和聊天能力方面也超越了相應(yīng)的指令模型。

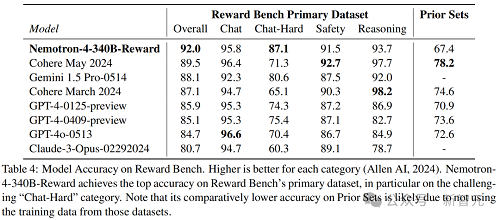

Nemotron-4-340B-Reward 在發(fā)表時,在 RewardBench 上實現(xiàn)了最高準確性,甚至超過了 GPT-4o-0513 和 Gemini 1.5 Pro-0514 這樣的專有模型。

在 BF16 精度下,模型的推理需要 8 塊 H200,或 16 塊 H100 / A100 80GB。如果是在 FP8 精度下,則只需 8 塊 H100。

除此之外,Nemotron-4 340B 還有一個非常顯著的特點 —— 對商用十分友好的許可。

高級深度學(xué)習研究工程師 Somshubra Majumdar 對此表示大贊:「是的,你可以用它生成你想要的所有數(shù)據(jù)」

無與倫比的合成數(shù)據(jù)生成

LLM 無法獲得大規(guī)模、多樣化標注數(shù)據(jù)集,怎么破?

Nemotron-4 340B 指令模型,可以幫助開發(fā)者生成合成訓(xùn)練數(shù)據(jù)。

這些多樣化的合成數(shù)據(jù),模仿了真實世界的數(shù)據(jù)特征,因而數(shù)據(jù)質(zhì)量明顯提升,從而提升了各領(lǐng)域定制 LLM 的性能和穩(wěn)定性。

而且,為了進一步提高 AI 生成數(shù)據(jù)的質(zhì)量,開發(fā)者還可以用 Nemotron-4 340B 獎勵模型,來篩選高質(zhì)量的響應(yīng)。

它會根據(jù)有用性、正確性、一致性、復(fù)雜性和冗長性這 5 個屬性,對響應(yīng)評分。

另外,研究者可以使用自己的專用數(shù)據(jù),再結(jié)合 HelpSteer2 數(shù)據(jù)集,定制 Nemotron-4 340B 基礎(chǔ)模型,以創(chuàng)建自己的指令或獎勵模型。