7 月 3 日消息,Meta 公司昨日(7 月 2 日)發(fā)布研究論文,介紹了名為 Meta 3D Gen(3DGen)的全新 AI 模型,可以在 1 分鐘內(nèi)基于用戶輸入的提示詞,生成高質量的 3D 內(nèi)容。

Meta 公司表示 Meta 3D Gen(3DGen)所生成的 3D 內(nèi)容具備高分辨率紋理和材質貼圖,還支持基于物理的渲染(PBR),并能對此前生成的 3D 內(nèi)容重新再生成新紋理。

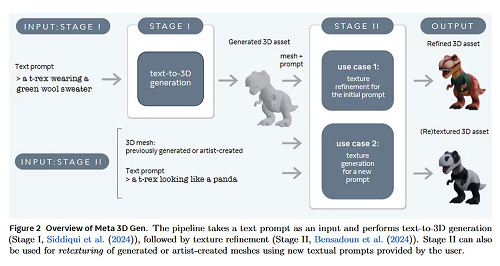

援引論文主要內(nèi)容,Meta 3D Gen 包含 text-to-3D 生成和 text-to-texture 生成兩個主要組件,其工作原理如下:

第一階段

根據(jù)用戶提供的文本提示,第一階段使用 Meta 的三維資產(chǎn)生成模型(AssetGen)創(chuàng)建初始 3D 資產(chǎn)。該步驟生成一個帶有紋理和 PBR 材質貼圖的 3D mesh。推理時間約為 30 秒。

第二階段

案例 1:生成更細化的 3D 紋理

根據(jù)階段 1 生成的三維資產(chǎn)和初始文本提示,階段 2 將為該資產(chǎn)生成更高質量的紋理和 PBR 貼圖。它使用 Meta 的文本到紋理生成器 Meta 3D TextureGen。推理時間約為 20 秒。

案例 2:再生成 3D 紋理

給定一個未紋理化的 3D mesh 和一個描述其所需外觀的提示。階段 2 還可以從頭開始為該三維資產(chǎn)生成紋理(mesh 可以是以前生成的,也可以是藝術家創(chuàng)建的)。推理時間約為 20 秒。

本站內(nèi)容除特別聲明的原創(chuàng)文章之外,轉載內(nèi)容只為傳遞更多信息,并不代表本網(wǎng)站贊同其觀點。轉載的所有的文章、圖片、音/視頻文件等資料的版權歸版權所有權人所有。本站采用的非本站原創(chuàng)文章及圖片等內(nèi)容無法一一聯(lián)系確認版權者。如涉及作品內(nèi)容、版權和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當措施,避免給雙方造成不必要的經(jīng)濟損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。