7 月 23 日消息,Meta 今晚正式發(fā)布 Llama 3.1 開源大語言模型,提供 8B、70B 及 405B 參數(shù)版本。

據(jù)介紹,Llama 3.1 系列改進(jìn)了推理能力及多語言支持,上下文長(zhǎng)度提升至 128K,首次推出 405B 參數(shù)的旗艦?zāi)P汀?/p>

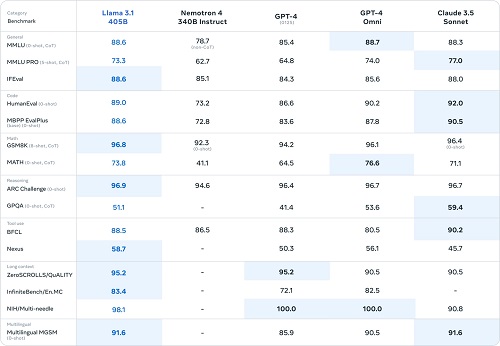

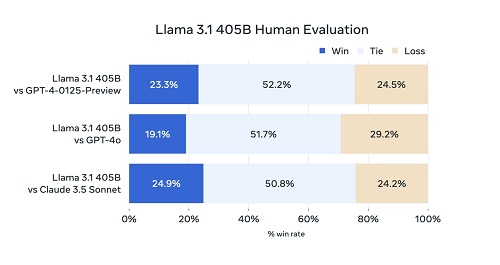

Meta 稱 4050 億參數(shù)的 Llama 3.1-405B 在常識(shí)、可引導(dǎo)性、數(shù)學(xué)、工具使用和多語言翻譯等一系列任務(wù)中,可與 GPT-4、GPT-4o、Claude 3.5 Sonnet 等領(lǐng)先的閉源模型相媲美。

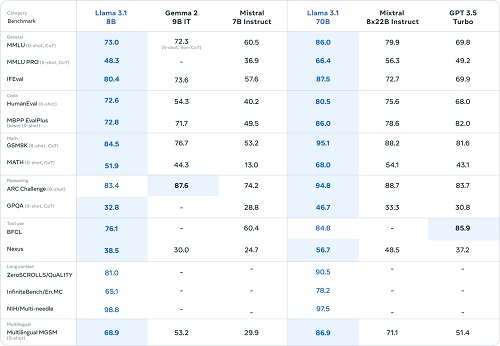

此外,8B 與 70B 參數(shù)的 Llama 3.1 模型與其他參數(shù)量相似的閉源和開源模型相比,也同樣具有競(jìng)爭(zhēng)力。

注:Llama 3.1 現(xiàn)已于 Meta 官網(wǎng)和 Hugging Face 開放下載,包括 AWS、英偉達(dá)、戴爾、Azure 和 Google Cloud 在內(nèi)的超過 25 個(gè)合作伙伴也已經(jīng)準(zhǔn)備就緒。

本站內(nèi)容除特別聲明的原創(chuàng)文章之外,轉(zhuǎn)載內(nèi)容只為傳遞更多信息,并不代表本網(wǎng)站贊同其觀點(diǎn)。轉(zhuǎn)載的所有的文章、圖片、音/視頻文件等資料的版權(quán)歸版權(quán)所有權(quán)人所有。本站采用的非本站原創(chuàng)文章及圖片等內(nèi)容無法一一聯(lián)系確認(rèn)版權(quán)者。如涉及作品內(nèi)容、版權(quán)和其它問題,請(qǐng)及時(shí)通過電子郵件或電話通知我們,以便迅速采取適當(dāng)措施,避免給雙方造成不必要的經(jīng)濟(jì)損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。