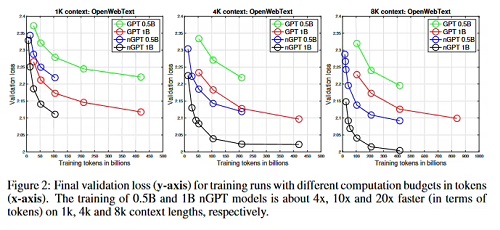

10 月 22 日消息,科技媒體 dataconomy 昨日(10 月 21 日)發(fā)布博文,報(bào)道稱英偉達(dá)在訓(xùn)練 AI 模型方面取得重大突破,發(fā)布了最新的 Normalized Transformer(nGPT)新架構(gòu),保持模型的穩(wěn)定性和準(zhǔn)確性的前提下,可以將訓(xùn)練 AI 時(shí)間縮短至 1/4 或者 1/20。

nGPT 架構(gòu)提升效率的秘訣在于“超球面學(xué)習(xí)”(Hyperspherical learning)這個(gè)概念。

傳統(tǒng)的變換器模型通常缺乏一致的幾何框架,而 nGPT 通過將嵌入、注意力矩陣和隱藏狀態(tài)等關(guān)鍵組件映射到超球面表面,確保模型各層在訓(xùn)練過程中保持平衡。

這種幾何結(jié)構(gòu)有助于創(chuàng)造更穩(wěn)定高效的學(xué)習(xí)過程:

減少訓(xùn)練步驟:nGPT 不再直接對(duì)模型權(quán)重應(yīng)用權(quán)重衰減,而是依賴學(xué)習(xí)到的縮放參數(shù),優(yōu)化模型在訓(xùn)練中的調(diào)整方式。

簡(jiǎn)化過程:此方法消除了對(duì) LayerNorm 或 RMSNorm 等歸一化技術(shù)的需求,使訓(xùn)練過程更為簡(jiǎn)單和快速。

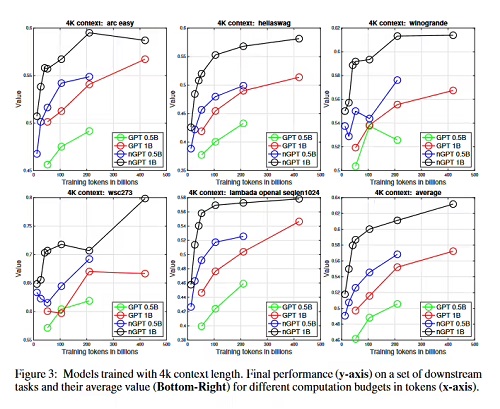

英偉達(dá)團(tuán)隊(duì)使用 OpenWebText 數(shù)據(jù)集進(jìn)行測(cè)試,nGPT 在速度和效率上均優(yōu)于傳統(tǒng)的 GPT 模型。對(duì)于長(zhǎng)達(dá) 4000 個(gè) tokens 的文本輸入,nGPT 所需的訓(xùn)練輪次遠(yuǎn)少于傳統(tǒng)模型,顯著縮短了訓(xùn)練時(shí)間。

nGPT 的一個(gè)關(guān)鍵優(yōu)勢(shì)是將歸一化(normalization)和表示學(xué)習(xí)(representation learning)結(jié)合成一個(gè)統(tǒng)一框架,這種設(shè)計(jì)簡(jiǎn)化了模型架構(gòu),便于擴(kuò)展和適應(yīng)更復(fù)雜的混合系統(tǒng)。未來,nGPT 的方法可能被整合進(jìn)其他類型的模型和架構(gòu),從而開發(fā)出更強(qiáng)大的 AI 系統(tǒng)。