在拉斯維加斯舉行的國際消費(fèi)電子展 (CES) 上,英偉達(dá) CEO 黃仁勛在一次面向萬人的主題演講后接受 TechCrunch 采訪時(shí)表示,其公司 AI 芯片的性能提升速度已遠(yuǎn)超數(shù)十年來推動(dòng)計(jì)算機(jī)技術(shù)進(jìn)步的“摩爾定律”設(shè)定的標(biāo)準(zhǔn)。

“我們的系統(tǒng)進(jìn)步速度遠(yuǎn)超摩爾定律,”黃仁勛周二表示。

據(jù)了解,“摩爾定律”由英特爾聯(lián)合創(chuàng)始人戈登 摩爾于 1965 年提出,預(yù)測計(jì)算機(jī)芯片上的晶體管數(shù)量將大約每年翻一番,從而使芯片性能也大致翻一番。這一預(yù)測基本實(shí)現(xiàn)了,并在幾十年里推動(dòng)了計(jì)算機(jī)性能的快速提升和成本的急劇下降。

近年來,“摩爾定律”的發(fā)展速度有所放緩。然而,黃仁勛聲稱,英偉達(dá)的 AI 芯片正以自身的加速節(jié)奏發(fā)展;該公司表示,其最新的數(shù)據(jù)中心超級(jí)芯片在運(yùn)行 AI 推理工作負(fù)載方面的速度比上一代產(chǎn)品快 30 多倍。

“我們可以同時(shí)構(gòu)建架構(gòu)、芯片、系統(tǒng)、庫和算法,”黃仁勛說,“如果這樣做,我們就能比摩爾定律更快地發(fā)展,因?yàn)槲覀兛梢栽谡麄€(gè)技術(shù)棧中進(jìn)行創(chuàng)新。”

英偉達(dá) CEO 發(fā)表這一大膽言論之際,正值許多人質(zhì)疑 AI 發(fā)展是否停滯之時(shí)。包括谷歌、OpenAI 和 Anthropic 在內(nèi)的領(lǐng)先 AI 實(shí)驗(yàn)室都使用英偉達(dá)的 AI 芯片來訓(xùn)練和運(yùn)行其 AI 模型,而這些芯片的進(jìn)步可能會(huì)轉(zhuǎn)化為 AI 模型能力的進(jìn)一步提升。

這并非黃仁勛首次暗示英偉達(dá)正在超越“摩爾定律”。早在去年 11 月的一次播客節(jié)目中,黃仁勛就曾提出 AI 世界正以“超摩爾定律”的速度發(fā)展。

黃仁勛還駁斥了“AI 進(jìn)展放緩”的觀點(diǎn)。他認(rèn)為,當(dāng)前 AI 領(lǐng)域存在三大擴(kuò)展定律:預(yù)訓(xùn)練(pre-training)、后訓(xùn)練(post-training)和推理時(shí)計(jì)算(test-time compute)。預(yù)訓(xùn)練階段,AI 模型從海量數(shù)據(jù)中學(xué)習(xí)模式;后訓(xùn)練階段,通過人類反饋等方法微調(diào)模型;推理時(shí)計(jì)算則讓模型在回答每個(gè)問題后有更多時(shí)間“思考”。黃仁勛強(qiáng)調(diào),隨著計(jì)算能力的提升,AI 推理成本將逐步降低,類似于摩爾定律推動(dòng)計(jì)算成本下降的歷史進(jìn)程。

英偉達(dá)的 H100 芯片曾是科技公司訓(xùn)練 AI 模型的首選,但現(xiàn)在科技公司更加關(guān)注推理,一些人開始質(zhì)疑英偉達(dá)昂貴的芯片是否還能保持領(lǐng)先地位。

目前,使用測試時(shí)計(jì)算的 AI 模型運(yùn)行成本高昂。有人擔(dān)心 OpenAI 的 o3 模型(使用了規(guī)模化的測試時(shí)計(jì)算)對(duì)大多數(shù)人來說過于昂貴。例如,OpenAI 使用 o3 在一項(xiàng)通用智能測試中達(dá)到人類水平的分?jǐn)?shù),每項(xiàng)任務(wù)花費(fèi)近 20 美元。而 ChatGPT Plus 的訂閱費(fèi)用為每月 20 美元。

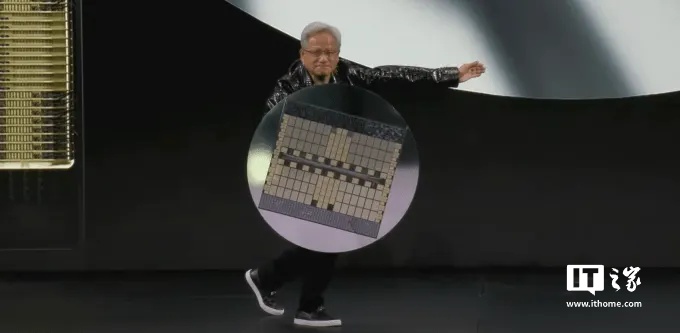

在周一的主題演講中,黃仁勛像舉著盾牌一樣展示了英偉達(dá)最新的數(shù)據(jù)中心超級(jí)芯片 GB200 NVL72。這款芯片在運(yùn)行 AI 推理工作負(fù)載方面的速度比英偉達(dá)之前最暢銷的芯片 H100 快 30 到 40 倍。黃仁勛表示,這種性能的飛躍意味著像 OpenAI 的 o3 這樣在推理階段使用大量計(jì)算的 AI 推理模型,其成本將隨著時(shí)間的推移而降低。

黃仁勛表示,他總體上專注于創(chuàng)造性能更強(qiáng)的芯片,而性能更強(qiáng)的芯片從長遠(yuǎn)來看會(huì)帶來更低的價(jià)格。“無論是在性能還是成本承受能力方面,測試時(shí)計(jì)算的直接解決方案是提高我們的計(jì)算能力,”黃仁勛表示。他指出,從長遠(yuǎn)來看,AI 推理模型可以用于為 AI 模型的預(yù)訓(xùn)練和后訓(xùn)練創(chuàng)建更好的數(shù)據(jù)。

在過去一年里,我們確實(shí)看到了 AI 模型的價(jià)格大幅下降,部分原因是英偉達(dá)等硬件公司的計(jì)算技術(shù)突破。黃仁勛表示,他預(yù)計(jì)這種趨勢將隨著 AI 推理模型的發(fā)展而繼續(xù)下去。

黃仁勛聲稱他今天的 AI 芯片比 10 年前的產(chǎn)品好 1000 倍。這是一個(gè)比“摩爾定律”設(shè)定的標(biāo)準(zhǔn)快得多的速度,黃仁勛表示他認(rèn)為這種速度沒有停止的跡象。