王婧,彭亞雄,賀松,陳余

(貴州大學(xué) 大數(shù)據(jù)與信息工程學(xué)院,貴州 貴陽 550025)

摘要:基于生物特征識(shí)別的身份認(rèn)證技術(shù)已經(jīng)應(yīng)用于多個(gè)領(lǐng)域,然而單一的生物特征有各自的優(yōu)缺點(diǎn),為了提高身份認(rèn)證的安全性和魯棒性,對(duì)多生物特征進(jìn)行融合便成為了身份認(rèn)證技術(shù)新的研究方向。將指紋識(shí)別和聲紋識(shí)別通過加權(quán)融合的方法在匹配層進(jìn)行融合,實(shí)驗(yàn)結(jié)果表明,融合系統(tǒng)的等錯(cuò)誤率(EER)比指紋識(shí)別和聲紋識(shí)別提高了0.3%~0.4%,證明了融合系統(tǒng)識(shí)別率有所提高。

關(guān)鍵詞:指紋識(shí)別;聲紋識(shí)別;融合;生物特征

0引言

在當(dāng)今這個(gè)信息發(fā)展的時(shí)代,身份認(rèn)證技術(shù)是保障信息安全的重要技術(shù)之一。由于人體的生物特征有指紋、聲紋等,因此屬于身體特征的識(shí)別方式有:指紋識(shí)別[1]、手指靜脈識(shí)別[1]、人臉識(shí)別[2]、聲紋識(shí)別[3-4]等。之所以生物特征被廣泛地應(yīng)用于身份認(rèn)證,是因?yàn)檫@種認(rèn)證方式具有穩(wěn)定性、無須記憶等優(yōu)點(diǎn)。

雖然生物特征識(shí)別技術(shù)有著眾多的優(yōu)點(diǎn),但是它在現(xiàn)實(shí)中的應(yīng)用并沒有想象中那么廣泛,而造成這種情況的原因有很多,如:利用指紋套復(fù)制指紋、說話人聲音的變化都會(huì)影響聲紋識(shí)別的效果。因此,將多種生物特征相結(jié)合既可以很好地彌補(bǔ)單一生物特征自身所帶來的缺陷,又可以提高身份認(rèn)證的識(shí)別率。

本文研究說話人識(shí)別與指紋識(shí)別的融合方式,采用自適應(yīng)加權(quán)融合方法,在分別對(duì)說話人識(shí)別與指紋識(shí)別進(jìn)行研究之后,對(duì)自適應(yīng)加權(quán)融合系統(tǒng)的識(shí)別率進(jìn)行研究,經(jīng)過實(shí)驗(yàn)結(jié)果的比較,證明融合的識(shí)別效果要比單一生物特征的識(shí)別率好。

1基于指紋識(shí)別的身份認(rèn)證

1.1指紋圖像建模

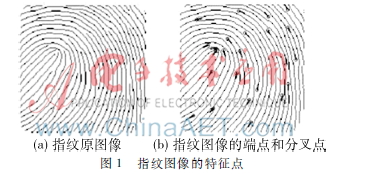

使用指紋[5]來進(jìn)行身份認(rèn)證,建模時(shí),系統(tǒng)對(duì)指紋圖片進(jìn)行特征提取,所提取的特征點(diǎn)為端點(diǎn)和分叉點(diǎn),并生成模板,而在特征提取前需要對(duì)圖片進(jìn)行預(yù)處理,通過確定的中心點(diǎn)的位置來確定分叉點(diǎn),最后得到的指紋特征用特征位置和方向來表示。指紋圖像所提取的特征點(diǎn)如圖1所示。

1.2指紋識(shí)別

在識(shí)別階段,所用的匹配方法是基于特征點(diǎn)模式,利用指紋圖像的細(xì)節(jié)點(diǎn)坐標(biāo)模型來做細(xì)節(jié)匹配,該方法是利用端點(diǎn)和分叉點(diǎn)來進(jìn)行指紋識(shí)別,它是利用幾何關(guān)系來判定模板圖像與測(cè)試圖像的兩組特征點(diǎn)位置特性的相似度,并且采用打分的方式輸出匹配的結(jié)果。具體的匹配方法可參閱參考文獻(xiàn)[1]。

1.3實(shí)驗(yàn)

在進(jìn)行指紋識(shí)別的研究時(shí),本次實(shí)驗(yàn)所用的數(shù)據(jù)是51個(gè)人的指紋數(shù)據(jù),每個(gè)人有不同的8張指紋圖片,為了實(shí)驗(yàn)方便,在實(shí)驗(yàn)的過程中均采用每個(gè)人的第一張圖片作為模板,剩余的7張圖片作為測(cè)試圖片,所得指紋識(shí)別系統(tǒng)的EER為0.367 8%。

2基于聲紋識(shí)別的身份認(rèn)證

2.1聲紋識(shí)別系統(tǒng)

聲紋識(shí)別又稱為說話人識(shí)別,其識(shí)別過程與指紋識(shí)別類似,首先需要對(duì)說話人語音進(jìn)行提取特征建模,然后再對(duì)測(cè)試語音提取特征并與模板進(jìn)行匹配,得到相應(yīng)的匹配結(jié)果。在本文中,聲紋識(shí)別所使用的模型為高斯混合模型通用背景模型(GMMUBM)[67]。所提取的特征是39維的MFCC(Mel頻率倒譜系數(shù))特征,其中包含13維的MFCC特征,并對(duì)每個(gè)特征向量進(jìn)行一階、二階的動(dòng)態(tài)差分。

2.2實(shí)驗(yàn)

聲紋識(shí)別實(shí)驗(yàn)所使用的數(shù)據(jù)庫(kù)是清華大學(xué)語音和語言技術(shù)中心所錄制的數(shù)據(jù)庫(kù),為了便于融合,所取人數(shù)與指紋實(shí)驗(yàn)人數(shù)相同,同為51人。與指紋識(shí)別不同的是,聲紋的訓(xùn)練語音為12條8位的數(shù)字串,且這12條語音合為一條語音來訓(xùn)練模型,訓(xùn)練語音為7條8位的數(shù)字串,所得聲紋識(shí)別系統(tǒng)的EER為0.476 7%。

3自適應(yīng)加權(quán)融合系統(tǒng)

3.1融合框架

本文中所稱的融合即數(shù)據(jù)融合,對(duì)應(yīng)于數(shù)據(jù)的抽象層次,可將數(shù)據(jù)融合分為4個(gè)層次:數(shù)據(jù)級(jí)融合、特征級(jí)融合、匹配級(jí)融合和決策級(jí)融合,在本文中將會(huì)在匹配級(jí)采用自適應(yīng)加權(quán)的融合算法。

3.2加權(quán)融合算法

匹配級(jí)融合有很多算法,但是較為簡(jiǎn)單的方法是對(duì)子模塊的匹配值進(jìn)行加權(quán)融合。而對(duì)于融合子模塊匹配值的常用方法有兩種:加法融合和乘法融合。其中乘法融合不常用,這是因?yàn)楫?dāng)其中一個(gè)子模塊本身匹配值極大或者極小時(shí),融合的最終結(jié)果都會(huì)受到該子模塊的影響。而對(duì)于加法融合,各個(gè)子模塊的匹配分?jǐn)?shù)之間沒有十分緊密的聯(lián)系,因此,即使某一個(gè)子模塊的匹配分?jǐn)?shù)出錯(cuò),也不會(huì)對(duì)整個(gè)融合的結(jié)果有太大的影響。

3.3歸一化處理

由于每一個(gè)子模塊的模型不同,因此所得的匹配分?jǐn)?shù)的形式也會(huì)有所不同,例如后驗(yàn)概率、距離度量等。本文中的指紋識(shí)別匹配分?jǐn)?shù)是利用幾何關(guān)系來判定模板圖像與測(cè)試圖像的兩組特征點(diǎn)位置特性的相似度,而聲紋識(shí)別的匹配分?jǐn)?shù)是求特征矢量序列X由說話人s產(chǎn)生的后驗(yàn)概率。顯然這兩種匹配值不可以直接用來當(dāng)作融合系統(tǒng)的輸入匹配值,在融合之前,需要對(duì)兩種匹配值進(jìn)行歸一化處理。

常用的數(shù)據(jù)歸一化方法有MinMax方法、MediaMAD方法、ZScore方法等,對(duì)于眾多的方法,本文采用MinMax方法進(jìn)行數(shù)值歸一化處理。最大最小值歸一化方法是:將所需處理的數(shù)值全都轉(zhuǎn)化到[0,1]的區(qū)間。假設(shè)有N個(gè)匹配距離值{dn}n=1,2,…,N,計(jì)算公式為:

d′n=dn-dmindmax-dmin,d∈[0,1](1)

其中,dmax和dmin分別是{dn}n=1,2,…,N的最大值和最小值。

3.4融合算法和權(quán)重的分配

假設(shè)聲紋識(shí)別子系統(tǒng)和指紋識(shí)別子系統(tǒng)均有M個(gè)歸一化后的匹配值,分別記為:指紋子系統(tǒng){s(Ofinger|λi)}i=1,2,…,M和聲紋子系統(tǒng){s(Ospeaker|λi)}i=1,2,…,M ,根據(jù)加權(quán)的加法融合方法,融合后的匹配計(jì)算公式為:

s(OfingerOspeaker|λi)=αs(Ospeaker|λi)+βs(Ofinger|λi),

i=1,2,…,M(2)

其中,α+β=1;s(OfingerOspeaker|λi)表示在輸入聲紋識(shí)別子系統(tǒng)和指紋識(shí)別子系統(tǒng)的歸一化匹配值后的聯(lián)合匹配分?jǐn)?shù),與單一子系統(tǒng)的匹配分?jǐn)?shù)相同,分?jǐn)?shù)值越高,表明測(cè)試體與模板越匹配,反之,則不匹配。

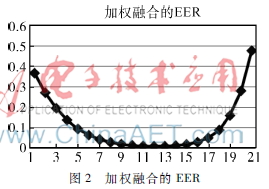

為了得到一個(gè)穩(wěn)定且可靠的融合系統(tǒng),將指紋識(shí)別數(shù)據(jù)庫(kù)和聲紋識(shí)別數(shù)據(jù)庫(kù)的人數(shù)分為3組,分別為A組、B組、C組,將采取3組測(cè)試。第一組測(cè)試,取A組的數(shù)據(jù)來確定權(quán)值,融合權(quán)重的α值將從0取到1,其中以0.05的步長(zhǎng)逐漸遞增,如此可得到21組融合后的數(shù)值,從這21組的數(shù)值中可找出EER最小的一組權(quán)值作為融合系統(tǒng)最優(yōu)的權(quán)重,并用這組權(quán)重值對(duì)B組和C組的數(shù)據(jù)進(jìn)行加權(quán)融合,得到EER1。依照相同的方法進(jìn)行其余兩組測(cè)試,且分別用B組、C組的數(shù)據(jù)確定權(quán)值,并得到相應(yīng)的EER2和EER3。比較3個(gè)EER值的大小,得到最小的EER值,而該值所對(duì)應(yīng)的權(quán)值即為整個(gè)融合系統(tǒng)最優(yōu)的權(quán)重,也是最終所采用的權(quán)重。

4實(shí)驗(yàn)

4.1數(shù)據(jù)庫(kù)

加權(quán)融合所使用的數(shù)據(jù)庫(kù)就是之前指紋識(shí)別與聲紋識(shí)別所使用的數(shù)據(jù)庫(kù),兩方各51人,每個(gè)人都有8條數(shù)據(jù),且取第一條數(shù)據(jù)來訓(xùn)練模型,得到訓(xùn)練集;剩下的7條數(shù)據(jù)做測(cè)試,得到測(cè)試集。

4.2實(shí)驗(yàn)結(jié)果及分析

根據(jù)第3節(jié)所提到的方法得到的最優(yōu)權(quán)重,使用該權(quán)重對(duì)數(shù)據(jù)進(jìn)行融合,對(duì)于系統(tǒng)的性能,將會(huì)以EER的值來體現(xiàn),具體的實(shí)驗(yàn)結(jié)果如圖2所示。從圖2可以很明顯地看出,當(dāng)α的值從0到1以0.05的步長(zhǎng)逐漸增長(zhǎng)時(shí),EER的值呈U形曲線變化;當(dāng)α的值為0.55時(shí),EER的值達(dá)到最小,其值為0.013 11。換言之,此時(shí)的融合系統(tǒng)達(dá)到最好的狀態(tài),其識(shí)別率和穩(wěn)定性優(yōu)于取其他權(quán)重的時(shí)刻。較單一的指紋識(shí)別或是聲紋識(shí)別,加權(quán)融合的EER有了很大的提高,說明采用加權(quán)融合的方法將聲紋識(shí)別和指紋識(shí)別相結(jié)合是有利于系統(tǒng)性能的。

5結(jié)論

無論是基于哪種生物特征識(shí)別的身份認(rèn)證技術(shù),它們都有各自的優(yōu)勢(shì)和劣勢(shì),為了更好地提高身份認(rèn)證的安全性和識(shí)別率,可以從多個(gè)層次考慮多個(gè)生物特征識(shí)別的融合。本文在匹配層采用加權(quán)融合的算法對(duì)聲紋識(shí)別和指紋識(shí)別進(jìn)行融合,實(shí)驗(yàn)結(jié)果也證明了融合效果要好于單一的生物特征識(shí)別,同時(shí)也證明了融合的可行性。在今后的研究中,可以從其他層次對(duì)兩種識(shí)別進(jìn)行融合,以求得到更好的融合系統(tǒng)。

參考文獻(xiàn)

[1] 李雪峰.基于指紋與手指靜脈的雙模態(tài)識(shí)別算法研究[D].哈爾濱:哈爾濱工程大學(xué),2010.

[2] 陳倩.多生物特征融合身份識(shí)別研究[D].杭州:浙江大學(xué) 2007.

[3] 熊振宇.大規(guī)模、開集、文本無關(guān)說話人辨認(rèn)研究[D].北京:清華大學(xué),2005.

[4] 陶佰睿,郭琴,李春輝,等.聲紋認(rèn)證前端音頻預(yù)處理SOPC設(shè)計(jì)[J].電子技術(shù)應(yīng)用,2014,40(9):2426.

[5] 曾杰,吳曉紅,吳小強(qiáng),等.基于QT/E和指紋識(shí)別模塊的巖屑圖像采集系統(tǒng)的設(shè)計(jì)[J].微型機(jī)與應(yīng)用,2014,33(24):3841.

[6] KENNY P. Bayesian speaker verification with heavy tailed priors[C]. Speaker and Language Recognition Workshop (IEEE Odyssey), 2010.

[7] GHARAMANI Z, HINTON G E. The EM algorithm for mixtures of factor analyzers[R]. Technical Report CRGTR961, Department of Computer Science, University of Toronto, 1996.5.