在過去的2016年,在計(jì)算機(jī)產(chǎn)業(yè)來說,,相信沒有一個(gè)概念比人工智能更熱門,。跨入2017年,,專家們表示,,人工智能生態(tài)圈的需求增長會(huì)更加迅猛。主要集中在為深度神經(jīng)網(wǎng)絡(luò)找尋性能和效率更適合的“引擎”,。

現(xiàn)在的深度學(xué)習(xí)系統(tǒng)依賴于軟件定義網(wǎng)絡(luò)和大數(shù)據(jù)學(xué)習(xí)產(chǎn)生的超大型運(yùn)算能力,,并靠此來實(shí)現(xiàn)目標(biāo)。但很遺憾的是,,這類型的運(yùn)算配置是很難嵌入到那些運(yùn)算能力,、存儲(chǔ)大小,、和帶寬都有限制的系統(tǒng)中(例如汽車、無人機(jī)和物聯(lián)網(wǎng)設(shè)備),。

這就給業(yè)界提出了一個(gè)新的挑戰(zhàn),,如何通過創(chuàng)新,把深度神經(jīng)網(wǎng)絡(luò)的運(yùn)算能力嵌入到終端設(shè)備中去,。

Movidius公司的CEO Remi El-Ouazzane在幾個(gè)月前說過,,將人工智能擺在網(wǎng)絡(luò)的邊緣將會(huì)是一個(gè)大趨勢。

芯片藍(lán)海爭奪 誰能最后勝出" src="http://images.ofweek.com/Upload/News/2016-12/26/lin/1482737178651096403.png" width="500" height="317"/>

Remi El-Ouazzane

在問到為什么人工智能會(huì)被“趕”到網(wǎng)絡(luò)邊緣的時(shí)候,,CEA Architecture Fellow Marc Duranton給出了三個(gè)原因:分別是安全,、隱私和經(jīng)濟(jì)。他認(rèn)為這三點(diǎn)是驅(qū)動(dòng)業(yè)界在終端處理數(shù)據(jù)的重要因素,。他指出,,未來將會(huì)衍生更多“將數(shù)據(jù)轉(zhuǎn)化為信息”的需求。并且這些數(shù)據(jù)越早處理越好,,他補(bǔ)充說,。

CEA Architecture Fellow Marc Duranton

攝像一下,假如你的無人駕駛汽車是安全的,,那么這些無人駕駛功能就不需要長時(shí)間依賴于聯(lián)盟處理,;假設(shè)老人在家里跌倒了,那么這種情況當(dāng)場就應(yīng)該檢測到并判斷出來,??紤]到隱私原因,這些是非常重要的,,Duranton強(qiáng)調(diào),。

但這并不意味著收集家里十個(gè)攝像頭的所有圖片,并傳送給我,,就稱作一個(gè)號的提醒,。這也并不能降低“能耗、成本和數(shù)據(jù)大小”,,Duranton補(bǔ)充說,。

競賽正式開啟

從現(xiàn)在的情景看來,芯片供應(yīng)商已經(jīng)意識(shí)到推理機(jī)的增長需求,。包括Movidus (Myriad 2),, Mobileye (EyeQ 4 & 5) 和Nvidia (Drive PX)在內(nèi)的眾多半導(dǎo)體公司正在角逐低功耗、高性能的硬件加速器,。幫助開發(fā)者更好的在嵌入式系統(tǒng)中執(zhí)行“學(xué)習(xí)”,。

從這些廠商的動(dòng)作和SoC的發(fā)展方向看來,在后智能手機(jī)時(shí)代,,推理機(jī)已經(jīng)逐漸成為半導(dǎo)體廠商追逐的下一個(gè)目標(biāo)市場,。

在今年早些時(shí)候,,Google的TPU橫空出世,昭示著業(yè)界意圖在機(jī)器學(xué)習(xí)芯片中推動(dòng)創(chuàng)新的的意圖,。在發(fā)布這個(gè)芯片的時(shí)候,,搜索巨人表示,TPU每瓦性能較之傳統(tǒng)的FPGA和GPU將會(huì)高一個(gè)數(shù)量級,。Google還表示,,這個(gè)加速器還被應(yīng)用到了今年年初風(fēng)靡全球的AlphaGo系統(tǒng)里面。

但是從發(fā)布到現(xiàn)在,,Google也從未披露過TPU的具體細(xì)節(jié),,更別說把這個(gè)產(chǎn)品對外出售。

很多SoC從業(yè)者從谷歌的TPU中得出了一個(gè)結(jié)論,,他們認(rèn)為,,機(jī)器學(xué)習(xí)需要定制化的架構(gòu)。但在他們針對機(jī)器學(xué)習(xí)做芯片設(shè)計(jì)的時(shí)候,,他們又會(huì)對芯片的架構(gòu)感到懷疑和好奇,。同時(shí)他們想知道業(yè)界是否已經(jīng)有了一種衡量不同形態(tài)下深度神經(jīng)網(wǎng)絡(luò)(DNN)性能的工具。

工具已經(jīng)到來

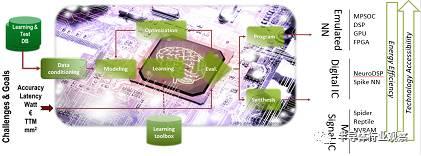

CEA聲稱,,他們已經(jīng)為幫推理機(jī)探索不同的硬件架構(gòu)做好了準(zhǔn)備,,他們已經(jīng)開發(fā)出了一個(gè)叫做N2D2,的軟件架構(gòu),。他們夠幫助設(shè)計(jì)者探索和聲稱DNN架構(gòu),。“我們開發(fā)這個(gè)工具的目的是為了幫助DNN選擇適合的硬件”,,Duranton說,。到2017年第一季度,這個(gè)N2D2會(huì)開源,。Duranton承諾。

N2D2的特點(diǎn)在于不僅僅是在識(shí)別精度的基礎(chǔ)上對比硬件,,它還能從處理時(shí)間,、硬件成本和能源損耗的多個(gè)方面執(zhí)行對比。因?yàn)獒槍Σ煌纳疃葘W(xué)習(xí)應(yīng)用,,其所需求的硬件配置參數(shù)都是不一樣的,,所以說以上幾點(diǎn)才是最重要的,Duranton表示,。

N2D2的工作原理

N2D2為現(xiàn)存的CPU,、GPU和FPGA提供了一個(gè)參考標(biāo)準(zhǔn)。

邊緣計(jì)算的障礙

作為一個(gè)資深的研究組織,,CEA已經(jīng)在如何把DNN完美的推廣到邊緣計(jì)算領(lǐng)域進(jìn)行了長時(shí)間的深入研究,。在問到執(zhí)行這種推進(jìn)的障礙時(shí),,Duranton指出,由于功耗,、尺寸和延遲的限制,,這些“浮點(diǎn)”服務(wù)器方案不能應(yīng)用。這就是最大的障礙,。而其他的障礙包括了“大量的Mac,、帶寬和芯片上存儲(chǔ)的尺寸”,Duranton補(bǔ)充說,。

那就是說如何整合這種“浮點(diǎn)”方式,,是最先應(yīng)該被解決的問題。

Duranton認(rèn)為,,一些新的架構(gòu)是在所難免的,,隨之而來的一些類似“spike code”的新coding也是必然的。

經(jīng)過CEA的研究指出,,甚至二進(jìn)制編碼都不是必須的,。他們認(rèn)為類似spike coding這類的時(shí)間編碼在邊緣能夠迸發(fā)出更強(qiáng)大的能量。

Spike coding之所以受歡迎,,是因?yàn)樗苊鞔_展示神經(jīng)系統(tǒng)內(nèi)的數(shù)據(jù)解碼,。往深里講,就是說這些基于事件的的編碼能夠兼容專用的傳感器和預(yù)處理,。

這種和神經(jīng)系統(tǒng)極度相似的編碼方式使得混合模擬和數(shù)字信號更容易實(shí)現(xiàn),,這也能夠幫助研究者打造低功耗的硬件加速器。

CEA也正在思考把神經(jīng)網(wǎng)絡(luò)架構(gòu)調(diào)整到邊緣計(jì)算的潛在可能,。Duranton指出,,現(xiàn)在人們正在推動(dòng)使用‘SqueezeNet取替AlexNet。據(jù)報(bào)道,,為達(dá)到同等精度,,使用前者比后者少花50倍的參數(shù)。這類的簡單配置對于邊緣計(jì)算,、拓?fù)鋵W(xué)和降低Mac的數(shù)量來說,,都是很重要的。

Duranton認(rèn)為,,從經(jīng)典的DNN轉(zhuǎn)向嵌入式網(wǎng)絡(luò)是一種自發(fā)的行為,。

P-Neuro,一個(gè)臨時(shí)的芯片

CEA的野心是去開發(fā)一個(gè)神經(jīng)形態(tài)的電路,。研究機(jī)構(gòu)認(rèn)為,,在深度學(xué)習(xí)中,這樣的一個(gè)芯片是推動(dòng)把數(shù)據(jù)提取放在傳感器端的一個(gè)有效補(bǔ)充,。

但在達(dá)到這個(gè)目標(biāo)之前,,CEA相處了很多權(quán)宜之計(jì),。例如開發(fā)出D2N2這樣的工具,幫助芯片開發(fā)者開發(fā)出高TOPS的DNN解決方案,。

而對于那些想把DNN轉(zhuǎn)移到邊緣計(jì)算的玩家來說,,他們也有相對應(yīng)的硬件去實(shí)現(xiàn)。這就是CEA提供的低功耗可編程加速器——P-Neuro?,F(xiàn)行的P-Neuro芯片是基于FPGA開發(fā)的,。但Duranton表示,他們已經(jīng)把這個(gè)FPAG變成了一個(gè)ASIC,。

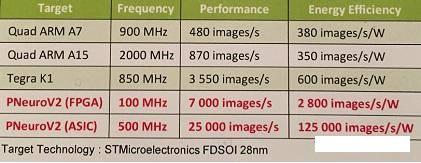

和嵌入式CPU對比的P-Neuro demo

在CEA的實(shí)驗(yàn)室,,Duranton他們已經(jīng)在這個(gè)基于FPAG的P-Neuro搭建了一個(gè)面部識(shí)別的卷積神經(jīng)網(wǎng)絡(luò)(CNN)。這個(gè)基于 P-Neuro的Demo和嵌入式CPU做了對比,。(樹莓派,、帶有三星Exynos處理器的安卓設(shè)備)。他們同樣都運(yùn)行相同的CNN應(yīng)用,。他們都安排去從18000個(gè)圖片的數(shù)據(jù)庫中去執(zhí)行“人臉特征提取”,。

根據(jù)示例展示,P-Neuro的速度是6942張圖片每秒,,而功耗也只是2776張圖每瓦,。

P-Neuro和GPU、CPU的對比

如圖所示,,和Tegra K1相比,,基于FPGA的P-Neuro在100Mhz工作頻率的時(shí)候,工作更快,,且功耗更低,。

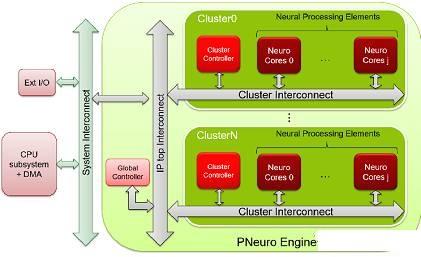

P-Neuro是基于集群的SIMD架構(gòu)打造,這個(gè)架構(gòu)是以優(yōu)化的分級存儲(chǔ)器體系和內(nèi)部連接被大家熟知的,。

P-Neuro的框圖

對于CEA的研究者來說 ,,P-Neuro 只是一個(gè)短期方案。現(xiàn)行的 P-Neuro 是在一個(gè)CMOS設(shè)備上打造的,,使用的是二進(jìn)制編碼,。他們團(tuán)隊(duì)正在打造一個(gè)全CMOS方案,并打算用spike coding,。

為了充分利用先進(jìn)設(shè)備的優(yōu)勢,并且打破密度和功率的問題,,他們團(tuán)隊(duì)設(shè)立了一個(gè)更高的目標(biāo),。他們考慮過把RRAM當(dāng)做突觸元素,還考慮過FDSOI和納米線這樣的制程,。

在一個(gè)“EU Horizon 2020”的計(jì)劃里面,,他們希望做出一個(gè)神經(jīng)形態(tài)架構(gòu)的芯片,,能夠支持最先進(jìn)的機(jī)器學(xué)習(xí)。同時(shí)還是一個(gè)基于spike的學(xué)習(xí)機(jī)制,。

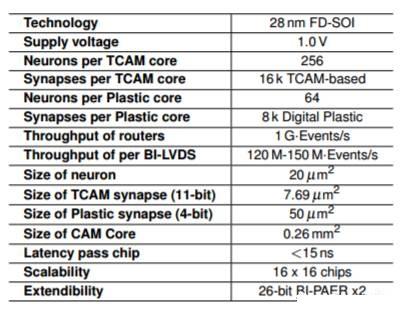

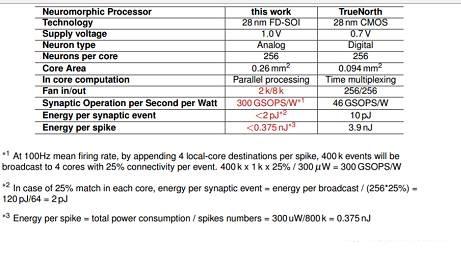

Neuromorphic處理器

這就是一個(gè)叫做NeuRAM3的項(xiàng)目,。屆時(shí),他們的芯片會(huì)擁有超低功耗,、尺寸和高度可配置的神經(jīng)架構(gòu),。他們的目標(biāo)是較之傳統(tǒng)方案,打造一個(gè)能將功耗降低50倍的產(chǎn)品,。

Neuromorphic處理器

Neuromorphic處理器的基本參數(shù)

據(jù)介紹,,這個(gè)方案包含了基于FD-SOI工藝的整體集成的3D技術(shù),另外還用到的RRAM來做突觸元素,。在NeuRAM3項(xiàng)目之下,,這個(gè)新型的混合信號多核神經(jīng)形態(tài)芯片設(shè)備較之IBM的TrueNorth,能明顯降低功耗,。

與IBM的TrueNorth對比

而NeuRAM3項(xiàng)目的參與者包括了IMEC,, IBM Zurich, ST Microelectronics,, CNR (The National Research Council in Italy),, IMSE (El Instituto de Microelectrónica de Sevilla in Spain), 蘇黎世大學(xué)和德國的雅各布大學(xué),。

更多AI芯片角逐

其實(shí)AI芯片這個(gè)市場,,已經(jīng)吸引了很多玩家,無論是傳統(tǒng)的半導(dǎo)體業(yè)者,,還是所謂的初創(chuàng)企業(yè),,都開始投奔這個(gè)下一個(gè)金礦。除了上面說的CEA這個(gè),。我們不妨來看一下市場上還有哪些AI芯片,。

一、傳統(tǒng)廠商的跟進(jìn)

(1)Nvidia

英偉達(dá)是GPU霸主,,雖然錯(cuò)過了移動(dòng)時(shí)代,,但他們似乎在AI時(shí)代,重獲榮光,,從其過去一年內(nèi)的股票走勢,,就可以看到市場對他們的信心。我們來看一下他有什么計(jì)劃,,在這個(gè)領(lǐng)域,。

在今年四月,Nvidia發(fā)布了一個(gè)先進(jìn)的機(jī)器學(xué)習(xí)芯片——Tesla P100 GPU。按照英偉達(dá)CEO黃仁勛所說,,這個(gè)產(chǎn)品較之英偉達(dá)的前代產(chǎn)品,,任務(wù)處理速度提高了12倍。這個(gè)耗費(fèi)了20億美元開發(fā)的芯片上面集成了1500億個(gè)晶體管,。

據(jù)介紹,,全新的 NVIDIA Pascal? 架構(gòu)讓 Tesla P100 能夠?yàn)?HPC 和超大規(guī)模工作負(fù)載提供超高的性能。憑借每秒超過 20 萬億次的 FP16 浮點(diǎn)運(yùn)算性能,,經(jīng)過優(yōu)化的 Pascal 為深度學(xué)習(xí)應(yīng)用程序帶來了令人興奮的新可能,。

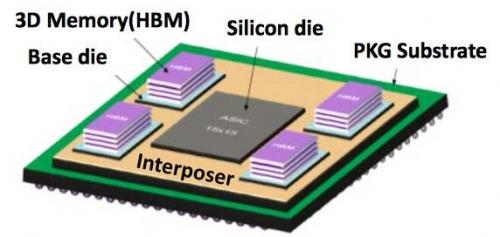

而通過加入采用 HBM2 的 CoWoS(晶圓基底芯片)技術(shù),Tesla P100 將計(jì)算和數(shù)據(jù)緊密集成在同一個(gè)程序包內(nèi),,其內(nèi)存性能是上一代解決方案的 3 倍以上,。這讓數(shù)據(jù)密集型應(yīng)用程序的問題解決時(shí)間實(shí)現(xiàn)了跨時(shí)代的飛躍。

再者,,因?yàn)榇钶d了 NVIDIA NVLink? 技術(shù),, Tesla P100的快速節(jié)點(diǎn)可以顯著縮短為具備強(qiáng)擴(kuò)展能力的應(yīng)用程序提供解決方案的時(shí)間。采用 NVLink 技術(shù)的服務(wù)器節(jié)點(diǎn)可以 5 倍的 PCIe 帶寬互聯(lián)多達(dá)八個(gè) Tesla P100,。這種設(shè)計(jì)旨在幫助解決擁有極大計(jì)算需求的 HPC 和深度學(xué)習(xí)領(lǐng)域的全球超級重大挑戰(zhàn),。

(2)Intel

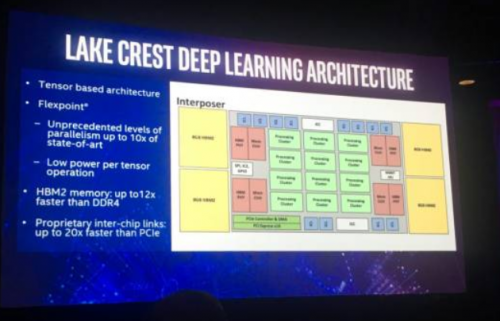

在今年十一月。Intel公司發(fā)布了一個(gè)叫做Nervana的AI處理器,,他們宣稱會(huì)在明年年中測試這個(gè)原型,。如果一切進(jìn)展順利,Nervana芯片的最終形態(tài)會(huì)在2017年底面世,。這個(gè)芯片是基于Intel早前購買的一個(gè)叫做Nervana的公司,。按照Intel的人所說,這家公司是地球上第一家專門為AI打造芯片的公司,。

Intel公司披露了一些關(guān)于這個(gè)芯片的一些細(xì)節(jié),,按照他們所說,這個(gè)項(xiàng)目代碼為“Lake Crest”,,將會(huì)用到Nervana Engine 和Neon DNN相關(guān)軟件,。。這款芯片可以加速各類神經(jīng)網(wǎng)絡(luò),,例如谷歌TensorFlow框架,。芯片由所謂的“處理集群”陣列構(gòu)成,處理被稱作“活動(dòng)點(diǎn)”的簡化數(shù)學(xué)運(yùn)算,。相對于浮點(diǎn)運(yùn)算,,這種方法所需的數(shù)據(jù)量更少,因此帶來了10倍的性能提升,。

Lake Crest利用私有的數(shù)據(jù)連接創(chuàng)造了規(guī)模更大,、速度更快的集群,其拓?fù)浣Y(jié)構(gòu)為圓環(huán)形或其他形式。這幫助用戶創(chuàng)造更大,、更多元化的神經(jīng)網(wǎng)絡(luò)模型。這一數(shù)據(jù)連接中包含12個(gè)100Gbps的雙向連接,,其物理層基于28G的串并轉(zhuǎn)換,。

這一2.5D芯片搭載了32GB的HBM2內(nèi)存,內(nèi)存帶寬為8Tbps,。芯片中沒有緩存,,完全通過軟件去管理片上存儲(chǔ)。

英特爾并未透露這款產(chǎn)品的未來路線圖,,僅僅表示計(jì)劃發(fā)布一個(gè)名為Knights Crest的版本,。該版本將集成未來的至強(qiáng)處理器和Nervana加速處理器。預(yù)計(jì)這將會(huì)支持Nervana的集群,。不過英特爾沒有透露,,這兩大類型的芯片將如何以及何時(shí)實(shí)現(xiàn)整合。

至于整合的版本將會(huì)有更強(qiáng)的性能,,同時(shí)更易于編程,。目前基于圖形處理芯片(GPU)的加速處理器使編程變得更復(fù)雜,因?yàn)殚_發(fā)者要維護(hù)單獨(dú)的GPU和CPU內(nèi)存,。

據(jù)透露,,到2020年,英特爾將推出芯片,,使神經(jīng)網(wǎng)絡(luò)訓(xùn)練的性能提高100倍,。一名分析師表示,這一目標(biāo)“極為激進(jìn)”,。毫無疑問,,英特爾將迅速把這一架構(gòu)轉(zhuǎn)向更先進(jìn)的制造工藝,與已經(jīng)采用14納米或16納米FinFET工藝的GPU展開競爭,。

(3)IBM

百年巨人IBM,,在很早以前就發(fā)布過wtson,現(xiàn)在他的人工智能機(jī)器早就投入了很多的研制和研發(fā)中去,。而在去年,,他也按捺不住,投入到類人腦芯片的研發(fā),,那就是TrueNorth,。

TrueNorth是IBM參與DARPA的研究項(xiàng)目SyNapse的最新成果。SyNapse全稱是Systems of Neuromorphic Adaptive Plastic Scalable Electronics(自適應(yīng)可塑可伸縮電子神經(jīng)系統(tǒng),,而SyNapse正好是突觸的意思),,其終極目標(biāo)是開發(fā)出打破馮?諾依曼體系的硬件。

這種芯片把數(shù)字處理器當(dāng)作神經(jīng)元,把內(nèi)存作為突觸,,跟傳統(tǒng)馮諾依曼結(jié)構(gòu)不一樣,,它的內(nèi)存、CPU和通信部件是完全集成在一起,。因此信息的處理完全在本地進(jìn)行,,而且由于本地處理的數(shù)據(jù)量并不大,傳統(tǒng)計(jì)算機(jī)內(nèi)存與CPU之間的瓶頸不復(fù)存在了,。同時(shí)神經(jīng)元之間可以方便快捷地相互溝通,,只要接收到其他神經(jīng)元發(fā)過來的脈沖(動(dòng)作電位),這些神經(jīng)元就會(huì)同時(shí)做動(dòng)作,。

2011年的時(shí)候,,IBM首先推出了單核含256 個(gè)神經(jīng)元,256×256 個(gè)突觸和 256 個(gè)軸突的芯片原型,。當(dāng)時(shí)的原型已經(jīng)可以處理像玩Pong游戲這樣復(fù)雜的任務(wù),。不過相對來說還是比較簡單,從規(guī)模上來說,,這樣的單核腦容量僅相當(dāng)于蟲腦的水平,。

不過,經(jīng)過3年的努力,,IBM終于在復(fù)雜性和使用性方面取得了突破,。4096個(gè)內(nèi)核,100萬個(gè)“神經(jīng)元”,、2.56億個(gè)“突觸”集成在直徑只有幾厘米的方寸(是2011年原型大小的1/16)之間,,而且能耗只有不到70毫瓦,IBM的集成的確令人印象深刻,。

這樣的芯片能夠做什么事情呢,?IBM研究小組曾經(jīng)利用做過DARPA 的NeoVision2 Tower數(shù)據(jù)集做過演示。它能夠?qū)崟r(shí)識(shí)別出用30幀每秒的正常速度拍攝自斯坦福大學(xué)胡佛塔的十字路口視頻中的人,、自行車,、公交車、卡車等,,準(zhǔn)確率達(dá)到了80%,。相比之下,一臺(tái)筆記本編程完成同樣的任務(wù)用時(shí)要慢100倍,,能耗卻是IBM芯片的1萬倍,。

跟傳統(tǒng)計(jì)算機(jī)用FLOPS(每秒浮點(diǎn)運(yùn)算次數(shù))衡量計(jì)算能力一樣,IBM使用SOP(每秒突觸運(yùn)算數(shù))來衡量這種計(jì)算機(jī)的能力和能效,。其完成460億SOP所需的能耗僅為1瓦—正如文章開頭所述,,這樣的能力一臺(tái)超級計(jì)算機(jī),,但是一塊小小的助聽器電池即可驅(qū)動(dòng)。

通信效率極高,,從而大大降低能耗這是這款芯片最大的賣點(diǎn),。TrueNorth的每一內(nèi)核均有256個(gè)神經(jīng)元,每一個(gè)神經(jīng)有分別都跟內(nèi)外部的256個(gè)神經(jīng)元連接,。

(4)Google

其實(shí)在Google上面,,我是很糾結(jié)的,這究竟是個(gè)新興勢力,,還是傳統(tǒng)公司。但考慮到Google已經(jīng)那么多年了,,我就把他放在傳統(tǒng)里面吧,。雖然傳統(tǒng)也是很新的。而谷歌的人工智能相關(guān)芯片就是TPU,。也就是Tensor Processing Unit,。

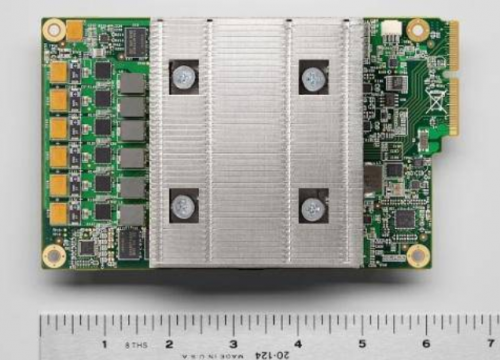

TPU是專門為機(jī)器學(xué)習(xí)應(yīng)用而設(shè)計(jì)的專用芯片。通過降低芯片的計(jì)算精度,,減少實(shí)現(xiàn)每個(gè)計(jì)算操作所需的晶體管數(shù)量,,從而能讓芯片的每秒運(yùn)行的操作個(gè)數(shù)更高,這樣經(jīng)過精細(xì)調(diào)優(yōu)的機(jī)器學(xué)習(xí)模型就能在芯片上運(yùn)行的更快,,進(jìn)而更快的讓用戶得到更智能的結(jié)果,。Google將TPU加速器芯片嵌入電路板中,利用已有的硬盤PCI-E接口接入數(shù)據(jù)中心服務(wù)器中,。

據(jù)Google 資深副總Urs Holzle 透露,,當(dāng)前Google TPU、GPU 并用,,這種情況仍會(huì)維持一段時(shí)間,,但也語帶玄機(jī)表示,GPU 過于通用,,Google 偏好專為機(jī)器學(xué)習(xí)設(shè)計(jì)的芯片,。GPU 可執(zhí)行繪圖運(yùn)算工作,用途多元,;TPU 屬于ASIC,,也就是專為特定用途設(shè)計(jì)的特殊規(guī)格邏輯IC,由于只執(zhí)行單一工作,,速度更快,,但缺點(diǎn)是成本較高。至于CPU,,Holzle 表示,,TPU 不會(huì)取代CPU,,研發(fā)TPU 只是為了處理尚未解決的問題。但是他也指出,,希望芯片市場能有更多競爭,。

如果AI算法改變了(從邏輯上講隨著時(shí)間的推移算法應(yīng)該會(huì)改變),你是不是想要一款可以重新編程的芯片,,以適應(yīng)這些改變,?如果情況是這樣的,另一種芯片適合,,它就是FPGA(現(xiàn)場可編程門陣列),。FPGA可以編程,和ASIC不同,。微軟用一些FPGA芯片來增強(qiáng)必應(yīng)搜索引擎的AI功能,。我們很自然會(huì)問:為什么不使用FPGA呢?

谷歌的回答是:FPGA的計(jì)算效率比ASIC低得多,,因?yàn)樗梢跃幊?。TPU擁有一個(gè)指令集,當(dāng)TensorFlow程序改變時(shí),,或者新的算法出現(xiàn)時(shí),,它們可以在TPU上運(yùn)行。

現(xiàn)在問題的答案開始浮現(xiàn),。在谷歌看來,,能耗是一個(gè)重要的考量標(biāo)準(zhǔn),數(shù)據(jù)中心相當(dāng)巨大,,建設(shè)在世界各地,,包括芬蘭和臺(tái)灣。能耗越高,,運(yùn)營的成本就越高,,隨著時(shí)間的推移實(shí)際消耗的金錢會(huì)成倍增長。谷歌工程師對比了FPGA和ASIC的效率,,最終決定選擇ASIC,。

問題的第二部分與TPU的指令集有關(guān)。這是一套基本的命令,,它以硬編碼形式存在于芯片中,,能夠識(shí)別、執(zhí)行,;在芯片世界,,指令集是計(jì)算機(jī)運(yùn)行的基礎(chǔ)。

在開發(fā)TPU指令集時(shí),,它是專門用來運(yùn)行TensorFlow的,,TensorFlow是一個(gè)開源軟件庫,,針對的是AI應(yīng)用的開發(fā)。谷歌認(rèn)為,,如果AI有必要在底層進(jìn)行改變,,極可能發(fā)生在軟件上,芯片應(yīng)該具備彈性,,以適應(yīng)這種改變,。

TPU架構(gòu)的技術(shù)細(xì)節(jié)讓許多了解芯片的人驚奇。Anandtech的Joshua Ho有一個(gè)有趣的理論:TPU更加類似于第三類芯片,,也就是所謂的數(shù)字信號處理器(Digital Signal Processor),。

(5)微軟

這是又一個(gè)由軟轉(zhuǎn)硬的代表,微軟蟄伏六年,,打造出了一個(gè)迎接AI世代的芯片,。那就是Project Catapult。

據(jù)介紹,,這個(gè)FPGA 目前已支持微軟Bing,未來它們將會(huì)驅(qū)動(dòng)基于深度神經(jīng)網(wǎng)絡(luò)——以人類大腦結(jié)構(gòu)為基礎(chǔ)建模的人工智能——的新搜索算法,,在執(zhí)行這個(gè)人工智能的幾個(gè)命令時(shí),,速度比普通芯片快上幾個(gè)數(shù)量級。有了它,,你的計(jì)算機(jī)屏幕只會(huì)空屏 23 毫秒而不是 4 秒,。

在第三代原型中,芯片位于每個(gè)服務(wù)器的邊緣,,直接插入到網(wǎng)絡(luò),,但仍舊創(chuàng)造任何機(jī)器都可接入的 FPGA 池。這開始看起來是 Office 365 可用的東西了,。最終,,Project Catapult 準(zhǔn)備好上線了。另外,,Catapult 硬件的成本只占了服務(wù)器中所有其他的配件總成本的 30%,,需要的運(yùn)轉(zhuǎn)能量也只有不到 10%,但其卻帶來了 2 倍原先的處理速度,。

另外還有賽靈思,、高通、中國寒武紀(jì)等一系列芯片投入到AI的研發(fā),。我們暫且按下,。先看一下新興的AI芯片勢力。

二,、新興勢力

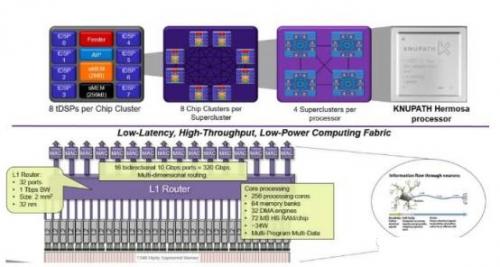

(1)KnuEdge

KnuEdge實(shí)際上并不是一個(gè)初創(chuàng)公司,,它由NASA的前任負(fù)責(zé)人創(chuàng)立,,已經(jīng)在一個(gè)隱形模式下運(yùn)營了10年。KnuEdge最近從隱形的模式中走出,,并讓全世界知道他們從一個(gè)匿名的投資人獲取1億美元的投資用來開發(fā)一個(gè)新的“神經(jīng)元芯片”,。

KUNPATH提供基于LambaFabric的芯片技術(shù),LambaFabric將會(huì)通過與現(xiàn)在市場上的GPUs,、CPUs和FPGAs完全不同的架構(gòu)進(jìn)行神經(jīng)網(wǎng)絡(luò)的計(jì)算,。

LambdaFabric本質(zhì)上是為在高要求的運(yùn)算環(huán)境下向上拓展至512000臺(tái)設(shè)備而設(shè)計(jì),機(jī)架至機(jī)架延遲時(shí)間只有400毫微秒,,低功耗的256核處理器,。

KNUPATH技術(shù)以生物學(xué)原理為基礎(chǔ),將會(huì)重新定義數(shù)據(jù)中心和消費(fèi)設(shè)備市場中的芯片級/系統(tǒng)級計(jì)算,。

對比其他相似的芯片,,這個(gè)芯片技術(shù)應(yīng)提供2倍到6倍的性能優(yōu)勢,并且公司已經(jīng)通過銷售他們的樣機(jī)系統(tǒng)獲得了收入,。在“KnuEdge傘形結(jié)構(gòu)”下,,KnuEdge由3個(gè)單獨(dú)的公司組成,KnuPath提供他們的芯片,,KnuVerse提供通過驗(yàn)證的軍事級的語音識(shí)別和驗(yàn)證技術(shù),,Knurld.io是一個(gè)允許開發(fā)者們?nèi)ズ唵蔚厝诤险Z音驗(yàn)證到他們的專利產(chǎn)品的公共云API服務(wù)(Public cloud API service)。KnuEdge宣稱,,現(xiàn)在只需要對著麥克風(fēng)說幾個(gè)詞就可以做到驗(yàn)證電腦,、網(wǎng)絡(luò)、移動(dòng)應(yīng)用和物聯(lián)網(wǎng)設(shè)備,。以后再也不用記住密碼將會(huì)是一件多棒的事情,?

(2)Nervana

這個(gè)公司已經(jīng)被英特爾收購了,但我覺得我還是有必要介紹一下這個(gè)公司,。Nervana創(chuàng)立于2014年,,位于圣地亞哥的初創(chuàng)公司Nervana Systems已經(jīng)從20家不同的投資機(jī)構(gòu)那里獲得了2440萬美元資金,而其中一家是十分受人尊敬的德豐杰風(fēng)險(xiǎn)投資公司(Draper Fisher Jurvetson,,DFJ),。

在·The Nervana Engine(將于2017年問世)是一個(gè)為深度學(xué)習(xí)專門定做和優(yōu)化的ASIC芯片。這個(gè)方案的實(shí)現(xiàn)得益于一項(xiàng)叫做High Bandwidth Memory的新型內(nèi)存技術(shù),,同時(shí)擁有高容量和高速度,,提供32GB的片上儲(chǔ)存和8TB每秒的內(nèi)存訪問速度。該公司目前提供一個(gè)人工智能服務(wù)“in the cloud”,,他們聲稱這是世界上最快的且目前已被金融服務(wù)機(jī)構(gòu),、醫(yī)療保健提供者和政府機(jī)構(gòu)所使用的服務(wù),他們的新型芯片將會(huì)保證Nervana云平臺(tái)在未來的幾年內(nèi)仍保持最快的速度,。

(3)地平線機(jī)器人

由余凱創(chuàng)立于2015年的初創(chuàng)企業(yè)Horizon Robotics(地平線機(jī)器人)已經(jīng)從包括Sequoia和傳奇的風(fēng)險(xiǎn)資本家Yuri Milner等投資人獲得了未透露金額的種子基金,。后來更是獲得了已經(jīng)獲得了晨興,、高瓴、紅杉,、金沙江,、線性資本、創(chuàng)新工場和真格基金的聯(lián)合投資,。他們正在著手于建立一個(gè)一站式人工智能解決方案,,定義“萬物智能”,讓生活更便捷,、更有趣,、更安全。

地平線致力于打造基于深度神經(jīng)網(wǎng)絡(luò)的人工智能 “大腦” 平臺(tái) - 包括軟件和芯片,,可以做到低功耗,、本地化的解決環(huán)境感知、人機(jī)交互,、決策控制等問題,。

其中,軟件方面,,地平線做了一套基于神經(jīng)網(wǎng)絡(luò)的 OS,,已經(jīng)研發(fā)出分別面向自動(dòng)駕駛的的 “雨果” 平臺(tái)和智能家居的 “安徒生” 平臺(tái),并開始逐步落地,。硬件方面,未來地平線機(jī)器人還會(huì)為這個(gè)平臺(tái)設(shè)計(jì)一個(gè)芯片——NPU (Neural Processing Unit) ,,支撐自家的 OS,,到那時(shí)效能會(huì)提升 2-3 個(gè)數(shù)量級(100-1000 倍)。

安徒生平臺(tái)方面,,今年3月 上海的家博會(huì)上,,地平線機(jī)器人展示了與家電大廠合作的智能家電,近期還會(huì)推出其他新品,。雨果平臺(tái)方面,,今年3月9日奇點(diǎn)汽車發(fā)布會(huì)上,地平線機(jī)器人首次展示了基于雨果平臺(tái)的 ADAS(先機(jī)輔助駕駛系統(tǒng))原型系統(tǒng),。據(jù)悉,,世界某知名 tier-1 汽車零部件供應(yīng)商的 ADAS 系統(tǒng)也確定將采用地平線研發(fā)的單目感知技術(shù)。

(4)krtkl

創(chuàng)立于2015年的krtkl致力于創(chuàng)造“一個(gè)微小的無線電腦用來創(chuàng)造一些完全不同的東西”,。技術(shù)人將會(huì)迷戀Snickerdoodle,,一個(gè)雙核ARM處理器、FPGA,、WIFI,、藍(lán)牙,,起價(jià)于65美元,“以最小,、最難做,、最實(shí)惠賦能機(jī)器人、無人機(jī)和計(jì)算機(jī)視覺等的平臺(tái)”,。這個(gè)產(chǎn)品事實(shí)上是通過眾籌獲得了超過16萬美金的資金,。最新的信息是說他們已經(jīng)收到了Snickerdoodle初級版本,并且很快就會(huì)出貨,。這款開拓板是基于XilinxZynq SoC,,集成了ARM處置器和可編程FPGA。用戶甚至可以經(jīng)過手機(jī)上的專用APP對其舉行編程,,供230個(gè)用戶可用的I/O接口,,應(yīng)用靈巧兼容很多擴(kuò)展板卡,其特征如次:

選擇Zynq 7010SoCchip,,集成雙核ARM Cortex-A9@667Mhz處置器和430K LUT的FPGA資源(可晉級為Zynq 7020@866Mhz1.3M LUT)

這款開拓板的一大亮點(diǎn)是不僅支援傳統(tǒng)的MicroUSB程序燒寫,,終端調(diào)試等效能,還支援手機(jī)終端操控,,應(yīng)用官方供的Apps,,經(jīng)過Wi-Fi連接開拓板,用戶可以下載程序,,管腳把持,,管腳復(fù)用以及體系把持能效能。

(5)Eyeriss

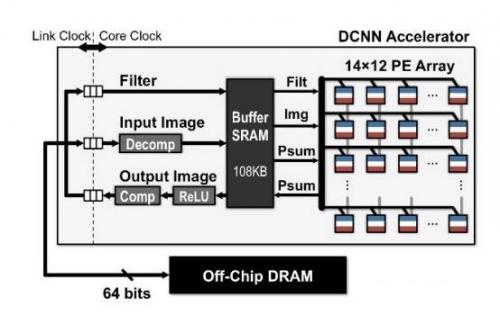

Eyeriss事實(shí)上還不是一個(gè)初創(chuàng)公司,,但是因?yàn)樗怯蒑IT開發(fā)并且獲得了大量的媒體報(bào)道,,所以我們不能從這個(gè)名單中排除它。Eyeriss是一個(gè)高效能的深度卷積神經(jīng)網(wǎng)絡(luò)(CNN)加速器硬件,,架構(gòu)圖如下:

MIT 表示,,該芯片內(nèi)建168 個(gè)核心,專門用來部署神經(jīng)網(wǎng)路(neural network),,效能為一般行動(dòng)GPU 的10 倍,,也因其效能高,不需透過網(wǎng)路處理資料,,就能在行動(dòng)裝置上直接執(zhí)行人工智慧演算法,。其具有辨識(shí)人臉、語言的能力,,可應(yīng)用在智慧型手機(jī),、穿戴式裝置、機(jī)器人、自動(dòng)駕駛車與其他物聯(lián)網(wǎng)應(yīng)用裝置上,。

而MIT 研究出的Eyeriss 芯片之所以能大量提升效能,,關(guān)鍵便在于最小化GPU 核心和記憶體之間交換資料的頻率(此運(yùn)作過程通常會(huì)消耗大量的時(shí)間與能量),且一般GPU 內(nèi)的核心通常共享單一記憶體,,但Eyeriss 的每個(gè)核心擁有屬于自己的記憶體,。

此外,Eyeriss 芯片還能在將資料傳送到每一個(gè)核心之前,,先進(jìn)行資料壓縮,,且每一個(gè)核心都能立即與鄰近的核心直接溝通,因此若需要共享資料,,核心們不需要透過主要記憶體就能傳遞,。