張利萍,劉桂華,可楊

(西南科技大學 信息工程學院,四川 綿陽 621000)

摘要:在基于相位輪廓術進行雙目三維重建時,傳統(tǒng)的雙目測量系統(tǒng)在遮擋條件下無法獲取雙目相機公共視野以外的區(qū)域的點云數(shù)據(jù),導致掃描結(jié)果出現(xiàn)測量空洞或者點云數(shù)量減少,從而不能通過立體視覺進行三維重建。對此,提出了一種基于雙目點云重建單目點云的方法,系統(tǒng)無需增加其他操作過程,單次掃描就能同時獲得雙目點云和精度較高的左右單目點云。在對飛機模型的測量中,利用該方法填補了雙目測量在機翼附近出現(xiàn)的數(shù)據(jù)丟失,提高了測量結(jié)果的完整性。

關鍵詞:三維重建;遮擋;相位;點云

中圖分類號:TP391文獻標識碼:ADOI: 10.19358/j.issn.1674-7720.2017.04.021

引用格式:張利萍,劉桂華,可楊.基于單雙目融合的遮擋區(qū)域點云獲取技術研究[J].微型機與應用,2017,36(4):70-73.

0引言

基于相位測量輪廓術的三維測量技術作為一種主動式非接觸光學測量方法,因具有全場分析、測量精度高、非接觸等優(yōu)點,正逐漸成為當前三維測量領域內(nèi)最重要和最熱門的一個研究分支,在工業(yè)檢測、質(zhì)量控制、逆向工程、生物醫(yī)學、虛擬現(xiàn)實、文物保護等眾多領域中具有廣泛的應用[14]。常用的基于相位輪廓術的三維重建系統(tǒng)按相機個數(shù)可以分為單目系統(tǒng)和雙目系統(tǒng),單目測量系統(tǒng)只需一個攝像機,通過相位值直接解算得到物體的高度信息,雙目系統(tǒng)則將相位作為匹配的一個特征,利用立體視覺求取物體的三維特征。這兩種結(jié)構(gòu)都有各自的優(yōu)點,但單目系統(tǒng)在測量精度以及抗噪性上與雙目視覺系統(tǒng)有一定的差距。故雙目視覺系統(tǒng)在實際中的應用更廣泛。

雙目視覺系統(tǒng)由于其三維坐標的獲取是基于兩相機對應像素點的匹配,在視場方面有一定的局限性,對于遮擋、陰影等情況,在重建過程中容易出現(xiàn)數(shù)據(jù)的缺失。遮擋是指匹配圖像對時,一個圖像的像素在另一個圖像中找不到對應匹配點,導致最終出現(xiàn)匹配錯誤,不僅被遮擋的點難以得到正確的視差值,還會給遮擋區(qū)域附近點的匹配帶來負面效果。如果靠多次掃描拼合或后期點云處理,則較復雜[5]。IKEMURA S等人在用TOF相機獲得深度信息的基礎上,提出了相關深度相似特征來進行遮擋判斷,該設備成本昂貴,且只能應用在特殊場合中[6]。MA Y等人將深度和遮擋率相結(jié)合,但是當遮擋對象出現(xiàn)相似視差變化的情況,就很難解決遮擋問題[7]。Jin Xin等人將編碼和遮擋區(qū)域的分割相結(jié)合對遮擋關系進行判斷,減少了計算量,但是必須完全清楚場景中的對象時才可用此方法[8]。耿英楠提出基于RGB矢量空間的三目立體匹配方法,提高了遮擋區(qū)的匹配正確率,但是匹配過程比較復雜[9]。許雯提出了基于LRC遮擋檢測的改進的ASW算法,對檢測出的遮擋區(qū)域進行填充,提高了整體視差圖的匹配質(zhì)量[10]。以上算法對解決立體匹配中的遮擋問題都有很好的效果,但是由于匹配過程中算法復雜,計算量龐大或者成本較高等各種原因,導致在實際中的應用性不強。針對上述問題,結(jié)合單雙目測量系統(tǒng)各自的優(yōu)點,提出了一種基于雙目點云重建單目點云的新方法,系統(tǒng)無需增加其他操作過程,單次掃描就能同時獲得雙目點云和精度較高的左右單目點云,很好地提升了測量數(shù)據(jù)的完整性。

1雙目三維重建原理

基于相位輪廓術的物體三維輪廓測量原理是投影儀向被測物體投射一組光強呈正弦分布的光柵,左、右兩個相機同步采集受物體表面調(diào)制后的光柵,然后根據(jù)采集的圖像獲取毎個像素的相位值,最后根據(jù)標定參數(shù),應用三角測量原理獲得物體表面三維數(shù)據(jù)。

雙目立體視覺系統(tǒng)中三維空間點的成像模型如圖1所示,設空間點A在左右相機Cl和Cr上的投影分別為al和ar,al和ar為一對匹配點,則可以唯一確定A點的空間位置,即直線Olal和直線Orar的交點。

設左攝像機位于世界坐標系O-xyz原點,圖像坐標系為Ol-XlYl,有效焦距為fl,右攝像機坐標系為Or-xryrzr,有效焦距為fr,由攝像機透視投影模型以及兩攝像機之間的位置關系,空間點A的三維坐標可以表示為:

式中Xi=(ui-u0i)*dx,Yi=(vi-v0i)*dy,i=l,r。其中(Xi,Yi)為像素物理坐標,(u,v)為像素圖像坐標,(u0,v0)為像素坐標原點,dx、dy為像元尺寸。右相機和左相機間的旋轉(zhuǎn)矩陣

由式(1)可知,通過雙目攝像機標定求出左、右相機焦距fl、fr,旋轉(zhuǎn)矩陣R和平移矩陣T,通過極線約束原理求出左右圖像中匹配點對的圖像坐標,就可以得到被測物的三維點云數(shù)據(jù)。

在利用雙目視覺原理進行三維重建的過程中,常常由于相機拍攝視角或者物體表面輪廓較復雜等原因,導致物體表面某些場景點只能在雙目視覺系統(tǒng)中的一個攝像機中可見,而在另一個攝像機中不可見,圖像上這些點稱為雙目半遮擋點。它們通常存在于物體邊緣和場景不連續(xù)等地方,而這些地方又是視覺中要處理的關鍵點。

2單目重建技術

現(xiàn)有的單雙目點云重建方法一般采用兩個相機分別與投影儀組成單目測量系統(tǒng)來補充雙目測量結(jié)果的方式。在獲取單目點云的方法上,本文采用蓋紹彥提出的相位高度映射模型[11],此模型對攝像機、投影裝置以及標定平面的位置關系無嚴格要求,提高了系統(tǒng)的可操作性。本節(jié)基于該模型提出一種使用雙目點云來優(yōu)化模型參數(shù),獲得單目點云的方法,與單純依靠雙目的測量系統(tǒng)相比,使用此方法能夠有效地改進系統(tǒng)的測量范圍和提高測量結(jié)果的完整性。

2.1相位恢復高度模型

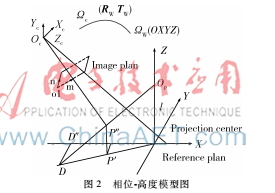

系統(tǒng)模型[11]如圖2所示,參考坐標系Ωw(OXYZ)是基于投影設備建立的:OXY平面平行于投影面,光柵條紋平行于Y軸,投影中心OP經(jīng)過Z軸。攝像機坐標系Ωc(OcXcYcZc)原點Oc位于鏡頭光心,Zc位于光軸,Xc、Yc分別平行于攝像機成像面的橫軸、縱軸。o1mn表示攝像機成像面上的圖像坐標系。

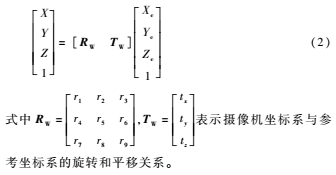

設物點P在參考坐標系ΩW中的坐標為(X,Y,Z),在攝像機坐標系Ωc中的坐標為(Xc,Yc,Zc),有

可以推導出P點的相位θ與其三維坐標(Xc,Yc,Zc)的關系如式(3)所示:

式(3)是θ-(Xc,Yc,Zc)映射模型的關系式,a1~a8為待標定的系統(tǒng)參量,λ0為投影光柵節(jié)距,θ0為原點O的相位。

2.2單雙目重建技術

傳統(tǒng)的求解參數(shù)a1~a8的方法是先通過平面標定板對單目相機進行標定,再對投影到標定板上的光柵進行解相,得到樣本點集(Xc,Yc,Zc,θ),帶入式(3),可得到一組以參量a1~a8為未知數(shù)的線性方程,解方程組,即可得到參量值。

本節(jié)提出了一種基于雙目點云重建單目點云的方法,直接將雙目重建的點和對應的相位值組成樣本集(Xi,Yi,Zi,θi)代入式(3),優(yōu)化解得a1~a8,然后對于僅在單個相機視場內(nèi)有效的物點,將其相位值代入式(3),結(jié)合式(1)中X、Y和Z的關系計算三維坐標。相比傳統(tǒng)的參數(shù)求解方法,本方法既消除了傳統(tǒng)方法中由于相機標定和光柵解相帶來的誤差,提高了參數(shù)的優(yōu)化精度,又簡化了操作過程。

設左相機為參考坐標系,計算左單目點云時可以直接使用雙目點和左相位場,但計算右單目點云時,將雙目點云轉(zhuǎn)換到右相機坐標系下,加上右相位場來計算,最后再將右單目點云坐標統(tǒng)一到左相機坐標系下。算法實現(xiàn)的步驟如下:

(1)標定:使用張正友平板標定法[12]對雙目系統(tǒng)的內(nèi)外參數(shù)進行標定。

(2)相位解算:先使用最大類間方差法分離物體和背景,將屬于物體部分的點標記為有效點,再通過四步相移[13]加多頻外差[14]解算出左右相位場。

(3)匹配:利用相位值相等和極線約束條件尋找左右相機中的對應匹配點,同時在相位圖中對未匹配點予以標記,再進行亞像素插值提高精度。

(4)雙目重建:得到左右相機的匹配點后,利用相機的內(nèi)外參量,根據(jù)三角原理法計算三維坐標。

(5) 左右單目重建:分別利用左右相機與投影儀組成兩個單目測量系統(tǒng)。利用本文所述的單目測量方法分別對左右相機中的未匹配點求取對應的三維坐標,并統(tǒng)一到雙目測量坐標系中。

為了避免單目測量系統(tǒng)重建雙目缺失區(qū)域以外的部位,在雙目測量匹配過程中,分別對左右相機中的未匹配點進行標記,對相位圖中的每一點設置一個標記值,如果能夠找到對應匹配點則設其標記值為1,否則為0,在后續(xù)的單目重建中僅對標記值為0的點進行處理。

3實驗驗證及結(jié)果分析

實驗采用基于雙目視覺的數(shù)字光柵投影系統(tǒng),該系統(tǒng)由兩個高分辨率(分辨率1 280×1 024)的工業(yè)CCD相機和一個DLP投影儀組成,測量時使用投影儀向被測物體投射一組光強呈正弦分布的光柵,左右兩個相機進行同步采集受物體表面調(diào)制后的光柵,然后根據(jù)采集的圖像,獲取其相位信息最后根據(jù)標定參數(shù),應用三角測量原理獲得物體表面三維數(shù)據(jù)。

飛機模型的點云如圖3所示。

在圖3中,單次掃描重建的點云如圖3(b)所示,在機身和兩側(cè)機翼交接的地方會出現(xiàn)一些空洞,其原因是由于機身的遮擋, 而不能被雙相機同時拍攝到,因此出現(xiàn)點云缺失的空洞。分別基于雙目點云及其相位場優(yōu)化得到的a1~a8見表1。單目重建也對雙目無法測量的部位進行了補充,使單次測量結(jié)果更加完整。圖3(d)中仍然存在的一些空洞是物體表面的黑色斑點所致,與本文算法無關,可以通過向物體表面噴白色顯影劑的方式來測得。

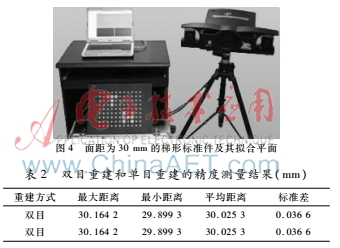

為了對本測量系統(tǒng)的重建精度進行評估,對面距為30 mm的梯形標準件進行測量,如圖4所示,將得到的點云擬合成平面,計算兩平面之間的面距,測量結(jié)果如表2所示,可以看出單目點云精度比雙目點云稍低,可以用于對精度要求不是很高的場合。

單目重建算法能對雙目點云中的測量空洞進行補充,但其精度往往達不到雙目點云的精度,由于單目重建是直接通過相位值計算物點的三維坐標,相位誤差是影響單目測量精度的主要因素,由投影儀的Gamma非線性和工業(yè)相機的非線性響應共同引起的光柵圖像非正弦化是相位誤差的主要來源,相機采集圖像時引入的環(huán)境光與相機Gamma值共同作用也會使采集的光柵圖片非正弦化。

4結(jié)論

本文提出了一種基于相位高度模型的新單雙目重建方法,使用雙目點云優(yōu)化出系統(tǒng)參數(shù)用于單目點云的計算。該方法能在單次掃描過程中同時實現(xiàn)單目和雙目的點云計算,對雙目測量結(jié)果中出現(xiàn)的空洞區(qū)域,可以使用該處單目測量的結(jié)果加以補充。這種方式的單目重建在雙目視覺系統(tǒng)的基礎上,無需增加其他硬件設備或者操作步驟,簡單可行。與單純地依靠雙目測量系統(tǒng)相比,使用此方法能夠有效地改進系統(tǒng)的測量范圍和提高測量結(jié)果的完整性。

單目重建算法能對雙目點云中的測量空洞進行補充,但其精度往往達不到雙目點云的精度。由于單目重建是直接通過相位值計算物點的三維坐標,因此需要進一步提升相位精度。下一步的重點是研究相位誤差補償方法,建立相機和投影儀Gamma值的數(shù)學模型,利用預編碼方法消除相位誤差。

參考文獻

[1] Zhang Zonghua, TOWERS D P, TOWERS C E. Snapshot color fringe projection for absolute 3D metrology of video sequences[J]. Applied Optics, 2010, 49: 5947-53.

[2] Dai Meiling, Yang Fujun, He Xiaoyuan. Singleshot color fringe projection for threedimensional shape measurement of objects with discontinuities[J]. Applied Optics, 2012, 5(12): 2062-2069.

[3] Wang Yongchang, Liu Kai, Hao Qi, et al. Period coded phase shifting strategy for realtime 3D structured light illumination[J]. IEEE Transactions on Image Processing, 2011, 20(11): 3001-3013.

[4] GORTHI S S, RASTOGI P. Fringe projection techniques: whither we are?[J]. Optics & Lasers in Engineering, 2010, 48(2): 133-140.

[5] TYAGI A, POTAMIANOS G, DAVIS J W, et al. Fusion of multiple camera views for kernelbased 3D tracking[C]. IEEE Workshop on Motion and Video Computing. Austin, TX, USA: IEEE Press, 2007:1-8.

[6] IKEMURA S, FUJIYOSHI H. Realtime human detection using relational depth similarity features[J]. Computer Vision–ACCV 2010, Springer Berlin Heidelberg, 2010,6495: 25-38.

[7] MA Y, WORRALL S, KONDOZ A M. Depth assisted visual tracking[C]. 10th Workshop on Image Analysis for Multimedia Interactive Services, 2009. WIAMIS'09. IEEE, 2009: 157-160.

[8] Jin Xin, Chen Xiaowu, Zhou Bin, et al. Cooperatively resolving occlusion between real and virtual in multiple video sequences[C]. 2011 Sixth Annual IEEE China Grid Conference (China Grid), 2011: 234-240.

[9] 耿英楠.立體匹配技術的研究[D].長春:吉林大學,2014.

[10] 許雯.立體視覺中局部立體匹配算法研究[D].西安:西安電子科技大學,2014.

[11] 蓋紹彥,達飛鵬.一種新的相位法三維輪廓測量系統(tǒng)模型及其標定方法研究[J].自動化學報, 2007,33(9):902-910.

[12] ZHANG Z. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000. 22(11): 1330-1334.

[13] 蔡長青,賀玲鳳.基于四步相移的相位差提取方法[J]. 華南理工大學學報(自然科學版),2011,39(9):93-96.

[14] 陳松林,趙吉賓,夏仁波.多頻外差原理相位解包裹方法的改進[J].光學學報,2016,36(4):1-11.