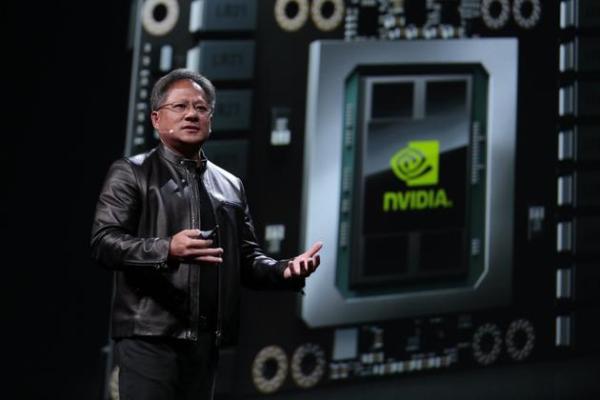

據(jù)國外媒體VentureBeat報道,,英偉達(dá)CEO黃仁勛昨天發(fā)布了一款針對人工智能應(yīng)用的雄心勃勃的新處理器:Tesla V100,。

該新芯片擁有210億個晶體管,,性能比英偉達(dá)一年前發(fā)布的帶150億個晶體管的Pascal處理器強(qiáng)大得多,。它是一款很大的芯片——815平方毫米,,大小約為Apple Watch智能手表的表面,。它擁有5120個CUDA(統(tǒng)計計算設(shè)備架構(gòu))處理核心,,雙精度浮點(diǎn)運(yùn)算性能可達(dá)每秒7.5萬億次,。

作為全球最大的圖形芯片和AI芯片廠商,,總部位于加州圣克拉拉的英偉達(dá)在加州圣何塞舉行GPU技術(shù)大會,并發(fā)布了上述產(chǎn)品,。

黃仁勛稱Nvidia總共投入了30億美元來打造這款產(chǎn)品,。黃仁勛在發(fā)布這款產(chǎn)品時顯得非常激動,稱Tesla V100的研發(fā)是一項幾乎不可能完成的任務(wù),,令人難以置信,。

接下來,黃仁勛通過一系列視頻及游戲展示了Tesla V100怪獸級的性能,。那些曾經(jīng)在Titan X上需要數(shù)分鐘才能處理完成的任務(wù),,在Tesla V100上只需要花數(shù)秒就能完成。

此外,,基于8塊Tesla V100搭建的DGX-1也開始預(yù)售,,價格為149000美元(合100萬人民幣),預(yù)計在今年第三季度交付,。

在介紹該款芯片之前,,黃仁勛談到了AI近年的發(fā)展史。他指出,,深度學(xué)習(xí)神經(jīng)網(wǎng)絡(luò)研究大約5年前開始帶來成果,,那個時候研究人員開始利用圖形處理器(CPU)來處理數(shù)據(jù),同時利用它們來快速訓(xùn)練神經(jīng)網(wǎng)絡(luò),。自那時起,,深度學(xué)習(xí)技術(shù)呈現(xiàn)加速發(fā)展,。今年,英偉達(dá)打算培訓(xùn)10萬個開發(fā)者使用該項技術(shù),。

Tesla V100另稱為Volta,,針對深度學(xué)習(xí)而打造,Tensor性能可達(dá)每秒120萬億次浮點(diǎn)運(yùn)算,。它能夠每秒傳輸300GB的數(shù)據(jù),,速度相當(dāng)于時下其它處理器的20倍。該款芯片由三星代工生產(chǎn),。

該芯片針對深度學(xué)習(xí)訓(xùn)練的Tensor浮點(diǎn)運(yùn)算性能達(dá)到去年發(fā)布的Pascal處理器的12倍,。這種處理速度很有必要,因?yàn)樯疃葘W(xué)習(xí)算法的進(jìn)展令人驚嘆,。

2015年,,微軟打造了一個名為ResNet的深度學(xué)習(xí)項目,該項目非常復(fù)雜,,需要每秒7百億億次浮點(diǎn)運(yùn)算的處理能力,。百度2016年打造的Deep Speech 2 AI需要每秒20百億億次浮點(diǎn)運(yùn)算的處理能力,谷歌2017年打造的NMT則需要每秒105百億億次浮點(diǎn)運(yùn)算的處理能力,。

微軟正在開發(fā)一個新的ResNet版本,,ResNet會同時使用64個Tesla V100芯片來進(jìn)行處理。目前還不清楚Tesla V100批量出貨的時間,。