張兆豐,吳澤民,杜麟,胡磊

(中國人民解放軍理工大學 通信工程學院,江蘇 南京 210007)

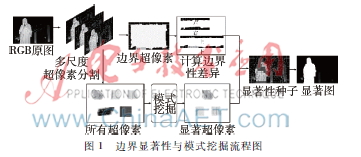

摘要:針對目標在圖像邊界上帶來的檢測誤差,提出了邊界顯著性算法。首先在多尺度下對圖像進行超像素分割,計算邊界差異,估計其邊界顯著性。而后對所有超像素進行模式挖掘,得到顯著性種子,并與邊界顯著性相結(jié)合。最后通過顯著性傳播得到最終顯著圖。在三個公開的測試數(shù)據(jù)集上將本文提出算法與其他18種主流的現(xiàn)有算法進行對比。大量實驗結(jié)果表明,所提出的算法在不同數(shù)據(jù)集上都優(yōu)于目前主流算法。

關(guān)鍵詞:邊界顯著性;多尺度;模式挖掘;顯著性種子;顯著性傳播

中圖分類號:TN919.85文獻標識碼:ADOI: 10.19358/j.issn.1674-7720.2017.08.012

引用格式:張兆豐,吳澤民,杜麟,等.邊界顯著性與模式挖掘[J].微型機與應用,2017,36(8):34-38.

0引言

*基金項目:國家自然科學基金(61501509)近年來,計算機視覺受到了眾多學者的關(guān)注,顯著性檢測作為降低計算復雜度的重要預處理過程,更是被廣泛應用于目標識別、目標跟蹤以及圖像分割等相關(guān)領(lǐng)域。

顯著性檢測被劃分為兩個領(lǐng)域:一是眼動點預測,這一類模型被廣泛應用于生物學、神經(jīng)學等認知領(lǐng)域。另外就是本文所討論的顯著性目標檢測。通常又將顯著性目標檢測分為兩類:自頂向下的任務驅(qū)動方法,針對目標的高級特征信息,通過大量樣本的訓練進行檢測。與之相反,自底向上的數(shù)據(jù)驅(qū)動方法通常利用顏色、紋理以及空間分布等低級特征獲取顯著圖。早期的一些方法基于中心優(yōu)先,通過計算目標與其周圍環(huán)境對比度得到顯著圖。自從Wei Yichen[1]首先提出利用圖像邊界作為背景的思路后,越來越多的算法采用背景優(yōu)先或邊界優(yōu)先,并取得了較好的檢測效果。這類方法通常將邊界區(qū)域作為背景,雖然大多數(shù)情況下圖像邊界很有可能成為背景,但是對于傳統(tǒng)的背景優(yōu)先算法將所有的邊界歸為背景并不合理。

本文主要針對上述問題,提出邊界顯著性,并與模式挖掘相結(jié)合,從而同時利用目標和邊界特征,更好地將多特征整合。最終得到的結(jié)果優(yōu)于其他先進算法。

1相關(guān)工作

早期的一些圖像顯著性檢測算法,通常是基于中心優(yōu)先。這一類算法大多從圖像中顯著目標與背景區(qū)域?qū)Ρ榷炔町惖慕嵌瘸霭l(fā),計算局部或者全局對比度。但是基于對比度的中心優(yōu)先算法存在以下缺陷:首先對于局部對比度,目標的邊緣區(qū)域與背景特征差別較大,對比度自然較高,但是目標內(nèi)部對比度相差不大的,反映到最終的顯著圖上很容易造成目標相對清晰高亮,而內(nèi)部模糊不清,整體性較差。而對于全局對比度,當背景特征與目標相似時誤檢的可能性較高。而且基于中心優(yōu)先的算法對目標的所在位置與尺寸大小有較強的針對性,對于大尺寸目標和目標在邊界上這類情況,檢測效果往往較差。

區(qū)別于中心優(yōu)先,近來,越來越多的顯著性檢測算法利用背景優(yōu)先構(gòu)建顯著圖。Wei Yichen最早提出背景優(yōu)先這一概念,將圖像邊界默認為背景,對分割后的圖像,計算分割塊到邊界的測地線距離來衡量其顯著性。文獻[2]在此基礎(chǔ)上提出了邊界連通度這一概念,并給出了可以推廣到其他模型上的優(yōu)化算法。諸如此類的背景優(yōu)先算法大多有一個共同的缺陷,對于所有邊界都不加區(qū)分地作為背景對待,因此對于目標在邊界上這類情況,檢測效果沒有從根本上得到提升。

為了更好地解決目標在邊界上帶來的一系列問題,本文提出了一種邊界顯著性算法,并與模式挖掘相結(jié)合。圖1為本文算法流程圖,首先對輸入圖像在多尺度上進行超像素分割,而后對所有邊界計算邊界差異,從而估計其邊界顯著性。同時對所有超像素進行模式挖掘,得到顯著性種子,并結(jié)合邊界顯著性結(jié)果,對得到的種子加以顯著性傳播,最終得到顯著圖。

2圖的構(gòu)建

目前超像素分割已經(jīng)融入到計算機視覺、模式識別等各個研究領(lǐng)域。利用超像素作為圖像處理的基本單元,大幅度降低了直接處理像素的算法復雜度。本文選取了簡單線性迭代聚類(Simple Linear Iterative Clustering ,SLIC)[3]進行超像素分割,不僅基本保留了圖像原本的結(jié)構(gòu)化信息,而且使得到的區(qū)域如同細胞一樣排列比較緊湊規(guī)整,可以把以前基于像素的方法加以改造后應用,統(tǒng)計特征也比較好保持。

對于一般圖像而言,圖像中的物體尺度各不相同,待檢測的顯著目標也就會有多種尺度。因此最終的顯著性檢測的結(jié)果與超像素的數(shù)量是有很大關(guān)系的,如果從單一尺度進行顯著性檢測,很有可能導致最終檢測不準確。為了最大程度降低尺度上帶來的影響,本文在三個不同尺度上對圖像進行分割,超像素個數(shù)分別是300,400和500。以超像素V為節(jié)點,鄰接超像素之間為邊E,構(gòu)造一個無向加權(quán)圖G=(V,E)。相鄰節(jié)點間權(quán)重定義如下:

其中ci和cj分別代表節(jié)點i和j在CIELab色彩空間上的平均顏色值,ci-cj代表兩個節(jié)點在CIELab色彩空間上的歐氏距離。σ是權(quán)重控制參數(shù),反映了超像素之間的差異,一般手動設置其大小。當圖像中顏色差異較大時,σ的值相應較大;當圖像整體顏色差異較小時,σ的值相應較小。參照文獻[4]依據(jù)超像素顏色的差異來自適應計算σ值:

![5AT9J$]]V34QK(KFSEX~[PR.png 5AT9J$]]V34QK(KFSEX~[PR.png](http://files.chinaaet.com/images/2017/05/27/6363147477324152453000037.png)

其中,m=14N2s∑Nsi,j=1ci-cj,Ns 表示超像素的總數(shù)。

3邊界顯著性與模式挖掘

3.1邊界顯著性

現(xiàn)有的顯著性檢測算法對于普通的目標與背景區(qū)分效果較好,但是當目標的一部分位于邊界上時,如圖2所示,很多基于背景優(yōu)先的算法也無法給出較好的檢測結(jié)果。這是由于傳統(tǒng)基于背景優(yōu)先的檢測算法沒有對邊界加以區(qū)分,直接把所有邊界都當作背景處理所導致的。因此本文提出了邊界顯著性這一概念,對邊界上目標出現(xiàn)的可能性進行估計,從而提升最終檢測效果。

通過對大量圖像樣本的統(tǒng)計發(fā)現(xiàn),對于目標在邊界上的圖像,如果把所有邊界超像素視為一個連通區(qū)域,大多數(shù)情況下只有相對較小的一部分是顯著目標,而且顯著目標和背景往往在顏色分布上有著明顯的區(qū)別。因此借鑒文獻[5]、[6],在RGB色彩空間上分別計算邊界的像素分布。

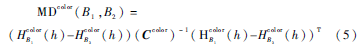

其中B={top, bottom, left, right}代表圖像的四條邊界,h=0,1,2,…,255代表不同的亮度區(qū)間,NB代表邊界連通區(qū)域像素總數(shù),Ip代表像素p的亮度,δ(·)表示單位脈沖響應函數(shù)。然后計算邊界像素分布間的馬氏距離(Mahalanobis Distance, MD),構(gòu)造邊界差異矩陣:

其中MDcolor(B1,B2)表示在不同顏色通道下,邊界B1和B2之間的馬氏距離。color=

其中Ccolor表示在不同顏色通道下的協(xié)方差矩陣。得到4×4的邊界差異矩陣D,將矩陣每一列元素加和,最終得到每條邊界與其他邊界的差異度:

dn=∑4m=1D(Bn,Bm)(6)

以負指數(shù)函數(shù)估計邊界上存在目標的概率從而表示邊界顯著性:

S(Bn)=1-exp(-(dn/dmin-1))(7)

其中dmin=min{di}i=1,…,4為差異度最小的邊界,即邊界上存在目標的可能性最小,因此邊界顯著性為0。其余邊界差異度越大,目標在邊界上的可能性就越大,與之對應的邊界顯著性越大。

3.2基于邊界顯著性改進的模式挖掘算法

模式挖掘最早應用在市場營銷分析,近年來逐漸被應用到計算機視覺領(lǐng)域。文獻[7]利用模式挖掘,在先驗顯著圖的基礎(chǔ)上尋找可靠的種子節(jié)點:

supp(A)>t1

conf(A→pos)>t2(8)

其中supp(·)代表支持度,conf(·)代表置信度,A代表頻繁項集,pos代表正樣本(即顯著)標簽,t1和t2分別是支持度和置信度的篩選閾值參數(shù),根據(jù)文獻[7]分別設置為90%和20%。最終得到的顯著性種子集合記為L。f={f1,f2,…,fNs}T代表節(jié)點標簽向量,結(jié)合第3節(jié)中提到的邊界顯著性,對f初始化如下:

![628W]$AC{BSKY7G1%3U9W@A.png 628W]$AC{BSKY7G1%3U9W@A.png](http://files.chinaaet.com/images/2017/05/27/6363147483119885302494056.png)

對于模式挖掘得到的顯著性種子,初始化為1;對于不是顯著性種子但位于邊界上的節(jié)點,按其邊界顯著度初始化;對于其他節(jié)點則初始化為0。

而后利用隨機游走模型進行顯著性傳播:

![K]ZL4T7108$LCCE`8867IVY.png K]ZL4T7108$LCCE`8867IVY.png](http://files.chinaaet.com/images/2017/05/27/6363147483816810808077138.png)

公式(10)~(12)分別代表隨機游走(Random Walking, RW)、拉普拉斯算子(Laplacian, La)、先驗顯著圖(Priori Saliency, PS)。N(i)代表節(jié)點i的鄰接節(jié)點,yi代表先驗顯著圖中節(jié)點i的顯著值,α和β 是權(quán)重控制參數(shù),分別取值0.5和0.01。

argminf{RW+La+PS}

s.t.fi=1,i∈L(13)

公式(13)中分別考慮了傳統(tǒng)的隨機游走、二次拉普拉斯算子、先驗顯著圖對于最終顯著檢測結(jié)果的影響。

4實驗結(jié)果

4.1實驗設置

測試數(shù)據(jù)集:本文在3個公開數(shù)據(jù)集對提出的算法進行測試,并與其他18種顯著性檢測模型做橫向比對。下面分別說明本文使用的3個數(shù)據(jù)集的不同特點。

MSRA:1 000張圖像,含有像素級的真值標準,大部分圖像為單一目標,但是很多圖像中目標在邊界上,存在一定的挑戰(zhàn)性。

SED2:100張圖像,含有像素級的真值標準,雖然圖像規(guī)模較小,但是所有圖像都存在兩個目標,并且大多數(shù)目標位于邊界上,挑戰(zhàn)難度很大。

ECSSD:1 000張圖像,含有像素級的真值標準。背景比較復雜,存在很多大尺度目標而且有很多位于邊界上的目標,挑戰(zhàn)難度很大。

對比算法:SR,F(xiàn)T,LC,HC,SF,GS,RC,GC,PCA,HS,MR,MC,DSR,HDCT,RBD,RRWR,wCOBD和PM。其中GS[1],MR[8],MC[9],DSR[10],RBD[2]和wCOBD[11]為近年來比較優(yōu)秀的基于背景優(yōu)先的顯著性檢測算法。

評價指標:為了更加全面地衡量本文提出算法的檢測性能,通過準確度召回率(PrecisionRecall,PR)曲線、Fmeasure、平均絕對誤差(Mean Absolute Error,MAE)和AUC(Area Under ROC(Receiver Operating Characteristics,接收者操作特性) Curve,ROC曲線下面積)對所有算法進行評價。

本文所有試驗都是在MATLAB平臺上實現(xiàn)的,所應用的計算機配置為Intel E52620,CPU 2 GHz,96 GB RAM。

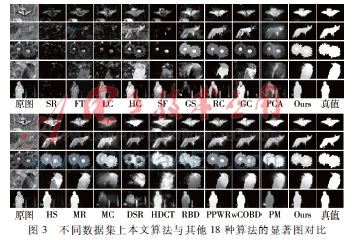

4.2定性分析

圖3展示了包括本文所提出的算法在內(nèi)共19中顯著檢測模型最終生成的顯著圖。其中既包含了經(jīng)典的中心優(yōu)先算法,也包含了近年來優(yōu)秀的背景優(yōu)先算法。選取了不同類型的圖像作為示例加以說明。對于第一個檢測樣本,目標表現(xiàn)出不同的顏色特征(蝴蝶翅膀黑白相間),一些算法不能很好地給出完整一致的目標整體,而且圖像邊界上存在干擾目標。對于第二個檢測樣本,背景區(qū)域和前景目標顏色區(qū)分較小,導致一些基于顏色對比度的檢測算法檢測失敗。對于第三個檢測樣本,目標內(nèi)部顏色對比度明顯,導致部分算法對目標整體性估計不足(大多只能較好地檢測黃色花蕊,但是對于紅色花瓣檢測效果欠佳),而且背景區(qū)域存在小尺度噪聲。第四和第五個檢測樣本顯著目標均位于邊界上,而且在第五個檢測樣本中背景區(qū)域存在其他干擾目標,導致部分算法對于邊界目標顯著性估計不足。

本文算法由于結(jié)合了邊界顯著性與模式挖掘,在原有基礎(chǔ)上加強了對邊界信息的處理能力,而且由于在多尺度上計算,很大程度上避免了不同尺度噪聲帶來的影響。對于不同場景檢測效果較好,魯棒性較強。

4.3定量分析

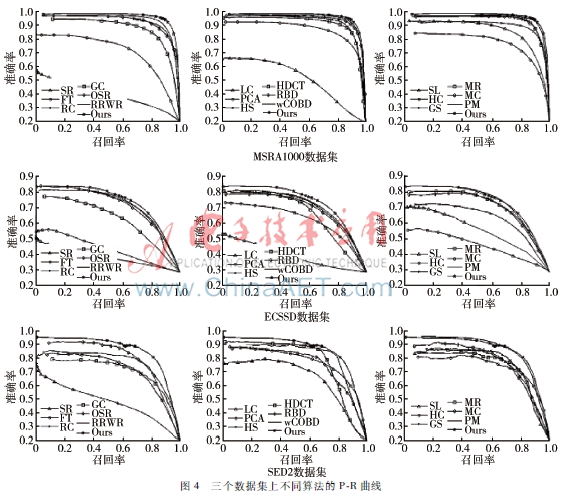

本文首先利用P-R曲線對所有算法進行評價。在計算機視覺領(lǐng)域,P-R曲線是一種常用指標。首先將得到的圖5三個數(shù)據(jù)集上不同算法的Fmeasure曲線顯著圖量化到[0,255 ]區(qū)間內(nèi),按照一定的閾值分割得到二值圖,然后參照真值圖,計算準確度和召回率。

如圖4所示,在三個數(shù)據(jù)集上測試結(jié)果顯示,本文所提算法與其他算法相比,檢測結(jié)果表現(xiàn)較好。

通常準確度和召回率難以同時保證,為了綜合評價顯著圖的質(zhì)量,本文采用Fmeasure曲線進一步對所有算法進行評價。其實質(zhì)是準確度和召回率的調(diào)和平均。

圖5給出了本文算法與其他算法的F-measure曲線,可以看出本文算法整體上優(yōu)于其他算法。

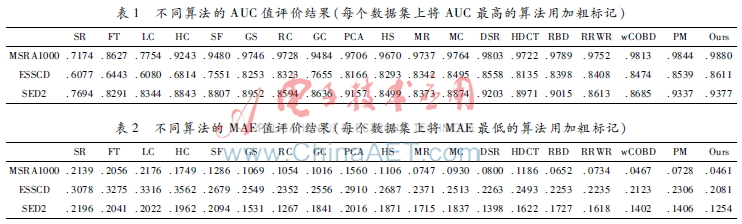

為了進一步對所有算法進行比較,還分別計算了不同算法的AUC。AUC值可以很好地反映不同算法的正確率和誤警率。表1給出了不同算法的AUC值。

最后,用MAE來衡量顯著圖與真值之間的相似程度,其值在[0, 1]區(qū)間內(nèi),值越小代表性能越好。表2給出了所有算法的MAE值,反映出本文所提算法在不同數(shù)據(jù)集上都與真值更加接近。

從上述四種評價指標的結(jié)果來看,尤其是與GS,MR,MC,DSR,RBD和wCOBD這些基于背景優(yōu)先的檢測算法相比,本文算法性能有所提升,證明本文所提出的邊界顯著性的有效性,而且在不同數(shù)據(jù)集上均有相對較好的表現(xiàn),證明了本文算法有較強的魯棒性。

5結(jié)論

本文提出了邊界顯著性算法。在多個尺度上對圖像進行處理,從而降低了目標尺度不同造成的檢測誤差。并與模式挖掘像結(jié)合,有效地解決了目前算法對于邊界的顯著性估計不足的問題。在三個數(shù)據(jù)集上,對本文所提模型與其他18種先進顯著性檢測模型進行對比,大量實驗說明本文模型能夠取得更好的檢測結(jié)果,有較強的魯棒性。

參考文獻

[1] Wei Yichen, Wen Fang, Zhu Wangjiang, et al. Geodesic saliency using background priors[C]. 12th European Conference on Computer Vision (ECCV), Florence, Italy, 2012: 29-42.

[2] Zhu Wangjiang, Liang Shuang, Wei Yichen, et al. Saliency optimization from robust background detection[C].IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Columbus, USA, 2014: 2814-2821.

[3] ACHANTA R,SHAJI A, SMITH K, et al. Slic superpixels compared to stateoftheart superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2281.

[4] 劉杰, 王生進. 融合聚類與排序的圖像顯著區(qū)域檢測[J]. 清華大學學報(自然科學版), 2016(9):913-919.

[5] 楊雪. 基于視覺感知的圖像顯著區(qū)域的提取[J]. 微型機與應用, 2015, 34(2):47-48.

[6] LI Changyang, Yuan Yuchen,Cai Weidong, et al. Robust saliency detection via regularized random walks ranking[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, USA, 2015:2710-2717.

[7] Kong Yuqiu, Wang Lijun, Liu Xiuping, et al. Pattern Mining Saliency[C]. 15th European Conference on Computer Vision (ECCV), Amsterdam, Holland, 2016: 583-598.

[8] Yang Chuan, Zhang Lihe, Lu Huchuan, et al. Saliency detection via graphbased manifold ranking[C]. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Portland, USA, 2013. 31663173.

[9] Jiang Bowen, Zhang Lihe, Lu Huchuan, et al. Saliency detection via absorbing Markov chain[C]. IEEE Conference on Computer Vision (ICCV), Sydney, Australia, 2013: 1665-1672.

[10] Li Xiaohui, Lu Huchuan, Zhang Lihe, et al. Saliency detection via dense and sparse reconstruction[C]. IEEE Conference on Computer Vision (ICCV), Sydney, Australia, 2013: 2976-2983.

[11] Jiang Qingzhu, Wu Zemin, Tian Chang, et al. Salient object detection based on discriminative boundary and multiple cues integration[J]. Journal of Electronic Imaging, 2016, 25(1): 1-14.