文獻(xiàn)標(biāo)識(shí)碼:A

DOI: 10.19358/j.issn.2096-5133.2018.07.014

中文引用格式:吳乾紳.融合多視角信息的RGB-D圖像協(xié)同顯著性檢測(cè)[J].信息技術(shù)與網(wǎng)絡(luò)安全,,2018,37(7):58-61,66.

0 引言

圖像的顯著性[1]概念是人類(lèi)在研究視覺(jué)感知機(jī)制的過(guò)程中提出來(lái)的,,可以理解為視覺(jué)場(chǎng)景中物體吸引人類(lèi)注意力的程度。近年來(lái),圖像顯著性檢測(cè)研究受到了廣泛關(guān)注,,并在物體識(shí)別,、圖像檢索等領(lǐng)域展現(xiàn)出廣闊的應(yīng)用前景。早期的工作主要基于人工設(shè)計(jì)的視覺(jué)特征進(jìn)行顯著性檢測(cè),,例如對(duì)比算法[1]以及多尺度顯著區(qū)域融合[2]等,。近年來(lái),深度學(xué)習(xí)被逐漸用于圖像顯著性檢測(cè),,并取得了良好的實(shí)驗(yàn)效果[3],。隨著深度相機(jī)的普及,深度圖像(RGB-D圖像)的數(shù)據(jù)規(guī)模呈爆炸式增長(zhǎng),,而且能克服二維圖像丟失深度信息的不足,,因此利用深度信息提升視覺(jué)分析性能逐漸成為計(jì)算機(jī)視覺(jué)領(lǐng)域新的趨勢(shì),吸引了研究人員的關(guān)注,。在已有研究中,,文獻(xiàn)[4]融合了深度信息來(lái)檢測(cè)圖像中的顯著目標(biāo),文獻(xiàn)[5]采用了一種進(jìn)化策略檢測(cè)RGB-D圖像中的顯著區(qū)域,。以上工作均局限于檢測(cè)單幅圖像的顯著性,,難以用于檢測(cè)一組相關(guān)圖像的協(xié)同顯著性。

較之單幅圖像顯著性檢測(cè),,圖像協(xié)同顯著性檢測(cè)力求在一組內(nèi)容相關(guān)的圖片中發(fā)現(xiàn)共有的顯著目標(biāo),。理論上,互相關(guān)聯(lián)的圖片組包含了更多信息,,而且重復(fù)出現(xiàn)的目標(biāo)有助于進(jìn)一步理解圖像,。對(duì)于RGB圖像,文獻(xiàn)[6]通過(guò)采用3個(gè)自下而上的顯著特征(對(duì)比特征,、空間特征以及相似特征)進(jìn)行特征聚類(lèi)來(lái)獲得協(xié)同顯著圖,。文獻(xiàn)[7]提出了一個(gè)基于多層分割的算法模型,該算法在粗分割的基礎(chǔ)上確定目標(biāo)輪廓,,然后通過(guò)細(xì)分割檢測(cè)區(qū)域間的相似性,。文獻(xiàn)[8]通過(guò)基于圖模型的流行排序算法獲得協(xié)同顯著圖,但是僅使用單一圖模型必然會(huì)丟失部分信息,。近年來(lái),,探索RGB-D圖像的協(xié)同顯著性也逐漸成為研究熱潮。與以往的前向檢測(cè)策略不同,,文獻(xiàn)[9]設(shè)計(jì)了一個(gè)反饋迭代優(yōu)化模型來(lái)檢測(cè)協(xié)同顯著目標(biāo),。文獻(xiàn)[10]通過(guò)特征匹配約束和顯著性標(biāo)記傳播實(shí)現(xiàn)對(duì)RGB-D圖像的協(xié)同顯著性檢測(cè)??梢钥吹竭@些方法依賴(lài)于算法中所設(shè)計(jì)的自下而上的先驗(yàn)特征,,而且并沒(méi)有充分利用單幅圖像的顯著信息,,因此在檢測(cè)效果上仍有很大的提升空間。

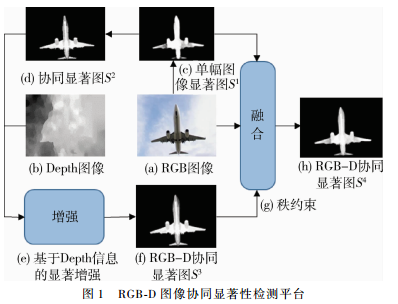

為了克服上述不足,,本文提出了一種基于多視角信息融合的RGB-D圖像協(xié)同顯著性檢測(cè)算法,。如圖1所示,考慮到單幅圖像的顯著圖包含了大量的圖像前景區(qū)域信息,,本文首先采用深度學(xué)習(xí)網(wǎng)絡(luò)獲得效果良好的單幅RGB圖像的顯著圖,。接著,提取圖像的多種類(lèi)型特征建立多圖模型,,采用流形排序算法初步檢測(cè)到協(xié)同顯著性目標(biāo),。然后使用基于深度信息的顯著圖對(duì)初始的協(xié)同顯著圖進(jìn)行優(yōu)化,最后使用秩約束算法將多種顯著信息進(jìn)行融合,,在進(jìn)一步增強(qiáng)目標(biāo)顯著性的同時(shí)降低了非顯著區(qū)域的影響,。在標(biāo)準(zhǔn)數(shù)據(jù)集上的檢測(cè)結(jié)果證明了本文方法的優(yōu)越性能,。

1 RGB-D圖像的協(xié)同顯著性檢測(cè)

1.1 基于DHSNet的單幅圖像顯著性檢測(cè)

深度學(xué)習(xí)誕生以后,,研究人員提出了各種模型來(lái)進(jìn)行顯著性檢測(cè)。盡管一些卷積網(wǎng)絡(luò)在檢測(cè)效果上取得了長(zhǎng)足進(jìn)步,,但仍然可能存在以下不足:(1)沒(méi)有優(yōu)先考慮全局特征,;(2)單獨(dú)處理超像素等局部區(qū)域時(shí),并沒(méi)有在映射空間中充分利用它們之間的關(guān)聯(lián)信息,。深度層次神經(jīng)網(wǎng)絡(luò)(Deep Hierarchical Saliency Network,,DHSNet)[3]很好地克服了這些不足,它采用先卷積而后逐步細(xì)化微調(diào)的方式不斷優(yōu)化顯著性檢測(cè)結(jié)果,。因此,,給定RGB圖像集 ,采用DHSNet來(lái)獲得效果良好的單幅圖像的顯著圖

,采用DHSNet來(lái)獲得效果良好的單幅圖像的顯著圖 ,。

,。

1.2 基于多視角信息融合的圖像協(xié)同顯著性檢測(cè)算法

(1)多圖模型

僅依賴(lài)于單一圖模型的檢測(cè)算法[8]不可避免地會(huì)丟失部分重要的圖像信息,,因此本文提出了一種基于多視角信息融合的協(xié)同顯著性檢測(cè)算法,通過(guò)多種圖像特征建立多圖模型[11]來(lái)檢測(cè)協(xié)同顯著目標(biāo),。給定RGB圖像集 及屬于Ii的超像素[6]的集合Ωi=

及屬于Ii的超像素[6]的集合Ωi= ,,首先抽取共G種類(lèi)型的圖像特征,接著,,將任一超像素作為節(jié)點(diǎn)V,,將節(jié)點(diǎn)之間的特征距離作為連接權(quán)重建立圖模型ζ=(V,W),定義連接權(quán)重為:

,,首先抽取共G種類(lèi)型的圖像特征,接著,,將任一超像素作為節(jié)點(diǎn)V,,將節(jié)點(diǎn)之間的特征距離作為連接權(quán)重建立圖模型ζ=(V,W),定義連接權(quán)重為:

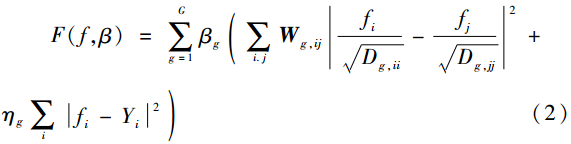

式中xg,j為節(jié)點(diǎn)xg,i的近鄰節(jié)點(diǎn),,g表示某一種圖像特征,。采用多種類(lèi)型的圖像特征建立多圖模型,其損失函數(shù)為:

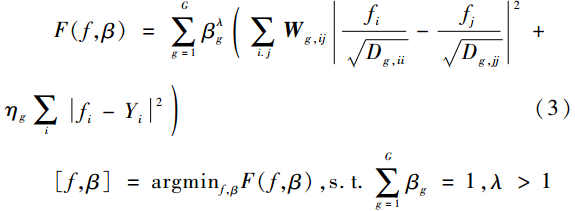

其中矩陣Wg,ij由wg,ij構(gòu)成且Dg,ii=![]() ,。理論上,,每個(gè)圖模型的權(quán)重是不同的,。引入?yún)?shù)λ獲得公式(1)關(guān)于f和β的凸模型:

,。理論上,,每個(gè)圖模型的權(quán)重是不同的,。引入?yún)?shù)λ獲得公式(1)關(guān)于f和β的凸模型:

采用迭代的方式對(duì)式(3)求解。分別對(duì)f以及β求導(dǎo),,有:

固定f求βg:

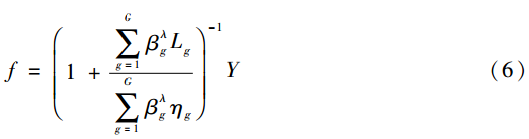

固定β可以求得f:

其中fT是f的轉(zhuǎn)置矩陣,,Lg=D-1/2gWgD-1/2g為相應(yīng)的拉普拉斯矩陣。

(2)協(xié)同顯著性檢測(cè)

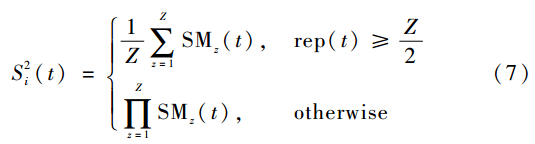

考慮到單幅圖像的顯著圖可以為協(xié)同顯著目標(biāo)的檢測(cè)提供重要的信息,,因此采用流行排序算法進(jìn)行協(xié)同顯著性檢測(cè),。給定單幅圖像的顯著圖S1,對(duì)于任一包含Z幅圖像的圖像組,,首先根據(jù)顯著圖S1給每張圖像賦初始顯著值,,記為y=[y1,y2,…,yZ],對(duì)于任意yk(1≤k≤Z),,可以通過(guò)協(xié)同顯著性檢測(cè)算法公式(6)獲得余下的(Z-1)張圖像的初始協(xié)同顯著圖,,按照相同的方法,對(duì)每一張圖像輪流進(jìn)行上述操作,。因此對(duì)于每幅圖像總共可以得到(Z-1)張協(xié)同顯著圖SMZ-1和1張初始的顯著圖,。將Z幅顯著圖SMZ進(jìn)行融合獲得協(xié)同顯著圖 :

:

其中t表示超像素, rep(·)為在Z個(gè)圖像中某一超像素被記為顯著目標(biāo)的次數(shù)。通過(guò)該算法過(guò)程,,不僅可以在單幅圖像顯著圖的基礎(chǔ)上增加未標(biāo)記的協(xié)同顯著區(qū)域,,而且抑制了非協(xié)同顯著區(qū)域。

1.3 基于深度圖的顯著性檢測(cè)及融合

對(duì)比因子類(lèi)似于人類(lèi)視覺(jué)系統(tǒng)的感受野,,因此對(duì)比線索廣泛用于顯著性度量,。對(duì)于圖像Ii的任一像素點(diǎn)ra,定義特征對(duì)比線索[12]為:

![]()

與RGB圖一樣,,深度空間里唯一的距離信息也可以增強(qiáng)目標(biāo)的顯著性,。D(ra,rb)為像素ra和rb的深度信息差異,也可以看作是相對(duì)顯著程度,,ω(ra,rb)是空間權(quán)重項(xiàng),,分別定義為:

其中,d(ra,rb)是像素ra和rb的歐式空間距離, α2為常數(shù)控制空間權(quán)重,。在視覺(jué)注意機(jī)制中,,人們更傾向于關(guān)注圖像的中心區(qū)域。因此引入空間偏置進(jìn)行平滑:

![]()

式中第一項(xiàng)反映了中心偏置,,la為像素坐標(biāo),,N是高斯核函數(shù),θ為圖像中心,,方差σ2為歸一化后的圖像半徑,。第二項(xiàng)為深度信息偏置,定義為:

![]()

其中,,q=max{da}-min{da},,為深度圖中距離da最遠(yuǎn)和最近的像素之間的距離,,γ為平衡參數(shù)。借助于中心偏置,,基于深度圖的顯著性檢測(cè)模型可以定義為:

![]()

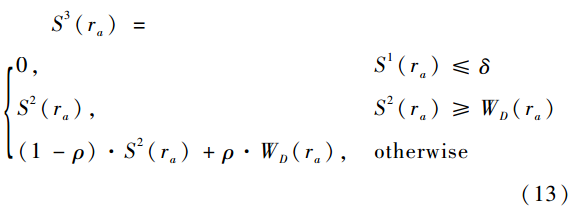

基于深度信息的顯著圖雖然包含了重要的顯著信息,,但同時(shí)也要進(jìn)一步去除非協(xié)同顯著的區(qū)域??紤]到單幅圖像的顯著圖S1基本包含了顯著區(qū)域,,首先采用掩碼的方式大致剔除非前景區(qū)域,然后考慮如下的融合方法:如果協(xié)同顯著區(qū)域的顯著值較大則將其保留下來(lái),,否則應(yīng)將其與基于深度信息的顯著圖進(jìn)行線性擬合,,即:

1.4 基于秩約束的融合算法

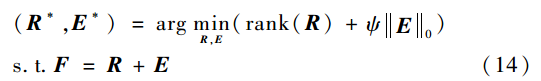

作為顯著性檢測(cè)研究的發(fā)展,協(xié)同顯著性檢測(cè)不僅和單幅圖像的顯著性檢測(cè)一樣遵循視覺(jué)顯著機(jī)制,,而且顯著目標(biāo)在多張圖片中展現(xiàn)出了較高的相似度和穩(wěn)定性,,在數(shù)學(xué)矩陣上表現(xiàn)為低秩特征,稱(chēng)之為秩約束[13],。給定圖片集 ,,通過(guò)M個(gè)顯著性檢測(cè)方法計(jì)算獲得N×M顯著圖。首先通過(guò)顯著性閾值(設(shè)置為0.3)得到圖像的前景區(qū)域f,,然后計(jì)算得到1 000維的RGB顏色直方圖作為該前景區(qū)域的顏色特征,,記為F=[f1,f2,…,fM],,計(jì)算其近似低秩矩陣R:

,,通過(guò)M個(gè)顯著性檢測(cè)方法計(jì)算獲得N×M顯著圖。首先通過(guò)顯著性閾值(設(shè)置為0.3)得到圖像的前景區(qū)域f,,然后計(jì)算得到1 000維的RGB顏色直方圖作為該前景區(qū)域的顏色特征,,記為F=[f1,f2,…,fM],,計(jì)算其近似低秩矩陣R:

式中ψ為控制E的稀疏性的權(quán)重參數(shù),,采用主成分分析算法(RPCA)[14]來(lái)解決相應(yīng)的凸優(yōu)化問(wèn)題。理論上,,對(duì)于所有的輸入圖像, 其協(xié)同顯著圖通過(guò)利用自適應(yīng)權(quán)重融合每個(gè) 獲得:

獲得:

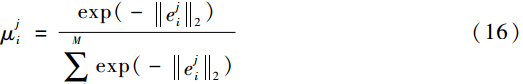

式中 為

為 的權(quán)重,,滿足0≤

的權(quán)重,,滿足0≤ ≤1,且:

≤1,且:

其中 為E*的第i列。當(dāng)稀疏誤差越小時(shí),,該區(qū)域的協(xié)同顯著性概率就越大,。

為E*的第i列。當(dāng)稀疏誤差越小時(shí),,該區(qū)域的協(xié)同顯著性概率就越大,。

2 實(shí)驗(yàn)結(jié)果及分析

2.1 數(shù)據(jù)集及評(píng)價(jià)標(biāo)準(zhǔn)

Cosal150數(shù)據(jù)集目前被廣泛用于RGB-D圖像協(xié)同顯著性檢測(cè)。實(shí)驗(yàn)中,,令α2=0.4,,ηg=0.01,γ=5,,ρ=0.5,,δ=0.01,σ2=1,,ψ=0.05,。對(duì)于RGB圖像分別抽取顏色特征以及紋理特征,同時(shí)通過(guò)FCN[15]深度網(wǎng)絡(luò)抽取Conv1_2層特征和Conv5_3層特征,,因此G=4,。在實(shí)驗(yàn)中經(jīng)過(guò)MAE測(cè)試令λ=1.2,。在秩約束融合過(guò)程中,將S1,、S2,、S3以及通過(guò)LI G等[16]設(shè)計(jì)的深度學(xué)習(xí)模型獲得的單幅圖像顯著圖進(jìn)行融合。為了定量比較試驗(yàn)效果,,采用準(zhǔn)確率-召回率(Precision-Recall)曲線和平均絕對(duì)誤差(MAE)兩種評(píng)價(jià)規(guī)則,。準(zhǔn)確率與召回率曲線是通過(guò)改變顯著閾值判斷像素是否顯著獲得的。MAE是顯著圖和真實(shí)標(biāo)注圖之間的平均絕對(duì)誤差,,定義為:

其中,,S(x,y)為算法預(yù)測(cè)的顯著圖,GT(x,y)為標(biāo)注的真實(shí)顯著圖,,W,、H分別為圖像的寬度和高度。

2.2 效果對(duì)比

將本文提出的算法與其他協(xié)同顯著性檢測(cè)方法做對(duì)比,。對(duì)于RGB圖像,,主要與模型CB[6]、HS[7],、SCS[11]進(jìn)行對(duì)比,。針對(duì)RGB-D圖像,主要與代表性的檢測(cè)模型MFM[10],、IC[9]進(jìn)行對(duì)比,。實(shí)驗(yàn)結(jié)果如圖2以及表1所示??梢钥吹?,本文方法在PR曲線上大幅領(lǐng)先其他方法。對(duì)于MAE,,本文方法取得了最小值0.093,,相比MFM下降了32.61%。

2.3 算法分析

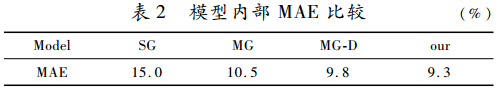

為了證明多圖模型以及深度信息的重要作用,,對(duì)算法模型進(jìn)行逐步分析,。實(shí)驗(yàn)結(jié)果如圖3及表2所示。從PR曲線可以看到在采用多圖模型后(MG),檢測(cè)結(jié)果與單圖模型[8](SG)相比有顯著提升,,對(duì)應(yīng)的MAE下降了30.00%,。加入深度信息后(MG-D),PR曲線進(jìn)一步提升,,同時(shí)MAE相比MG下降了6.67%,。進(jìn)一步地,在采用秩約束算法融合顯著信息(our)后,,PR曲線達(dá)到最優(yōu),,MAE也獲得了最小值0.093,,與MG-D相比繼續(xù)下降了5.10%。該分析實(shí)驗(yàn)表明,,深度信息在圖像協(xié)同顯著檢測(cè)中起到巨大作用,,同時(shí)融合多種顯著信息能有效提升檢測(cè)效果。

3 結(jié)論

本文提出了一種基于多視角信息融合的RGB-D圖像協(xié)同顯著性檢測(cè)算法,。該算法通過(guò)使用多種類(lèi)型的圖像特征建立多圖模型,,有效克服了單一圖模型在檢測(cè)過(guò)程中的信息丟失問(wèn)題。實(shí)驗(yàn)還表明融合深度信息能有效提升協(xié)同顯著性檢測(cè)效果,。值得指出的是,,本文提出的方法不僅適合RGB-D圖像協(xié)同顯著性檢測(cè)任務(wù),也同樣適用于RGB圖像的協(xié)同顯著性檢測(cè),。接下來(lái)的工作將更好地融合深度特征以及采用深度學(xué)習(xí)方法進(jìn)行RGB-D圖像的協(xié)同顯著性檢測(cè),。

參考文獻(xiàn)

[1] KOCH C, ULLMAN S. Shifts in selective visual attention: towards the underlying neural circuitry[M].Matters of Intelligence, Springer Netheriands, 1987.

[2] TONG N, LU H, ZHANG L, et al. Saliency detection with multi-scale superpixels[J]. IEEE Signal Processing Letters, 2014, 21(9): 1035-1039.

[3] LIU N, HAN J. DHSNet: deep hierarchical saliency network for salient object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 678-686.

[4] Cong Runmin, Lei Jianjun, Zhang Changqing, et al. Saliency detection for stereoscopic images based on depth confidence analysis and multiple cues fusion[J]. IEEE Signal Processing Letters, 2016,23(6):819-823.

[5] GUO J, REN T, BEI J. Salient object detection for RGB-D image via saliency evolution[C]//2016 IEEE International Conference on Multimedia and Expo (ICME). IEEE, 2016: 1-6.

[6] FU H, CAO X, TU Z. Cluster-based co-saliency detection[J]. IEEE Transactions on Image Processing, 2013, 22(10): 3766-3778.

[7] LIU Z, ZOU W, LI L, et al. Co-saliency detection based on hierarchical segmentation[J]. IEEE Signal Processing Letters, 2014, 21(1): 88-92.

[8] LI Y, FU K, LIU Z, et al. Efficient saliency-model-guided visual co-saliency detection[J]. IEEE Signal Processing Letters, 2015, 22(5): 588-592.

[9] CONG R, LEI J, FU H, et al. An iterative co-saliency framework for RGBD images[J]. IEEE Transactions on Cybernetics, 2017(99):1-14.

[10] CONG R, LEI J, FU H, et al. Co-saliency detection for RGBD images based on multi-constraint feature matching and cross label propagation[J]. IEEE Transactions on Image Processing, 2018, 27(2): 568-579.

[11] ZHAO S, YAO H, YANG Y, et al. Affective image retrieval via multi-graph learning[C]//Proceedings of the 22nd ACM International Conference on Multimedia. ACM, 2014: 1025-1028.

[12] LIU T, YUAN Z, SUN J, et al. Learning to detect a salient object[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(2): 353-367.

[13] CAO X, TAO Z, ZHANG B, et al. Self-adaptively weighted co-saliency detection via rank constraint[J]. IEEE Transactions on Image Processing, 2014, 23(9): 4175-4186.

[14] CANDS E J, LI X, MA Y, et al. Robust principal component analysis?[J]. Journal of the ACM (JACM), 2011, 58(3): 11.

[15] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431-3440.

[16] LI G, YU Y. Deep contrast learning for salient object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 478-487.

(收稿日期:2018-04-29)

作者簡(jiǎn)介:

吳乾紳(1990-),男,,碩士,,主要研究方向:模式識(shí)別。