以布里斯托市A38路旁的噴泉池為起始點(diǎn),你需要花用不到20分鐘時(shí)間,就可以騎自行車“沖”出這座英國(guó)西南部城市的CBD,進(jìn)入幾乎只有成排英式平房、灌木叢和河道的郊外。

沒(méi)錯(cuò),即便布里斯托(Bristol)是名副其實(shí)的英國(guó)西南部中心,但從城市規(guī)模來(lái)看,但它依然被很多中國(guó)留學(xué)生起了一個(gè)非常清新脫俗的名字——“布村”。( “除了倫敦,其他都是村兒”。)

然而,如今接觸芯片產(chǎn)業(yè)后,我們才恍然發(fā)現(xiàn),這座古老的英國(guó)小城,竟然藏著英國(guó)最強(qiáng)大的半導(dǎo)體產(chǎn)業(yè)集群之一。

圖為英偉達(dá)在布里斯托的研發(fā)中心。2011年收購(gòu)英國(guó)半導(dǎo)體公司 Icera 后,英偉達(dá)便在布里斯托扎根,并在這里投資上千萬(wàn)英鎊建立新工廠和實(shí)驗(yàn)室

1972年,硅谷大名鼎鼎的仙童半導(dǎo)體(英特爾、AMD的創(chuàng)始人們都是從這家公司出來(lái)的)為進(jìn)入歐洲市場(chǎng)做出了一個(gè)重要決策——在布里斯托設(shè)立一個(gè)辦事處。自此,便打開了這座英國(guó)西部小城面向半導(dǎo)體產(chǎn)業(yè)的全球視野。

而6年后,誕生于布里斯托,并在80年代占據(jù)全球SRAM市場(chǎng)60%份額的微處理器公司Inmos,接受了卡拉漢政府與撒切爾政府高達(dá)2億英鎊的投資,才終于創(chuàng)造出以布里斯托核心的英國(guó)半導(dǎo)體基礎(chǔ)設(shè)施與生態(tài)系統(tǒng),召集了大批像XMOS 半導(dǎo)體創(chuàng)始人、英國(guó)著名計(jì)算機(jī)科學(xué)家David May這樣的半導(dǎo)體超級(jí)精英。

“其實(shí)布里斯托一直都是英國(guó)的IT重鎮(zhèn)。它與周圍的斯溫頓、格洛斯特組成一個(gè)三角地帶,被稱為歐洲的‘硅谷’。半導(dǎo)體公司如果在歐洲設(shè)立研發(fā)中心,布里斯托通常是首選。譬如英偉達(dá)、惠普、博通、高通等世界級(jí)巨頭都在布里斯托設(shè)有辦事處。”

一位了解歐洲半導(dǎo)體產(chǎn)業(yè)的從業(yè)者告訴虎嗅,很多人因?yàn)锳RM對(duì)劍橋印象深刻,但從歷史來(lái)看,實(shí)際上布里斯托才是英國(guó)的芯片設(shè)計(jì)中心。

“華為也在布里斯托也有研發(fā)中心。”

就像上世紀(jì)50年代,8位天才“叛徒”離開仙童半導(dǎo)體創(chuàng)立英特爾、AMD、泰瑞達(dá)等公司,才成就了如今的硅谷一樣,布里斯托才華橫溢的工程師們也不甘于停留在“過(guò)去”——在摩爾定律失效爭(zhēng)議進(jìn)入高潮,人工智能、計(jì)算結(jié)構(gòu)發(fā)生異變的“臨界點(diǎn)”上,沒(méi)有人不渴望能夠成為那個(gè)改變時(shí)代的領(lǐng)導(dǎo)者。

一位名叫 Simon Knowles 的工程師從劍橋大學(xué)畢業(yè)后,在1989年第一次踏上布里斯托的土地,接受了存儲(chǔ)器企業(yè)Inmos的一份芯片設(shè)計(jì)工作。

在此后近20年里,從Inmos內(nèi)部一個(gè)專用處理器團(tuán)隊(duì)的領(lǐng)導(dǎo)者,再到兩家半導(dǎo)體企業(yè)Element 14與 Icera的創(chuàng)始人之一,Knowles幾乎見證了摩爾定律達(dá)到巔峰和走向衰落的全過(guò)程。而幸運(yùn)的是,Knowles參與創(chuàng)立的這兩家總估值超過(guò)10億美元的公司,分別在2000年和2011年被博通和英偉達(dá)收購(gòu)。

沒(méi)有任何意外,這位天才半導(dǎo)體設(shè)計(jì)師與連續(xù)創(chuàng)業(yè)者,又繼續(xù)在2016年另起爐灶,與另一位天才半導(dǎo)體工程師Nigel Toon創(chuàng)立了一家新的半導(dǎo)體設(shè)計(jì)公司,主動(dòng)迎擊人工智能市場(chǎng)需求觸發(fā)的芯片架構(gòu)創(chuàng)新機(jī)會(huì)。

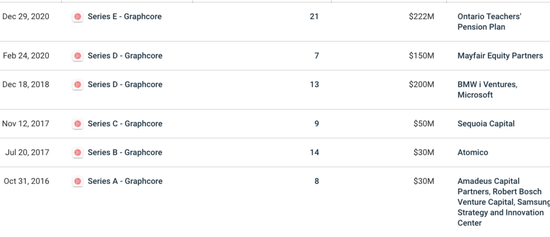

沒(méi)錯(cuò),這家公司就是剛在2020年12月29日宣布完成2.22億融資(這筆融資也讓公司的資產(chǎn)負(fù)債表上擁有4.4億美元現(xiàn)金),估值已高達(dá)27.7億美元,被外媒稱為英偉達(dá)最大對(duì)手之一的人工智能加速處理器設(shè)計(jì)商Graphcore。

需要注意,它也是目前西方AI芯片領(lǐng)域唯一的獨(dú)角獸。

圖片為Graphcore的IPU處理器

西方私募與風(fēng)投對(duì)待半導(dǎo)體這種項(xiàng)目一直非常謹(jǐn)慎,因?yàn)樗鼈冑Y金高度密集且無(wú)法預(yù)估前期投資回報(bào)。正如Knowles在一次采訪時(shí)承認(rèn):“與能夠小規(guī)模嘗試、不成功再換一個(gè)坑的軟件產(chǎn)業(yè)相比,如果一枚芯片設(shè)計(jì)失敗,除了花光所有錢,公司幾乎無(wú)路可選。”

因此,直到2018年以后,隨著人工智能商業(yè)化的可能性被持續(xù)鼓吹和放大,投資者們才確定可以從“人工智能大規(guī)模運(yùn)算驅(qū)動(dòng)芯片結(jié)構(gòu)變革”的趨勢(shì)中看到回報(bào)前景。

于是,在2017年獲得了超過(guò)8000萬(wàn)美元投資后的Graphcore,又接連在2018年與2020年分別獲得2億與1.5億美元風(fēng)險(xiǎn)投資。

需要注意的是,除了博世、三星從A輪就開始參投,紅杉資本是Graphcore的C輪領(lǐng)投方,而微軟與寶馬i風(fēng)投則成為其D輪融資領(lǐng)投方;

而E輪融資的主要參與者,則是非產(chǎn)業(yè)基金——加拿大安大略省教師養(yǎng)老金計(jì)劃委員會(huì)領(lǐng)投,富達(dá)國(guó)際與施羅德集團(tuán)也加入了這輪融資。

你可以從投資方看出,Graphcore的產(chǎn)業(yè)投資方基本分為三個(gè)產(chǎn)業(yè)方向——云計(jì)算(數(shù)據(jù)中心)、移動(dòng)設(shè)備(手機(jī))與汽車(自動(dòng)駕駛)。沒(méi)錯(cuò),這是三個(gè)最早被人工智能技術(shù)“入侵”的產(chǎn)業(yè)。

圖片來(lái)自Crunchbase

工業(yè)界們似乎越來(lái)越達(dá)成這樣一個(gè)共識(shí),未來(lái)需要有一家像ARM主導(dǎo)移動(dòng)設(shè)備時(shí)代一樣的底層創(chuàng)新企業(yè),除了有希望賣出上億塊芯片的同時(shí),也能推動(dòng)人工智能與各個(gè)產(chǎn)業(yè)的深度整合,最終觸達(dá)到上百億普通消費(fèi)者。

從產(chǎn)品的角度來(lái)看,Graphcore 在2020年拿出了相對(duì)引人注目的作品——推出第二代 IPU-M2000芯片,該芯片搭載在一個(gè)名為IPU Machine platform的計(jì)算平臺(tái)上。另外,其芯片配套的軟件棧工具Poplar也有同步更新。

“教計(jì)算機(jī)如何學(xué)習(xí),與教計(jì)算機(jī)做數(shù)學(xué)題,是完全不同的兩件事。提升一臺(tái)機(jī)器的‘理解力’,底層驅(qū)動(dòng)注重的是效率,而不是速度。” Graphcore CEO Nigel Toon 將新一代AI芯片的開發(fā)工作視為一個(gè)“千載難逢的機(jī)會(huì)”。

“任何公司能做到這一點(diǎn),都能分享對(duì)未來(lái)幾十年人工智能技術(shù)創(chuàng)新和商業(yè)化的決定權(quán)。”

切中英偉達(dá)的“軟肋”

沒(méi)有一家AI芯片設(shè)計(jì)公司不想干掉市值高達(dá)3394億美元的英偉達(dá)。或者說(shuō),沒(méi)有一家公司不想做出比GPU更好的人工智能加速器產(chǎn)品。

因此,近5年來(lái),大大小小的芯片設(shè)計(jì)公司都傾向于在PPT上,用英偉達(dá)的T4、V100,甚至是近期發(fā)布的“最強(qiáng)產(chǎn)品”A100與自己的企業(yè)級(jí)芯片產(chǎn)品做比較,證明自己的處理器擁有更好的運(yùn)算效率。

Graphcore也沒(méi)有例外。

他們同樣認(rèn)為,由于上一代的微處理器——譬如中央處理器(CPU)和圖形處理單元(GPU)并不是為人工智能相關(guān)工作而專門設(shè)計(jì),工業(yè)界需要一種全新的芯片架構(gòu),來(lái)迎合全新的數(shù)據(jù)處理方式。

當(dāng)然,這樣的說(shuō)法并不是利益相關(guān)者們的單純臆想。

我們無(wú)法忽視來(lái)自學(xué)術(shù)界與產(chǎn)業(yè)界對(duì)GPU越來(lái)越多的雜音——隨著人工智能算法訓(xùn)練與推理模型多樣性的迅速增加,在誕生之初并不是為了人工智能而設(shè)計(jì)的GPU暴露出了自己“不擅長(zhǎng)”的領(lǐng)域。

“如果你做的只是深度學(xué)習(xí)里的卷積神經(jīng)網(wǎng)絡(luò)(CNN),那么GPU是一個(gè)很好的解決方案,但網(wǎng)絡(luò)已經(jīng)越‘長(zhǎng)’越復(fù)雜,GPU已經(jīng)難以滿足AI開發(fā)者們?cè)絹?lái)越大的胃口。”

一位算法工程師向虎嗅指出,GPU之所以快,是因?yàn)樗焐湍懿⑿刑幚砣蝿?wù)(GPU的釋義和特點(diǎn)可以看《干掉英偉達(dá)》這篇文章)。如果數(shù)據(jù)存在“順序”,無(wú)法并行,那么還得用回CPU。

“很多時(shí)候既然硬件是固定的,我們會(huì)想辦法從軟件層,把存在順序的數(shù)據(jù),變?yōu)椴⑿械臄?shù)據(jù)。譬如語(yǔ)言模型中,文字是連續(xù)的,靠一種‘導(dǎo)師驅(qū)動(dòng)’的訓(xùn)練模式就可以轉(zhuǎn)換為并行訓(xùn)練。

但肯定不是所有模型都可以這么做,譬如深度學(xué)習(xí)中的‘強(qiáng)化學(xué)習(xí)’不太適合用GPU,而且也很難找到并行方式。”

由此來(lái)看,學(xué)術(shù)圈不少人甚至喊出“GPU阻礙了人工智能的創(chuàng)新”這句話,并不是聳人聽聞。

深度學(xué)習(xí)的4個(gè)發(fā)展脈絡(luò),制圖:宇多田

“深度學(xué)習(xí)”,這個(gè)近10年來(lái)機(jī)器學(xué)習(xí)領(lǐng)域發(fā)展最快的一個(gè)分支,其神經(jīng)網(wǎng)絡(luò)模型發(fā)展之快、類型之廣,只靠GPU這塊硬件的“一己之力”是很難追上其復(fù)雜運(yùn)算腳步的。

Graphcore 回復(fù)了虎嗅一份更為詳盡的答案。他們認(rèn)為,對(duì)于深度學(xué)習(xí)中除去CNNs的另外幾個(gè)分支,特別是循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)與強(qiáng)化學(xué)習(xí)(RL),讓很多開發(fā)者的研究領(lǐng)域受到了限制。

譬如,用強(qiáng)化學(xué)習(xí)做出了阿爾法狗的英國(guó)AI公司 Deepmind,很早就因?yàn)镚PU的計(jì)算局限問(wèn)題而關(guān)注Graphcore,其創(chuàng)始人Demis Hassabis最后成為了Graphcore的投資人。

“很多企業(yè)產(chǎn)品部門的開發(fā)者把需求(特別是延時(shí)和吞吐量的數(shù)據(jù)指標(biāo))交給算力平臺(tái)部門時(shí),他們通常會(huì)拒絕說(shuō) ‘GPU 目前不夠支持這么低的延時(shí)和這么高的吞吐量’。

主要原因就在于,GPU的架構(gòu)更適用于‘靜態(tài)圖像分類與識(shí)別’等擁有高稠密數(shù)據(jù)量的計(jì)算機(jī)視覺(jué)(CV)任務(wù),但對(duì)數(shù)據(jù)稀疏的模型訓(xùn)練并不是最好的選擇。

而跟文字相關(guān)的“自然語(yǔ)言處理”(NLP)等領(lǐng)域的算法,一方面數(shù)據(jù)沒(méi)那么多(稀疏),另一方面,這類算法在訓(xùn)練過(guò)程中需要多次傳遞數(shù)據(jù),并迅速給出階段性反饋,以便為下一步訓(xùn)練提供一個(gè)便于理解上下文的語(yǔ)境。”

換句話說(shuō),這是一個(gè)數(shù)據(jù)在持續(xù)流動(dòng)和循環(huán)的訓(xùn)練過(guò)程。

就像淘寶界面的“猜你喜歡”,在第一天在“學(xué)習(xí)”了你的瀏覽和訂單數(shù)據(jù)后,把不太多的經(jīng)驗(yàn)反饋給算法進(jìn)行修正,第二天、第三天以及未來(lái)的每一天不斷學(xué)習(xí)不斷反饋,才會(huì)變得愈加了解你的產(chǎn)品喜好。

而這類任務(wù),譬如谷歌為更好優(yōu)化用戶搜索在2018年提出的BERT模型,便是優(yōu)秀且影響深遠(yuǎn)的RNN模型之一,也是Graphcore提到的“GPU非常不擅長(zhǎng)的一類任務(wù)”。為了解決這類問(wèn)題,仍然有很多公司在使用大量CPU進(jìn)行訓(xùn)練。

CPU與GPU架構(gòu)對(duì)比

從根本上看,這其實(shí)是由當(dāng)下芯片運(yùn)行系統(tǒng)最大的瓶頸之一決定的——如何在一塊處理器上,將數(shù)據(jù)盡可能快地從內(nèi)存模塊傳送到邏輯操作單元,且不費(fèi)那么多功耗。在進(jìn)入數(shù)據(jù)爆炸時(shí)代后,解鎖這個(gè)瓶頸便愈加迫在眉睫。

舉個(gè)例子,2018年10月 BERT-Large 的模型體量還是3.3 億個(gè)參數(shù),到2019年,GPT2的模型體量已達(dá)到15.5億(兩個(gè)均屬于自然語(yǔ)言處理模型)。可以說(shuō),數(shù)據(jù)量對(duì)從系統(tǒng)底層硬件到上層SaaS服務(wù)的影響已經(jīng)不可小覷。

而一塊傳統(tǒng)的GPU或CPU,當(dāng)然可以執(zhí)行連續(xù)多個(gè)操作,但它需要“先訪問(wèn)寄存器或共享內(nèi)存,再讀取和存儲(chǔ)中間計(jì)算結(jié)果”。這就像先去室外地窖拿儲(chǔ)存的食材,然后再回到室內(nèi)廚房進(jìn)行處理,來(lái)來(lái)回回,無(wú)疑會(huì)影響系統(tǒng)的整體效率和功耗。

因此,很多半導(dǎo)體新興企業(yè)的產(chǎn)品架構(gòu)核心思路,便是讓“內(nèi)存更接近處理任務(wù),以加快系統(tǒng)的速度”——近存算一體。這個(gè)概念其實(shí)并不新鮮,但能做出真東西的公司少之又少。

而Graphcore到底做到了什么?簡(jiǎn)單來(lái)說(shuō),便是“改變了內(nèi)存在處理器上的部署方式”。

在一塊差不多像小號(hào)蘇打餅一樣大的IPU處理器上,除了集成有1216塊被稱為IPU-Core的處理單元,其與GPU和CPU最大的不同,便是大規(guī)模部署了“片上存儲(chǔ)器”。

簡(jiǎn)言之,便是將SRAM(靜態(tài)隨機(jī)存儲(chǔ)器)分散集成在運(yùn)算單元旁,拋棄了外接存儲(chǔ),最大程度減少數(shù)據(jù)的搬移量。而這種方法的目標(biāo),就是想通過(guò)減少負(fù)載和存儲(chǔ)數(shù)量來(lái)突破內(nèi)存帶寬瓶頸,大大減少數(shù)據(jù)傳輸延遲,同時(shí)降低功耗。

IPU架構(gòu)

也正因?yàn)槿绱耍谝恍┨囟ㄋ惴ǖ挠?xùn)練任務(wù)中,由于所有模型都可以保存在處理器中,經(jīng)過(guò)測(cè)試,IPU的速度的確可以達(dá)到GPU的20~30倍。

舉個(gè)例子,在計(jì)算機(jī)視覺(jué)領(lǐng)域,除了大名鼎鼎且應(yīng)用廣泛的殘差網(wǎng)絡(luò)模型ResNets(與GPU很契合),基于分組卷積與深度卷積方向的圖像分類模型 EfficientNet 和 ResNeXt 模型也是逐漸興起的研究領(lǐng)域。

而“分組卷積”有個(gè)特點(diǎn),就是數(shù)據(jù)不夠稠密。

因此,微軟機(jī)器學(xué)習(xí)科學(xué)家 Sujeeth 用Graphcore的IPU做了一次基于EfficientNet模型的圖像分類訓(xùn)練。最后的結(jié)果是,IPU用30分鐘的時(shí)間完成了一次新冠肺炎胸部X光樣片的圖像分析,而這個(gè)工作量,通常需要傳統(tǒng) GPU 用5個(gè)小時(shí)來(lái)完成。

重重考驗(yàn)

但是,就像GPU的大熱與計(jì)算機(jī)視覺(jué)領(lǐng)域的主流算法模型ResNets的廣泛應(yīng)用的相輔相成,決定Graphcore成功還是失敗的關(guān)鍵,也在于“特定”。

就像Graphcore銷售副總裁兼中國(guó)區(qū)總經(jīng)理在接受虎嗅采訪時(shí)指出:

一方面,他們的產(chǎn)品的確更適用于訓(xùn)練市場(chǎng)中數(shù)據(jù)較為稀疏,精度要求較高的深度學(xué)習(xí)任務(wù),譬如與自然語(yǔ)言處理相關(guān)的推薦任務(wù),這也是阿里云與百度愿意與之達(dá)成合作的重要原因之一。

另一方面,計(jì)算機(jī)視覺(jué)領(lǐng)域剛流行起來(lái)的新模型,是IPU在努力“攻克”的方向,而之前很多模型,還是GPU最應(yīng)手。

此外,GPU創(chuàng)造的強(qiáng)大軟件生態(tài)Cuda,比硬件更不容易被破壞(關(guān)于Cuda,也在《干掉英偉達(dá)》這篇文章里有詳細(xì)解釋),而這層圍墻恰恰是開辟產(chǎn)業(yè)影響力的關(guān)鍵。

毫無(wú)疑問(wèn),Graphocore在這方面根基尚淺,因此除了常規(guī)操作,他們選擇基于編程軟件Poplar,做一些相對(duì)大膽的嘗試。

譬如,他們?cè)谧约旱拈_發(fā)者社區(qū)開放計(jì)算圖庫(kù)PopLibs的源代碼,讓開發(fā)者去嘗試描述一種新的卷積網(wǎng)絡(luò)層。這一層對(duì)標(biāo)的是GPU的cnDNN和cuBLAS,而英偉達(dá)并沒(méi)有開放它們。

為了向開源社區(qū)致敬,Poplar v1.4增加了對(duì) PyTorch 的全面支持。這一聰明的舉動(dòng)將有助于簡(jiǎn)化人們的接受程度,有助于吸引更廣泛的社區(qū)參與。

此外,為了能夠盡快打開市場(chǎng),Graphcore并沒(méi)有走“打比賽來(lái)提升產(chǎn)業(yè)知名度”的實(shí)驗(yàn)室銷售路線,而是將IPU直接推入了產(chǎn)業(yè)界,去逐個(gè)敲開服務(wù)器集成商、云廠商等客戶的大門。

“AI這個(gè)行業(yè)本身,不管是算法的迭代還是模型的變化,其實(shí)都是非常快的。有云廠商曾抱怨,說(shuō)某家處理器跑某一種模型性能非常好,但模型稍微改一改,跑出來(lái)的性能就大跌眼鏡。”

Graphcore中國(guó)區(qū)技術(shù)應(yīng)用總負(fù)責(zé)人羅旭認(rèn)為,盡管市場(chǎng)在大量鼓吹A(chǔ)SIC(專用芯片)和FPGA(可編程芯片),但通用性,仍然是產(chǎn)業(yè)界考慮芯片的首要條件,尤其是互聯(lián)網(wǎng)廠商。

“互聯(lián)網(wǎng)廠商應(yīng)用非常多,每個(gè)應(yīng)用都會(huì)有不同的適用模型。如果一個(gè)處理器只能適配一個(gè)模型,那客戶是無(wú)法引入這個(gè)處理器做大量推廣的。”

而“編程環(huán)境是否友好”,也就是英偉達(dá)Cuda貢獻(xiàn)的那種力量,是第二個(gè)關(guān)鍵的采購(gòu)指標(biāo)。

“現(xiàn)在客戶一般都是用AI框架來(lái)設(shè)計(jì)模型,比如谷歌的TensorFlow、Facebook的PyTorch等等。他們會(huì)考慮這枚處理器的上層SDK是否能夠輕松接入到框架里,以及編程模型是否好用。

客戶可能會(huì)有一些算子級(jí)別的優(yōu)化,需要做一些自定義算子。自定義算子開發(fā)起來(lái)是否方便其實(shí)也是取決于編程友好性如何。”

如果說(shuō)客戶還在乎什么,當(dāng)然是產(chǎn)品性能。

無(wú)論是云廠商、服務(wù)器廠商還是通過(guò)云服務(wù)購(gòu)買算力的開發(fā)者,都會(huì)測(cè)試多種模型跑在芯片上的性能表現(xiàn)。

“如果他們主要看重NLP(自然語(yǔ)言處理)模型,那在性能測(cè)試時(shí)就可能重點(diǎn)測(cè)一下BERT。如果他們看重計(jì)算機(jī)視覺(jué),那在性能測(cè)試時(shí)就可能重點(diǎn)測(cè)試一些計(jì)算機(jī)視覺(jué)的經(jīng)典模型。

總的來(lái)說(shuō),客戶需要從以上幾個(gè)維度綜合評(píng)估下來(lái),才能決定到底要不要使用這個(gè)處理器,或者說(shuō),必須確定這個(gè)處理器能給他們帶來(lái)多大的收益。”

而在這個(gè)方面,無(wú)論是英偉達(dá),還是Graphcore的IPU或其他廠商的專用芯片,都是有自己最擅長(zhǎng)的模型,只能說(shuō)是“各有千秋”,絕對(duì)不能以偏概全。

贏家通吃,將不復(fù)存在

從Graphcore給出的產(chǎn)品基準(zhǔn)測(cè)試指標(biāo)與宣傳重點(diǎn)來(lái)看,這家公司正在拿著錘子找釘子,努力擴(kuò)展IPU擅長(zhǎng)的應(yīng)用場(chǎng)景,以便讓IPU架構(gòu)能夠發(fā)揮最大效率。

換句話說(shuō),Graphcore或許會(huì)分英偉達(dá)的一杯羹,但永遠(yuǎn)不可能取代它們。

正如“特定”這個(gè)詞的含義所限,人工智能訓(xùn)練與推理芯片市場(chǎng),因模型的多樣性與復(fù)雜性,一定能夠容納包括英偉達(dá)、Graphcore在內(nèi)更多的芯片企業(yè)。

Nigel Toon也承認(rèn),人工智能計(jì)算將孕育出三個(gè)芯片垂直市場(chǎng):

相對(duì)簡(jiǎn)單的小型專用加速器市場(chǎng),譬如手機(jī)、攝像頭以及其他智能設(shè)備里的某個(gè)IP核;

再譬如適用于數(shù)據(jù)中心某幾個(gè)功能的ASIC芯片,具體問(wèn)題具體解決,超大規(guī)模數(shù)據(jù)中心運(yùn)營(yíng)商(云廠商)將在這個(gè)市場(chǎng)中有大量機(jī)會(huì);

最后一個(gè)是可編程的AI處理器,也就是GPU所在的市場(chǎng)。這個(gè)市場(chǎng)一定會(huì)有更多企業(yè),同時(shí)未來(lái)更多的創(chuàng)新也一定會(huì)產(chǎn)生更大的份額。

CPU會(huì)持續(xù)存在,GPU也會(huì)持續(xù)創(chuàng)新,他們?cè)谀承〢I計(jì)算任務(wù)上都是不可或缺的,或者說(shuō)是最好的選擇。但是摩爾定律失效、AI計(jì)算和數(shù)據(jù)爆炸等趨勢(shì)催生出的新市場(chǎng),一定是巨大且多樣性的。正是因?yàn)槎鄻有裕圆沤o了更多專用芯片公司新的機(jī)會(huì)。

因此,像Cerebras、Groq、 SambaNova Systems 、Mythic AI 這樣的芯片創(chuàng)業(yè)公司才得以籌集到數(shù)億美元資金,英特爾也在今年投資了革新AI芯片架構(gòu)的Untether AI。已經(jīng)有不少人給出這樣的預(yù)測(cè)——新一代的‘蘋果’與‘英特爾’可能會(huì)在人工智能計(jì)算市場(chǎng)中誕生。

在軟件還沒(méi)有跟上硬件步伐的當(dāng)下,這意味著激烈的競(jìng)爭(zhēng)才剛剛開始。