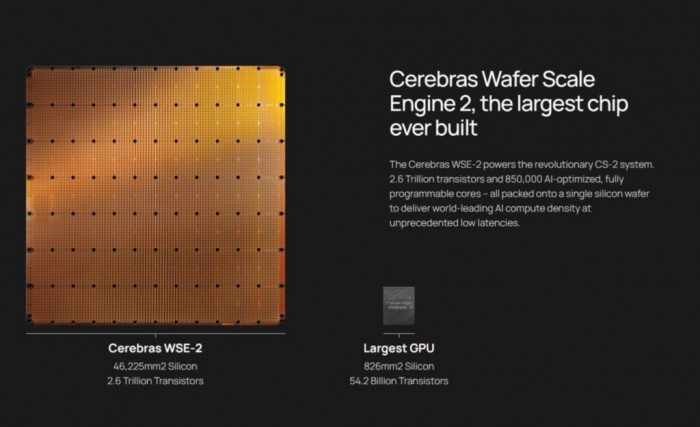

4月20日,Cerebras Systems 公司再次刷新歷史,推出為超級(jí)計(jì)算機(jī)任務(wù)而打造的第 2 代 Wafer Scale Engine (WSE-2)芯片。與一代WSE相比,WSE-2雖然在面積上沒(méi)有變化,但卻擁有創(chuàng)紀(jì)錄的 2.6 萬(wàn)億個(gè)晶體管以及 85萬(wàn)個(gè) AI 優(yōu)化的內(nèi)核,芯片的所有性能特征,包括:晶體管數(shù)、內(nèi)核數(shù)、內(nèi)存、內(nèi)存帶寬和結(jié)構(gòu)帶寬,均比一代增加了一倍以上。

差不多兩年前(2019年8月),SeaMicro 創(chuàng)始人安德魯·費(fèi)爾德曼(Andrew Feldman)創(chuàng)辦的 Cerebras Systems 公司公司,揭開(kāi)了芯片設(shè)計(jì)領(lǐng)域的一場(chǎng)革命,他們將整片晶圓制成了一個(gè)巨大的芯片。

以往的芯片制造流程,是從硅錠切下一片晶圓后在Fab中進(jìn)行加工,一片晶圓能被切成數(shù)百顆獨(dú)立的芯片。而這顆名為晶圓級(jí)引擎(Wafer Scale Engine,WSE-1)的處理器直接把整片晶圓做成了一顆芯片,面積與12英寸晶圓所能截取的最大矩形面積一樣——比iPad還大。

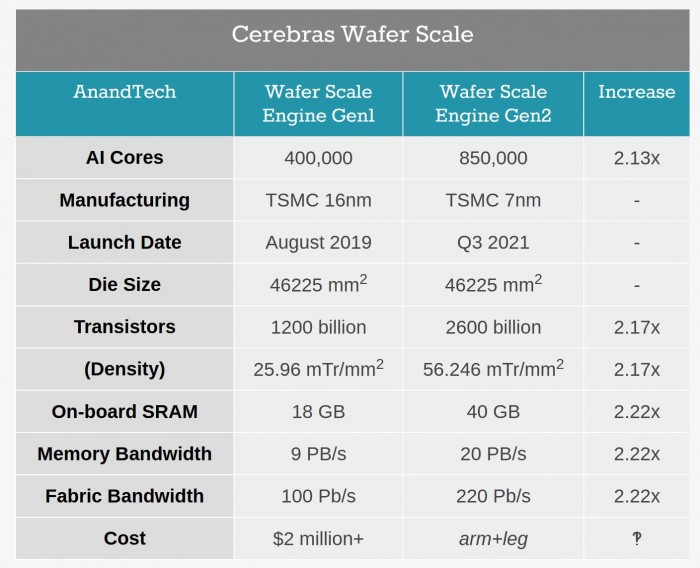

不過(guò),這顆芯片的每一塊區(qū)域都能被稱(chēng)為內(nèi)核,它們以一種復(fù)雜的方式與其他內(nèi)核相互連接。互聯(lián)的設(shè)計(jì)是為了保持所有內(nèi)核的高速運(yùn)轉(zhuǎn),以便所有晶體管能夠作為一個(gè)整體一起工作。在 2019 年推出的WSE-1中,Cerebras 融入了 40 萬(wàn)個(gè)內(nèi)核和 1.2萬(wàn)億個(gè)晶體管,采用的是 16 納米工藝進(jìn)行制造,可同時(shí)專(zhuān)注于AI和HPC(High Performance Computing,高性能計(jì)算機(jī)群)工作負(fù)載。

更狠的第二代(WSE-2)來(lái)了

4月20日,Cerebras Systems 公司再次刷新歷史,推出為超級(jí)計(jì)算機(jī)任務(wù)而打造的第二代 Wafer Scale Engine (WSE-2)芯片。與一代WSE相比,WSE-2雖然在面積上沒(méi)有變化,但卻擁有創(chuàng)紀(jì)錄的 2.6 萬(wàn)億個(gè)晶體管以及 85萬(wàn)個(gè) AI 優(yōu)化的內(nèi)核,芯片的所有性能特征,包括:晶體管數(shù)、內(nèi)核數(shù)、內(nèi)存、內(nèi)存帶寬和結(jié)構(gòu)帶寬,均比一代增加了一倍以上。

這得益于WSE-2采用基于臺(tái)積電(TSMC)的N7工藝(7nm)打造,使得邏輯電路可以按比例縮小,并在一定程度上縮小了SRAM,讓新芯片上可以容納更多AI內(nèi)核。Feldman 說(shuō),有了這樣的先進(jìn)工藝支持,Cerebras 可以在同樣的8*8英寸,面積約46225mm2的芯片中塞進(jìn)更多的晶體管。

WSE-2與一代對(duì)比(圖自:AnanTech)

值得注意的是,在功能提升的前提下,Cerebras還能夠保持其系統(tǒng)功耗不變(23 kW)。

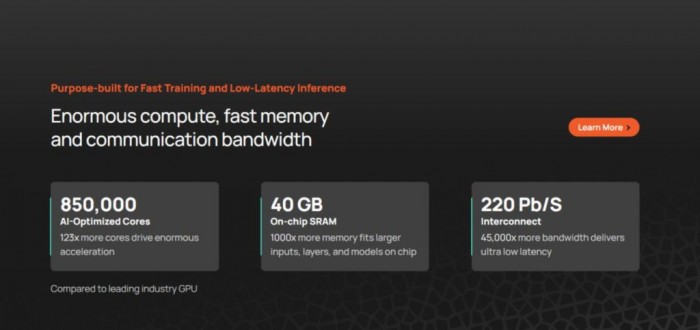

對(duì)比市場(chǎng)上第二大AI處理器,英偉達(dá)的Ampere A100面積約為826mm2,具有0.054萬(wàn)億個(gè)晶體管。WSE-2比它多了2.55萬(wàn)億個(gè)晶體管;內(nèi)核數(shù)是A100的123倍;緩存是其1000倍;可提供的內(nèi)存帶寬,則達(dá)到了A100的13萬(wàn)倍。

Cerebras還引用了1000倍的板載內(nèi)存,帶有40 GB的SRAM,而Ampere A100則為40 MB。

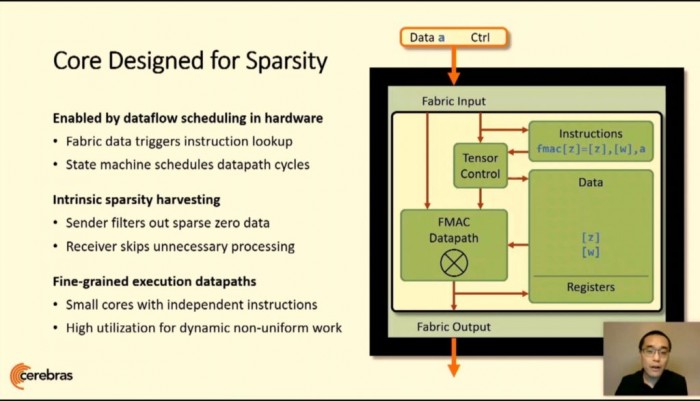

最初推出WSE-1的時(shí)候,很多人擔(dān)心這么大的晶圓做芯片,萬(wàn)一其中一塊不良,是否整個(gè)報(bào)廢?對(duì)此Cerebras解釋說(shuō),他們通過(guò)設(shè)計(jì)一種可以繞開(kāi)任何制造缺陷的系統(tǒng)來(lái)實(shí)現(xiàn)100%的良率,核心與帶有FMAC數(shù)據(jù)路徑的2D Mesh連接

Cerebras在WSE-1用了1.5%的額外核心來(lái)容納缺陷,但由于臺(tái)積電工藝的提升,這個(gè)數(shù)值被進(jìn)一步縮小了。

晶圓級(jí)引擎存在的意義

WSE的出現(xiàn),是因?yàn)橛?xùn)練神經(jīng)網(wǎng)絡(luò)需要花費(fèi)較多的時(shí)間,即便是當(dāng)今最先進(jìn)的模型,也需要幾天或幾周的時(shí)間進(jìn)行訓(xùn)練,大型網(wǎng)絡(luò)則需要數(shù)周。通常做法是在數(shù)十、數(shù)百甚至數(shù)千個(gè)GPU上進(jìn)行分布式訓(xùn)練,以使訓(xùn)練時(shí)間更可控。

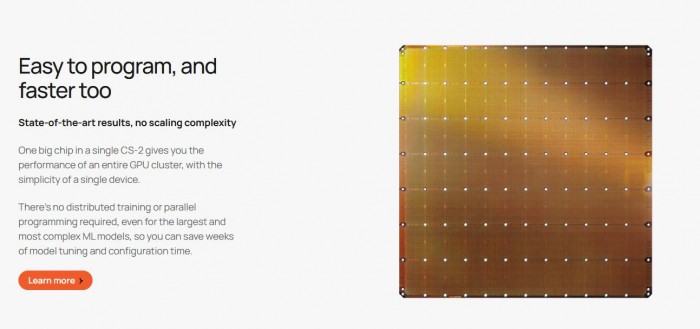

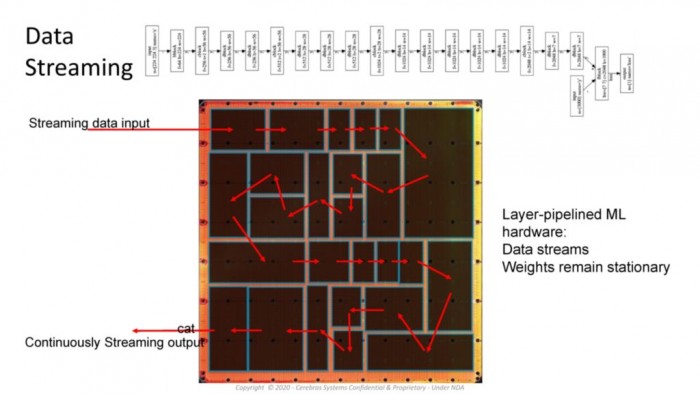

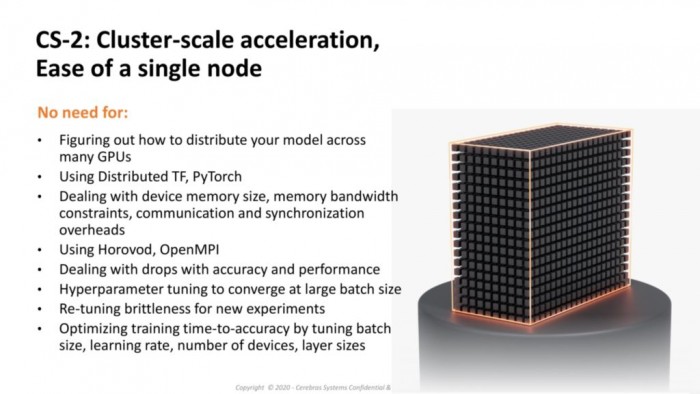

其中最大的瓶頸,是這些龐大的處理器集群很難編程,而且數(shù)據(jù)必須在處理器和外部 DRAM 存儲(chǔ)器之間進(jìn)行多次傳輸,既浪費(fèi)時(shí)間又消耗能源。所以WSE研發(fā)團(tuán)隊(duì)的初衷是擴(kuò)大芯片,使它與 AI 處理器內(nèi)核一起容納所需的所有數(shù)據(jù),一個(gè)CS-2的性能相當(dāng)于整個(gè)GPU集群的性能,同時(shí)具有單個(gè)設(shè)備的簡(jiǎn)單性……

其設(shè)計(jì)的關(guān)鍵是自定圖形編譯器,采用pyTorch或TensorFlow將每一層映射到芯片的物理部分,從而允許在數(shù)據(jù)流過(guò)時(shí)進(jìn)行異步計(jì)算。擁有如此大的處理器意味著數(shù)據(jù)永遠(yuǎn)不會(huì)掉隊(duì),也不需要在內(nèi)存中等待,不浪費(fèi)功率,并且可以以流水線(xiàn)的方式連續(xù)地移至計(jì)算的下一個(gè)階段。編譯器和處理器的設(shè)計(jì)還考慮到了稀疏性,無(wú)論批處理大小如何都可以實(shí)現(xiàn)高利用率,或者可以使參數(shù)搜索算法同時(shí)運(yùn)行。

Cerebras設(shè)計(jì)的獨(dú)特性,讓它能夠超越制造過(guò)程中出現(xiàn)的常見(jiàn)物理限制,即標(biāo)線(xiàn)限制。處理器的設(shè)計(jì)限制,往往取決于芯片的最大尺寸,因?yàn)楹茈y通過(guò)Cross link連接兩個(gè)區(qū)域。這是Cerebras的殺手锏之一,該公司仍然是唯一一家能提供這種規(guī)模處理器的公司。

在Hot Chips 2020,該公司首席硬件架構(gòu)師Sean Lie表示,Cerebras對(duì)客戶(hù)的主要好處之一是能夠簡(jiǎn)化工作負(fù)載,以前需要使用GPU / TPU機(jī)架的工作,現(xiàn)在可以以計(jì)算相關(guān)的方式在單個(gè)WSE上運(yùn)行。

產(chǎn)品和合作伙伴

Cerebras的第一代WSE作為CS-1的完整系統(tǒng)的一部分一起打包出售,不少實(shí)驗(yàn)室與計(jì)算機(jī)中心已經(jīng)部署了Cerebras WSE和CS-1。

愛(ài)丁堡大學(xué)的超級(jí)計(jì)算中心,利用WSE進(jìn)行自然語(yǔ)言處理、基因組學(xué)和COVID-19的相關(guān)研究。

在美國(guó)阿貢國(guó)家實(shí)驗(yàn)室(ANL),WSE被用于COVID-19研究、重力波檢測(cè)和材料發(fā)現(xiàn)等;并且在癌癥療法研究中,使癌癥模型的實(shí)驗(yàn)周轉(zhuǎn)時(shí)間,減少了300倍以上。

制藥企業(yè)葛蘭素史克的高級(jí)副總裁金·布蘭森表示:“其增加了生成的編碼器模型的復(fù)雜性,同時(shí)將訓(xùn)練時(shí)間減少了80倍。”

Lawrence Livermore將一臺(tái)CS-1與其23 PFLOP“拉森”超級(jí)計(jì)算機(jī)配對(duì)。匹茲堡超級(jí)計(jì)算機(jī)中心以500萬(wàn)美元的價(jià)格購(gòu)買(mǎi)了兩個(gè)系統(tǒng),并將這些系統(tǒng)連接到他們的Neocortex超級(jí)計(jì)算機(jī)上,以實(shí)現(xiàn)同步AI和增強(qiáng)的計(jì)算能力。

對(duì)于WSE-2的應(yīng)用,國(guó)際調(diào)研公司Tirias Research首席分析師Jim McGregor認(rèn)為:“顯然,對(duì)用于大型數(shù)據(jù)集的Cerebras晶圓級(jí)解決方案,有些公司和實(shí)體很感興趣。但是在企業(yè)層面,還有數(shù)百萬(wàn)的其他AI應(yīng)用,以及一些Cerebras不能處理的情況,這就是英偉達(dá)擁有SuprPod和Selene超級(jí)計(jì)算機(jī)的原因。與英偉達(dá)相比,Cerebras更像是一個(gè)小眾平臺(tái),二者的廣度無(wú)法相提并論。”

目前Cerebras在多倫多、圣地亞哥、東京和舊金山擁有約300名員工。該公司首席執(zhí)行官安德魯·費(fèi)爾德曼(Andrew Feldman)表示,作為一家公司,他們已經(jīng)實(shí)現(xiàn)了盈利,已經(jīng)部署了CS-1的客戶(hù)很多,并且在啟動(dòng)商業(yè)系統(tǒng)時(shí)已經(jīng)有更多的客戶(hù)在遠(yuǎn)程試用CS-2。

除了AI之外,由于芯片的靈活性使流體動(dòng)力學(xué)和其他計(jì)算仿真成為可能,因此Cerebras在典型的商業(yè)高性能計(jì)算市場(chǎng)(例如石油、天然氣和基因組學(xué))中吸引了很多客戶(hù)。

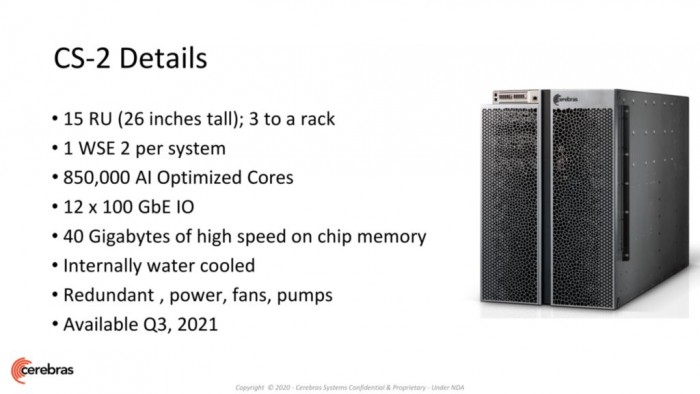

CS-2的部署將于今年晚些時(shí)候的第三季度開(kāi)始,價(jià)格已從2-3百萬(wàn)美元升至“幾百萬(wàn)”美元。