財(cái)報(bào)發(fā)布前兩天,英偉達(dá)突然冒出來一個(gè)勁敵。

一家名叫Groq的公司今天在AI圈內(nèi)刷屏,殺招就一個(gè):快。

在傳統(tǒng)的生成式AI中,等待是稀松平常的事情,字符一個(gè)個(gè)蹦出,半天才能回答完畢。但在Groq今天開放的云服務(wù)體驗(yàn)平臺(tái)上,你看到的會(huì)是一秒一屏。當(dāng)模型收到提示后,幾乎能夠立即生成答案。這些答案不僅真實(shí)可信,還附有引用,長度更是達(dá)到數(shù)百個(gè)單詞。

電子郵件初創(chuàng)企業(yè)Otherside AI的首席執(zhí)行官兼聯(lián)合創(chuàng)始人馬特·舒默(Matt Shumer)在演示中親自體驗(yàn)了Groq的強(qiáng)大功能。他稱贊Groq快如閃電,能夠在不到一秒鐘的時(shí)間內(nèi)生成數(shù)百個(gè)單詞的事實(shí)性、引用性答案。更令人驚訝的是,它超過3/4的時(shí)間用于搜索信息,而生成答案的時(shí)間卻短到只有幾分之一秒。

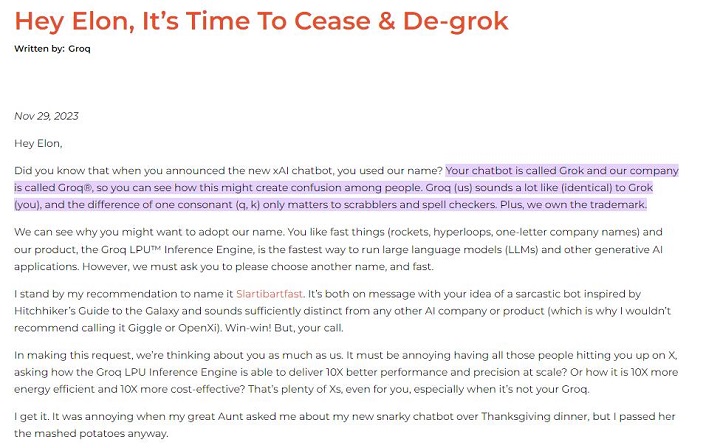

雖然今天才刷屏,但Groq公司并非初出茅廬的新創(chuàng)企業(yè)。實(shí)際上,該公司成立于2016年,并在那時(shí)就注冊了Groq商標(biāo)。去年11月,當(dāng)馬斯克發(fā)布人工智能模型Grok時(shí),Groq公司的開發(fā)者們就發(fā)了一篇文章說馬斯克撞名自己的公司。信寫的挺逗的,但這波流量他們是一點(diǎn)沒吃到。

這一次他們之所以能突然爆發(fā),主要是因?yàn)镚roq云服務(wù)的上線,讓大家真的能親身感受一下不卡頓的AI用起來有多爽。

有從事人工智能開發(fā)的用戶稱贊,Groq是追求低延遲產(chǎn)品的“游戲規(guī)則改變者”,低延遲指的是從處理請求到獲得響應(yīng)所需的時(shí)間。另一位用戶則表示,Groq的LPU在未來有望對(duì)GPU在人工智能應(yīng)用需求方面實(shí)現(xiàn)“革命性提升”,并認(rèn)為它可能成為英偉達(dá)A100和H100芯片的“高性能硬件”的有力替代品。

01 Groq芯片能在速度上取勝的核心技術(shù)是LPU

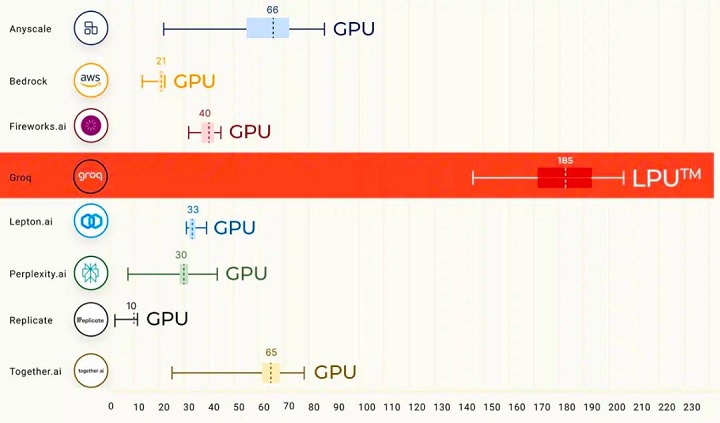

根據(jù)其模型的首次公開基準(zhǔn)測試結(jié)果,Groq云服務(wù)搭載的Llama2或Mistreal模型在計(jì)算和響應(yīng)速度上遠(yuǎn)超ChatGPT。這一卓越性能的背后,是Groq團(tuán)隊(duì)為大語言模型(LLM)量身定制的專用芯片(ASIC),它使得Groq每秒可以生成高達(dá)500個(gè) token。相比之下,目前ChatGPT-3.5的公開版本每秒只能生成大約40個(gè)token。

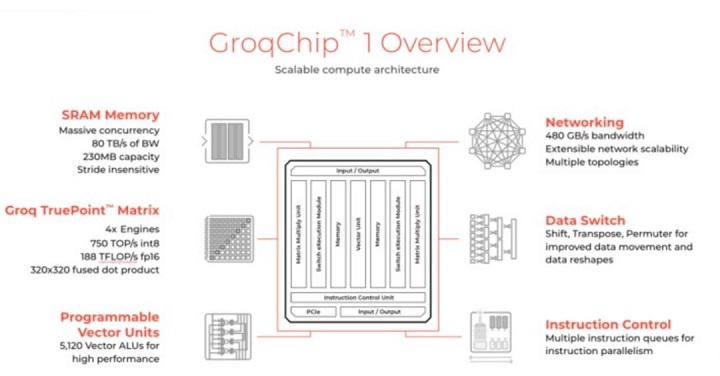

這一芯片能在速度上取勝的核心技術(shù)是Groq首創(chuàng)的LPU技術(shù)。

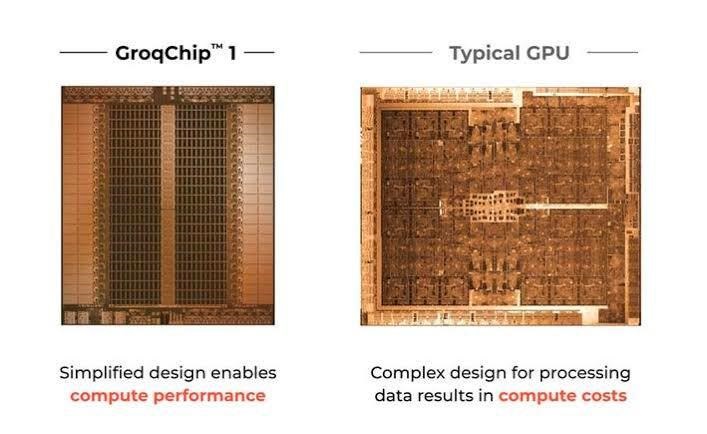

根據(jù)推特上與Groq關(guān)系密切的投資人k_zeroS分享,LPU的工作原理與GPU截然不同。它采用了時(shí)序指令集計(jì)算機(jī)(Temporal Instruction Set Computer)架構(gòu),這意味著它無需像使用高帶寬存儲(chǔ)器(HBM)的GPU那樣頻繁地從內(nèi)存中加載數(shù)據(jù)。這一特點(diǎn)不僅有助于避免HBM短缺的問題,還能有效降低成本。

不同于Nvidia GPU需要依賴高速數(shù)據(jù)傳輸,Groq的LPU在其系統(tǒng)中沒有采用高帶寬存儲(chǔ)器(HBM)。它使用的是SRAM,其速度比GPU所用的存儲(chǔ)器快約20倍。

鑒于AI的推理計(jì)算相較于模型訓(xùn)練需要的數(shù)據(jù)量遠(yuǎn)小,Groq的LPU因此更節(jié)能。在執(zhí)行推理任務(wù)時(shí),它從外部內(nèi)存讀取的數(shù)據(jù)更少,消耗的電量也低于Nvidia的GPU。

如果在AI處理場景中采用Groq的LPU,可能就無需為Nvidia GPU配置特殊的存儲(chǔ)解決方案。LPU并不像GPU那樣對(duì)存儲(chǔ)速度有極高要求。Groq公司宣稱,其技術(shù)能夠通過其強(qiáng)大的芯片和軟件,在AI任務(wù)中取代GPU的角色。

另一位安卡拉大學(xué)的助教更形象的解釋了一下LPU和GPU的差別,“想象一下,你有兩個(gè)工人,一個(gè)來自Groq(我們稱他們?yōu)椤癓PU”),另一個(gè)來自Nvidia(我們稱之為“GPU”)。兩人的任務(wù)都是盡快整理一大堆文件。

GPU就像一個(gè)速度很快的工人,但也需要使用高速傳送系統(tǒng)(這就像高帶寬存儲(chǔ)器或HBM)將所有文件快速傳送到他們的辦公桌上。這個(gè)系統(tǒng)可能很昂貴,有時(shí)很難得到(因?yàn)镠BM產(chǎn)能有限)。

另一方面,Groq的LPU就像一個(gè)高效組織任務(wù)的工人,他們不需要那么快地交付文件,所以用了一張就放在他們身邊的更小的桌子(這就像SRAM,一種更快但更小的存儲(chǔ)器),所以他們幾乎可以立即獲得所需的東西。這意味著他們可以在不依賴快速交付系統(tǒng)的情況下快速工作。

對(duì)于不需要查看堆中每一篇文件的任務(wù)(類似于不使用那么多數(shù)據(jù)的人工智能任務(wù)),LPU甚至更好。它不需要像往常一樣來回移動(dòng),既節(jié)省了能源,又能快速完成工作。

LPU組織工作的特殊方式(這是時(shí)態(tài)指令集計(jì)算機(jī)體系結(jié)構(gòu))意味著它不必一直站起來從堆里搶更多的論文。這與GPU不同,GPU不斷需要高速系統(tǒng)提供更多的文件。”

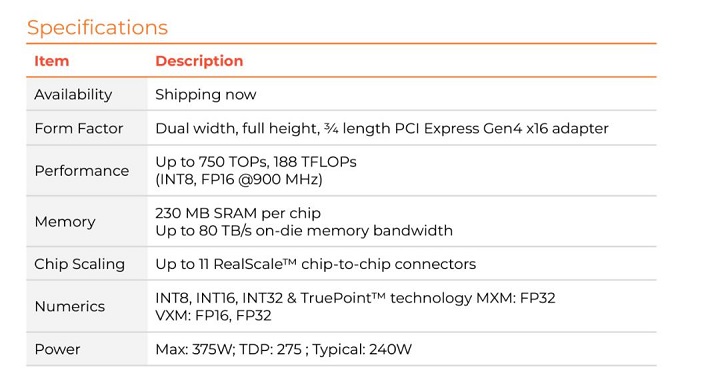

運(yùn)用LPU這一技術(shù),Groq生產(chǎn)了加速器單元,根據(jù)其網(wǎng)站介紹規(guī)格如下:

其特殊內(nèi)存SRAM的容量是230MB,帶寬80TB/s,在INT8、FP16下算力為188TFLOPs。

02 確實(shí)快,但是貴,目前并不能成為英偉達(dá)的競爭對(duì)手

在Groq剛剛刷屏的時(shí)候,AI行業(yè)都沉浸在它閃電速度的震撼之中。然而震撼過后,很多行業(yè)大佬一算賬,發(fā)現(xiàn)這個(gè)快的代價(jià)可能有點(diǎn)高。

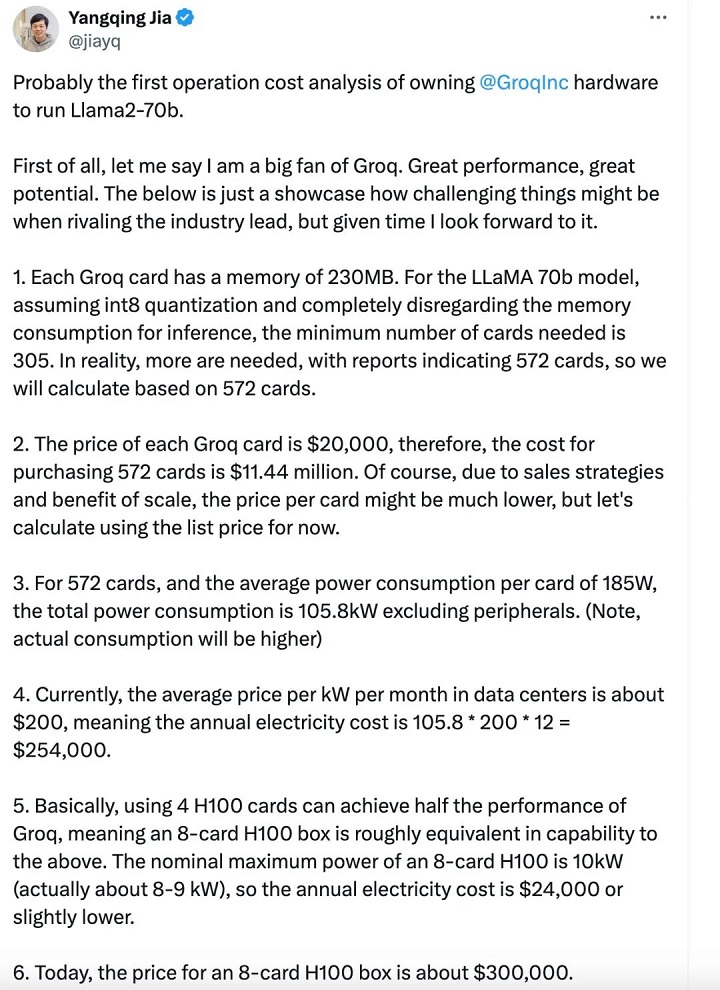

賈揚(yáng)清在推特上算了一筆賬,因?yàn)镚roq小的可憐的內(nèi)存容量(230MB),在運(yùn)行Llama-2 70b模型時(shí),需要305張Groq卡才足夠,而用H100則只需要8張卡。從目前的價(jià)格來看,這意味著在同等吞吐量下,Groq的硬件成本是H100的40倍,能耗成本是10倍。

芯片專家姚金鑫(J叔)向騰訊科技進(jìn)行了更詳細(xì)的解釋:

按照Groq的信息,這顆AI芯片的規(guī)格如下:

從芯片的規(guī)格中,可以看到幾個(gè)關(guān)鍵信息點(diǎn):SRAM的容量是230MB,帶寬80TB/s,F(xiàn)P16的算力是188TFLOPs。

按照當(dāng)前對(duì)大模型的推理部署,7B的模型大約需要14G以上的內(nèi)存容量,那么為了部署一個(gè)7B的模型,大約需要70片左右的芯片,根據(jù)透露的信息,一顆芯片對(duì)應(yīng)一張計(jì)算卡,按照4U服務(wù)器配置8張計(jì)算卡來計(jì)算,就需要9臺(tái)4U服務(wù)器(幾乎占了一個(gè)標(biāo)準(zhǔn)機(jī)柜了),總共72顆計(jì)算芯片,在這種情況下,算力(在FP16下)也達(dá)到了驚人的188T * 72 = 13.5P,如果按照INT8來算就是54P。54P的算力來推理7B的大模型,用大炮打蚊子來形容一點(diǎn)也不為過。

目前社交媒體廣泛傳播的文章對(duì)標(biāo)的是英偉達(dá)H100,其采用的是80G的HBM,這個(gè)容量可以部署5個(gè)7B的大模型實(shí)例;我們再來看算力,稀疏化后,H100在FP16下的算力將近2P,在INT8上也將近4P。

那么就可以做個(gè)對(duì)比,如果從同等算力來看,如果都是用INT8來推理,采用Groq的方案需要9臺(tái)包含72片的服務(wù)器集群,而如果是H100,達(dá)到同等算力大約需要2臺(tái)8卡服務(wù)器,此時(shí)的INT8算力已經(jīng)到64P,可以同時(shí)部署的7B大模型數(shù)量達(dá)到80多個(gè)。

原文中提到,Groq對(duì)Llama2-7B的Token生成速度是750 Tokens/s,如果對(duì)標(biāo)的是H100服務(wù)器,那這2臺(tái)總共16顆的H100芯片,并發(fā)吞吐就高到不知道哪里去了。如果從成本的角度,9臺(tái)的Groq服務(wù)器,也是遠(yuǎn)遠(yuǎn)貴過2臺(tái)H100的服務(wù)器(即使此刻價(jià)格已經(jīng)高到離譜)。

● Groq:2萬美金*72=144萬美金,服務(wù)器2萬美金*9=18萬美金,純的BOM成本160萬美金以上(全部都是按照最低方式來計(jì)算)。

● H100:30萬美金*2 = 60萬美金(國外),300萬人民幣*2=600萬人民幣(國內(nèi)實(shí)際市場價(jià))

如果是70B的模型,同樣是INT8,要用到至少600張卡,將近80臺(tái)服務(wù)器,成本會(huì)更高。

這還沒有算機(jī)架相關(guān)費(fèi)用,和消耗的電費(fèi)(9臺(tái)4U服務(wù)器幾乎占用整個(gè)標(biāo)準(zhǔn)機(jī)柜)。

實(shí)際上,部署推理性價(jià)比最高的,恰恰是4090這種神卡。

Groq是否真的超越了英偉達(dá)?對(duì)此,姚金鑫(J叔)也表達(dá)了自己不同的看法:

“英偉達(dá)在本次AI浪潮中的絕對(duì)領(lǐng)先地位,使得全球都翹首以盼挑戰(zhàn)者。每次吸引眼球的文章,總會(huì)在最初被人相信,除了這個(gè)原因之外,還是因?yàn)樵谧鰧?duì)比時(shí)的“套路”,故意忽略其他因素,用單一維度來做比較。這就好比那句名言“拋開事實(shí)不談,難道你就沒有一點(diǎn)錯(cuò)的地方嗎?”

拋開場景來談對(duì)比,其實(shí)是不合適的。對(duì)于Groq這種架構(gòu)來講,也有其盡顯長處的應(yīng)用場景,畢竟這么高的帶寬,對(duì)許多需要頻繁數(shù)據(jù)搬運(yùn)的場景來說,那就是再好不過了。

總結(jié)起來,Groq的架構(gòu)建立在小內(nèi)存,大算力上,因此有限的被處理的內(nèi)容對(duì)應(yīng)著極高的算力,導(dǎo)致其速度非常快。

現(xiàn)在把句話反過來,Groq極高的速度是建立在很有限的單卡吞吐能力上的。要保證和 H100同樣吞吐量,你就需要更多的卡。

速度,在這里成了Groq的雙刃劍。”

03 傳奇CEO,小團(tuán)隊(duì)

雖然Groq還面對(duì)著很多潛在的問題,但它還是讓人看到了GPU之外的可能路徑。這主要得益于其背后的超強(qiáng)團(tuán)隊(duì)。

Groq的CEO是被稱為“TPU之父”的前谷歌員工喬納森·羅斯;聯(lián)合創(chuàng)始人道格拉斯·懷特曼也來自谷歌TPU團(tuán)隊(duì),并先后創(chuàng)立了四家公司。該公司首席技術(shù)官吉姆·米勒曾是亞馬遜云計(jì)算服務(wù)AWS設(shè)計(jì)算力硬件的負(fù)責(zé)人,CMO曾主導(dǎo)了蘋果Macintosh的市場發(fā)布。

Groq目前的團(tuán)隊(duì)也相對(duì)較小,其總部位于加州山景城,該公司僅有180余名員工,甚至還不到英特爾等大型芯片制造商所需工程師數(shù)量的四分之一。

羅斯等人的目標(biāo)是在Groq復(fù)制他在谷歌的成功經(jīng)驗(yàn),打造一個(gè)內(nèi)部芯片項(xiàng)目,引領(lǐng)整個(gè)行業(yè)向新技術(shù)邁進(jìn)。他希望吸引少數(shù)關(guān)鍵客戶,通過廣泛部署Groq芯片為公司提供穩(wěn)定的收入來源,推動(dòng)公司的獨(dú)立發(fā)展。目前,這家初創(chuàng)公司已開始向潛在客戶發(fā)送樣品。

“這就像獵殺大象,”羅斯說道,“你只需要少數(shù)獵物就能維持自己的生命,尤其在我們還如此弱小的時(shí)候。”