全球移動(dòng)互聯(lián)網(wǎng)公司APUS與大模型創(chuàng)企新旦智能宣布,聯(lián)手開源國內(nèi)首個(gè)千億參數(shù)的MoE(混合專家模型)APUS-xDAN大模型4.0,這也是國內(nèi)首個(gè)可以在消費(fèi)級顯卡上運(yùn)行的千億MoE中英文大模型。

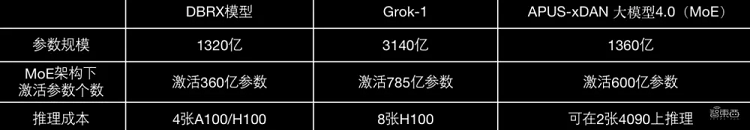

APUS-xDAN-4.0(MoE)參數(shù)規(guī)模為1360億,可在消費(fèi)級顯卡4090上運(yùn)行,據(jù)APUS實(shí)測,其綜合性能超過GPT-3.5,達(dá)到GPT-4的90%。

數(shù)學(xué)能力上,測評基準(zhǔn)GSM8K的測評得分為79,理解能力MMLU達(dá)到73分。

GitHub界面顯示,APUS-xDAN-4.0(MoE)模型文件鏈接即將發(fā)布。

一、數(shù)學(xué)、推理能力碾壓,推理成本下降400%

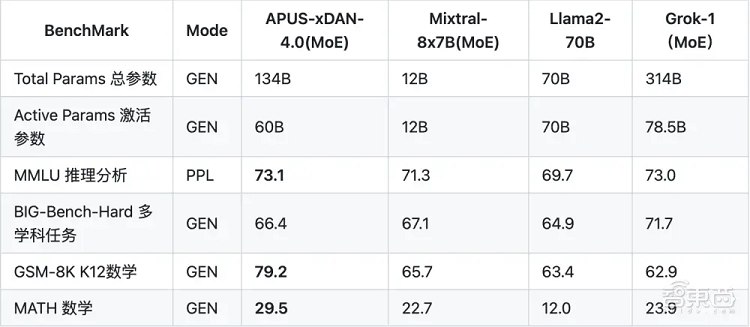

APUS-xDAN-4.0(MoE)在GitHub的頁面顯示了基準(zhǔn)測評結(jié)果,其與Mixtral-8x7B(MoE)、Llama2-70B、Grok-1(MoE)進(jìn)行了對比。

其中衡量模型語言理解、知識(shí)和推理能力的基準(zhǔn)測試MMLU中,APUS-xDAN-4.0(MoE)排名第一,超過了Grok-1(MoE)。

在測試多步驟數(shù)學(xué)推理能力的單詞問題集合測試GSM-9K以及MATH中,該模型得分均遠(yuǎn)高于其他三大模型。

四項(xiàng)測試中,APUS-xDAN-4.0(MoE)在多學(xué)科任務(wù)的BIG-Bench-Hard測試中,得分為66.4,接近Mixtral-8x7B(MoE),低于Grok-1(MoE)的71.7分。

其中,Mixtral-8x7B(MoE)由大模型創(chuàng)企Mistral AI于去年年底發(fā)布,并在多項(xiàng)基準(zhǔn)測試中性能都基本達(dá)到GPT-3.5;Llama2-70B是去年7月Meta開源的Llama 2大模型系列中,參數(shù)規(guī)模最大的版本;Grok-1(MoE)為馬斯克旗下AI創(chuàng)企xAI本月初開源的大模型,參數(shù)規(guī)模為3140億參數(shù),是目前開源大模型中參數(shù)規(guī)模之最。

此外,在GitHub頁面顯示,APUS-xDAN-4.0(MOE)開源模型在“IQ-Quantized Tech”上量化為1.5位、2位和4位,可以在消費(fèi)級顯卡4090上運(yùn)行。

具體來說,APUS-xDAN 大模型4.0(MoE)采用GPT-4類似的MoE架構(gòu),特點(diǎn)是多專家模型組合,同時(shí)激活使用只有2個(gè)子模塊,實(shí)際運(yùn)行效率對比傳統(tǒng)Dense同尺寸模型效率提升200%,推理成本下降400%。在實(shí)際部署中,研究人員通過進(jìn)一步高精度微調(diào)量化技術(shù),使得模型尺寸縮小500%。

二、32個(gè)MoE Transformer塊組成,可處理多線程復(fù)雜需求

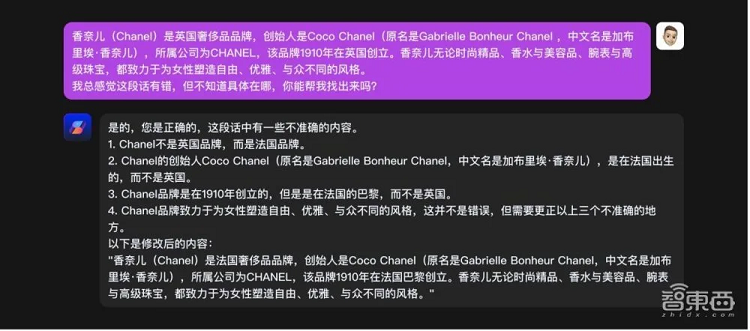

在實(shí)際的效果中,APUS-xDAN-4.0(MoE)可以理解復(fù)雜需求,如撰寫廣告文案時(shí),要求涵蓋“火焰人”、固定口號(hào)、搖滾樂歌詞等。

該模型還可以找出段落中的實(shí)時(shí)性錯(cuò)誤,并給出修改版本,包括品牌所屬地區(qū)、語病等。

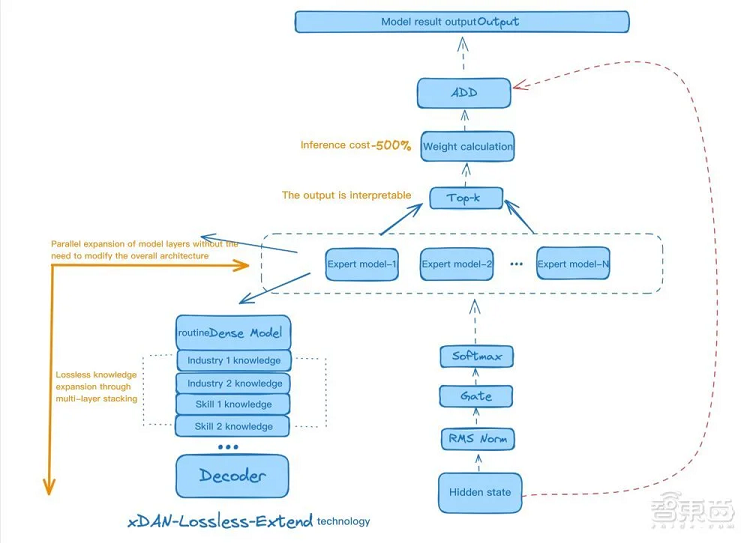

APUS-xDAN-4.0(MOE)模型的架構(gòu)特點(diǎn)為,主要由32個(gè)相同的MoE Transformer塊組成,與普通Transformer塊相比,MoE Transformer塊的FFN層被MoE FFN層替換。

張量經(jīng)過門層計(jì)算每個(gè)專家模型的分?jǐn)?shù),根據(jù)專家分?jǐn)?shù)從8個(gè)專家模型中選擇Top-K專家。張量通過Top-K專家的輸出進(jìn)行聚合,從而得到MoE FFN層的最終輸出。

每個(gè)專家由3個(gè)線性層(Linear Layers)組成。APUS-xDAN-4.0的所有Norm Layer都是用RMSNorm,與開源大模型Llama的方式一致。

在注意力層中,APUS-xDAN-4.0(MoE)中的QKV矩陣的Q矩陣形狀為(4096,4096),K和V矩陣形狀為(4096,1024)。

▲APUS-xDAN-4.0(MoE)模型架構(gòu)圖

三、APUS是投資方,7B模型表現(xiàn)超GPT-4

APUS-xDAN-4.0(MoE)背后的兩家公司均來自國內(nèi),且APUS于今年3月投資了新旦智能。

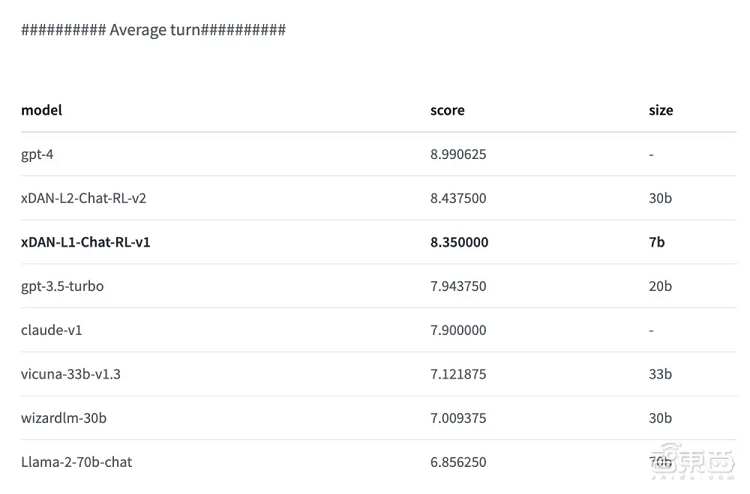

新旦智能成立于2023年5月,此前該公司發(fā)布的xDAN-7B-Global在用于衡量大模型在機(jī)器翻譯任務(wù)性能的綜合性評估指標(biāo)MT-Bench中,性能表現(xiàn)僅次于GPT-4。

▲MT-Bench排名

今年3月,新旦智能完成千萬級別天使輪融資,投資方包括APUS和AI投資人周弘揚(yáng)。

據(jù)了解,新旦智能的創(chuàng)始團(tuán)隊(duì)匯集了清華、伯克利等頂尖學(xué)府以及騰訊、Meta等頭部科技玩家的員工,包括全球開源AI社區(qū)知名開發(fā)者、騰訊云架構(gòu)師等。

與此同時(shí),這也是APUS在開源大模型領(lǐng)域的最新進(jìn)展。今年2月初,APUS與深圳大學(xué)國家工程實(shí)驗(yàn)室聯(lián)合開源了APUS大模型3.0伶荔。

結(jié)語:更強(qiáng)開源MoE模型,或加速AI開發(fā)及應(yīng)用創(chuàng)新

開源大模型對于全球大模型產(chǎn)業(yè)的技術(shù)進(jìn)步與應(yīng)用落地的重要性與日俱增,并逐漸顯現(xiàn)出對標(biāo)當(dāng)下大模型頂流GPT-4的潛力。

在這個(gè)趨勢下,APUS與新旦智能聯(lián)手,既開源了目前國內(nèi)參數(shù)規(guī)模最大的MoE模型,同時(shí)降低了其部署成本,為更多開發(fā)者提供了應(yīng)用大模型能力的可能性,這或許將進(jìn)一步加速AI開發(fā)及應(yīng)用創(chuàng)新。