阿里巴巴日前宣布,開源 Qwen1.5 系列首個千億參數(shù)模型 Qwen1.5-110B,該模型在基礎(chǔ)能力評估中與 Meta-Llama3-70B 相媲美,在 Chat 評估中表現(xiàn)出色,包括 MT-Bench 和 AlpacaEval 2.0。

匯總主要內(nèi)容:

據(jù)介紹,Qwen1.5-110B 與其他 Qwen1.5 模型相似,采用了相同的 Transformer 解碼器架構(gòu)。它包含了分組查詢注意力(GQA),在模型推理時更加高效。該模型支持 32K tokens 的上下文長度,同時它仍然是多語言的,支持英、中、法、西、德、俄、日、韓、越、阿等多種語言。

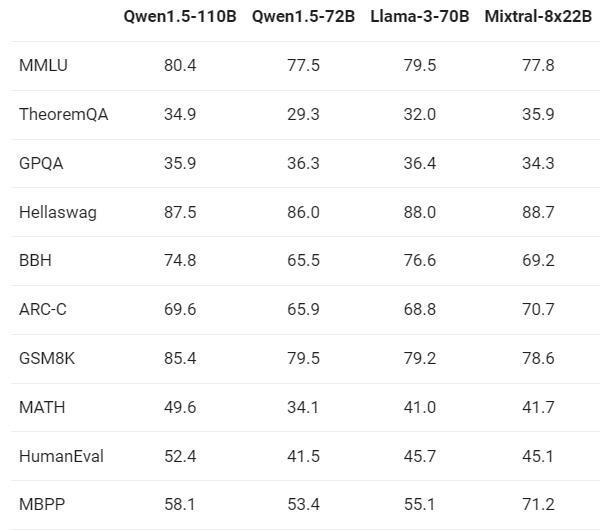

阿里 Qwen1.5-110B 模型與最近的 SOTA 語言模型 Meta-Llama3-70B 以及 Mixtral-8x22B 進行了比較,結(jié)果如下:

上述結(jié)果顯示,新的 110B 模型在基礎(chǔ)能力方面至少與 Llama-3-70B 模型相媲美。在這個模型中,阿里巴巴沒有對預(yù)訓(xùn)練的方法進行大幅改變,因此他們認為與 72B 相比的性能提升主要來自于增加模型規(guī)模。

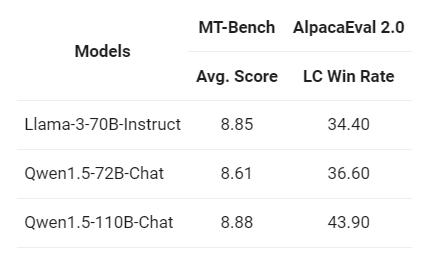

阿里還在 MT-Bench 和 AlpacaEval 2.0 上進行了 Chat 評估,結(jié)果如下:

阿里巴巴表示,與之前發(fā)布的 72B 模型相比,在兩個 Chat 模型的基準評估中,110B 表現(xiàn)顯著更好。評估結(jié)果的持續(xù)改善表明,即使在沒有大幅改變后訓(xùn)練方法的情況下,更強大、更大規(guī)模的基礎(chǔ)語言模型也可以帶來更好的 Chat 模型。

最后,阿里方面表示,Qwen1.5-110B 是 Qwen1.5 系列中規(guī)模最大的模型,也是該系列中首個擁有超過 1000 億參數(shù)的模型。它在與最近發(fā)布的 SOTA 模型 Llama-3-70B 的性能上表現(xiàn)出色,并且明顯優(yōu)于 72B 模型。