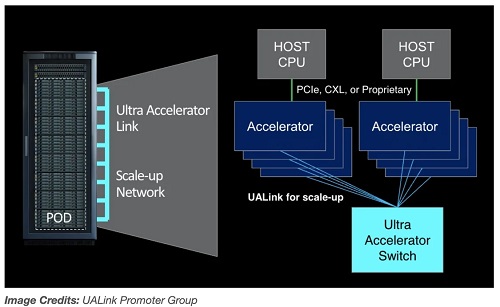

英特爾、谷歌、微軟、Meta等八家科技巨頭正在建立一個(gè)新的行業(yè)小組,即超加速器鏈接(UALink)推廣小組,以指導(dǎo)數(shù)據(jù)中心內(nèi)連接AI加速器芯片的組件的發(fā)展。

UALink推廣小組周四宣布成立,其成員還包括AMD、惠普企業(yè)、博通和思科。該小組提出了一個(gè)新的行業(yè)標(biāo)準(zhǔn),用于連接服務(wù)器中越來越多的AI加速器芯片。廣義上講,AI加速器是從GPU到為加速AI模型的訓(xùn)練、微調(diào)和運(yùn)行而定制設(shè)計(jì)的解決方案的芯片。

AMD數(shù)據(jù)中心解決方案總經(jīng)理Forrest Norrod在周三的簡報(bào)中對記者表示:“行業(yè)需要一個(gè)可以快速推進(jìn)的開放標(biāo)準(zhǔn),在開放的[格式]中,允許多家公司為整個(gè)生態(tài)系統(tǒng)增加價(jià)值。”“行業(yè)需要一個(gè)標(biāo)準(zhǔn),允許創(chuàng)新以不受任何單一公司束縛的快速步伐進(jìn)行。”

提議的標(biāo)準(zhǔn)的第一個(gè)版本,UALink 1.0,將在單個(gè)計(jì)算“pod”中連接多達(dá)1024個(gè)AI加速器——僅限GPU。(該小組將pod定義為服務(wù)器中的一個(gè)或幾個(gè)機(jī)架。)UALink 1.0基于“開放標(biāo)準(zhǔn)”,包括AMD的無限架構(gòu),將允許AI加速器附加的內(nèi)存之間進(jìn)行直接加載和存儲(chǔ),并且與現(xiàn)有的互連規(guī)格相比,總體上將提高速度并降低數(shù)據(jù)傳輸延遲。

該小組表示,將在第三季度創(chuàng)建一個(gè)聯(lián)盟,UALink聯(lián)盟,以監(jiān)督UALink規(guī)范的未來發(fā)展。UALink 1.0將在同期向加入聯(lián)盟的公司提供,更高帶寬的更新規(guī)范UALink 1.1,計(jì)劃在2024年第四季度推出。

UALink的首批產(chǎn)品將在“未來幾年”推出,Norrod說。

明顯缺席該小組成員名單的是Nvidia,它是迄今為止最大的AI加速器生產(chǎn)商,估計(jì)占有80%到95%的市場份額。Nvidia拒絕對此發(fā)表評(píng)論。但不難看出為什么這家芯片制造商不熱衷于支持基于競爭對手技術(shù)的規(guī)范。

首先,Nvidia為其數(shù)據(jù)中心服務(wù)器內(nèi)的GPU提供了自己的專有互連技術(shù)。該公司可能不太愿意支持基于競爭對手技術(shù)的標(biāo)準(zhǔn)。

然后是Nvidia從巨大的實(shí)力和影響力位置運(yùn)營的事實(shí)。

在Nvidia最近一個(gè)財(cái)季(2025年第一季度)中,包括其AI芯片銷售在內(nèi)的數(shù)據(jù)中心銷售額比去年同期增長了400%以上。如果Nvidia繼續(xù)目前的發(fā)展軌跡,它將在今年某個(gè)時(shí)候超過蘋果,成為世界上最有價(jià)值的公司。

因此,簡單來說,如果Nvidia不想?yún)⑴c,它就不必參與。

至于亞馬遜網(wǎng)絡(luò)服務(wù)(AWS),這是唯一沒有為UALink做出貢獻(xiàn)的公共云巨頭,它可能處于“觀望”模式,因?yàn)樗谙鳒p其各種內(nèi)部加速器硬件努力。也可能是AWS,憑借對云服務(wù)市場的控制,沒有看到反對Nvidia的戰(zhàn)略意義,Nvidia為其客戶提供了大部分GPU。

AWS沒有回應(yīng)TechCrunch的評(píng)論請求。

事實(shí)上,UALink的最大受益者——除了AMD和英特爾——似乎是微軟、Meta和谷歌,它們已經(jīng)花費(fèi)了數(shù)十億美元購買Nvidia GPU來驅(qū)動(dòng)它們的云并訓(xùn)練它們不斷增長的AI模型。所有人都希望擺脫一個(gè)他們視為在AI硬件生態(tài)系統(tǒng)中過于主導(dǎo)的供應(yīng)商。

谷歌擁有用于訓(xùn)練和運(yùn)行AI模型的定制芯片,TPU和Axion。亞馬遜擁有幾個(gè)AI芯片家族。微軟去年加入了Maia和Cobalt的競爭。Meta正在完善自己的加速器系列。

與此同時(shí),微軟及其密切合作伙伴OpenAI據(jù)報(bào)道計(jì)劃至少花費(fèi)1000億美元用于一臺(tái)超級(jí)計(jì)算機(jī),用于訓(xùn)練AI模型,該計(jì)算機(jī)將配備未來的Cobalt和Maia芯片。這些芯片將需要一些東西將它們連接起來——也許它將是UALink。