通義千問(Qwen)今天宣布經過數(shù)月的努力,Qwen 系列模型從 Qwen1.5 到 Qwen2 的重大升級,并已在 Hugging Face 和 ModelScope 上同步開源。

附上 Qwen 2.0 主要內容如下:

5 個尺寸的預訓練和指令微調模型,包括 Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B 以及 Qwen2-72B

在中文英語的基礎上,訓練數(shù)據(jù)中增加了 27 種語言相關的高質量數(shù)據(jù);

多個評測基準上的領先表現(xiàn);

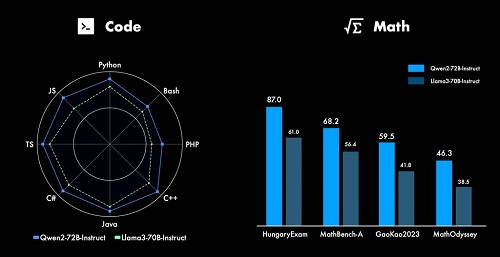

代碼和數(shù)學能力顯著提升;

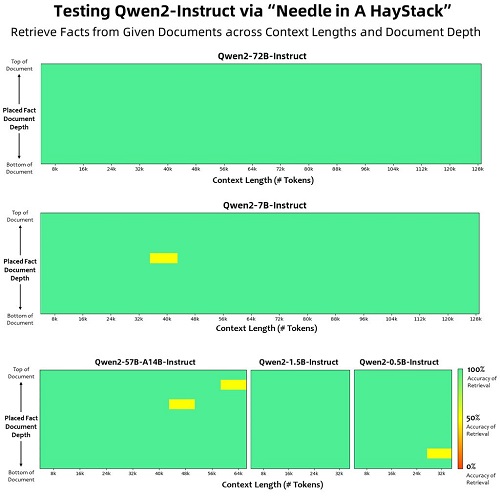

增大了上下文長度支持,最高達到 128K tokens(Qwen2-72B-Instruct)。

模型基礎信息

Qwen2 系列包含 5 個尺寸的預訓練和指令微調模型,其中包括 Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B 和 Qwen2-72B。

在 Qwen1.5 系列中,只有 32B 和 110B 的模型使用了 GQA。這一次,所有尺寸的模型都使用了 GQA,以便讓大家體驗到 GQA 帶來的推理加速和顯存占用降低的優(yōu)勢。

模型評測

相比 Qwen1.5,Qwen2 在大規(guī)模模型實現(xiàn)了非常大幅度的效果提升。我們對 Qwen2-72B 進行了全方位的評測。

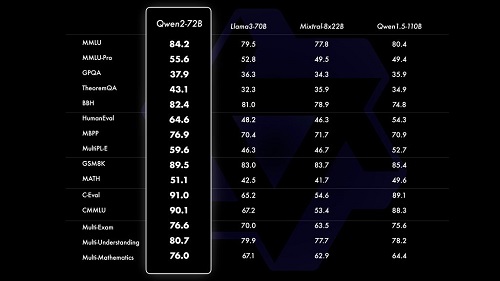

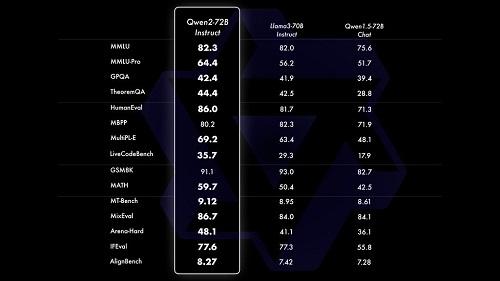

在針對預訓練語言模型的評估中,對比當前最優(yōu)的開源模型,Qwen2-72B 在包括自然語言理解、知識、代碼、數(shù)學及多語言等多項能力上均顯著超越當前領先的模型,如 Llama-3-70B 以及 Qwen1.5 最大的模型 Qwen1.5-110B。

本站內容除特別聲明的原創(chuàng)文章之外,轉載內容只為傳遞更多信息,并不代表本網站贊同其觀點。轉載的所有的文章、圖片、音/視頻文件等資料的版權歸版權所有權人所有。本站采用的非本站原創(chuàng)文章及圖片等內容無法一一聯(lián)系確認版權者。如涉及作品內容、版權和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當措施,避免給雙方造成不必要的經濟損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。