6月29日消息,阿里云近日公布了其專門為訓練大型語言模型(LLM)的超大數(shù)據(jù)傳輸而創(chuàng)建的以太網(wǎng)網(wǎng)絡(luò)設(shè)計,并且已在實際業(yè)務(wù)中使用了 8 個月。

阿里云之所以選擇以太網(wǎng)是出于避免過度依賴少數(shù)供應(yīng)商和利用“整個以太網(wǎng)聯(lián)盟的力量實現(xiàn)更快發(fā)展”的愿望。這一決定似乎也順應(yīng)了越來越多廠商開始支持以太網(wǎng),逃離英偉達NVlink在云端AI互聯(lián)上的壟斷。

阿里巴巴的以太網(wǎng)網(wǎng)絡(luò)計劃是阿里云高級工程師、網(wǎng)絡(luò)研究研究員翟恩南(Ennan Zhai)的GitHub 頁面上披露的。翟恩南發(fā)布了一篇論文,該論文將在 8 月份的 SIGCOMM 會議上發(fā)表,該會議是美國計算機協(xié)會數(shù)據(jù)通信特別興趣小組的年度聚會。

這篇題為《阿里巴巴 HPN:用于大型語言模型訓練的數(shù)據(jù)中心網(wǎng)絡(luò)》的論文開篇指出,流量云計算流量“……會產(chǎn)生數(shù)百萬個小流量(例如低于 10Gbit/秒)”,而大語言模型訓練“會在每個主機上產(chǎn)生少量周期性、突發(fā)性的流量(例如 400Gbit/秒)”。

等價多路徑路由是一種常用的通過多條路徑將數(shù)據(jù)包發(fā)送到單個目的地的方法,但它容易出現(xiàn)哈希極化,這種現(xiàn)象會導致負載平衡困難并顯著減少可用帶寬。

阿里云的自制替代方案名為“高性能網(wǎng)絡(luò)”(HPN),“通過減少 ECMP 的出現(xiàn)來避免哈希極化,同時也大大減少了路徑選擇的搜索空間,從而使我們能夠精確選擇能夠容納大流量的網(wǎng)絡(luò)路徑。”

HPN 還解決了 GPU 在訓練大型語言模型時需要同步工作的事實,這使得 AI 基礎(chǔ)設(shè)施對單點故障很敏感——尤其是機架頂部交換機。

因此,阿里巴巴的網(wǎng)絡(luò)設(shè)計使用了一對交換機——但不是交換機供應(yīng)商建議的堆疊配置。

堆滿了卡片

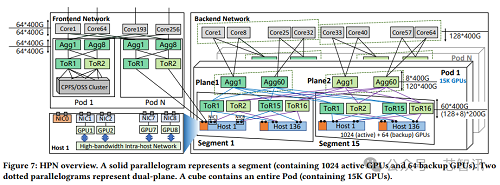

論文解釋稱,阿里云用于大型語言模型訓練的每臺主機都包含 8 個 GPU 和 9 個網(wǎng)絡(luò)接口卡 (NIC),每個卡都有一對 200GB/秒的端口。其中一個 NIC 負責處理“后端網(wǎng)絡(luò)”上的日常流量。

前端網(wǎng)絡(luò)允許主機中的每個 GPU 通過以 400-900GB/秒(雙向)運行的主機內(nèi)網(wǎng)絡(luò)直接與其他 GPU 通信。每個 NIC 服務(wù)于單個 GPU(阿里云稱之為“軌道”),這種安排使每個加速器以“專用的 400Gb/秒 RDMA 網(wǎng)絡(luò)吞吐量運行,總帶寬為 3.2Tb/秒”。

論文指出:“這樣的設(shè)計旨在最大限度地利用 GPU 的 PCIe 功能(PCIe Gen5×16),從而將網(wǎng)絡(luò)發(fā)送/接收容量推向極限。”NIC 上的每個端口都連接到不同的機架頂部交換機,以避免單點故障。

阿里云表示傾向于使用以太網(wǎng),這對于 AMD、博通、思科、谷歌、HPE、英特爾、Meta 和微軟來說無疑是個好消息。所有這些供應(yīng)商最近都加入了Ultra Accelerator Link (UALink)聯(lián)盟,旨在挑戰(zhàn)英偉達的 NVlink 網(wǎng)絡(luò)業(yè)務(wù)。

英特爾和 AMD 表示,該聯(lián)盟以及Ultra Ethernet等其他先進網(wǎng)絡(luò)項目代表了一種更好的 AI 工作負載網(wǎng)絡(luò)化方式,因為從長遠來看,開放標準總是會獲勝,因為它們使創(chuàng)新變得更加容易。

不過,盡管阿里云的 NPM 設(shè)計基于以太網(wǎng),但它仍然有使用英偉達的技術(shù)。這家英偉達的 NVlink 用于主機內(nèi)網(wǎng)絡(luò)(帶寬比主機間網(wǎng)絡(luò)更大),并且還采用了“軌道優(yōu)化”設(shè)計方法,即每個網(wǎng)絡(luò)接口卡都連接到不同的機架頂部交換機組。

阿里巴巴的單芯片交換機統(tǒng)治地位

這篇論文還多次提到阿里云的架頂式交換機中有一個“51.2Tb/秒以太網(wǎng)單芯片交換機(于 2023 年初首次發(fā)布)”。有兩款設(shè)備符合這一描述:博通的Tomahawk ASIC于 2023 年 3 月出貨,思科的G200于同年 6 月上市。提到“2023 年初”似乎表明阿里云選擇了博通的解決方案。

無論阿里巴巴交換機的內(nèi)部情況如何,該論文表明中國云計算公司偏愛單芯片驅(qū)動的交換機。

論文指出:“目前已經(jīng)出現(xiàn)了支持更高帶寬容量的多芯片機箱交換機”,并指出“阿里云在運營數(shù)據(jù)中心網(wǎng)絡(luò)的長期經(jīng)驗表明,多芯片機箱交換機比單芯片交換機帶來更多的穩(wěn)定性風險。”

據(jù)透露,該公司的單芯片交換機數(shù)量是多芯片交換機的 32.6 倍。而這些多芯片交換機發(fā)生嚴重硬件故障的概率是單芯片交換機的 3.77 倍。

需要 DIY 散熱器

雖然阿里云推崇單芯片交換機,并且很享受其采用的 51.2Tbit/秒設(shè)備的吞吐量是之前設(shè)備的兩倍,同時功耗僅增加 45% 這一事實,但新款設(shè)備的運行溫度并不比之前的產(chǎn)品低。

如果芯片溫度超過 105°C,交換機可能會關(guān)閉。阿里云找不到能夠提供能夠?qū)⑿酒瑴囟缺3衷?105°C 以下的冷卻系統(tǒng)的交換機供應(yīng)商。因此它創(chuàng)建了自己的蒸汽室散熱器。

論文解釋道:“通過優(yōu)化燈芯結(jié)構(gòu)并在芯片中心部署更多的燈芯柱,熱量可以更有效地傳導。”

數(shù)據(jù)中心設(shè)計披露

以上所有設(shè)備都內(nèi)置于每個容納 15,000 個 GPU 的“艙室”中,每個艙室都位于一個數(shù)據(jù)中心建筑內(nèi)。

論文透露:“阿里云所有投入使用的數(shù)據(jù)中心建筑的總功率約束為 18MW,而一棟 18MW 的建筑可容納約 15K 個 GPU”,并補充道,“與 HPN 結(jié)合,每棟建筑都可以完美容納整個 Pod,從而在同一棟建筑內(nèi)形成主要的鏈接。”

大樓內(nèi)的所有光纖長度均在100米以內(nèi),從而可以“使用成本較低的多模光纖收發(fā)器(與單模光纖收發(fā)器相比,成本降低70%)。”

但事情并非全是美好的:論文承認“HPN 引入了額外的設(shè)計……使得布線變得更加復雜。”

“特別是在構(gòu)建 HPN 的初期,現(xiàn)場工作人員會犯很多接線錯誤。”這意味著需要進行額外的測試。

論文還指出,單個以太網(wǎng)芯片的轉(zhuǎn)發(fā)容量每兩年翻一番。因此,阿里云已經(jīng)在“設(shè)計配備更高容量單芯片交換機的下一代網(wǎng)絡(luò)架構(gòu)”。

“我們在下一代數(shù)據(jù)中心的土地建設(shè)規(guī)劃中,對單棟建筑的總功率約束進行了調(diào)整,以覆蓋更多的GPU,這樣新數(shù)據(jù)中心交付時,就可以直接配備102.4Tbit/sec的單片交換機和下一代HPN。”

論文還指出,訓練具有數(shù)千億個參數(shù)的 LLM“依賴于大規(guī)模分布式訓練集群,通常配備數(shù)千萬個 GPU”。

阿里云自己的 Qwen 模型有一個經(jīng)過 1100 億個參數(shù)訓練的變體——這意味著它有大量使用 NPM 的 pod,以及數(shù)百萬個生產(chǎn)中的 GPU。隨著其模型和數(shù)據(jù)中心變得越來越大、越來越多,它還需要更多。