10月1日消息,AMD發(fā)布了自己的首個小語言模型(SLM),名為“AMD-135M”。

相比于越來越龐大的大語言模型(LLM),它體積小巧,更加靈活,更有針對性,非常適合私密性、專業(yè)性很強的企業(yè)部署。

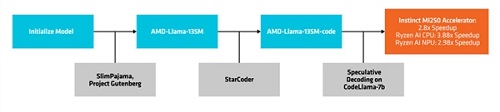

AMD-135小模型隸屬于Llama家族,有兩個版本:

一是基礎型“AMD-Llama-135M”,擁有多達6700億個token,在八塊Instinct MIM250 64GB加速器上訓練了六天。

二是延伸型“AMD-Llama-135M-code”,額外增加了專門針對編程的200億個token,同樣硬件訓練了四天。

創(chuàng)建與部署流程

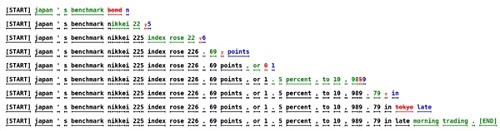

它使用了一種名為“推測解碼”(speculative decoding)的方法,通過較小的草稿模型,在單次前向傳播中生成多個候選token,然后發(fā)送給更大的、更精確的目標模型,進行驗證或糾正。

這種方法可以同時生成多個token,不會影響性能,還可以降低內存占用,但因為數(shù)據(jù)交易更多,功耗也會增加。

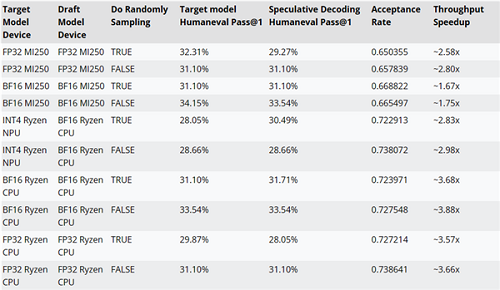

AMD還使用AMD-Llama-135M-code作為CodeLlama-7b的草案模型,測試了推測解碼使用與否的性能。

比如在MI250加速器上,性能可提升最多約2.8倍,銳龍AI CPU上可提升最多約3.88倍,銳龍AI NPU上可提升最多約2.98倍。

推測解碼

AMD-135M小模型的訓練代碼、數(shù)據(jù)集等資源都已經(jīng)開源,遵循Apache 2.0。

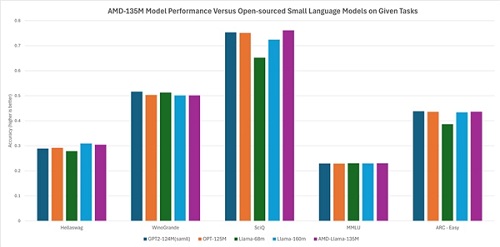

按照AMD的說法,它的性能與其他開源小模型基本相當或略有領先,比如Hellaswag、SciQ、ARC-Easy等任務超過Llama-68M、LLama-160M,Hellaswag、WinoGrande、SciQ、MMLU、ARC-Easy等任務則基本類似GTP2-124MN、OPT-125M。