12 月 11 日消息,IBM 宣布開發(fā)出一種新的光學技術(shù),能夠以光速訓練 AI 模型,同時大幅節(jié)省能源。該公司表示,通過將這項突破應(yīng)用于數(shù)據(jù)中心,訓練一個 AI 模型所節(jié)省的能源相當于 5000 個美國家庭一年的能源消耗。

該公司解釋說,雖然數(shù)據(jù)中心通過光纖電纜與外部世界連接,但內(nèi)部仍然使用銅線。這些銅線連接著 GPU 加速器,而 GPU 加速器在等待來自其他設(shè)備的數(shù)據(jù)時會有大量時間處于空閑狀態(tài),同時消耗能量并推高成本。

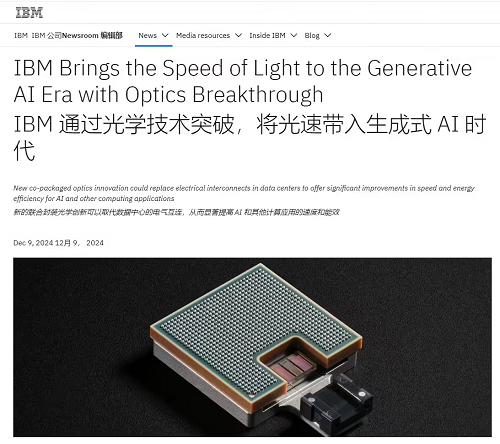

IBM 高級副總裁兼研究總監(jiān) Dario Gil 稱:“隨著生成式 AI 對更多能源和處理能力的需求,數(shù)據(jù)中心必須進化,而共封裝光學技術(shù)(CPO)可以使這些數(shù)據(jù)中心面向未來。通過這一突破,未來的芯片將像光纖電纜進出數(shù)據(jù)中心傳輸數(shù)據(jù)一樣進行通信,從而開啟一個更快、更可持續(xù)的通信新時代,能夠處理未來的 AI 工作負載。”

IBM 在一篇技術(shù)論文中概述了其新的 CPO 原型。通過顯著增加數(shù)據(jù)中心的帶寬,可以最大限度地減少 GPU 的閑置時間,從而加速 AI 處理。IBM 稱,大型語言模型(LLM)的訓練時間可以從三個月縮短到三周。同時,更高的能源效率將降低能源消耗,并減少與訓練 LLM 相關(guān)的成本。

本站內(nèi)容除特別聲明的原創(chuàng)文章之外,轉(zhuǎn)載內(nèi)容只為傳遞更多信息,并不代表本網(wǎng)站贊同其觀點。轉(zhuǎn)載的所有的文章、圖片、音/視頻文件等資料的版權(quán)歸版權(quán)所有權(quán)人所有。本站采用的非本站原創(chuàng)文章及圖片等內(nèi)容無法一一聯(lián)系確認版權(quán)者。如涉及作品內(nèi)容、版權(quán)和其它問題,請及時通過電子郵件或電話通知我們,以便迅速采取適當措施,避免給雙方造成不必要的經(jīng)濟損失。聯(lián)系電話:010-82306118;郵箱:[email protected]。