2月12日消息,字節(jié)跳動豆包大模型團(tuán)隊近日宣布推出全新稀疏模型架構(gòu) UltraMem,解決了 MoE 推理的高額訪存問題,推理速度較 MoE 架構(gòu)提升 2-6 倍,推理成本最高可降低 83%。

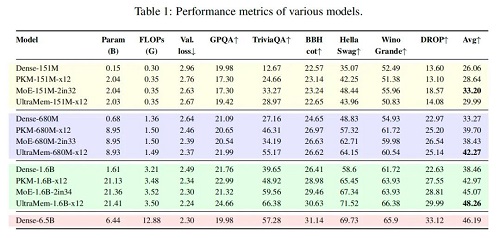

該研究揭示新架構(gòu)的 Scaling Law,表明其不僅有出色的 Scaling 特性,性能還超越 MoE。實驗顯示,訓(xùn)練規(guī)模達(dá) 2000 萬 value 的 UltraMem 模型,在同等計算資源下,能同時實現(xiàn)領(lǐng)先的推理速度和模型性能,為構(gòu)建數(shù)十億規(guī)模 value 或 expert 開辟新途徑。

據(jù)悉,豆包大模型團(tuán)隊的這項創(chuàng)新成果已被機器學(xué)習(xí)和AI領(lǐng)域的頂級會議ICLR 2025接收,為解決大模型推理效率和擴展能力問題提供了全新思路。

大模型的推理能力對應(yīng)的是端側(cè)AI應(yīng)用/工具的響應(yīng)能力和速度。隨著模型規(guī)模的擴大,推理成本和訪存效率已成為限制大模型規(guī)模應(yīng)用的關(guān)鍵瓶頸。

在Transformer架構(gòu)下,模型的性能與其參數(shù)數(shù)量和計算復(fù)雜度呈對數(shù)關(guān)系。隨著LLM規(guī)模不斷增大,推理成本會急劇增加,速度變慢。

為了解決計算問題,先前的研究者提出了MoE和PKM(Product Key Memory)方案,但它們都有各自的局限性:

MoE架構(gòu)犧牲了效率:MoE架構(gòu)成功將計算和參數(shù)解耦,通過稀疏激活專家的方式,在訓(xùn)練階段有效減少了計算量,但在推理時,由于模型在推理時只能一個字一個字的生成,batch size(批量大小)和sequence length(序列長度)通常較小,少量的token即可激活幾乎所有的專家,進(jìn)而導(dǎo)致訪存急劇上升,進(jìn)而使推理延遲大幅增加。

PKM架構(gòu)犧牲了效果:PKM架構(gòu)通過引入“行路由”和“列路由”機制,這種方法讓每個token在推理時僅僅只激活極少數(shù)的value(與提示模板中的內(nèi)容相關(guān)聯(lián)的數(shù)據(jù)或信息),所以推理時不會遇到訪存瓶頸,但其效果很差,且擴展能力有限,難以應(yīng)對更大規(guī)模的模型需求。

這些局限性使得MoE和PKM在推理效率、模型效果和擴展能力等方面的優(yōu)化空間仍需進(jìn)一步探索。UltraMem正是為了解決上述痛點。

據(jù)介紹,UltraMem參考了PKM的設(shè)計,但針對PKM的缺陷予以補充,以實現(xiàn)更高效的訪存、更優(yōu)質(zhì)的檢索,同時,降低了顯存和部署成本,其優(yōu)勢主要在于:

降低推理成本:與傳統(tǒng)的MoE架構(gòu)相比,UltraMem在推理成本上實現(xiàn)了最高83%的降低,這對于大規(guī)模模型的部署和運行具有重要意義。

提升推理速度:UltraMem的推理速度相比MoE架構(gòu)提升了2-6倍,這使得模型在處理大規(guī)模數(shù)據(jù)時更加高效。

保持模型效果:在降低推理成本和提升推理速度的同時,UltraMem還保持了模型的效果,確保了模型的準(zhǔn)確性和可靠性。

豆包研究團(tuán)隊在151M、680M、1.6B三個不同規(guī)模的模型上進(jìn)行了廣泛的實驗。實驗結(jié)果表明,UltraMem在模型效果和推理速度方面均優(yōu)于MoE和PKM架構(gòu),且在680M、1.6B上具有顯著的效果優(yōu)勢。

無論是訓(xùn)練端還是推理端,當(dāng)大模型廠商卷起成本,意味著AI應(yīng)用將在未來更加高效、易用。

推理成本大幅降低,將助推AI技術(shù)在更多領(lǐng)域的應(yīng)用成為可能,尤其是對于資源受限的場景,如邊緣計算和移動設(shè)備等,能讓更多企業(yè)和開發(fā)者有能力使用和部署AI模型。

對于用戶而言,UltraMem架構(gòu)的突破、推理速度的提升可使AI應(yīng)用如智能助手、自然語言處理等在實時應(yīng)用中響應(yīng)更迅速,交互更流暢,優(yōu)化用戶的使用體驗,提高內(nèi)容創(chuàng)作、日常辦公等場景下的效率。