文獻(xiàn)標(biāo)識碼:A

DOI: 10.19358/j.issn.2096-5133.2018.08.011

中文引用格式:朱素杰,王萌.一種基于高級驅(qū)動輔助系統(tǒng)快速時空立體匹配方法[J].信息技術(shù)與網(wǎng)絡(luò)安全,2018,37(8):45-49.

0 引言

高級駕駛輔助系統(tǒng)(Advanced Driver Assistance Systems, ADAS)旨在提高汽車的安全性和駕駛舒適性,其功能包括目標(biāo)檢測和跟蹤、交通標(biāo)志檢測和識別、行人檢測等。ADAS面臨的最重要的難題是車輛對外部環(huán)境的感知,然而隨著立體視覺技術(shù)的不斷成熟,立體匹配可以非常精確和詳細(xì)地對周圍環(huán)境進(jìn)行直觀的描述。立體匹配的關(guān)鍵問題在于從不同視點拍攝的立體圖像中找到像素之間的對應(yīng)關(guān)系[1]。為此,文獻(xiàn)[2]提供了一種新的高密度立體聲通信算法分類法(STM)和一個用于定量評價立體算法(SM)的試驗臺。可以看出,這兩種算法產(chǎn)生了很好的結(jié)果,然而卻以時間為代價,僅適合于靜態(tài)場景[3]。

本文研究的方法主要致力于立體聲傳感器嵌入在動態(tài)的ADAS,對于應(yīng)用在動態(tài)場景上的立體匹配,需要處理動態(tài)場景。該匹配算法通過立體聲傳感器根據(jù)每秒的幀提供每一對立體圖像對,獲得相應(yīng)的立體圖像,將時間信息合并到立體方法中來提高最后的匹配結(jié)果。然而,僅有少量的研究致力于從立體序列中重建動態(tài)場景。本文通過考慮連續(xù)幀之間的一致性,將立體匹配的結(jié)果大大改進(jìn)。

本文提出了一種基于時空信息的快速立體匹配方法。基于早期提出的通過圖像點得到全球視差范圍的方法,本文提出了一種新的計算視差范圍的方法。該方法不再通過所有圖像點來求取全局視差范圍,而是根據(jù)邊緣點的性質(zhì)得到。最后,將該方法和STM[4]、SM[5]方法進(jìn)行了比較,通過比較結(jié)果可以看出該方法大大提高了匹配率。

1 立體匹配算法

本文提出的立體匹配算法的流程如圖1所示。其中:ILk 和 IRk分別表示在時間k上獲得的左右立體聲圖像;ILk-1和IRk-1分別表示在時間k-1上獲得的左右立體聲圖像;Dk和Dk-1分別表示在當(dāng)前幀和前一個幀中計算的視差圖;fk=(ILk,IRk)和fk-1=(ILk-1,IRk-1)分別表示當(dāng)前幀和前一幀。

該算法根據(jù)左側(cè)圖像ILk-1當(dāng)前幀的局部視差圖和前一幀的全局視差圖以及立體圖像點通過DP算法計算出當(dāng)前幀的視差圖Dk (見圖1)。

首先根據(jù)以上方法進(jìn)行特性的匹配,然后通過關(guān)聯(lián)方法在連續(xù)的圖像之間建立關(guān)系。根據(jù)視差約束原理,本文提出一種獨(dú)立于掃描線的視差約束方法。通過成本函數(shù)來度量候選邊緣點之間的相似性。最后利用DP算法計算當(dāng)前幀的視差圖Dk進(jìn)行特征點的匹配。

1.1 匹配特征

首先從立體圖像中提取匹配特征點。通常使用邊緣點作為特征點。為了便于適應(yīng)智能交通系統(tǒng),需要選擇快速而準(zhǔn)確的邊緣檢測算法。本文使用Canny邊緣檢測算法進(jìn)行了邊緣檢測,此邊緣檢測器提供了連續(xù)的邊緣曲線,并產(chǎn)生了更重要的邊緣點,有助于得到較少的稀疏視差圖。

1.2 邊緣點之間的聯(lián)系

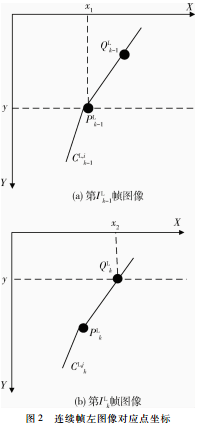

本節(jié)簡要介紹了用于在連續(xù)圖像之間建立關(guān)系的關(guān)聯(lián)算法。如圖2所示, PLk-1和 QLk-1屬于圖像ILk-1上CL,ik-1邊上的兩個點,PLk和QLk屬于圖像ILk上CL,jk邊上的對應(yīng)點。點QLk的匹配點被定義為CL,jk-1邊上與QLk點y坐標(biāo)相同的對應(yīng)點。

1.3 視差因素

在所有已知的立體匹配方法中,對于輸出視差圖的質(zhì)量和計算時間來說,精確選擇視差搜索空間是至關(guān)重要的。在本節(jié)中,提出了一種新的查找局部和全局視差范圍(視差搜索空間)方法。將局部視差范圍適用于相關(guān)聯(lián)的圖像點,將全局視差范圍適用于沒有關(guān)聯(lián)的圖像點。通過討論研究,根據(jù)匹配算法在每一對圖像掃描線上獨(dú)立執(zhí)行的原理,提出局部或全局視差范圍與圖像掃描線有關(guān)。

1.3.1 局部視差范圍計算

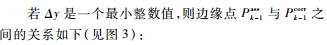

本小節(jié)將介紹如何計算局部視差范圍。首先用Pk表示左圖中當(dāng)前幀的一點,Pk-1表示左圖中前一幀的對應(yīng)點,然后根據(jù)前一幀對應(yīng)點Pk-1的視差值計算邊緣點Pk的視差范圍。由于通過在相鄰幀的邊緣點之間尋找對應(yīng)點是一個具有挑戰(zhàn)性的任務(wù),為此提出在邊緣線Ck-1的邊緣點Pk-1處尋找視差值的方法。視差值通過與Ck-1相關(guān)聯(lián)的均值來確定,Pk的對應(yīng)點Passk-1是圖像Ik-1中的像素點,該像素點與邊緣線Ck-1上Pk-1的y坐標(biāo)相同。在高級驅(qū)動輔助系統(tǒng)應(yīng)用程序中,fps為高(即邊緣點Pk與對應(yīng)點Pk-1的y坐標(biāo)),則Pcorrk-1應(yīng)該與其y坐標(biāo)相接近的一點Passk-1相對應(yīng)。

1.3.2 全局視差范圍計算

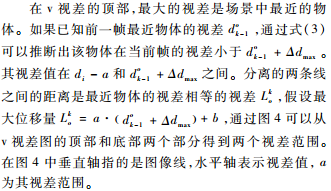

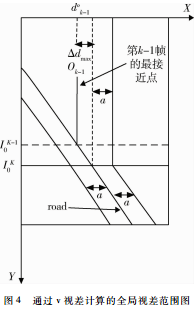

全局視差范圍的計算方法是基于v視差圖的分析,該v視差圖通過初始視差圖或預(yù)估視差圖得到。在本文中,根據(jù)當(dāng)前幀的v視差與前一幀相同的原理,提出了一種既不用計算初始視差圖,也不用計算預(yù)估視差圖的計算方法。如果每秒的幀數(shù)非常精確,那么圖像中物體的視差值不會發(fā)生較大的變化。也可以說,在當(dāng)前幀的v視差圖中道路表示的斜線,將會在前一幀的v視差圖中非常接近它的位置。當(dāng)前幀的v視差圖將分為兩部分:包含對象的頂部和包含道路的底部。在v視差圖中表示道路的斜線可以用下列方程描述:

di=(yi-b)/a (5)

其中yi為圖像線指數(shù),di為同一圖像線的視差值,a和b為斜線參數(shù)。

每個圖像線上只有一個視差值di。考慮到上面所做的假設(shè)與前一幀的視差圖所固有的不確定性,在圖像線yi處的差異d的值應(yīng)該滿足以下不等式:

di-a≤d≤di+a (6)

其中a是選擇的一個不確定性值(公差值)。此約束用于圖像底部的整個圖像線。

1.4 成本函數(shù)

為了確定候選邊緣點之間的相似性,采用了成本函數(shù),該函數(shù)根據(jù)強(qiáng)度、梯度大小和邊緣點的方向來定義。令eLi和eRi分別表示左圖和右圖對應(yīng)的兩個邊緣點,其代價函數(shù)定義如下:

其中I(ei)是邊緣點ei的強(qiáng)度,M(ei)是邊緣點ei的梯度大小,θ(ei)是邊緣點ei的方向。

1.5 動態(tài)規(guī)劃算法

若 和

和 是兩組邊緣點,根據(jù)兩個極線(即左、右) 上的x坐標(biāo)論證了在二維平面上從兩個極線獲取邊緣點之間的對應(yīng)關(guān)系的問題。二維平面的橫坐標(biāo)與左極線相對應(yīng),縱坐標(biāo)與右極線相對應(yīng)(見圖5)。二維平面的兩個軸在兩個相對應(yīng)極線的邊緣點位置。

是兩組邊緣點,根據(jù)兩個極線(即左、右) 上的x坐標(biāo)論證了在二維平面上從兩個極線獲取邊緣點之間的對應(yīng)關(guān)系的問題。二維平面的橫坐標(biāo)與左極線相對應(yīng),縱坐標(biāo)與右極線相對應(yīng)(見圖5)。二維平面的兩個軸在兩個相對應(yīng)極線的邊緣點位置。

將局部和全局視差范圍應(yīng)用到動態(tài)規(guī)劃的1.3.1和1.3.2小節(jié)中,在這些范圍內(nèi)的邊緣點被認(rèn)為是可能的匹配,而另一些則被認(rèn)為是無效的匹配。在1.4節(jié)中討論的成本函數(shù)用于填充搜索平面中的可能匹配項。在尋找最佳路徑后,確定了 和

和 之間的對應(yīng)邊緣點。對于每個圖像線都有獨(dú)立的匹配過程。

之間的對應(yīng)邊緣點。對于每個圖像線都有獨(dú)立的匹配過程。

局部視差范圍不僅需要提高匹配點的精度,也需要提高整個圖像的精度,因為如果DP算法在某一步失敗,將可能影響到圖像中其他邊緣點匹配。但在本文的匹配過程中,如果DP算法在某一個階段失敗,那么局部視差范圍就會迫使算法遵循最優(yōu)路徑,如圖5所示。當(dāng)在圖像中發(fā)現(xiàn)大量的局部區(qū)域時,局部視差范圍都能夠較好地控制。

2 實驗結(jié)果

為了評估本文所提方法的性能,在立體圖像對的虛擬序列中進(jìn)行了測試,并與現(xiàn)有的快速時空立體匹配方法相比較。為了說明時間信息在匹配過程中的重要性,在不整合時間信息的情況下,同樣的方法應(yīng)用于立體圖像,既不使用本地約束,也不使用全局約束。

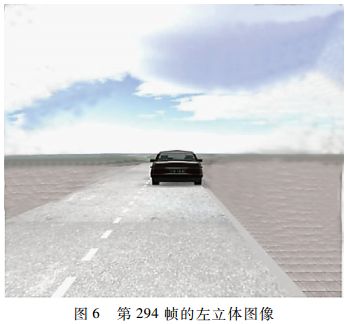

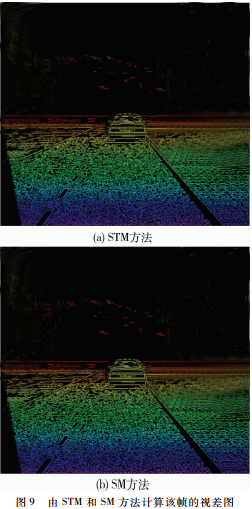

該方法在虛擬立體圖像上進(jìn)行了測試。數(shù)據(jù)集包含512×512的立體圖像和它們的地面實況。圖6顯示了在第294幀的左立體圖像,圖7顯示了由Canny邊緣檢測算法獲得的邊緣圖像。圖8描述了用本文方法在第294幀計算的視差圖。圖9描述了由STM和SM方法計算該幀的視差圖。

表1對三種方法在第294幀中得到的結(jié)果進(jìn)行比較,為每種方法提供了匹配邊緣點(NME)的數(shù)量、正確匹配點的數(shù)量(NCM)、錯誤匹配點的數(shù)量、正確匹配的百分比(PCM)和第294幀的執(zhí)行時間(ETime)。

通過表1可以清楚地看到本文方法正確匹配了更多的邊緣點,提供了較少的稀疏視差圖,從而大大提高了正確匹配率。

3 結(jié)束語

本文利用相鄰幀之間的時間一致性,通過對前一幀的匹配結(jié)果進(jìn)行計算,完成了當(dāng)前幀的視差圖的計算。在當(dāng)前幀的匹配過程中,通過前一幀的視差圖來確定局部和全局視差范圍,這樣既減少了每個邊緣點可能匹配的數(shù)量,也減少了錯誤匹配的數(shù)量,并加速了匹配過程。該方法已經(jīng)在虛擬的序列上進(jìn)行了測試,結(jié)果令人滿意。后續(xù)研究中將在真實序列中進(jìn)行測試。

參考文獻(xiàn)

[1] 耿英楠. 立體匹配技術(shù)的研究[D].長春:吉林大學(xué),2014.

[2] SCHARSTEIN D, SZELISKI R. A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[J]. International Journal of Computer Vision, 2002,47(1-3):7-42.

[3] 郭寶龍,侯葉. 基于圖切割的圖像自動分割方法[J]. 模式識別與人工智能,2011,24(5):604-609.

[4] 杜歆,陳國赟,朱云芳. 一種基于時空結(jié)合的動態(tài)場景立體視頻匹配方法[J]. 電路與系統(tǒng)學(xué)報,2012,17(6):6-13.

[5] 萬立莉. 立體視覺測量的快速立體匹配方法研究[D]. 哈爾濱:哈爾濱理工大學(xué),2016.

(收稿日期:2018-04-26)

作者簡介:

朱素杰(1987-),女,碩士研究生,助教,主要研究方向:圖形圖像處理。

王萌(1990-),女,碩士研究生,助教,主要研究方向:數(shù)字廣播技術(shù)。