俗語(yǔ)說(shuō)得好:海水退潮之后,才知道誰(shuí)沒(méi)穿褲子。但歷史的教訓(xùn)往往證明殘酷的事實(shí):結(jié)果站在浪里的所有人,全部都沒(méi)有穿褲子。

處理器業(yè)界的年度盛事第32屆IEEE HotChips,剛剛在今年8月以全部線上活動(dòng)型式結(jié)束了,連擠4年牙膏的IBM與英特爾總算換了一管全新牙膏,真是可喜可賀。

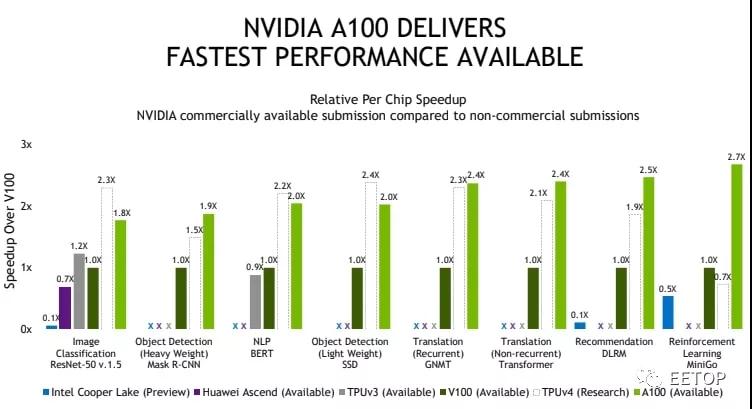

但另一方面,分別在云端服務(wù)和終端硬件執(zhí)人工智能牛耳的Google與nVidia,卻也學(xué)到了“擠牙膏”的精髓,前者讓2018年就問(wèn)世的第三代TPU,從2018年Google I/O講到2020 HotChips,后者在HotChips發(fā)表的內(nèi)容,完全承襲GTC 2000的簡(jiǎn)報(bào),唯一差別只有把華為Ascend 910人工智能處理器和英特爾支援BF16格式的“新型Xeon”Cooper Lake-P拖出來(lái)狠狠打一頓。

總之,我們來(lái)瞧瞧HotChips 32 的Google 第三代TPU 與nVidiaA100。

講了三年總算勉強(qiáng)講完的Google TPU v3

Google 這家公司最令人稱許之處,在于恐怖的“前瞻執(zhí)行力”,每當(dāng)眾人還在清談“技術(shù)趨勢(shì)”之際,就突然石破天驚的昭示天下:你們還在嘴炮的東西,我們?cè)缇蛻?yīng)用到實(shí)際產(chǎn)品。諸多豐功偉業(yè)的最知名案例,莫過(guò)于2013 年底,Google 爆炸性公開(kāi)“規(guī)劃部署已達(dá)3 年”的B4 數(shù)據(jù)中心廣域網(wǎng)絡(luò),開(kāi)大規(guī)模商業(yè)化軟件定義網(wǎng)絡(luò)(SDN)之先河。

早在2015年就投入內(nèi)部應(yīng)用的Google TPU,更是近年來(lái)的經(jīng)典案例,接著Google也很迅速推陳出新,2017年推出深度學(xué)習(xí)第二代TPU,第三代TPU更早在2018 Google I/O就亮相了。

但Google 也隨即“擠牙膏之神”上身,2019 年HotChips 31 教程僅提到部分資訊,到2020 年才公開(kāi)細(xì)節(jié)全貌。

我們都有充分的理由相信,第四甚至第五代TPU,不是早就上線服役也該早在路上了。

2019 年比較對(duì)手是nVidia V100,結(jié)果2020 年看不到第四代TPU 較量V100,讓人感覺(jué)有點(diǎn)奇怪。

TPU v3 概觀可視為TPU v2 的雙倍放大版,散熱系統(tǒng)從氣冷改為液冷,也是主機(jī)板最顯眼的特色。

TPU v3 仍舊著重持續(xù)提升存儲(chǔ)器帶寬(+30%)與容量(加倍),拜液冷之賜,時(shí)鐘頻率也有成長(zhǎng)(+30%)。

TPU v3 的指令集架構(gòu)是332 位元長(zhǎng)的超長(zhǎng)指令集(VLIW),VLIW 指令包內(nèi)總計(jì)有2 個(gè)純量指令、4 個(gè)向量指令(其中2 個(gè)是存儲(chǔ)器載入/回存)、 2 個(gè)矩陣(Matrix)指令、6 個(gè)立即值(Immediate)與一個(gè)雜項(xiàng)(Misc)應(yīng)用。

強(qiáng)化多芯片互連總線,打造更大規(guī)模的“人工智能超級(jí)電腦”,更是TPU v3 的重頭戲,也就是上圖那個(gè)“4x Nodes”。

同樣一片系統(tǒng)主機(jī)板裝4 顆TPU,TPU v3 組成的“人工智能超級(jí)電腦”,擁有前代8 倍以上效能、8 倍存儲(chǔ)器容量、4 倍芯片數(shù)量與4 倍的最大裝置設(shè)定數(shù),可切割成256 個(gè)獨(dú)立運(yùn)算平臺(tái)分租給客戶。

順便一提,現(xiàn)今已知關(guān)于Google TPU 的專利多達(dá)50 份,亦不乏詳細(xì)描述第三代TPU 的內(nèi)部架構(gòu)細(xì)節(jié),也是眾多有志進(jìn)軍人工智能芯片的冒險(xiǎn)者,抽絲剝繭的研究對(duì)象。

但這對(duì)使用Google Cloud AI 的用戶,甚至大多數(shù)Google 部門來(lái)說(shuō),其實(shí)并不重要,他們只要用得爽快、不需要“為了喝牛奶自己蓋一座牧場(chǎng)”就夠了。

靠GPU 基本盤(pán)穩(wěn)扎穩(wěn)打的nVidia A100

nVidia以通用GPU為基礎(chǔ),站穩(wěn)高效能運(yùn)算市場(chǎng),并將觸角逐漸延伸到人工智能和自駕車輛等新興應(yīng)用領(lǐng)域,使2020年夏天市值連續(xù)超越英特爾和三星,證實(shí)外界多么看好“皮衣教主”昭示天下的“美好未來(lái)”。無(wú)論個(gè)人電腦與高效能運(yùn)算領(lǐng)域,從“電競(jìng)筆電非有Max-Q不可”現(xiàn)象到超級(jí)電腦Top500清單滿滿的nVidia GPU,優(yōu)勢(shì)地位看似牢不可破。

nVidia 旗艦GPU 也隨著制程演進(jìn)而持續(xù)“恐龍化”,Ampere 世代之首A100 是一顆臺(tái)積電7 納米制程、540 億晶體管的巨獸,像更多執(zhí)行單元、更大存儲(chǔ)器子系統(tǒng)帶寬、一直更新的DGX 超級(jí)電腦等,是各位也都耳熟能詳,甚至早就令人哈欠連連的“標(biāo)準(zhǔn)劇情”了。

關(guān)于人工智能應(yīng)用,nVidia A100 最重要的特色,莫過(guò)于自行定義的TF32(Tensor Float 32)浮點(diǎn)數(shù)格式。講白了就是“取長(zhǎng)補(bǔ)短”,既然Google BF16 犧牲掉FP32 的精度,維持動(dòng)態(tài)范圍不變,那就讓精度和FP16 一樣吧,神奇的19 位元長(zhǎng)度TF32就這樣誕生了,兼具FP32的動(dòng)態(tài)范圍和FP16 的精度。nVidia 之所以這樣大費(fèi)周章創(chuàng)造新格式,根本目的不外乎要降低存儲(chǔ)器帶寬和容量需求,和Google發(fā)明BF16 如出一轍。

理所當(dāng)然的,TF32 在A100 一定跑得很快,因所需帶寬僅為前代V100 一半或三分之一,更能喂飽嗷嗷待哺的龐大Tensor Core。

但這件事的背后,隱隱約約透露nVidia長(zhǎng)期領(lǐng)先AMD(ATI)的根本原因與基本思維:存儲(chǔ)器帶寬,這件事早從2004年NV40(GeForce 6系列)存儲(chǔ)器控制器內(nèi)建壓縮傳輸機(jī)能,相關(guān)技術(shù)持續(xù)演進(jìn)并陸續(xù)申請(qǐng)專利,就已埋下了種子。過(guò)去十幾年來(lái),AMD或ATI的GPU,需要更多存儲(chǔ)器帶寬,才能實(shí)現(xiàn)同等級(jí)的效能水準(zhǔn),絕對(duì)不是偶然。

大概整批帶槍投靠英特爾的前AMD 團(tuán)隊(duì)過(guò)去吃了不少悶虧,這次替英特爾重新打造Xe 繪圖架構(gòu)時(shí),也很刻意提到“End-To-End Compression”,只是不知道會(huì)不會(huì)不小心踩到nVidia 的專利地雷。

當(dāng)GPU 踏入高效能運(yùn)算和人工智能,“每筆運(yùn)算可平均分配到的存儲(chǔ)器帶寬,持續(xù)穩(wěn)定的下滑中”,更讓提高運(yùn)算效能這件事,絕非區(qū)區(qū)增加幾個(gè)特化指令與擴(kuò)張執(zhí)行單元,即可迎刃而解,更需搞定帶寬這件事,一旦帶寬不足,就發(fā)揮不出完整的運(yùn)算效能。

聽(tīng)說(shuō)nVidia 下一代GPU“Hopper”將改弦易轍,改走多芯片Chiplet“包水餃”路線,也許nVidia 在多芯片連結(jié)架構(gòu)部分,將帶來(lái)讓人感到驚奇的技術(shù)突破也說(shuō)不定,讓人對(duì)明年HotChips 33 多抱持一分期待。

人工智能熱潮的消退:先講求不要餓死再求發(fā)展

話說(shuō)回來(lái),我們就不得不探究一個(gè)大哉問(wèn):為何越來(lái)越多芯片廠商開(kāi)始“擠牙膏”?要么不是受摩爾第二定律詛咒,產(chǎn)品技術(shù)難以短期內(nèi)飛躍性提升,要么就是講再多對(duì)我也沒(méi)任何實(shí)質(zhì)好處,還不如少講一點(diǎn)悶聲發(fā)大財(cái)。

不過(guò)這幾年,難道人工智能芯片不是很火的話題嗎?2017年HotChips 29,不就是從主題演講到議程,從泛用處理器、GPU、ASIC到FGPA,統(tǒng)統(tǒng)“人工智能滿天下”?如此沉默,對(duì)公司的未來(lái)妥當(dāng)嗎?

很遺憾的,人工智能芯片從2018 年起,以中國(guó)相關(guān)領(lǐng)域新創(chuàng)公司為首,熱潮急速退燒,像中國(guó)DEEPHi(深鑒科技)被FPGA 巨頭賽靈思收購(gòu),已經(jīng)算是最好的退場(chǎng)。

即使美國(guó)企業(yè)亦不可免俗,就算公司不會(huì)倒,也不保證產(chǎn)品線不會(huì)收掉。像這些年來(lái)癡迷自駕車和人工智能,耗費(fèi)數(shù)百億美元“生氣亂買公司”的英特爾,2018年宣布中止XeonPhi產(chǎn)品線,決定整個(gè)砍掉重練,由2017年底來(lái)自AMD的Raja Koduri重建貨真價(jià)實(shí)的GPU。2019年底以20億美元購(gòu)并以色列HabanaLabs并在隔年2月停止NNP-T1000(代號(hào)Spring Crest,還宣稱跟百度合作),也意味著2016年用3.5億美元買下的Nervana形同棄兒,英特爾人工智能平臺(tái)事業(yè)群負(fù)責(zé)人、Nervana聯(lián)合創(chuàng)辦人Naveen Rao隨即離職,一點(diǎn)都不讓人意外。

英特爾連續(xù)公開(kāi)栽了兩次(實(shí)際上應(yīng)該更多),事后諸葛的后見(jiàn)之明與背后補(bǔ)刀的內(nèi)幕爆料,均朝向“做出來(lái)的東西根本不能用,也無(wú)法符合軟件開(kāi)發(fā)者和潛在客戶的需求”。

所以這也是當(dāng)人工智能漸漸在HotChips 退燒后,為何Google 和nVidia 可站在臺(tái)上活好好的主因:Google 很清楚自身需要,快速演進(jìn)三代(應(yīng)該更多)的TPU 就是為了自家Google Cloud AI 和其他服務(wù)量身訂做(蘋(píng)果塞在自己芯片內(nèi)的NPU 也是一樣狀況)。nVidia 則是擁有龐大GPU 市占率、累積十多年的CUDA 與高效能運(yùn)算的“基本盤(pán)”足以先養(yǎng)活自己,日后再慢慢發(fā)展。

反觀之前那票一窩蜂狂沖“人工智能新大陸”的勇者,又有幾家有本錢和能耐,先不求餓死,再講求和客戶攜手并進(jìn)的共同勝利?講更白一點(diǎn),你會(huì)相信中國(guó)那些開(kāi)發(fā)數(shù)字貨幣挖礦芯片的廠商,被迫轉(zhuǎn)型做出來(lái)的人工智能芯片,可以迅速得到指標(biāo)性客戶的青睞?

天下任何一家求生存的企業(yè),無(wú)不企求有所謂的“現(xiàn)金母牛”和忠實(shí)客戶,才為穩(wěn)定營(yíng)運(yùn)的基礎(chǔ)。我們可以猜猜看,明年HotChips 33 還剩下哪些幸存者?